嵌入式语音识别系统的研究和实现_方敏

- 格式:doc

- 大小:45.00 KB

- 文档页数:8

语音识别技术在智能嵌入式系统中的应用研究智能嵌入式系统已经成为现代生活中的重要组成部分,它们运用了各种技术来帮助人们更加高效地完成各种任务。

其中,语音识别技术在智能嵌入式系统中的应用尤为重要。

本文将探讨语音识别技术在智能嵌入式系统中的应用,并分析其研究现状和未来发展趋势。

语音识别技术是一种将人类语音转化为可处理的电子文本或指令的技术。

它可以通过分析说话者的声音和语音特征,将其转化为可操作的数据,并在智能嵌入式系统中执行相应的任务。

语音识别技术的应用范围广泛,包括但不限于语音助手、智能家居、无线通信和汽车导航等领域。

首先,语音识别技术在语音助手中的应用已经成为现代生活中的常态。

智能音箱、手机助手和智能手表等设备都可以通过语音识别技术进行人机交互。

用户可以通过语音指令来控制设备的功能,例如提醒、播放音乐、查询天气和设置闹钟等。

语音助手的出色表现使得用户可以更加便捷地与智能设备进行交互,提高了生活和工作效率。

其次,语音识别技术在智能家居领域也发挥了重要作用。

通过语音识别技术,用户可以使用简单的语音指令来控制家庭中的各种设备,包括灯光、空调、电视和音响等。

例如,当用户说出“打开客厅的灯”时,智能家居系统会根据识别结果自动控制客厅的灯光。

这种无需手动操作的智能控制方式极大地方便了人们的日常生活。

此外,语音识别技术在无线通信和汽车导航中的应用也具备重要价值。

在无线通信中,语音识别技术可以用于语音转文字的功能,使得用户无需打字就可以发送短信、邮件和语音消息。

同时,它还可以在汽车导航中帮助驾驶员通过语音指令控制导航设备,避免因为看地图而分散注意力对驾驶安全造成的威胁。

然而,在智能嵌入式系统中应用语音识别技术也面临一些挑战。

首先是语音信号的复杂性。

语音信号受来自环境、说话者声音、语速、口音等多种因素的影响,导致信号的噪声和变异性较大。

因此,准确地识别并转化这些信号需要更加精确和鲁棒的语音识别算法。

其次是隐私和安全问题。

实现嵌入式语音识别系统的基本原理及步骤嵌入式语音识别系统是一种将语音信号转化为可理解的文本信息的技术,它广泛应用于智能家居、智能手机、汽车导航系统等领域。

本文将介绍嵌入式语音识别系统的基本原理及实现步骤。

一、基本原理嵌入式语音识别系统的基本原理基于语音信号的特征提取和模式匹配。

其主要流程包括:音频采集、预处理、特征提取、模式匹配和后处理。

1. 音频采集:利用麦克风或其他音频采集设备获取用户的语音信号。

2. 预处理:对采集到的语音信号进行预处理,包括降噪、增强和去除不必要的信号干扰。

3. 特征提取:从预处理后的语音信号中提取与语音内容相关的特征信息。

常用的特征提取方法包括短时能量、短时过零率、倒谱系数等。

4. 模式匹配:将提取到的特征信息与预先建立的语音模型进行匹配。

常用的模型包括隐马尔可夫模型(HMM)和深度学习模型(如循环神经网络)。

5. 后处理:对匹配结果进行后处理,包括词语连续性检测、语音纠错等。

二、实现步骤实现嵌入式语音识别系统的基本步骤包括:数据准备、特征提取、语音模型训练和系统集成。

1. 数据准备:收集适用于系统训练的语音数据集。

数据集可以包含多个说话人的语音样本,涵盖不同的人声特征和语音内容。

2. 特征提取:对采集到的语音信号进行预处理,并提取出与语音内容相关的特征信息。

常用的特征提取方法包括短时能量、短时过零率、MFCC(Mel频率倒谱系数)等。

3. 语音模型训练:使用已准备好的语音数据集和特征信息,训练一个语音识别模型。

在模型训练过程中,可以选择使用隐马尔可夫模型(HMM)或深度学习模型(如循环神经网络)来构建语音识别系统。

4. 系统集成:将训练好的语音识别模型嵌入到嵌入式设备中,实现实时的语音识别功能。

在系统集成过程中,需要考虑设备的计算能力、存储空间以及实时性等因素。

总结:实现嵌入式语音识别系统的基本原理是基于语音信号的特征提取和模式匹配。

通过音频采集、预处理、特征提取、模式匹配和后处理等步骤,可以将语音信号转化为可理解的文本信息。

嵌入式系统中的语音识别与语音合成技术嵌入式系统中的语音识别与语音合成技术在当今科技发展中扮演着重要的角色。

这种技术的应用范围广泛,涉及智能手机、智能助理、智能家居和车载系统等领域。

本文将详细介绍嵌入式系统中的语音识别与语音合成技术的原理、应用以及存在的挑战。

语音识别技术是将人类语音转化为计算机可处理的形式的过程。

在嵌入式系统中,语音识别技术被用于将用户的语音指令转化为对应的操作,如语音搜索、语音助手等。

语音识别的关键是语音信号的特征提取和模式匹配。

特征提取通过将语音信号表示为一系列数值,如频谱特征、梅尔频率倒谱系数等。

模式匹配则使用机器学习算法,如隐马尔可夫模型(HMM)或深度学习算法,将输入的语音特征与预先训练好的模型进行匹配,以判断用户的语音指令。

语音识别技术的应用越来越广泛,从智能助手如苹果的Siri、亚马逊的Alexa,到智能家居控制和车载系统的语音操作,都离不开这项技术。

通过语音识别,用户可以通过语音指令进行各种操作,实现更加便捷高效的人机交互。

例如,在车载系统中,司机可以通过语音识别来控制导航、电话等功能,提高驾驶安全性。

在智能家居中,用户可以通过语音指令控制灯光、电器等,增加生活的智能化和舒适性。

然而,嵌入式系统中的语音识别技术也面临着一些挑战。

首先,由于嵌入式系统的资源限制,如处理器性能、存储容量和功耗等,对语音识别算法提出了挑战。

为了在有限的资源下实现准确的语音识别,需要优化算法和设计高效的硬件架构。

其次,嵌入式系统中的语音识别需要考虑语音指令的多样性和语言差异性。

不同用户的语音特征和语音习惯不同,导致语音识别算法的泛化能力和鲁棒性需要进一步提高。

此外,隐私保护也是嵌入式系统中语音识别技术面临的重要问题。

由于语音指令包含个人信息,如电话号码、地址等,保护用户隐私成为一项重要任务。

与语音识别技术相对应的是语音合成技术,它是将计算机生成的文本转化为自然语言的语音的过程。

语音合成技术可以使嵌入式系统更具人性化,提供良好的用户体验。

嵌入式语音识别的研究与实现随着科技的发展,嵌入式系统在各个领域得到了广泛应用。

其中,嵌入式语音识别作为人机交互的重要手段之一,正逐渐成为人们生活中不可或缺的一部分。

本文将从研究和实现两个方面,介绍嵌入式语音识别的相关内容。

首先,嵌入式语音识别的研究是基础。

语音识别是将人类语音转化为可理解的文本或命令的技术,而嵌入式语音识别则是将这项技术应用于嵌入式系统中。

在研究方面,需要深入了解语音信号的处理、特征提取、模型训练等相关知识。

此外,还需要对不同语音识别算法进行研究和比较,以找到适合嵌入式系统的算法。

研究者还需关注嵌入式系统的资源限制,如计算能力、存储空间和功耗等,以保证算法在嵌入式设备上的高效运行。

其次,嵌入式语音识别的实现是重要的应用方向。

在实现方面,首先需要选择适合的硬件平台,如嵌入式处理器或专用语音处理芯片。

然后,根据研究的成果,将语音识别算法移植到嵌入式系统中,并进行优化和调试,以确保实时性和准确性。

此外,为了提高用户体验,还可以结合其他技术,如语音合成、语音交互等,实现更多功能。

嵌入式语音识别在日常生活中有着广泛的应用。

例如,智能家居领域中的语音控制,可以通过语音识别技术实现对家电的远程控制;智能手机领域中的语音助手,可以通过语音识别技术将用户的语音指令转化为相应的操作;医疗领域中的智能健康监测,可以通过语音识别技术实现对患者语音的识别和分析等等。

这些应用不仅方便了人们的生活,也提高了工作效率。

总之,嵌入式语音识别的研究与实现是一项具有重要意义的工作。

通过深入研究语音识别算法,并将其应用于嵌入式系统中,可以实现更加智能、便捷和高效的人机交互方式。

随着嵌入式技术的不断发展,相信嵌入式语音识别将在更多领域得到广泛应用,为人们的生活带来更多便利。

一、实训背景随着人工智能技术的不断发展,嵌入式语音识别技术在我国逐渐得到广泛应用。

为了深入了解嵌入式语音识别技术,提高自身实践能力,我们开展了嵌入式语音识别实训。

二、实训目标1. 熟悉嵌入式语音识别系统的工作原理;2. 掌握嵌入式语音识别系统的硬件与软件设计;3. 学会使用C语言进行嵌入式语音识别系统的编程;4. 培养团队合作精神和实践创新能力。

三、实训内容1. 嵌入式语音识别系统概述嵌入式语音识别系统主要包括以下几个部分:(1)麦克风:负责采集语音信号;(2)A/D转换器:将模拟语音信号转换为数字信号;(3)处理器:负责语音信号的预处理、特征提取和识别;(4)识别模块:根据特征参数进行语音识别;(5)执行模块:根据识别结果执行相应的操作。

2. 硬件设计(1)开发板:选用STM32F103C8T6开发板;(2)麦克风模块:选用INMP441麦克风模块;(3)A/D转换器:选用ADC12位分辨率;(4)处理器:选用ARM Cortex-M3内核的32位处理器;(5)识别模块:选用LD3320语音识别芯片。

3. 软件设计(1)语音信号预处理:包括降噪、去噪、静音检测等;(2)特征提取:采用MFCC(Mel-frequency Cepstral Coefficients)特征提取方法;(3)语音识别:采用LD3320芯片内置的语音识别算法;(4)执行模块:根据识别结果执行相应的操作。

4. 编程实践(1)使用C语言编写嵌入式语音识别系统程序;(2)实现语音信号的预处理、特征提取和识别;(3)实现执行模块的功能。

四、实训过程1. 硬件搭建(1)将麦克风模块连接到开发板;(2)连接A/D转换器;(3)连接处理器和识别模块。

2. 软件编程(1)编写语音信号预处理程序;(2)编写特征提取程序;(3)编写语音识别程序;(4)编写执行模块程序。

3. 调试与优化(1)对程序进行调试,确保程序正常运行;(2)根据实际情况对程序进行优化,提高识别率和稳定性。

龙源期刊网

论嵌入式语音识别系统的研究与实现

作者:熊伟水仲飞

来源:《现代商贸工业》2010年第02期

摘要:在介绍了语音识别技术的基础上,根据语音识别系统的构成模型,实现基于嵌入式系统的语音识别系统。

本系统采用了能量过零率双门限法进行语音文件端点检测,采用线性预测倒

谱系数作为语音信号特征矢量,另外,基于非特定人的嵌入式系统要求,为了达到减少计算量和存储量的目的,在特征参数提取完成之后,利用矢量量化方法进行数据压缩。

语音识别模型采用(DHMM)离散隐马尔可夫模型,利用Baum-Welth重估算法、前向后向算法、viterbi算法来完成语音模板的训练和语音识别的任务。

关键词:语音识别;DHMM;嵌入式系统

中图分类号:TN912 文献标识码:A 文章编号:1672-3198(2010)02-0291-02

注:本文中所涉及到的图表、注解、公式等内容请以PDF格式阅读原文。

基于深度学习的嵌入式语音识别算法研究随着科技的不断发展,嵌入式设备的应用越来越广泛,其中语音识别作为一种智能化交互方式,被广泛应用于智能家居、智能车载、医疗设备等领域。

嵌入式语音识别技术是将语音识别算法嵌入到嵌入式设备中,可以实现语音控制和语音交互等功能。

本文将介绍一种基于深度学习的嵌入式语音识别算法,探讨其应用前景和技术实现。

一、前言随着深度学习技术的不断发展和应用,自然语言处理领域的研究开始向深度学习模型转移。

与传统的语音识别技术相比,深度学习模型可以对更大规模的语音数据集进行训练,大大提高了语音识别的准确率和鲁棒性。

同时,随着嵌入式设备运算能力的提升,基于深度学习的嵌入式语音识别技术也得到了广泛应用。

二、基于深度学习的语音识别算法1. 概述基于深度学习的语音识别算法主要分为三个步骤:特征提取、声学建模和解码器。

其中,特征提取是将语音信号转化成计算机能够处理的特征向量,声学建模是建立每个特征向量对应的语音识别结果的模型,解码器是用来翻译声学模型生成的最可能的语音识别结果。

2. 特征提取在深度学习模型中,通常使用的特征向量为MFCC特征或FBANK特征,这些特征向量可以反映语音信号的频率分布特征,并将其转化为一系列数值型数据,以便能够被深度学习模型处理。

同时,也可以利用一些高级特征提取技术,如声学模型和谱图滤波器组来提取声学特征。

3. 声学建模在声学建模中,深度学习模型使用的主要算法是循环神经网络(RNN)和卷积神经网络(CNN)。

RNN能够很好地捕获语音信号的长时序关系,而CNN能够对语音信号进行局部的特征提取,并利用卷积核来实现时间不变性。

4. 解码器解码器是用来翻译声学模型生成的最可能的语音识别结果。

其中,常用的解码器算法是基于统计建模的HMM算法和基于神经网络的CTC算法。

HMM算法通过统计模型进行建模,能够有效地处理有限数量的字典,但在大词汇量的识别任务中表现较差。

而CTC算法通过神经网络对语音信号进行直接建模,能够处理大量的字典,且表现优异。

基于深度学习的嵌入式语音识别算法实现嵌入式语音识别是近年来人工智能技术领域的热门研究方向之一。

随着深度学习技术的不断发展,基于深度学习算法的语音识别在嵌入式系统上广泛应用的可能性逐渐增加。

本文将探讨如何基于深度学习的嵌入式语音识别算法实现,旨在为读者提供一个详细的技术指南。

首先,了解深度学习在语音识别领域的应用是理解嵌入式语音识别算法实现的关键。

深度学习主要包括神经网络、深度自编码器和卷积神经网络等技术,这些技术在很大程度上改进了语音识别的性能。

神经网络是深度学习算法的基石,通过模拟人脑的神经元传递信号的方式来实现对语音的理解。

深度自编码器通过自动提取输入特征,大幅度减少了特征工程的复杂性。

而卷积神经网络则能够有效地处理语音信号的时域和频域信息。

其次,嵌入式系统的特殊性对基于深度学习的语音识别算法实现提出了一定的挑战。

嵌入式系统一般具有计算资源有限、存储容量有限和功耗要求低等特点。

因此,在选择适合嵌入式系统的深度学习算法时,需要考虑算法的复杂度、存储需求和处理速度等因素。

例如,可以选择轻量级的网络结构,或者采用剪枝和量化等技术来减小模型的大小和计算量。

此外,还可以将深度学习算法与传统的音频处理和特征提取方法相结合,以达到更好的性能和更高的效率。

然后,选择合适的数据集对基于深度学习的嵌入式语音识别算法实现至关重要。

一个好的数据集应该包含充足且多样化的语音样本,以涵盖不同的语速、口音和语种等变化。

此外,数据集还应该具有正确的标注和较低的噪声干扰,以确保模型能够准确地学习语音的特征和语法结构。

在嵌入式系统上实施语音识别算法时,还需要注意数据集的大小和存储方式,确保可在设备上高效地存储和访问数据。

最后,嵌入式语音识别算法的实现涉及到模型的训练、优化和部署等过程。

首先,需要构建适合嵌入式系统的深度学习模型,并使用选择好的数据集进行训练。

然后,利用优化算法对模型进行调整和改进,以提高识别的准确性和实时性。

最后,将训练好的模型部署到嵌入式设备上,通过接口与其他系统进行集成,从而实现真正的嵌入式语音识别应用。

基于ARM嵌入式孤立词语音识别系统研究与实现的开题报告一、研究背景随着物联网技术的不断发展,嵌入式系统越来越广泛应用于各个领域。

而语音识别技术则作为人机交互的重要手段,同样在嵌入式系统中得到了应用。

孤立词语音识别系统(Isolated Word Speech Recognition,简称IWSR)是语音识别领域中的一个重要分支,它可以对语音信号中的单个孤立的词进行识别。

目前,基于一些开源的语音识别工具库如CMU Sphinx和Kaldi等已经可以很方便地实现孤立词语音识别系统,但是他们在处理效率和嵌入式系统的适应性上还有瓶颈,尤其是在嵌入式系统的资源限制下,这些工具库难以满足实际需求。

因此,一个基于ARM嵌入式系统的高效、精准以及低功耗的孤立词语音识别系统是非常有必要的。

二、研究目的和意义本次研究旨在通过在ARM嵌入式系统上实现孤立词语音识别系统,以探究解决开源语音识别库在嵌入式系统上无法满足高效低功耗的问题的有效途径。

同时,为大数据背景下语音识别技术的普及和使用提供一种新的解决方案。

三、研究内容本次研究将从以下几个方面展开:1. 孤立词语音识别算法研究:介绍孤立词语音识别算法的理论基础,并从训练数据集的选择、特征提取、模型训练等方面对算法进行深入研究。

同时,比较不同算法的复杂度和准确率,为嵌入式系统的应用提供优化策略。

2. 基于ARM嵌入式系统的孤立词语音识别系统设计:针对ARM嵌入式系统的特点和资源限制,系统设计满足实际需求的系统架构,包括硬件平台和软件平台的选择、系统预处理等功能模块的实现、以及实时响应和低功耗的优化。

3. 系统实现和测试:在中国环境下收集人类发音的音频数据,根据预设计算法训练得到声学模型。

通过在嵌入式系统上实现孤立词语音识别算法并进行测试,验证系统的性能和实用性。

四、研究计划本次研究的时间进度如下:1. 孤立词语音识别算法研究与优化(约14个月):(1)算法理论:阅读并理解常见的语音识别算法,以及CMU Sphinx等相关工具库的原理和技术细节;(2)算法实现:根据预设下的算法选型和设计,实现算法,并对其进行效率和准确率的优化。

实现嵌入式音频识别的基本原理及方法嵌入式音频识别是指将嵌入式设备与音频识别技术相结合,实现在嵌入式环境下对音频进行自动识别与处理的技术。

一般情况下,嵌入式音频识别系统包括音频采集、特征提取、模型训练和推理等关键环节,并且需要考虑到嵌入式设备的计算能力、存储资源和功耗等限制因素。

本文将介绍实现嵌入式音频识别的基本原理和常用方法。

一、基本原理实现嵌入式音频识别的基本原理主要包括音频采集、特征提取和模型训练与推理三个步骤。

1. 音频采集:音频采集是指通过嵌入式设备的麦克风或外部音频输入接口收集环境中的音频数据。

采集到的音频数据一般以数字信号的形式存储在嵌入式设备的内存中,为后续的特征提取和模型训练提供数据基础。

2. 特征提取:特征提取是将原始音频数据转换为可以用于识别的特征向量的过程。

常用的特征提取方法包括短时傅里叶变换(STFT)、梅尔频率倒谱系数(MFCC)和基于神经网络的特征提取等。

这些方法可以提取音频信号的频域、时域和声学特征,用于表示和描述音频的关键信息。

3. 模型训练与推理:模型训练是指通过使用已标注的音频数据集来训练音频识别模型,一般采用机器学习算法或深度学习模型进行。

训练好的模型可以对输入的音频数据进行分类或识别。

推理阶段是指将待识别的音频数据输入到训练好的模型中,通过模型的推理过程得到音频的识别结果。

二、常用方法实现嵌入式音频识别的方法多种多样,根据不同的应用需求和硬件资源限制,可以选择合适的方法进行开发。

1. 关键词检测(Keyword Spotting):关键词检测是一种简化的音频识别任务,主要用于监听环境中的指定关键词是否存在。

这种方法可以在嵌入式设备上实现实时的音频识别,常用于语音助手、智能家居等场景中。

关键词检测一般通过训练二分类模型来判断音频中是否包含指定关键词。

2. 声纹识别(Speaker Verification):声纹识别是指通过对声音特征进行比对和匹配,确定说话人身份的过程。

基于深度学习的智能嵌入式语音识别系统设计与实现随着人工智能技术的快速发展,智能语音技术在我们日常生活中的应用越来越广泛。

智能嵌入式语音识别系统是其中的一个重要应用,它能够方便我们的生活,提高工作效率。

本文将从深度学习角度出发,针对智能嵌入式语音识别系统的设计与实现进行探讨。

一、智能嵌入式语音识别系统的概述智能嵌入式语音识别系统是指在较小的芯片集成电路内部实现语音识别的系统,具有体积小、功耗低、性能高等特点。

在实际应用中,智能嵌入式语音识别系统主要应用于智能家居、智能手表、智能手环、智能音箱等场景。

系统的核心技术是语音识别技术,主要分为语音识别预处理、特征提取、语音识别模型、后处理等几个部分。

二、深度学习在智能嵌入式语音识别系统中的应用1.语音识别预处理在语音识别的预处理中,主要的任务是将输入的语音信号进行处理,使得模型能够高精度地进行语音识别。

在深度学习中,语音信号可以通过卷积神经网络(CNN)进行降维,再通过循环神经网络(RNN)进行序列建模,提取出对语音识别有利的特征。

2.特征提取在语音识别的特征提取中,需要将语音信号转换为语谱图等形式的特征。

在深度学习中,可以通过使用卷积神经网络(CNN)进行特征提取,并使用长短时记忆网络(LSTM)进行序列建模,进一步提取出时序特征,并将其送入分类网络使用。

3.语音识别模型在深度学习中,语音识别模型通常采用深度神经网络(DNN)、卷积神经网络(CNN)、循环神经网络(RNN)等模型。

其中,DNN模型普遍应用于语音识别的分类任务,而CNN和RNN模型更适合于序列建模和时序特征提取。

此外,目前流行的语音识别模型主要包括DNN-HMM、CNN-HMM、RNN-HMM和CTC等。

4.后处理在深度学习语音识别模型中,可以通过使用条件随机场(CRF)对输出结果进行后处理,提高识别效果。

同时,可以引入语言模型对识别结果进行相应的校正,提高应用的准确性。

三、智能嵌入式语音识别系统的实现智能嵌入式语音识别系统可以使用ARM Cortex-M3、Cortex-M7等微控制器,将上述的深度学习语音识别算法进行实现。

嵌入式系统中的语音识别技术随着科技的飞速发展,嵌入式系统在我们日常生活中扮演着越来越重要的角色。

其中,语音识别技术作为嵌入式系统的重要组成部分之一,在智能家居、智能手机和人机交互等领域展现出了强大的能力和潜力。

本文将针对嵌入式系统中的语音识别技术进行探讨,探索其原理、应用以及未来发展趋势。

一、语音识别技术的原理语音识别技术是指将人的语音信息转化为数值信号,并通过计算机进行处理和识别的过程。

首先,嵌入式系统中的语音识别技术需要通过麦克风采集用户的语音信号,然后将信号转化为数字信号,并进行预处理,例如降噪和增强等操作。

接下来,语音特征提取是非常关键的一步,通常采用梅尔频率倒谱系数(MFCC)和线性预测编码(LPC)等算法进行语音特征的提取。

最后,使用模式匹配算法,如隐马尔可夫模型(HMM)和深度学习模型(如卷积神经网络和循环神经网络),将提取的语音特征与已知的语音模型进行匹配和识别。

二、嵌入式系统中的语音识别应用举例1. 智能家居随着人们生活水平的提高,智能家居成为了一种新的生活方式。

嵌入式系统中的语音识别技术为智能家居提供了更加便捷的交互方式。

通过语音指令,我们可以实现对家居设备的控制,如开关灯、调节温度等。

这大大提高了家居的智能化程度,使得家居设备更加人性化和智能化。

2. 智能手机语音助手已成为智能手机的标配,嵌入式系统中的语音识别技术支持了智能手机与用户之间的语音交互。

我们可以通过语音指令进行拨号、发送消息、打开应用等操作,不仅方便了用户的操作,还提供了更加安全的驾驶环境。

此外,嵌入式语音识别技术还能够将语音实时转换为文字,方便用户进行文字输入和记录。

3. 人机交互在人机交互领域,语音识别技术已广泛应用于智能音箱、智能助手和机器人等设备上。

通过语音识别技术,我们可以实现与设备的自然对话,例如询问天气、播放音乐、提醒日程等。

这种人机交互方式为用户提供了更加直观、便捷的体验,增强了设备在生活中的陪伴感。

基于嵌入式系统的语音识别研究的开题报告题目:基于嵌入式系统的语音识别研究研究背景和意义:近年来,语音识别技术得到了广泛的应用,如智能家居控制、智能手机语音助手、语音识别转录等。

语音识别技术的发展使得人们可以通过语音指令来控制设备,极大地方便了生活。

然而,许多应用场景需要对语音识别进行实时处理,如驾驶员的语音控制、语音转写等。

为了解决这些实时处理的需求,基于嵌入式系统的语音识别研究变得越来越重要。

嵌入式系统是一种嵌入智能设备中的微型计算机,具有体积小、功耗低和成本低等优点,广泛应用于智能家居、车联网、医疗设备等领域。

在基于嵌入式系统的语音识别研究中,需要研究如何将语音信号转换为数字信号,并将数字信号通过处理器进行实时识别,同时满足资源有限、计算能力有限、时延要求等要求。

这对于提高语音识别的实时性和精确度具有重要意义。

研究内容:本研究的主要内容包括以下几个方面:1. 嵌入式系统的搭建本研究需要搭建基于嵌入式系统的语音识别平台,包括采集语音信号的硬件和实现数字信号处理的软件。

2. 语音信号处理本研究需要研究如何将语音信号转换为数字信号,并通过数字信号处理技术对语音信号进行去噪、预处理等操作,提高信号质量。

3. 语音识别算法研究本研究需要研究基于嵌入式系统的语音识别算法,包括经典的HMM 模型、DNN模型以及语音识别深度学习算法等。

需要对这些算法进行调优,以满足实时处理的需求。

4. 实验评测本研究需要对设计的基于嵌入式系统的语音识别平台进行实验评测,可以评估语音识别的准确度、实时性和资源消耗等方面的指标。

预期成果:通过本研究,预计可以实现基于嵌入式系统的语音识别平台,并将其应用于智能家居和车联网等应用场景中。

同时,预计可以对语音信号处理和语音识别算法进行优化,提高语音识别的准确度和实时性。

此外,本研究还将会在学术界和工业界产生一定的影响力。

嵌入式语音识别系统的研究和实现①方敏,浦剑涛,李成荣,台宪青(中国科学院自动化研究所高技术创新中心,北京100080)摘要:本文首先给出了一种适合于在嵌入式平台上实现的可变命令集的非特定人语音识别系统,同传统的基于PC的非特定人语音识别系统相比,该系统具备内存消耗小,运算速度快的优点。

然后给出了该语音识别系统在多种嵌入式平台上的实现和评估结果,论证了非特定人语音识别系统在嵌入式平台上实现的可行性及其对硬件的最低配置要求,在技术层次上分析了目前实现高性能语音识别SOC的主要问题和困难,并指出了今后相关的研究方向。

关键词:计算机应用;中文信息处理;嵌入式平台;非特定人语音识别;语音识别SOC中图分类号:TP391.4文献标识码:AResearch and Realization of Embedded Speech Recognition SystemFANG Min,PUJian-tao,LI Cheng-rong,TAI Xian-qing(Hi-tech Innovation Center,Institute of Automation,Chinese Acadamy of Science Beijing 100080,China)Abstract:Proposed in this paperis a novel speaker-independent speech recognition system,which is command-variable andsuitable for realization based on embedded pared with traditional speaker-independent speech recognition sys-tem based on PC,our system is featured small storage and computation cost.The system is evaluated on several embeddedplatformsthat are specially designed.According to the result of the evaluation,the feasibility of speaker-independentspeech recognition system based on embedded platform is proved and the least requirement for the hardware is given.Thenwe analyzed the main problems and difficulties in the development of high performance speech recognition SOC(System Ona Chip)from the point of technology,and pointed out some future works.Key words:computer application;Chinese information processing;embedded platform;speaker-independent speech recog-nition;speech recognition SOC1前言随着计算机软硬件技术、半导体技术、电子技术、通讯技术和网络技术等的飞速发展,人类已经进入后PC时代。

这个时代一个典型的特征就是:各种新型智能化的设备日益广泛地走进人们的工作和生活,而人与这些智能化终端之间的自然快捷稳定可靠的交互方式有助于提高人机交互的效率,增强人对智能化设备的控制。

作为人机交互最自然的方式,语音技术的研究近几十年来取得了长足的进展,其中语音识别由于其重要性和研究的难度更成为研究的热点[1,8]。

嵌入式语音识别系统是指应用各种先进的微处理器在板级或是芯片级用软件或硬件实现语音识别技术。

语音识别系统的嵌入式实现要求算法在保证识别效果的前提下尽可能优化, 以适应嵌入式平台存储资源少、实时性要求高的特点。

实验室中高性能的大词汇量连续语音识别系统代表当今语音识别技术的先进水平。

但由于嵌入式平台在资源和速度方面的限制, 其嵌入式实现尚不成熟。

而中小词汇量的命令词语音识别系统由于算法相对简单,对资源的需求较小,且系统识别率和鲁棒性较高,能满足大多数应用的要求,因而成为嵌入式应用的主要着眼点。

目前,在嵌入式平台实现了的主要是对系统的运算资源和存储资源要求比较低的特定人孤立词语音识别系统[7]。

而在现实中,更多的语音识别应用要求系统具有非特定人的特点。

相对而言,特定人语音识别系统可以对整词声学建模,识别则采用简单的DTW等匹配算法,这对小词汇量识别系统的实现效果比较理想。

其缺点是,如果词表更换,就要求采集大量数据, 重新训练模型,且训练好的模型又具有特定人的局限。

本文介绍的非特定人语音识别系统采用基于汉语声韵母的声学建模单元,命令集可变,更换词表时无需重新训练模型,避免了特定人识别系统词表增大模型空间线性增加的缺点。

此项研究的目的在于:通过比较不同平台上的系统实现,分析语音识别系统嵌入式实现的最低运算和存储资源配置要求及系统优化方向,为语音识别系统板级及芯片级的设计开发提供参考依据。

为使系统尽可能少的占用嵌入式平台存储和运算资源并保证识别效果,我们对系统进行了优化,采用压缩的声学模型。

我们分别在数字信号处理能力强的DSP平台和通用性好、性价比高的ARM平台上实现了该系统,考虑到不同的处理器及不同的硬件平台在系统时钟频率、数据处理速度、存储资源、缓冲机制等方面的差异,针对不同的平台对系统进行了模型大小及代码等方面的优化,进一步给出了在各平台上系统实现所要求的最小硬件资源配置及系统能达到的最高实时性能。

嵌入式板级平台的测试评估结果为今后语音识别片上系统(SOC)的研制奠定了技术基础。

本文各小节内容安排如下:第二部分给出了一种适合于嵌入式平台实现的非特定人语音识别系统及其改进系统,第三部分分别介绍了三种嵌入式平台,第四部分给出了该非特定人语音识别系统的实验结果及其在不同嵌入式平台上的评估结果,并对结果进行了分析,最后是本项研究的阶段性结论,并对今后嵌入式语音识别技术的研究方向进行了探讨和展望。

2适用于嵌入式平台的基于汉语声韵母建模的非特定人语音识别系统汉语大词汇量连续语音识别系统(LVCSR)[2~6]一般采用以声韵母为建模单元的上下文相关的声学模型,一遍或多遍的搜索算法,以及N-GRAM的语言模型,词汇量一般达到几万个词, 因此对运行平台的计算能力和存储能力要求非常高,目前只能在主流的PC机上运行。

听写机曾是LVCSR的主流应用模式,但在实际应用中,由于语音识别引擎的识别率及其鲁棒性还不能达到应用的要求,因此听写机的应用并没有得到推广。

但是,LVCSR系统的与说话人无关和自然语言交互的特点,却始终是语音交互接口所不懈追求的。

由于运算资源和存储资源, 以及语音识别引擎本身性能的限制,目前要在嵌入式平台上实现一个可用的口语交互接口是很困难的。

所以本文的研究集中在说话人无关上,希望能够在嵌入式平台上实现一个非特定人的语音识别系统。

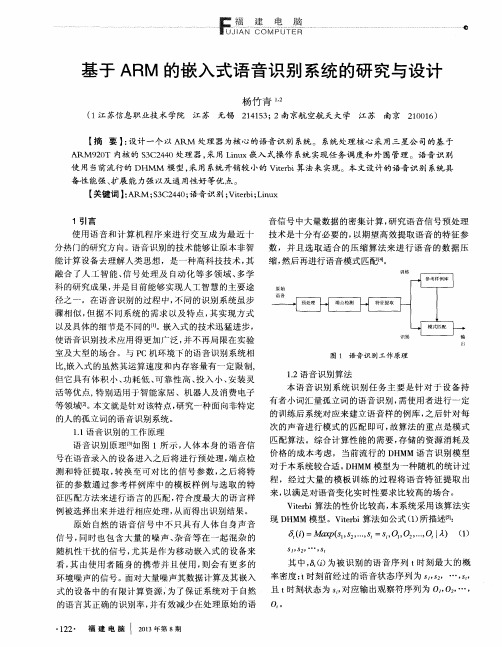

2.1BASELINE系统(简称系统1)图1给出了非特定人语音识别BASELINE系统的框架结构。

74硬性结构图该平台包含:a)一个CPU芯片b)一片FLASHc)一个CODEC语音输入输出接口d)一片AD/DA芯片e)一个麦克风f)如果CPU芯片的片内RAM存储空间太小,还必须外扩RAMg)如果需要向外设输出识别结果,可以增加UART接口和RS232接口3.2基于TMS320C5409的DSP嵌入式平台(简称DSP5409平台)TMS320C5409 DSP是TI公司TMS320C54X系列的产品。

TMS320C54X系列的DSP是一种典型的高性能、低功耗、16位定点DSP,广泛应用在各种嵌入式应用场合。

54X系列的DSP 的处理器速度快,片内资源丰富,完全能够满足非特定人语音识别系统的要求。

我们选择的TMS320C5409 DSP的处理器速度最高可达100MIPS;片内共48K字的存储空间,其中DRAM 是32K字,ROM是16K字;片内具有丰富的外设,如PLL,McBSP,DMA,HIP等,其中McBSP0我们用来和AD DA连接,接收采集到的语音数据。

外扩的资源有:两片1M字节的8位FLASH,支持16位BOOTLOADER模式;外扩512K字SRAM,其中256K字映射在程序区,供程序以扩展寻址方式访问,另外256K映射在数据区的高32K字的空间,分成8页访问,页面切换由烧录在外部CPLD中的逻辑控制。

AD DA芯片采用TI公司的高速模拟接口芯片TLC320AD50,该芯片支持多种采样率,包括16KHz和8KHz,支持16位精度的采样,动态范围为91dB。

3.3基于TI320C5402的DSP嵌入式评估平台(简称DSP5402平台)TI320C5402 DSP也是TI公司TMS320C54X系列的产品,同TI320C5409 DSP相比,主要差别是,片内的存储空间要小得多,其中DARAM是16K字,ROM是4K字。

由于片内DARAM是影响系统的功耗和成本的主要因素,因此TI320C5402 DSP的功耗比5409 DSP更低,成本也只有5409 DSP的1/3。

TI320C5402 DSP的处理器的速度最高也可达100MIPS。

外扩的资源有:一片64K字的16位FLASH,支持16位BOOTLOADER模式;外扩64K字的SARAM,其中高48K字的空间为程序空间和数据空间共享,低16K字的空间的使用方法视DSP的中央处理器的配置寄存器的OVL Y位的状态而定,当OVL Y=0时,SARAM低16K字的空间映射到程序区的低16K字空间,当OVL Y=1时,程序空间和数据空间的低16K字共享DSP的片内16K字的DARAM,片外扩展SARAM的低16K字将无法访问。

由于程序在片内运行的速度比程序在片外运行的速度快6~9倍,需要把语音识别系统中某些运算量大的代码放到片内运行,因此我们选择OVL Y=1,这样,如果不考虑FLASH和ROM的话,程序空间和数据空间一共可用的RAM空间是64K字,这要比上述TI320C5409评估平台的存储资源小得多。

AD DA 芯片采用AIC11,该芯片支持多种采样率,包括16KHz和8KHz,支持16位精度的采样。

另外,该平台对基于TI320C5409 DSP的评估平台上一些不必要的外部扩展资源进行了精简。