第五章 最小二乘法

- 格式:ppt

- 大小:2.65 MB

- 文档页数:62

最小二乘法是一种数学优化技术,它通过最小化误差的平方和来寻找数据的最佳函数匹配。

在许多领域,如线性回归分析、曲线拟合、机器学习、信号处理、控制系统、金融预测和经济建模等,最小二乘法都得到了广泛的应用。

以下是一些最小二乘法的用法举例:1. 线性回归分析线性回归分析是一种统计学方法,用于研究因变量和自变量之间的关系。

最小二乘法可以用于估计线性回归模型的参数,使得预测值和实际观测值之间的残差平方和最小化。

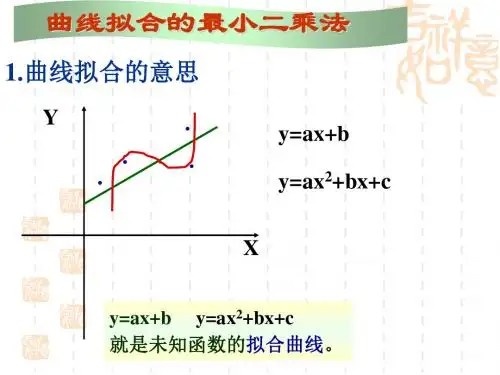

2. 曲线拟合曲线拟合是一种数学方法,用于将一组数据拟合到一个特定的函数模型中。

最小二乘法可以用于估计模型的参数,使得模型预测值和实际观测值之间的残差平方和最小化。

3. 机器学习机器学习是一种人工智能技术,用于让计算机从数据中学习并自动改进其性能。

最小二乘法可以用于训练机器学习模型,例如线性回归模型、逻辑回归模型和支持向量机等。

4. 信号处理信号处理是一种技术,用于对信号进行变换、分析和合成。

最小二乘法可以用于估计信号的参数,例如频率、幅度和相位等,使得信号的预测值和实际观测值之间的残差平方和最小化。

5. 控制系统控制系统是一种技术,用于控制系统的行为并使其达到预期的性能指标。

最小二乘法可以用于估计控制系统的参数,例如传递函数和状态空间模型等,使得控制系统的预测值和实际观测值之间的残差平方和最小化。

6. 金融预测金融预测是一种技术,用于预测金融市场的走势和未来趋势。

最小二乘法可以用于估计金融模型的参数,例如ARIMA模型和神经网络模型等,使得模型的预测值和实际观测值之间的残差平方和最小化。

7. 经济建模经济建模是一种技术,用于建立经济系统的数学模型并对其进行仿真和分析。

最小二乘法可以用于估计经济模型的参数,例如生产函数和需求函数等,使得模型的预测值和实际观测值之间的残差平方和最小化。

最小二乘法的推导过程

最小二乘法是一种线性回归分析方法,用于解决当回归方程中的自变量与因变量之间存在一定误差时,如何求出最优解的问题。

其推

导过程如下:

1. 假设回归方程为y = β0 + β1x1 + β2x2 + ... + βkxk + ε,其中y为因变量,x1,x2,...,xk为自变量,β0,β1,...,βk为

回归系数,ε为误差项。

2. 根据最小二乘法的原理,我们需要求出使误差之和最小的回

归系数,即最小化残差平方和:Σ(yi - ŷi)^2,其中yi为实际值,ŷi为预测值。

3. 将回归方程中的自变量和误差项写成矩阵的形式,得到一个

线性模型:Y = Xβ + e,其中Y为n行1列的因变量向量,X为n行

k+1列的自变量矩阵,β为(k+1)行1列的回归系数向量,e为n行1

列的误差向量。

4. 利用最小二乘法的原理,将残差平方和对回归系数向量β求偏导数,并令其等于0,得到一个求解回归系数的正规方程组:X'Xβ = X'Y,其中X'为X矩阵的转置。

5. 解正规方程组,得到回归系数向量β的估计值:β =

(X'X)^-1X'Y。

6. 将得到的回归系数代入原始的回归方程中,即可得到最终的

线性回归方程。

通过以上推导过程,我们可以利用最小二乘法求解线性回归方程中的回归系数,从而预测因变量的值。

这种方法常用于统计学、金融学、经济学等领域,可以帮助我们更好地理解和分析数据。

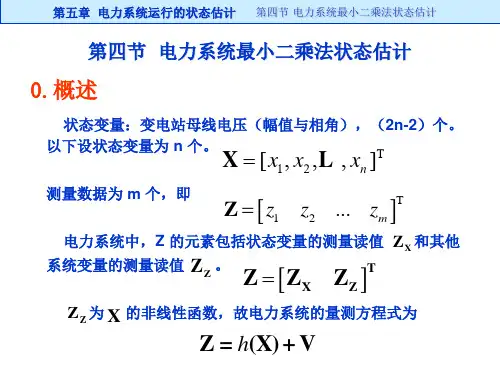

第五章 广义逆及最小二乘解在应用上见得最频繁的、大约莫过于线性方程组了。

作一番调查或整理一批实验数据,常常归结为一个线性方程组:Ax b =然而是否是相容方程呢?倘若不是,又如何处理呢?最小二乘解是常见的一种处理方法。

其实它不过是最小二乘法的代数形式而已。

广义逆从1935年Moore 提出以后,未得响应。

据说: (S.L.Campbell & C.D.Meyer.Jr Generalized Inverses of Linear Transformations 1979 P9)原因之一,可能是他给出的定义,有点晦涩。

其后,1955年Penrose 给出了现在大都采用的定义以后,对广义逆的研究起了影响,三十年来,广义逆无论在理论还是应用上都有了巨大发展,一直成为了线性代数中不可缺少的内容之一。

为了讨论的顺利进行,我们在第一节中先给出点准备,作出矩阵的奇值分解。

§5.1 矩阵的酉交分解、满秩分解和奇值分解在线行空间中,知道一个线性变换在不同基偶下的矩阵表示是相抵的或等价的。

用矩阵的语言来说,就是:若 ,m n A B C ×∈,倘有非异矩阵()P m n ×,()Q n n ×存在,使B PAQ =则称A 与B 相抵的或等价的。

利用初等变换容易证明m n A C ×∈,秩为r ,则必有P ,Q ,使000r m nI PAQ C ×⎛⎞=∈⎜⎟⎝⎠(5.1-1) 其中r I 是r 阶单位阵。

在酉空间中,上面的说法,当然也成立,如果加上P ,Q 是酉交阵的要求,情形又如何呢?下面就来讨论这个问题。

定理 5.1.1 (酉交分解) m n A C ×∈,且秩为r ,则(),(),,H H m n U m n V n n U U I V V I ∃××==,使00r HU AV Δ⎛⎞=×⎜⎟⎝⎠(m n) (5.1-2) 其中r Δ为r 阶非异下三角阵。

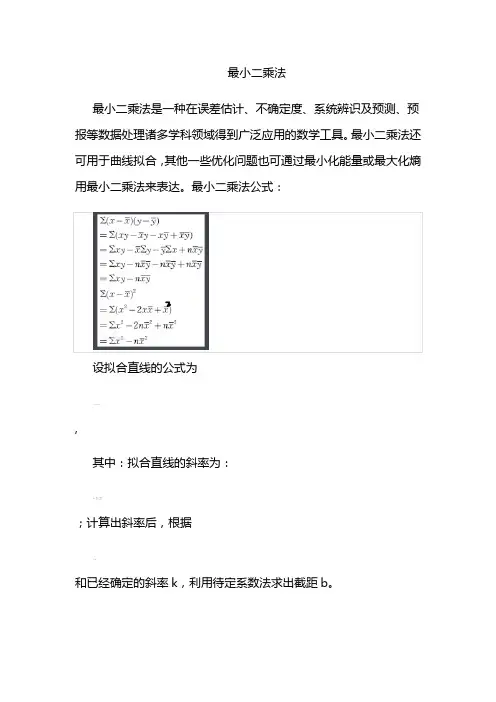

最小二乘法最小二乘法是一种在误差估计、不确定度、系统辨识及预测、预报等数据处理诸多学科领域得到广泛应用的数学工具。

最小二乘法还可用于曲线拟合,其他一些优化问题也可通过最小化能量或最大化熵用最小二乘法来表达。

最小二乘法公式:设拟合直线的公式为,其中:拟合直线的斜率为:;计算出斜率后,根据和已经确定的斜率k,利用待定系数法求出截距b。

在我们研究两个变量(x, y)之间的相互关系时,通常可以得到一系列成对的数据(x1, y1),(x2, y2).. (xm , ym);将这些数据描绘在x -y 直角坐标系中(如图1), 若发现这些点在一条直线附近,可以令这条直线方程如(式1-1)。

Y计= a0 + a1 X (式1-1)其中:a0、a1 是任意实数为建立这直线方程就要确定a0和a1,应用《最小二乘法原理》,将实测值Yi与利用(式1-1)计算值(Y计=a0+a1X)的离差(Yi-Y计)的平方和〔∑(Yi - Y计)²〕最小为“优化判据”。

令: φ= ∑(Yi - Y计)² (式1-2)把(式1-1)代入(式1-2)中得:φ= ∑(Yi - a0 - a1 Xi)2 (式1-3)当∑(Yi-Y计)²最小时,可用函数φ对a0、a1求偏导数,令这两个偏导数等于零。

(式1-4)(式1-5)亦即m a0 + (∑Xi ) a1 = ∑Yi (式1-6)(∑Xi ) a0 + (∑Xi2 ) a1 = ∑(Xi, Yi) (式1-7)得到的两个关于a0、a1为未知数的两个方程组,解这两个方程组得出:a0 = (∑Yi) / m - a1(∑Xi) / m (式1-8)a1 = [∑Xi Yi - (∑Xi ∑Yi)/ m] / [∑Xi2 - (∑Xi)2 / m)] (式1-9) 这时把a0、a1代入(式1-1)中, 此时的(式1-1)就是我们回归的元线性方程即:数学模型。

最小二乘函数

最小二乘法(又称最小平方法)是一种数学优化技术。

它通过最小化误差的平方和寻找数据的最佳函数匹配。

利用最小二乘法可以简便地求得未知的数据,并使得这些求得的数据与实际数据之间误差的平方和为最小。

最小二乘法还可用于曲线拟合。

其他一些优化问题也可通过最小化能量或最大化熵用最小二乘法来表达。

根据样本数据,采用最小二乘估计式可以得到简单线性回归模型参数的估计量。

但是估计量参数与总体真实参数的接近程度如何,是否存在更好的其它估计式,这就涉及到最小二乘估计式或估计量的最小方差(或最佳)性、线性及无偏性,简称为BLU特性。

最小二乘法1:最小二乘法的原理与要解决的问题最小二乘法是由勒让德在19世纪发现的,形式如下式:标函数 = \sum(观测值-理论值)^2\\观测值就是我们的多组样本,理论值就是我们的假设拟合函数。

目标函数也就是在机器学习中常说的损失函数,我们的目标是得到使目标函数最小化时候的拟合函数的模型。

举一个最简单的线性回归的简单例子,比如我们有 m 个只有一个特征的样本: (x_i, y_i)(i=1, 2, 3...,m)样本采用一般的 h_{\theta}(x) 为 n 次的多项式拟合,h_{\theta}(x)=\theta_0+\theta_1x+\theta_2x^2+...\theta _nx^n,\theta(\theta_0,\theta_1,\theta_2,...,\theta_n) 为参数最小二乘法就是要找到一组\theta(\theta_0,\theta_1,\theta_2,...,\theta_n) 使得\sum_{i=1}^n(h_{\theta}(x_i)-y_i)^2 (残差平方和) 最小,即,求 min\sum_{i=1}^n(h_{\theta}(x_i)-y_i)^22 :最小二乘法的矩阵法解法最小二乘法的代数法解法就是对 \theta_i 求偏导数,令偏导数为0,再解方程组,得到 \theta_i 。

矩阵法比代数法要简洁,下面主要讲解下矩阵法解法,这里用多元线性回归例子来描:假设函数h_{\theta}(x_1,x_2,...x_n)=\theta_0+\theta_1x_1+...+\t heta_nx_n 的矩阵表达方式为:h_{\theta}(\mathbf{x})=\mathbf{X}\theta\\其中,假设函数 h_{\theta}(\mathbf{x})=\mathbf{X}\theta 为 m\times1 的向量, \theta 为 n\times1 的向量,里面有 n 个代数法的模型参数。

最小二乘法方差推导导言最小二乘法是一种常用的回归分析方法,用于建立变量之间的关系模型。

在使用最小二乘法进行回归分析时,我们通常会考虑误差的大小和分布情况。

方差是一种常用的衡量误差大小的指标,通过推导最小二乘法的方差,可以更好地理解最小二乘法的原理和应用。

一、线性回归模型线性回归模型是最简单也是最常用的回归模型之一。

假设我们有一组观测数据(x1,y1),(x2,y2),...,(x n,y n),其中x i表示自变量,y i表示因变量。

线性回归模型的基本形式可以表示为:y=β0+β1x+ϵ其中y表示因变量,β0和β1分别表示截距和斜率,ϵ表示误差。

二、最小二乘法原理最小二乘法的目标是找到一条直线,使得观测数据到这条直线的距离最短。

假设观测数据的真实值为y i,模型预测值为y î,则观测数据的误差可以表示为e i=y i−y î。

最小二乘法的原理是通过最小化误差的平方和来估计回归模型的参数。

具体来说,我们希望找到一组参数β0̂和β1̂,使得观测数据的误差平方和最小。

误差平方和可以表示为:nSSE=∑(y i−y î)2i=1三、最小二乘法方差的推导最小二乘法方差是衡量观测数据与回归模型之间的离散程度的指标。

我们通过推导最小二乘法的方差,可以更好地理解模型的可靠性和拟合程度。

3.1 残差在推导最小二乘法方差之前,我们首先定义残差e i。

残差表示观测数据的真实值与模型预测值之间的差异。

对于线性回归模型,残差可以表示为e i=y i−y î。

3.2 方差推导方差是衡量观测数据与回归模型之间的离散程度的指标。

我们通过推导最小二乘法的方差,可以衡量回归模型的可靠性和拟合程度。

方差可以表示为残差平方和除以观测数据的数量。

具体来说,方差可以表示为:Var=SSE n其中,n表示观测数据的数量,SSE表示观测数据的误差平方和。

四、小结最小二乘法是一种常用的回归分析方法,可以用于建立变量之间的关系模型。

通过最小化观测数据与模型预测值之间的误差平方和,可以得到回归模型的参数估计值。