Binary classification二分类

- 格式:docx

- 大小:103.94 KB

- 文档页数:5

matlab二分类算法二分类算法是机器学习领域中的一种常见算法,它将数据集划分为两个类别,并预测新样本属于哪一类。

MATLAB作为一种强大的数值计算和数据分析工具,提供了多种用于二分类问题的算法。

本文将介绍一些常用的MATLAB二分类算法,并说明其原理和使用方法。

一、支持向量机(Support Vector Machine,SVM)是一种非常流行的二分类算法。

其核心思想是将数据集转换为高维空间,然后找到一个超平面,使得两个类别的数据点在该超平面上的投影最大化。

在MATLAB中,可以使用fitcsvm函数来训练SVM模型,并使用predict函数进行预测。

该函数提供了多种参数配置选项,如核函数类型、惩罚系数等。

二、逻辑回归(Logistic Regression)是另一种常用的二分类算法。

它通过将线性回归模型的输出映射到一个概率值(0~1之间),然后根据阈值进行分类预测。

在MATLAB中,可以使用fitglm函数进行逻辑回归模型的训练,并使用predict函数进行预测。

fitglm函数支持多种模型配置选项,如正则化类型、损失函数类型等。

三、随机森林(Random Forest)是一种基于集成学习的二分类算法。

它由多个决策树组成,每棵树对数据集进行随机采样,并在每个节点上选择最佳的特征进行分割。

最终,通过对多棵树的结果进行投票或平均,得到最终的预测结果。

在MATLAB中,可以使用TreeBagger类来实现随机森林算法。

通过创建TreeBagger对象,设置参数并调用train函数来训练模型,然后使用predict函数进行预测。

四、神经网络(Neural Network)是一种通过模拟人脑中的神经元网络来解决问题的方法。

在二分类问题中,神经网络可以通过多个神经元和多个隐藏层构建一个复杂的模型,并通过调整权重和偏置来训练模型。

在MATLAB中,可以使用patternnet函数来创建神经网络模型,并使用train函数进行训练。

机器学习专业词汇中英⽂对照activation 激活值activation function 激活函数additive noise 加性噪声autoencoder ⾃编码器Autoencoders ⾃编码算法average firing rate 平均激活率average sum-of-squares error 均⽅差backpropagation 后向传播basis 基basis feature vectors 特征基向量batch gradient ascent 批量梯度上升法Bayesian regularization method 贝叶斯规则化⽅法Bernoulli random variable 伯努利随机变量bias term 偏置项binary classfication ⼆元分类class labels 类型标记concatenation 级联conjugate gradient 共轭梯度contiguous groups 联通区域convex optimization software 凸优化软件convolution 卷积cost function 代价函数covariance matrix 协⽅差矩阵DC component 直流分量decorrelation 去相关degeneracy 退化demensionality reduction 降维derivative 导函数diagonal 对⾓线diffusion of gradients 梯度的弥散eigenvalue 特征值eigenvector 特征向量error term 残差feature matrix 特征矩阵feature standardization 特征标准化feedforward architectures 前馈结构算法feedforward neural network 前馈神经⽹络feedforward pass 前馈传导fine-tuned 微调first-order feature ⼀阶特征forward pass 前向传导forward propagation 前向传播Gaussian prior ⾼斯先验概率generative model ⽣成模型gradient descent 梯度下降Greedy layer-wise training 逐层贪婪训练⽅法grouping matrix 分组矩阵Hadamard product 阿达马乘积Hessian matrix Hessian 矩阵hidden layer 隐含层hidden units 隐藏神经元Hierarchical grouping 层次型分组higher-order features 更⾼阶特征highly non-convex optimization problem ⾼度⾮凸的优化问题histogram 直⽅图hyperbolic tangent 双曲正切函数hypothesis 估值,假设identity activation function 恒等激励函数IID 独⽴同分布illumination 照明inactive 抑制independent component analysis 独⽴成份分析input domains 输⼊域input layer 输⼊层intensity 亮度/灰度intercept term 截距KL divergence 相对熵KL divergence KL分散度k-Means K-均值learning rate 学习速率least squares 最⼩⼆乘法linear correspondence 线性响应linear superposition 线性叠加line-search algorithm 线搜索算法local mean subtraction 局部均值消减local optima 局部最优解logistic regression 逻辑回归loss function 损失函数low-pass filtering 低通滤波magnitude 幅值MAP 极⼤后验估计maximum likelihood estimation 极⼤似然估计mean 平均值MFCC Mel 倒频系数multi-class classification 多元分类neural networks 神经⽹络neuron 神经元Newton’s method ⽜顿法non-convex function ⾮凸函数non-linear feature ⾮线性特征norm 范式norm bounded 有界范数norm constrained 范数约束normalization 归⼀化numerical roundoff errors 数值舍⼊误差numerically checking 数值检验numerically reliable 数值计算上稳定object detection 物体检测objective function ⽬标函数off-by-one error 缺位错误orthogonalization 正交化output layer 输出层overall cost function 总体代价函数over-complete basis 超完备基over-fitting 过拟合parts of objects ⽬标的部件part-whole decompostion 部分-整体分解PCA 主元分析penalty term 惩罚因⼦per-example mean subtraction 逐样本均值消减pooling 池化pretrain 预训练principal components analysis 主成份分析quadratic constraints ⼆次约束RBMs 受限Boltzman机reconstruction based models 基于重构的模型reconstruction cost 重建代价reconstruction term 重构项redundant 冗余reflection matrix 反射矩阵regularization 正则化regularization term 正则化项rescaling 缩放robust 鲁棒性run ⾏程second-order feature ⼆阶特征sigmoid activation function S型激励函数significant digits 有效数字singular value 奇异值singular vector 奇异向量smoothed L1 penalty 平滑的L1范数惩罚Smoothed topographic L1 sparsity penalty 平滑地形L1稀疏惩罚函数smoothing 平滑Softmax Regresson Softmax回归sorted in decreasing order 降序排列source features 源特征sparse autoencoder 消减归⼀化Sparsity 稀疏性sparsity parameter 稀疏性参数sparsity penalty 稀疏惩罚square function 平⽅函数squared-error ⽅差stationary 平稳性(不变性)stationary stochastic process 平稳随机过程step-size 步长值supervised learning 监督学习symmetric positive semi-definite matrix 对称半正定矩阵symmetry breaking 对称失效tanh function 双曲正切函数the average activation 平均活跃度the derivative checking method 梯度验证⽅法the empirical distribution 经验分布函数the energy function 能量函数the Lagrange dual 拉格朗⽇对偶函数the log likelihood 对数似然函数the pixel intensity value 像素灰度值the rate of convergence 收敛速度topographic cost term 拓扑代价项topographic ordered 拓扑秩序transformation 变换translation invariant 平移不变性trivial answer 平凡解under-complete basis 不完备基unrolling 组合扩展unsupervised learning ⽆监督学习variance ⽅差vecotrized implementation 向量化实现vectorization ⽮量化visual cortex 视觉⽪层weight decay 权重衰减weighted average 加权平均值whitening ⽩化zero-mean 均值为零Letter AAccumulated error backpropagation 累积误差逆传播Activation Function 激活函数Adaptive Resonance Theory/ART ⾃适应谐振理论Addictive model 加性学习Adversarial Networks 对抗⽹络Affine Layer 仿射层Affinity matrix 亲和矩阵Agent 代理 / 智能体Algorithm 算法Alpha-beta pruning α-β剪枝Anomaly detection 异常检测Approximation 近似Area Under ROC Curve/AUC Roc 曲线下⾯积Artificial General Intelligence/AGI 通⽤⼈⼯智能Artificial Intelligence/AI ⼈⼯智能Association analysis 关联分析Attention mechanism 注意⼒机制Attribute conditional independence assumption 属性条件独⽴性假设Attribute space 属性空间Attribute value 属性值Autoencoder ⾃编码器Automatic speech recognition ⾃动语⾳识别Automatic summarization ⾃动摘要Average gradient 平均梯度Average-Pooling 平均池化Letter BBackpropagation Through Time 通过时间的反向传播Backpropagation/BP 反向传播Base learner 基学习器Base learning algorithm 基学习算法Batch Normalization/BN 批量归⼀化Bayes decision rule 贝叶斯判定准则Bayes Model Averaging/BMA 贝叶斯模型平均Bayes optimal classifier 贝叶斯最优分类器Bayesian decision theory 贝叶斯决策论Bayesian network 贝叶斯⽹络Between-class scatter matrix 类间散度矩阵Bias 偏置 / 偏差Bias-variance decomposition 偏差-⽅差分解Bias-Variance Dilemma 偏差 – ⽅差困境Bi-directional Long-Short Term Memory/Bi-LSTM 双向长短期记忆Binary classification ⼆分类Binomial test ⼆项检验Bi-partition ⼆分法Boltzmann machine 玻尔兹曼机Bootstrap sampling ⾃助采样法/可重复采样/有放回采样Bootstrapping ⾃助法Break-Event Point/BEP 平衡点Letter CCalibration 校准Cascade-Correlation 级联相关Categorical attribute 离散属性Class-conditional probability 类条件概率Classification and regression tree/CART 分类与回归树Classifier 分类器Class-imbalance 类别不平衡Closed -form 闭式Cluster 簇/类/集群Cluster analysis 聚类分析Clustering 聚类Clustering ensemble 聚类集成Co-adapting 共适应Coding matrix 编码矩阵COLT 国际学习理论会议Committee-based learning 基于委员会的学习Competitive learning 竞争型学习Component learner 组件学习器Comprehensibility 可解释性Computation Cost 计算成本Computational Linguistics 计算语⾔学Computer vision 计算机视觉Concept drift 概念漂移Concept Learning System /CLS 概念学习系统Conditional entropy 条件熵Conditional mutual information 条件互信息Conditional Probability Table/CPT 条件概率表Conditional random field/CRF 条件随机场Conditional risk 条件风险Confidence 置信度Confusion matrix 混淆矩阵Connection weight 连接权Connectionism 连结主义Consistency ⼀致性/相合性Contingency table 列联表Continuous attribute 连续属性Convergence 收敛Conversational agent 会话智能体Convex quadratic programming 凸⼆次规划Convexity 凸性Convolutional neural network/CNN 卷积神经⽹络Co-occurrence 同现Correlation coefficient 相关系数Cosine similarity 余弦相似度Cost curve 成本曲线Cost Function 成本函数Cost matrix 成本矩阵Cost-sensitive 成本敏感Cross entropy 交叉熵Cross validation 交叉验证Crowdsourcing 众包Curse of dimensionality 维数灾难Cut point 截断点Cutting plane algorithm 割平⾯法Letter DData mining 数据挖掘Data set 数据集Decision Boundary 决策边界Decision stump 决策树桩Decision tree 决策树/判定树Deduction 演绎Deep Belief Network 深度信念⽹络Deep Convolutional Generative Adversarial Network/DCGAN 深度卷积⽣成对抗⽹络Deep learning 深度学习Deep neural network/DNN 深度神经⽹络Deep Q-Learning 深度 Q 学习Deep Q-Network 深度 Q ⽹络Density estimation 密度估计Density-based clustering 密度聚类Differentiable neural computer 可微分神经计算机Dimensionality reduction algorithm 降维算法Directed edge 有向边Disagreement measure 不合度量Discriminative model 判别模型Discriminator 判别器Distance measure 距离度量Distance metric learning 距离度量学习Distribution 分布Divergence 散度Diversity measure 多样性度量/差异性度量Domain adaption 领域⾃适应Downsampling 下采样D-separation (Directed separation)有向分离Dual problem 对偶问题Dummy node 哑结点Dynamic Fusion 动态融合Dynamic programming 动态规划Letter EEigenvalue decomposition 特征值分解Embedding 嵌⼊Emotional analysis 情绪分析Empirical conditional entropy 经验条件熵Empirical entropy 经验熵Empirical error 经验误差Empirical risk 经验风险End-to-End 端到端Energy-based model 基于能量的模型Ensemble learning 集成学习Ensemble pruning 集成修剪Error Correcting Output Codes/ECOC 纠错输出码Error rate 错误率Error-ambiguity decomposition 误差-分歧分解Euclidean distance 欧⽒距离Evolutionary computation 演化计算Expectation-Maximization 期望最⼤化Expected loss 期望损失Exploding Gradient Problem 梯度爆炸问题Exponential loss function 指数损失函数Extreme Learning Machine/ELM 超限学习机Letter FFactorization 因⼦分解False negative 假负类False positive 假正类False Positive Rate/FPR 假正例率Feature engineering 特征⼯程Feature selection 特征选择Feature vector 特征向量Featured Learning 特征学习Feedforward Neural Networks/FNN 前馈神经⽹络Fine-tuning 微调Flipping output 翻转法Fluctuation 震荡Forward stagewise algorithm 前向分步算法Frequentist 频率主义学派Full-rank matrix 满秩矩阵Functional neuron 功能神经元Letter GGain ratio 增益率Game theory 博弈论Gaussian kernel function ⾼斯核函数Gaussian Mixture Model ⾼斯混合模型General Problem Solving 通⽤问题求解Generalization 泛化Generalization error 泛化误差Generalization error bound 泛化误差上界Generalized Lagrange function ⼴义拉格朗⽇函数Generalized linear model ⼴义线性模型Generalized Rayleigh quotient ⼴义瑞利商Generative Adversarial Networks/GAN ⽣成对抗⽹络Generative Model ⽣成模型Generator ⽣成器Genetic Algorithm/GA 遗传算法Gibbs sampling 吉布斯采样Gini index 基尼指数Global minimum 全局最⼩Global Optimization 全局优化Gradient boosting 梯度提升Gradient Descent 梯度下降Graph theory 图论Ground-truth 真相/真实Letter HHard margin 硬间隔Hard voting 硬投票Harmonic mean 调和平均Hesse matrix 海塞矩阵Hidden dynamic model 隐动态模型Hidden layer 隐藏层Hidden Markov Model/HMM 隐马尔可夫模型Hierarchical clustering 层次聚类Hilbert space 希尔伯特空间Hinge loss function 合页损失函数Hold-out 留出法Homogeneous 同质Hybrid computing 混合计算Hyperparameter 超参数Hypothesis 假设Hypothesis test 假设验证Letter IICML 国际机器学习会议Improved iterative scaling/IIS 改进的迭代尺度法Incremental learning 增量学习Independent and identically distributed/i.i.d. 独⽴同分布Independent Component Analysis/ICA 独⽴成分分析Indicator function 指⽰函数Individual learner 个体学习器Induction 归纳Inductive bias 归纳偏好Inductive learning 归纳学习Inductive Logic Programming/ILP 归纳逻辑程序设计Information entropy 信息熵Information gain 信息增益Input layer 输⼊层Insensitive loss 不敏感损失Inter-cluster similarity 簇间相似度International Conference for Machine Learning/ICML 国际机器学习⼤会Intra-cluster similarity 簇内相似度Intrinsic value 固有值Isometric Mapping/Isomap 等度量映射Isotonic regression 等分回归Iterative Dichotomiser 迭代⼆分器Letter KKernel method 核⽅法Kernel trick 核技巧Kernelized Linear Discriminant Analysis/KLDA 核线性判别分析K-fold cross validation k 折交叉验证/k 倍交叉验证K-Means Clustering K – 均值聚类K-Nearest Neighbours Algorithm/KNN K近邻算法Knowledge base 知识库Knowledge Representation 知识表征Letter LLabel space 标记空间Lagrange duality 拉格朗⽇对偶性Lagrange multiplier 拉格朗⽇乘⼦Laplace smoothing 拉普拉斯平滑Laplacian correction 拉普拉斯修正Latent Dirichlet Allocation 隐狄利克雷分布Latent semantic analysis 潜在语义分析Latent variable 隐变量Lazy learning 懒惰学习Learner 学习器Learning by analogy 类⽐学习Learning rate 学习率Learning Vector Quantization/LVQ 学习向量量化Least squares regression tree 最⼩⼆乘回归树Leave-One-Out/LOO 留⼀法linear chain conditional random field 线性链条件随机场Linear Discriminant Analysis/LDA 线性判别分析Linear model 线性模型Linear Regression 线性回归Link function 联系函数Local Markov property 局部马尔可夫性Local minimum 局部最⼩Log likelihood 对数似然Log odds/logit 对数⼏率Logistic Regression Logistic 回归Log-likelihood 对数似然Log-linear regression 对数线性回归Long-Short Term Memory/LSTM 长短期记忆Loss function 损失函数Letter MMachine translation/MT 机器翻译Macron-P 宏查准率Macron-R 宏查全率Majority voting 绝对多数投票法Manifold assumption 流形假设Manifold learning 流形学习Margin theory 间隔理论Marginal distribution 边际分布Marginal independence 边际独⽴性Marginalization 边际化Markov Chain Monte Carlo/MCMC 马尔可夫链蒙特卡罗⽅法Markov Random Field 马尔可夫随机场Maximal clique 最⼤团Maximum Likelihood Estimation/MLE 极⼤似然估计/极⼤似然法Maximum margin 最⼤间隔Maximum weighted spanning tree 最⼤带权⽣成树Max-Pooling 最⼤池化Mean squared error 均⽅误差Meta-learner 元学习器Metric learning 度量学习Micro-P 微查准率Micro-R 微查全率Minimal Description Length/MDL 最⼩描述长度Minimax game 极⼩极⼤博弈Misclassification cost 误分类成本Mixture of experts 混合专家Momentum 动量Moral graph 道德图/端正图Multi-class classification 多分类Multi-document summarization 多⽂档摘要Multi-layer feedforward neural networks 多层前馈神经⽹络Multilayer Perceptron/MLP 多层感知器Multimodal learning 多模态学习Multiple Dimensional Scaling 多维缩放Multiple linear regression 多元线性回归Multi-response Linear Regression /MLR 多响应线性回归Mutual information 互信息Letter NNaive bayes 朴素贝叶斯Naive Bayes Classifier 朴素贝叶斯分类器Named entity recognition 命名实体识别Nash equilibrium 纳什均衡Natural language generation/NLG ⾃然语⾔⽣成Natural language processing ⾃然语⾔处理Negative class 负类Negative correlation 负相关法Negative Log Likelihood 负对数似然Neighbourhood Component Analysis/NCA 近邻成分分析Neural Machine Translation 神经机器翻译Neural Turing Machine 神经图灵机Newton method ⽜顿法NIPS 国际神经信息处理系统会议No Free Lunch Theorem/NFL 没有免费的午餐定理Noise-contrastive estimation 噪⾳对⽐估计Nominal attribute 列名属性Non-convex optimization ⾮凸优化Nonlinear model ⾮线性模型Non-metric distance ⾮度量距离Non-negative matrix factorization ⾮负矩阵分解Non-ordinal attribute ⽆序属性Non-Saturating Game ⾮饱和博弈Norm 范数Normalization 归⼀化Nuclear norm 核范数Numerical attribute 数值属性Letter OObjective function ⽬标函数Oblique decision tree 斜决策树Occam’s razor 奥卡姆剃⼑Odds ⼏率Off-Policy 离策略One shot learning ⼀次性学习One-Dependent Estimator/ODE 独依赖估计On-Policy 在策略Ordinal attribute 有序属性Out-of-bag estimate 包外估计Output layer 输出层Output smearing 输出调制法Overfitting 过拟合/过配Oversampling 过采样Letter PPaired t-test 成对 t 检验Pairwise 成对型Pairwise Markov property 成对马尔可夫性Parameter 参数Parameter estimation 参数估计Parameter tuning 调参Parse tree 解析树Particle Swarm Optimization/PSO 粒⼦群优化算法Part-of-speech tagging 词性标注Perceptron 感知机Performance measure 性能度量Plug and Play Generative Network 即插即⽤⽣成⽹络Plurality voting 相对多数投票法Polarity detection 极性检测Polynomial kernel function 多项式核函数Pooling 池化Positive class 正类Positive definite matrix 正定矩阵Post-hoc test 后续检验Post-pruning 后剪枝potential function 势函数Precision 查准率/准确率Prepruning 预剪枝Principal component analysis/PCA 主成分分析Principle of multiple explanations 多释原则Prior 先验Probability Graphical Model 概率图模型Proximal Gradient Descent/PGD 近端梯度下降Pruning 剪枝Pseudo-label 伪标记Letter QQuantized Neural Network 量⼦化神经⽹络Quantum computer 量⼦计算机Quantum Computing 量⼦计算Quasi Newton method 拟⽜顿法Letter RRadial Basis Function/RBF 径向基函数Random Forest Algorithm 随机森林算法Random walk 随机漫步Recall 查全率/召回率Receiver Operating Characteristic/ROC 受试者⼯作特征Rectified Linear Unit/ReLU 线性修正单元Recurrent Neural Network 循环神经⽹络Recursive neural network 递归神经⽹络Reference model 参考模型Regression 回归Regularization 正则化Reinforcement learning/RL 强化学习Representation learning 表征学习Representer theorem 表⽰定理reproducing kernel Hilbert space/RKHS 再⽣核希尔伯特空间Re-sampling 重采样法Rescaling 再缩放Residual Mapping 残差映射Residual Network 残差⽹络Restricted Boltzmann Machine/RBM 受限玻尔兹曼机Restricted Isometry Property/RIP 限定等距性Re-weighting 重赋权法Robustness 稳健性/鲁棒性Root node 根结点Rule Engine 规则引擎Rule learning 规则学习Letter SSaddle point 鞍点Sample space 样本空间Sampling 采样Score function 评分函数Self-Driving ⾃动驾驶Self-Organizing Map/SOM ⾃组织映射Semi-naive Bayes classifiers 半朴素贝叶斯分类器Semi-Supervised Learning 半监督学习semi-Supervised Support Vector Machine 半监督⽀持向量机Sentiment analysis 情感分析Separating hyperplane 分离超平⾯Sigmoid function Sigmoid 函数Similarity measure 相似度度量Simulated annealing 模拟退⽕Simultaneous localization and mapping 同步定位与地图构建Singular Value Decomposition 奇异值分解Slack variables 松弛变量Smoothing 平滑Soft margin 软间隔Soft margin maximization 软间隔最⼤化Soft voting 软投票Sparse representation 稀疏表征Sparsity 稀疏性Specialization 特化Spectral Clustering 谱聚类Speech Recognition 语⾳识别Splitting variable 切分变量Squashing function 挤压函数Stability-plasticity dilemma 可塑性-稳定性困境Statistical learning 统计学习Status feature function 状态特征函Stochastic gradient descent 随机梯度下降Stratified sampling 分层采样Structural risk 结构风险Structural risk minimization/SRM 结构风险最⼩化Subspace ⼦空间Supervised learning 监督学习/有导师学习support vector expansion ⽀持向量展式Support Vector Machine/SVM ⽀持向量机Surrogat loss 替代损失Surrogate function 替代函数Symbolic learning 符号学习Symbolism 符号主义Synset 同义词集Letter TT-Distribution Stochastic Neighbour Embedding/t-SNE T – 分布随机近邻嵌⼊Tensor 张量Tensor Processing Units/TPU 张量处理单元The least square method 最⼩⼆乘法Threshold 阈值Threshold logic unit 阈值逻辑单元Threshold-moving 阈值移动Time Step 时间步骤Tokenization 标记化Training error 训练误差Training instance 训练⽰例/训练例Transductive learning 直推学习Transfer learning 迁移学习Treebank 树库Tria-by-error 试错法True negative 真负类True positive 真正类True Positive Rate/TPR 真正例率Turing Machine 图灵机Twice-learning ⼆次学习Letter UUnderfitting ⽋拟合/⽋配Undersampling ⽋采样Understandability 可理解性Unequal cost ⾮均等代价Unit-step function 单位阶跃函数Univariate decision tree 单变量决策树Unsupervised learning ⽆监督学习/⽆导师学习Unsupervised layer-wise training ⽆监督逐层训练Upsampling 上采样Letter VVanishing Gradient Problem 梯度消失问题Variational inference 变分推断VC Theory VC维理论Version space 版本空间Viterbi algorithm 维特⽐算法Von Neumann architecture 冯 · 诺伊曼架构Letter WWasserstein GAN/WGAN Wasserstein⽣成对抗⽹络Weak learner 弱学习器Weight 权重Weight sharing 权共享Weighted voting 加权投票法Within-class scatter matrix 类内散度矩阵Word embedding 词嵌⼊Word sense disambiguation 词义消歧Letter ZZero-data learning 零数据学习Zero-shot learning 零次学习Aapproximations近似值arbitrary随意的affine仿射的arbitrary任意的amino acid氨基酸amenable经得起检验的axiom公理,原则abstract提取architecture架构,体系结构;建造业absolute绝对的arsenal军⽕库assignment分配algebra线性代数asymptotically⽆症状的appropriate恰当的Bbias偏差brevity简短,简洁;短暂broader⼴泛briefly简短的batch批量Cconvergence 收敛,集中到⼀点convex凸的contours轮廓constraint约束constant常理commercial商务的complementarity补充coordinate ascent同等级上升clipping剪下物;剪报;修剪component分量;部件continuous连续的covariance协⽅差canonical正规的,正则的concave⾮凸的corresponds相符合;相当;通信corollary推论concrete具体的事物,实在的东西cross validation交叉验证correlation相互关系convention约定cluster⼀簇centroids 质⼼,形⼼converge收敛computationally计算(机)的calculus计算Dderive获得,取得dual⼆元的duality⼆元性;⼆象性;对偶性derivation求导;得到;起源denote预⽰,表⽰,是…的标志;意味着,[逻]指称divergence 散度;发散性dimension尺度,规格;维数dot⼩圆点distortion变形density概率密度函数discrete离散的discriminative有识别能⼒的diagonal对⾓dispersion分散,散开determinant决定因素disjoint不相交的Eencounter遇到ellipses椭圆equality等式extra额外的empirical经验;观察ennmerate例举,计数exceed超过,越出expectation期望efficient⽣效的endow赋予explicitly清楚的exponential family指数家族equivalently等价的Ffeasible可⾏的forary初次尝试finite有限的,限定的forgo摒弃,放弃fliter过滤frequentist最常发⽣的forward search前向式搜索formalize使定形Ggeneralized归纳的generalization概括,归纳;普遍化;判断(根据不⾜)guarantee保证;抵押品generate形成,产⽣geometric margins⼏何边界gap裂⼝generative⽣产的;有⽣产⼒的Hheuristic启发式的;启发法;启发程序hone怀恋;磨hyperplane超平⾯Linitial最初的implement执⾏intuitive凭直觉获知的incremental增加的intercept截距intuitious直觉instantiation例⼦indicator指⽰物,指⽰器interative重复的,迭代的integral积分identical相等的;完全相同的indicate表⽰,指出invariance不变性,恒定性impose把…强加于intermediate中间的interpretation解释,翻译Jjoint distribution联合概率Llieu替代logarithmic对数的,⽤对数表⽰的latent潜在的Leave-one-out cross validation留⼀法交叉验证Mmagnitude巨⼤mapping绘图,制图;映射matrix矩阵mutual相互的,共同的monotonically单调的minor较⼩的,次要的multinomial多项的multi-class classification⼆分类问题Nnasty讨厌的notation标志,注释naïve朴素的Oobtain得到oscillate摆动optimization problem最优化问题objective function⽬标函数optimal最理想的orthogonal(⽮量,矩阵等)正交的orientation⽅向ordinary普通的occasionally偶然的Ppartial derivative偏导数property性质proportional成⽐例的primal原始的,最初的permit允许pseudocode伪代码permissible可允许的polynomial多项式preliminary预备precision精度perturbation 不安,扰乱poist假定,设想positive semi-definite半正定的parentheses圆括号posterior probability后验概率plementarity补充pictorially图像的parameterize确定…的参数poisson distribution柏松分布pertinent相关的Qquadratic⼆次的quantity量,数量;分量query疑问的Rregularization使系统化;调整reoptimize重新优化restrict限制;限定;约束reminiscent回忆往事的;提醒的;使⼈联想…的(of)remark注意random variable随机变量respect考虑respectively各⾃的;分别的redundant过多的;冗余的Ssusceptible敏感的stochastic可能的;随机的symmetric对称的sophisticated复杂的spurious假的;伪造的subtract减去;减法器simultaneously同时发⽣地;同步地suffice满⾜scarce稀有的,难得的split分解,分离subset⼦集statistic统计量successive iteratious连续的迭代scale标度sort of有⼏分的squares平⽅Ttrajectory轨迹temporarily暂时的terminology专⽤名词tolerance容忍;公差thumb翻阅threshold阈,临界theorem定理tangent正弦Uunit-length vector单位向量Vvalid有效的,正确的variance⽅差variable变量;变元vocabulary词汇valued经估价的;宝贵的Wwrapper包装分类:。

基于人脸图像的二阶段性别分类算法杨晨旭,蔡克参+,张红云,苗夺谦同济大学计算机科学与技术系,上海201804+通信作者E-mail:*******************.cn摘要:许多现实场景要求准确的脸部性别识别。

深度卷积神经网络在正常状况下取得好的准确率,适用于大规模分类任务,但存在模型可解释性差、易丢失细节信息等问题,并且光照、姿势、表情等因素带来的不确定性会导致分类准确率较低。

提出一种基于阴影集的二级分类模型。

采用深度卷积神经网络对大规模图像集进行一阶段分类;结合阴影集理论,将图像分类结果划分为接收域、拒绝域和不确定域,得到不确定的脸部图像集,用传统方法进行二阶段分类。

在LFW 数据集和Adience 数据集下,与现有先进算法相比,所提方法能有效地提高总体分类的准确率。

关键词:性别识别;卷积神经网络(CNN );阴影集;不确定域文献标志码:A中图分类号:TP391Facial Image Based Two-Level Model for Gender ClassificationYANG Chenxu,CAI Kecan +,ZHANG Hongyun,MIAO DuoqianDepartment of Computer Science and Technology,Tongji University,Shanghai 201804,ChinaAbstract:Many scenes need facial gender identification with good accuracy.Deep convolutional neural networks (CNN)with large set of training data normally give good accuracy,however,to achieve good accuracy with uncertain training data is a difficult task due to their lower explanation and potential information loss.Moreover,the uncertain-ties resulted from illumination,postures and facial expressions can lead to low accuracy of the classification.In this paper,a shadowed sets based two-level model for gender classification is proposed to address the problem.Deep convolutional neural networks are used as one-level bining the concept of shadowed sets,one-level classification results are divided into three parts:accept domain,reject domain and uncertain domain.Samples in the uncertain domain are selected as uncertain facial images for two-level reclassification.Results show that the proposed method can further improve the accuracy compared with several existing state-of-the-art methods on the LFW dataset and Adience dataset.Key words:gender identification;convolutional neural networks (CNN);shadowed sets;uncertain domain计算机科学与探索1673-9418/2021/15(03)-0524-09doi:10.3778/j.issn.1673-9418.2006071基金项目:国家自然科学基金(61573255,61976158,61673301);国家重点研发计划(213)。

acc(binary)评估指标1.准确率是衡量分类器性能的重要指标。

Accuracy is an important metric for evaluating the performance of a classifier.2.当模型对数据进行预测时,准确率可以告诉我们有多少预测是正确的。

When the model makes predictions on the data, accuracy can tell us how many of the predictions are correct.3.在二进制分类中,准确率可以通过计算正确分类的样本数与总样本数的比例来计算。

In binary classification, accuracy can be calculated by comparing the number of correctly classified samples to the total number of samples.4.然而,准确率并不是完美的指标,因为它无法告诉我们模型在不同类别上的表现。

However, accuracy is not a perfect metric as it does not tell us about the performance of the model on different classes.5.在某些情况下,数据可能存在不平衡,这时准确率可能会误导我们对模型性能的判断。

In some cases, the data may be imbalanced, and accuracy may mislead us about the performance of the model.6.为了更全面地评估模型,我们需要考虑其他指标,如精确率和召回率。

To assess the model more comprehensively, we need to consider other metrics such as precision and recall.7.精确率告诉我们在模型预测为正类的样本中,有多少是真正的正类。

浅谈keras中⾃定义⼆分类任务评价指标metrics的⽅法以及代码对于⼆分类任务,keras现有的评价指标只有binary_accuracy,即⼆分类准确率,但是评估模型的性能有时需要⼀些其他的评价指标,例如精确率,召回率,F1-score等等,因此需要使⽤keras提供的⾃定义评价函数功能构建出针对⼆分类任务的各类评价指标。

keras提供的⾃定义评价函数功能需要以如下两个张量作为输⼊,并返回⼀个张量作为输出。

y_true:数据集真实值组成的⼀阶张量。

y_pred:数据集输出值组成的⼀阶张量。

tf.round()可对张量四舍五⼊,因此tf.round(y_pred)即是预测值张量。

1-tf.round(y_pred)即是预测值张量取反。

1-y_true即是真实值张量取反。

tf.reduce_sum()可对张量求和。

由此可以根据定义构建出四个基础指标TP、TN、FP、FN,然后进⼀步构建出进阶指标precision、recall、F1score,最后在编译阶段引⽤上述⾃定义评价指标即可。

keras中⾃定义⼆分类任务常⽤评价指标及其引⽤的代码如下import tensorflow as tf#精确率评价指标def metric_precision(y_true,y_pred):TP=tf.reduce_sum(y_true*tf.round(y_pred))TN=tf.reduce_sum((1-y_true)*(1-tf.round(y_pred)))FP=tf.reduce_sum((1-y_true)*tf.round(y_pred))FN=tf.reduce_sum(y_true*(1-tf.round(y_pred)))precision=TP/(TP+FP)return precision#召回率评价指标def metric_recall(y_true,y_pred):TP=tf.reduce_sum(y_true*tf.round(y_pred))TN=tf.reduce_sum((1-y_true)*(1-tf.round(y_pred)))FP=tf.reduce_sum((1-y_true)*tf.round(y_pred))FN=tf.reduce_sum(y_true*(1-tf.round(y_pred)))recall=TP/(TP+FN)return recall#F1-score评价指标def metric_F1score(y_true,y_pred):TP=tf.reduce_sum(y_true*tf.round(y_pred))TN=tf.reduce_sum((1-y_true)*(1-tf.round(y_pred)))FP=tf.reduce_sum((1-y_true)*tf.round(y_pred))FN=tf.reduce_sum(y_true*(1-tf.round(y_pred)))precision=TP/(TP+FP)recall=TP/(TP+FN)F1score=2*precision*recall/(precision+recall)return F1score#编译阶段引⽤⾃定义评价指标⽰例pile(optimizer='adam',loss='binary_crossentropy',metrics=['accuracy',metric_precision,metric_recall,metric_F1score])补充知识:keras sklearn下两分类/多分类的技术杂谈(交叉验证和评价指标)⼀.前⾔这篇博客是为了记录论⽂补充实验中所遇到的问题,以及解决⽅法,主要以程序的形式呈现。

机器学习sklearn(⼆⼗五):模型评估(五)量化预测的质量(⼆)分类指标分类指标模块实现了⼏个 loss, score, 和 utility 函数来衡量 classification (分类)性能。

某些 metrics (指标)可能需要 positive class (正类),confidence values(置信度值)或binary decisions values (⼆进制决策值)的概率估计。

⼤多数的实现允许每个样本通过sample_weight参数为 overall score (总分)提供 weighted contribution (加权贡献)。

其中⼀些仅限于⼆分类⽰例:调⽤功能(y_true, probas_pred)Compute precision-recall pairs for different probability thresholds(y_true, y_score[, pos_label, …])Compute Receiver operating characteristic (ROC)其他也可以在多分类⽰例中运⾏:调⽤功能(y1, y2[, labels, weights, …])Cohen’s kappa: a statistic that measures inter-annotator agreement.(y_true, y_pred[, labels, …])Compute confusion matrix to evaluate the accuracy of a classification(y_true, pred_decision[, labels, …])Average hinge loss (non-regularized)(y_true, y_pred[, …])Compute the Matthews correlation coefficient (MCC)有些还可以在 multilabel case (多重⽰例)中⼯作:调⽤功能(y_true, y_pred[, normalize, …])Accuracy classification score.(y_true, y_pred[, …])Build a text report showing the main classification metrics(y_true, y_pred[, labels, …])Compute the F1 score, also known as balanced F-score or F-measure(y_true, y_pred, beta[, labels, …])Compute the F-beta score(y_true, y_pred[, labels, …])Compute the average Hamming loss.(y_true, y_pred[, …])Jaccard similarity coefficient score(y_true, y_pred[, eps, normalize, …])Log loss, aka logistic loss or cross-entropy loss.(y_true, y_pred)Compute precision, recall, F-measure and support for each class(y_true, y_pred[, labels, …])Compute the precision(y_true, y_pred[, labels, …])Compute the recall(y_true, y_pred[, normalize, …])Zero-one classification loss.⼀些通常⽤于 ranking:调⽤功能(y_true, y_score[, k])Discounted cumulative gain (DCG) at rank K.(y_true, y_score[, k])Normalized discounted cumulative gain (NDCG) at rank K.有些⼯作与 binary 和 multilabel (但不是多类)的问题:调⽤功能(y_true, y_score[, …])Compute average precision (AP) from prediction scores(y_true, y_score[, average, …])Compute Area Under the Curve (AUC) from prediction scores在以下⼩节中,我们将介绍每个这些功能,前⾯是⼀些关于通⽤ API 和 metric 定义的注释。

回归分类逻辑回归2线性回归1支持向量机3朴素贝叶斯4案例演示5目 录CONTENTS1chapter 线性回归1chapter 1chapter单击此处编辑母版标题样式线性回归-定义与问题引入线性回归(Linear regression )是线性回归是利用数理统计中回归分析,来确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法。

其表达形式为y = w'x+e ,e 为误差服从均值为0的正态分布。

只有一个自变量的情况称为简单回归,大于一个自变量情况的叫做多元回归。

举例:房价预测-给出房价和房子面积,训练出模型,将来基于面积预测房子售价。

学习算法模型新面积新房价训练集单击此处编辑母版标题样式线性回归-模型定义假设给定具有n个属性的属性向量的数据 ,我们利用属性的线性组合来进行预测,即我们可以将其写成向量形式其中 ,w和b就是该模型中我们要求的参数,确定w和b,该模型就得以确定。

我们将这样的模型称为线性模型。

我们的目标是,求得适当的w和b,使得S最小,其中S是预测值和真值的差距平方和,亦称为代价函数:一般情况下,我们有两种方法来求解这个模型:最小二乘法和梯度下降法最小二乘法使用参数估计,将S看做一个关于w和b的函数,分别对w和b求偏导数,使得偏导数为0,由微积分知识知道,在此次可以取得S的最小值。

由这两个方程即可求得w和b的值。

梯度下降法的相当于我们下山的过程,每次我们要走一步下山,寻找最低的地方,那么最可靠的方法便是环顾四周,寻找能一步到达的最低点,持续该过程,最后得到的便是最低点。

对于函数而言,便是求得该函数对所有参数(变量)的偏导,每次更新这些参数,直到到达最低点为止,注意这些参数必须在每一轮一起更新,而不是一个一个更新。

局部最优其中α是学习速率,可以控制收敛的速度,需要选择合适大小的,否者导致结果不收敛(α过大)或收敛过慢(α过小)学习率α的影响a为学习率,学习率决定了学习的速度:- 如果a过小,那么学习的时间就会很长,导致算法的低效,不如直接使用最小二乘法。

2020mathematics subject classification -回复2020数学科学分类(2020 Mathematics Subject Classification)是一个根据数学学科的不同领域进行分类的系统。

该分类系统由国际数学联合会(International Mathematical Union,简称IMU)于2020年发布。

它旨在对数学的研究和教学活动进行统一和系统的分类,并帮助学者和教育工作者更好地了解和定位自己的研究领域。

一、2020数学科学分类的目的2020数学科学分类的目的是为了促进数学研究的交流和合作。

通过将不同学科领域进行分类,可以更好地组织和管理数学知识,便于学者之间的沟通和研究合作。

此外,分类还有助于学生和教育工作者了解数学的各个分支和应用,从而更好地选择学习和教学内容。

二、2020数学科学分类的结构2020数学科学分类共分为两层,第一层是大类(Primary),第二层是子类(Secondary)。

大类主要根据数学学科的一级分类分类,而子类则进一步细分不同的领域。

在大类中,数学被分为10个大类别,分别是:1. 逻辑学和基础数学逻辑2. 代数学3. 分析学4. 几何学5. 拓扑学6. 数论7. 统计学8. 运筹学、优化和控制论9. 概率论和数理统计10. 数学物理每个大类别下又细分为几个子类别,以更加具体的领域进行分类。

例如,代数学大类别下有33个子类别,包括群论、环论、域论等;分析学大类别下有23个子类别,包括实分析、复分析、泛函分析等。

三、使用2020数学科学分类的方法对于学者和研究者来说,研究成果的发布和交流是非常重要的。

使用2020数学科学分类可以帮助他们将自己的研究内容准确地归入到相应的领域中,从而吸引到对该领域感兴趣的人士。

此外,在学术会议和期刊投稿时,也可以根据分类系统的标准选择合适的会议或期刊。

对于教育工作者和学生来说,了解数学的不同领域和应用对于选择学习和教学内容非常重要。

二分类fang 激活函数

在二分类问题中,激活函数是非常重要的一环。

激活函数可以将输入的信号转换为输出,从而实现神经网络的非线性映射。

常见的二分类问题中常用的激活函数有sigmoid、relu和tanh等。

sigmoid函数是最常见的二分类激活函数之一。

它的图像呈现出一个类似于'S'型的曲线,它的取值范围在0到1之间。

sigmoid函数对于处理二分类问题具有很好的效果,可以将输出的值映射到0或1,从而实现二分类。

relu函数是另一种常用的二分类激活函数。

它的图像是一个斜坡型,取值范围在0到正无穷。

relu函数在处理深度神经网络时具有很好的效果,因为它可以减少梯度消失问题,并加速网络的训练速度。

tanh函数也是一种常用的二分类激活函数。

它的图像呈现出一个类似于sigmoid函数的形态,但它的取值范围在-1到1之间。

tanh 函数在处理二分类问题时具有很好的效果,因为它可以将输出的值映射到-1或1,从而实现二分类。

综上所述,不同的二分类激活函数适用于不同的场景,我们需要根据具体的问题来选择合适的激活函数。

- 1 -。

二分类数据的分类结果可视化算法第4l卷第3期2006年6月西南交通大学JOURNALOFSOUTHWESTJIAOTONGUNIVERSITYV01.41No.3Jun.2006文章编号:0258-2724(2006)03-0329-06二分类数据的分类结果可视化算法王晓红,王晓茹,李群湛(西南交通大学电气3-程学院,四川成都61~31)摘要:针对在某些应用领域对二分类数据分类结果可视化的需求,以及现有无监督可视化算法无法提供分类结果的相关信息的问题,提出了二分类数据分类结果可视化算法——支持向量可视化(sw).该算法是在无监督的自组织神经网络(SOM)的可视化功能的基础上,结合监督学习的支持向量机(SVM)的二分类算法,得到能够直观地显示高维数据,二分类数据分类边界以及数据与分类边界距离的二维映射图,提高了分类结果的可解释性.以SOM可视化算法以及Sammon算法为参照,用2组可分性不同的样本集进行仿真分析,验证了该算法的有效性和可行性.关键词:支持向量机;自组织神经网络;可视化;算法;支持向量可视化;二分类数据中图分类号:11P274文献标识码:AAlgorithmforVisualizationofClassificationResultsofTwo?CategoryDataW ANGXiaohong,WANGXmom,LIQunzhan(Sch00lofElectricalEng.,SouthwestJiaotongUniversity,Chengdu61~31,China) Abstract:Anewalgorithmcalledsupportvectorvisualization(SVV)waspmposedforvisuali zationofclassificationresultsoftwo-categorydatatomeettheneedinsomeapplications.TheSWalgor ithmisbasedonsupportvectormachine(SVM)andself-organizingmapping(SOM).TheresultofS VVisa2Dmaptovisualizehigh-dimensionaldata,theboundaryofthetwo-categorydata,aswellasth eparedwithSOMandSammonmappingalgo rithms, experimentalresultsontwodatasetswithdifferentseparabilityverifythefeasibilityandeffec tivenessoftheSVV algorithm.Keywords:SVM;SOM;visualization;algorithm;SVV;two-categorydata随着计算机等技术的快速发展,出现了大量隐含有用信息的高维数据.为了从这些高维数据中获得有用的信息,分类是最有效的数据挖掘方法之一.但绝大多数分类方法对于用户来讲相当于只提供类别信息的黑匣子,分类结果可解释性,可理解性较差,难以满足某些应用领域的要求.例如在故障识别等应用领域往往需要知道更多有关分类结果的信息,如样本与分类面之间的距离.这是因为在分类面附近的样本最容易出现误分类,识别这些样本并对其进行适当的分析处理,可减少因误分类引起的损失.如果能够实现在低维空间可视化高维数据以及分类边界的相关信息,就可满足上述的要求,使分类结果的透明度大大增加.目前普遍采用的可视化技术是降维的思路,如PCA(principalcomponentanalysis)方法…,MDS(multidimensionalsealing)方法和SOM(self-organizingmapping)方法J.其中,MDS方法又包括Sammon收稿日期:2005-09.15基金项目:国家重点基础研究发展规划项目(G1998020312)作者简介:王晓红(1977一).女.讲师.博士研究生,研究方向为电力系统保护以及变电站综合自动化技术,E-mall:xhwang@nec.州tu.;王晓茹(1962一).女.教授,博士生导师.研究方向是电力系统保护和安全稳定控制,变电站自动化技术,E-mail:xrw∞********~.ca33O西南交通大学第41卷算法[41,CCA(curvilinearcomponentanalysis)方法LsI,Isomap方法.以及RPM(relationalperspectivemap)方法等.这些可视化方法都是无监督的,即学习时不考虑分类信息,因此不同类别的数据在低维可视化空间中很容易重叠,不利于对不同类别数据的观察.而且,它们均在低维空间上表示高维输人数据,不能提供分类边界信息.关于高维数据分类结果的可视化方法,根据笔者的了解,目前在国内外鲜有报道.本文中提出了用于显示二分类数据分类结果的可视化算法:支持向量可视化(supportvectorvisualization,SVV).该算法是以S0M可视化功能为基础,结合监督学习的支持向量机SVM(supportvectormachine)二分类算法,最终实现在二维的S0M输出特征映射图上显示二分类数据的分类边界及高维数据距离分类边界的距离程度,从而提高了二分类结果的可解释性和可理解性.在实验仿真中,通过在两组可分性质量不同的样本集上与传统S0M可视化算法以及Sammon算法的仿真结果的比较可见,数据集的可分性越差,越能体现该算法的优越性,从而验证了该算法有效性和可行性.1SW算法的提出1.1SVV的基本思路S0M用具有m个结点的低维格状网络表征高维的输人数据.这种网格通常是二维矩形或六边形,每个网络结点都是输出神经元.在本文中采用二维矩形输出网络,称为S0M的输出二维特征映射图.该输出二维特征映射图保持了输人数据的拓扑结构,即在输入空间上邻近的两个特征向量,在输出空间上两者同样邻近,因此S0M适合用于可视化研究.但正如前面所说S0M方法是无监督学习的算法,不同类别的数据在低维可视化空间中很容易重叠,不能提供分类边界信息,不利于不同类别数据的观察.为了可视化分类边界,提供更多的分类结果有关的信息,必须先得到分类边界,再实现分类边界的可视化.因此,需要采用有监督学习的分类算法.采用SVM分类,一方面由于其具有分类泛化效果好等优势;另一方面,该算法求得的确定最优分类面的决策函数仅由少数的支持向量决定,并且根据该函数可以得到样本在高维特征空间与最优分类面之间的距离信息.SVV算法的基本思路如图1所示.先分别利用S0M算法和SVM二分类算法对训练样本进行学习,再综合两者的学习结果.训练样太SOM算法二维映射图SVM二分类算法卜_.叫最优二分类超平面图1SVV算法的基本思路Fig.1TheideaoftheSVV algorithm给定训练样本集(.,Y),…,(,Y),其中∈R为输人数据向量,Y∈{±1}为类别标号,/7,为样本数目,d为输入样本空间的维数.1.2SOM算法的引入S0M算法是迭代的,迭代次数用k表示.任一输出神经元_『都有一个对应的d维权值向量=(,,…,).在作为训练用的输人数据作用下,具有与输人数据最接近的权值向量的结点按照"胜者为王"的原则,取得胜者的地位.获胜的结点(记为c)就"宣称"表征该输人数据,并且根据输入数据修改各结点的权值向量.获胜结点为c=argm!nll一'.,ll,_『∈{1,2,…,m},(1)权值向量'.,,(.]}+1):』()+=]}()[?一()],V_『E,(2)two(k),其它,,其中:Ⅳ是获胜结点c的邻域;(.]})是第.]}次迭代获胜结点c的邻域函数;占(后)是学习速率.在迭代的过平到射超映映上类反维图分面二合综一第3期王晓红等:二分类数据的分类结果可视化算法33l程中,邻域Ⅳ£和学习速率(k)都是随迭代次数的增加不断减小的.SOM算法学习的结果是二维特征映射图和权值矢量矩阵W=(),该二维映射图上的各网络结点为SOM的输出神经元,每个输出神经元均对应1个权值矢量.通过权值矢量做媒介,任一高维输人数据均可按式(1)映射到该SOM的二维输出映射图中的某个结点中.这种情况称为该结点代表的输出神经元被高维输人数据激活,被激活的输出神经元能够表示该高维数据.这样,当将所有输入数据按式(1)映射到SOM二维映射图上时,该二维映射图就反映了高维输入空间中的样本数据的拓扑分布.SOM在训练过程中每次迭代的计算复杂度是0(mn),很明显,适当地增加m可得到较准确的映射图,但计算复杂度也增加了.为解决这一问题,采用SOM的内插处理方法.因SOM 保持了输人数据的拓扑结构,故在相邻的两个权重向量之间进行内插处理以得到更多的数据是可行的.如果内插处理前的网络为l×l,则经过内插处理后变为(21一I)×(21一I),继续内插变为(4Z一3)×(4Z一3),(8Z一7)×(8Z一7)等等.经过内插以后就得到扩展的权值矢量矩阵W=(w,),在SVV算法中用它来代替插值处理前的权值矢量矩阵w.这样,可在保证不增加计算复杂度的同时,得到更准确的二维SOM 映射图.SVM主要分为两类:C—SVM(C—supportvectormachine)和口一SVM(口一supportvectormachine)J.由于.SVM中的参数有明显的物理意义,即定量地指出了支持向量数目占训练样本比例的下界以及训练样本错误分类的上界¨..,更具有实用性.所以,本文中采用一SVM.对于一SVM,最优分类面可表示为如下的约束优化问题:min(b(w)=~-iiwl1一vp+1l∑基),1..t.),[(w.(Xi))+bo]≥.p—,}3)蠡≥0,P≥0,i=1,2,…,n,式(3)中:()是映射函数,将输入样本X从输入样本空间映射到高维的特征空间;w和b.用于确定分类决策函数;是松弛算子;P是另一偏移量;参数定量地指出了支持向量数目占训练样本比例的下界以及训练样本错误分类的上界.为了计算的方便,不直接求解式(3),而将其转化为式(4)所示的对偶问题Q(ct)=一÷∑),iysC,(x)(),厶J=10≤≤,∑otiyi=0,i=1∑Oti≥口,i=1(4)式(4)中Ot是朗格拉日算子.根据Kamsh—Kuhn—Tucker(KKT)IS]条件,ot≠0的样本为影响分类结果的"关键"样本,称为支持向量.为了避免在高维特征空间中进行复杂的内积计算,引入核函数K(X,,)=(X.).(『).求解式(4)便可得到最优的值.由于在由式(3)表示的原问题转化为式(4)表示的对偶问题的过程中,推导出了w和b.关于的关系式,结合这些关系式可得到确定分类最优"超平面"的分类决策函数:,.z)=sgn(w?(z)+bo)=sgn(∑otiyiK(xi'z)+bo),(5)式(5)中:Z为任一输人数据;n为支持向量的数目.根据式(5)可对输人数据进行分类.令样本Z距离分类边界的偏移量为^Py(z)=∑i),iK(xi,Z)+bo,(6)332西南交通大学第41卷则P(z)反映了该数据Z与分类面的距离及该数据的类别信息.P(Z)>0表示其属于第1类,Pr(z)<0表示其属于第2类,P(z)=0表示其在分类最优"超平面"上.当利用SVM分类算法对输人数据进行学习时,便可得到直接体现分类结果的偏移量P的表达式(6).1.4SoM和SVM学习结果的综合如前面所述,通过SOM和SVM对输人数据的学习分别得到反映数据拓扑结构的SOM的二维特征映射图和直接体现分类结果的偏移量P的表达式.因为被某输入高维数据激活的输出神经元的权值矢量能够反映该高维数据,故只要用训练SOM及内插处理后得到扩展权值矢量矩阵w 代替高维输入数据代人该表达式求得偏移量矩阵P=(P('.,',就可以将分类结果反映到SOM的二维输出映射图上,P(W',)=0标示了分类边界.这样,分类结果的可视化便实现了.在测试阶段只要将测试样本按SOM算法的竞争机制(式(1))映射到通过SVV算法得到的反映分类结果的二维映射图中,就可直接观测到其类别以及与分类边界的距离.离边界近的样本发生误分类的可能性较大.对这些样本进行重点分析处理,可以减少因误分类引起的后果.1.5SVV算法的流程步骤1利用口.SVM算法,根据式(4)找到最优的j,i=1,2,…,n以及确定支持向量和b.,从而得到偏移量尸的表达式(6).步骤2利用SOM算法得到保持输入数据拓扑结构的权值矢量矩阵W=('.,),.『=1,2,…,m.步骤3内插处理得到扩展的权值矢量矩阵W=(W),=1,2,…,m.此时,SOM输出神经元数目m为内插后的数目.步骤4将扩展的权值矢量矩阵w'代入式(6),得到权值偏移矩阵P=(P('.,)),其中, n,Py('.,,)=∑Otly'K(x.,'.,,)+6o,=1,2,…,in.(7)i=1步骤5根据权值偏移矩阵P中各元素的值将二维SOM特征映射网络中不同区域,并用不同灰度表示.深色区域的输出神经元对应的P('.,)>0,表示激活这些输出神经元的输人数据的类别为第1类;白色区域的输出神经元对应的P('.,,)<0,表示激活这些输出神经元的输人数据的的类别为第2类.白色区域和深色区域之间的分界对应分类的边界.每个区中颜色随着P(w)的大小变化而有所变化.为了使边界更明显,让P('.,,)越小,颜色越深,即对第1类区来说表示输入数据离边界越近,对于第2类区来说表示输入数据离边界越远.2仿真算例2.1仿真条件用Matlab6.5在P41.7GHz,256MB内存的微机上进行仿真试验.对于".SVM,采用应用广泛的高斯核函数.高斯核宽度对分类性能影响较大,不宜太大,太大导致较少的支持向量,使分类边界过于光滑.失去较多的分类信息;也不宜太小,太小导致的支持向量很多,泛化能力降低.根据其含义可知,"值对分类性能影响也很大这两个参数的取值目前无明确的理论指导,需经过大量仿真试验获得.为了验证SVV算法,用两组可分性质量不同的样本集进行了仿真,并且与SOM算法和常用的可视化算法——Sammon算法比较.对于SOM,迭代次数均取为1000次,学习速率从1.000降到0.001.样本在训练前进行了0?1规范化,即样本规范化后均值为0方差为1.2.2癌症诊断数据集该数据集来自加州埃尔文分校UCImachinelearningrepository(/~mlesm/),有9种属性,699个样本,根据诊断结果分为两类:良性的和恶性的.由于其中16个样本的部分属性丢失,仿真时将它们去掉.这样,所用的样本为683个,所含两类样本分别为444个和239个.该数据集的可分性良好,但数据在高维空间比较密集.试验中取0.91,取0.05,SOM的网络结构大小为20×20,经过内插扩展后为39×39.图2显示了SVV算法的试验结果以及与SOM算法和Sammon算法的比较,图中""代表诊断结果为良性的数据,第3期王晓红等:二分类数据的分类结果可视化算法333(a)SOM算法(b)Sammon算法403020l00l0203040(c)SVV算法图2对癌症诊断数据集的可视化结果比较Fig.2VisualizationoftheWinsconsincancerdataset"△"代表诊断结果为恶性数据.3种算法均可实现高维数据的低维可视化.从提供分类结果可视化方面看,3种算法比较如下:在SOM算法得到的映射图(图2(a))中虽能够清晰地看到两个聚类,但在聚类边界处,大量数据混叠,无法有效地识别分类边界;在Sammon算法得到的映射图(图2(b))中大量的二分类数据混叠,数据比较密集,根本无法提供所需的分类边界及相关的信息,这是因为该算法为无监督学习的算法,并且重在表示所有的高维数据.而在SVV算法得到的映射图(图2(C))中深色区域表示诊断结果为良性的区域,白色区域表示诊断结果为恶性的区域,从该图中可以清楚地看到分类边界,以及样本与边界的距离信息.另外,在图2(a)和图2(C)中均存在一些"△"与",-c"标注混合的数据,这是由于这些数据处于分类边界附近,经SOM映射后形成的.从图2(C)中可以看出这些数据处于边界附近的区域,而从图2(a)中无法得到这一信息.可见在此算例中,SVV算法可视化效果优于SOM算法和Sammon算法,但相对于SOM算法优势不是非常明显.2.3电离层数据该数据集同样来自加州埃尔文分校UCImachinelearningrepository.34维共351个样本,分为两类:"好的"雷达返回信号和"差的"雷达返回信号,所含两类样本分别为225个和126个.该数据集的可分性相对较差,大量数据积聚在分类面附近,分类面较复杂.试验中取0.35,取0.05,SOM网络结构为10X10,经过内插扩展后为19X19.图3显示了SVV算法的试验结果以及与SOM算法和Sammon算法的比较,各图中",-c"代表"好的"雷达返回信号,"△"代表"差的"雷达返回信号.3种算法比较如下:在SOM算法得到的映射图(图3(a))和Sammon算法得到的映射图(图3(b))中均有大量的二分类数据混叠,无法看到的分类边界及相关的其它信息.而在SVV算法得到的映射图(图3(C))中,深色区域表示"好的"雷达返回信号,白色区域表示"差的"雷达返回信号,(a)SOM算法(b)Sammon算法图3对电离层数据的可视化结果比较Fig.3Visualizationoftheionospheredatasetl5l0l520(c)SVV算法334西南交通大学第41卷可以清楚地看到分类边界,以及样本与边界的距离信息.可见SVV算法在此算例中明显优于SOM算法和Sammon算法,Sw算法的优势得以充分体现.3结论本文中提出了基于SVM和SOM的可视化算法sVV.利用该算法可以在低维空间中可视化高维输入空间中的分类边界以及样本与分界面之间的远近程度,因此分类结果更易于理解.借助可视化,在故障识别等应用领域,有利于发现在边界附近的样本数据,从而减少因误分类而引起的损失.通过对两组数据集的仿真实验,将SVV算法和SOM算法,Sammon算法的可视化结果比较可得: (1)SVV算法与SOM算法和Smnmon算法均能可视化高维数据,sw算法可视化高维数据的效果同SOM算法.(2)SVV算法优于SOM算法和Sammon算法之处在于能够可视化高维输入空间中的分类边界以及样本与分界面之间的远近程度.当样本可分性好时,虽然SOM算法和Smnmon算法在可视化高维数据时,可能也能给出一定的类别信息,但不能给出确切的分类边界;当样本集可分性相对差时,由于大量数据的交叠,使SOM算法与Smnmon算法无法提供分类信息,sw算法明显优于这两种算法,此时其优越性得到充分体现.总的来说,SVV算法是针对可视化分类结果提出的,是其与目前各种可视化算法相比的优势所在.参考文献:[1]JACKSONJE.Auser'sguidetoprincipalcomponents[M].NewY ork:JohnWileyandSon s.1991.[2]COXTF,COXMA.Multidimensionalscaling[M].2nded.London:ChapmanHall/CRC Press.2000.[3]KOHONENT,Serf-organizingmaps[M].Berlin:Springer.V erlag,1997:145.152.'[4]SAMMONJw.Anon'nearmappingfordatastructureanalysis[J].IEEETrans.onComput ers,1969(18):401-409.[5]DEMARTINESP,HERAULTJ.Curvihnearcomponentanalysis:aself-organizingneura lnetworkfornonlinearmappingofdatasets[J].IEEETrans.oilNeuralNetworks,1997(8):148.154.[6]TENENBAUMJB,deSILVA V,LANGFORDJc.Asiobalgeometricframeworkfornonli neardimensionalityreduction[J].Science,2ooo(290):23192323.【7]uJx.Visualizationofhigh-dimensionaldatawithrelationalperspectivemap 【J].InformationVisualization,2004(3):49.59.[8]邓乃扬,田英杰.数据挖掘中的新方法——支持向量机[M].北京:科学出版社,2004:186.206.【9]wuST,CHOWTWS.Supportvectorvisualizationandclusteringusingself-organizing mapandsupportvectorone.d鹊sclassification[C]∥Proc.of2003Int.JointConf.onNeuralNetworks.Portland:IEEEPress.2003:803-808. [10]SCHOLKOPFB,SMOLAA.Newsupportvectoralgorithms[J].NeuralComputation,2 000,12:1207.1245.(中文编辑:唐晴英文编辑:刘斌)。

二分类观察结果的四格表-概述说明以及解释1.引言1.1 概述在数据分析领域中,二分类问题是一种常见且重要的任务。

通过对数据集进行分类,我们可以将样本分为两个类别,例如正类和负类。

在观察二分类结果时,我们通常使用四格表来进行分析和总结。

四格表是一个二维表格,将真实类别和预测类别的组合展示在其中,便于直观地观察分类器的性能表现。

在本文中,我们将对二分类观察结果的四格表进行详细介绍,探讨其构成要素和应用场景。

通过对四格表的分析,我们可以有效评估分类器的性能,了解分类结果的准确性和偏差程度。

同时,通过研究四格表的价值和未来发展,可以为数据分析领域的进一步研究和实践提供重要参考。

1.2文章结构1.2 文章结构本文将首先介绍二分类观察结果的四格表的概念和基本作用,帮助读者理解这一分析工具的重要性。

接着将详细讨论四格表的构成要素,包括真正例、假正例、真负例和假负例,以及如何通过这些要素来解读观察结果。

然后,将探讨四格表在各种应用场景下的实际运用,包括医疗诊断、市场营销和社会科学等领域。

最后,结合以上内容,对四格表在数据分析中的重要性和未来发展进行总结和展望,帮助读者更好地理解和应用这一分析工具。

1.3 目的二分类观察结果的四格表是数据分析中常用的工具,其主要目的在于帮助研究人员更清晰地理解和解释二分类数据的观察结果。

通过四格表,我们可以直观地查看分类结果的真阳性、假阳性、真阴性和假阴性情况,从而对模型的性能进行评估和改进。

在实际应用中,四格表可以帮助我们发现数据中存在的问题,比如模型的偏差或方差问题,进而指导我们采取合适的调整措施。

此外,四格表也可以帮助我们比较不同模型或算法的性能表现,从而选择最适合实际场景的方案。

总之,通过探讨二分类观察结果的四格表,我们的目的是深入理解数据分析中的关键概念,并提高数据分析的准确性和可靠性。

希望通过本文的介绍和分析,读者能够更好地运用四格表工具,解决实际问题,并取得更好的研究成果。

多分类及多标签分类算法单标签⼆分类问题单标签⼆分类算法原理单标签⼆分类这种问题是我们最常见的算法问题,主要是指label标签的取值只有两种,并且算法中只有⼀个需要预测的label标签;直⽩来讲就是每个实例的可能类别只有两种(A or B);此时的分类算法其实是在构建⼀个分类线将数据划分为两个类别。

常见的算法:Logistic、SVM、KNN、决策树等。

Logistic算法原理单标签多分类问题单标签多分类问题其实是指待预测的label标签只有⼀个,但是label标签的取值可能有多种情况;直⽩来讲就是每个实例的可能类别有K种(t1 ,t2 ,...t k ,k≥3);常见算法:Softmax、KNN、决策树等;在实际的⼯作中,如果是⼀个多分类的问题,我们可以将这个待求解的问题转换为⼆分类算法的延伸,即将多分类任务拆分为若⼲个⼆分类任务求解,具体的策略如下:One-Versus-One(ovo):⼀对⼀One-Versus-All / One-Versus-the-Rest(ova/ovr):⼀对多Error Correcting Output codes(纠错码机制):多对多ovo原理:将K个类别中的两两类别数据进⾏组合,然后使⽤组合后的数据训练出来⼀个模型,从⽽产⽣K(K-1)/2个分类器,将这些分类器的结果进⾏融合,并将分类器的预测结果使⽤多数投票的⽅式输出最终的预测结果值。

def ovo(datas,estimator):'''datas[:,-1]为⽬标属性'''import numpy as npY = datas[:,-1]X = datas[:,:-1]y_value = np.unique(Y)#计算类别数⽬k = len(y_value)modles = []#将K个类别中的两两类别数据进⾏组合,并对y值进⾏处理for i in range(k-1):c_i = y_value[i]for j in range(i+1,k):c_j = y_value[j]new_datas = []for x,y in zip(X,Y):if y == c_i or y == c_j:new_datas.append(np.hstack((x,np.array([2*float(y==c_i)-1]))))new_datas = np.array(new_datas)algo = estimator()modle = algo.fit(new_datas)modles.append([(c_i,c_j),modle])return modlesdef argmaxcount(seq):'''计算序列中出现次数最多元素''''''超极简单的⽅法'''# from collections import Counter# return Counter(seq).values[0]'''稍微复杂的'''# dict_num = {}# for item in seq:# if item not in dict_num.keys():# dict_num[item] = seq.count(item)# # 排序# import operator# sorted(dict_num.items(), key=operator.itemgetter(1))'''字典推导'''dict_num = dict_num = {i: seq.count(i) for i in set(seq)}def ovo_predict(X,modles):import operatorresult = []for x in X:pre = []for cls,modle in modles:pre.append(cls[0] if modle.predict(x) else cls[1])d = {i: pre.count(i) for i in set(pre)} #利⽤集合的特性去重result.append(sorted(d.items(),key=operator.itemgetter(1))[-1][0])return resultfrom sklearn import datasetsfrom sklearn.multiclass import OneVsOneClassifierfrom sklearn.svm import LinearSVCfrom sklearn.neighbors import KNeighborsClassifier# 加载数据iris = datasets.load_iris()# 获取X和yX, y = iris.data, iris.targetprint("样本数量:%d, 特征数量:%d" % X.shape)# 设置为3,只是为了增加类别,看⼀下ovo和ovr的区别y[-1] = 3# 模型构建clf = OneVsOneClassifier(LinearSVC(random_state=0))# clf = OneVsOneClassifier(KNeighborsClassifier())# 模型训练clf.fit(X, y)# 输出预测结果值print(clf.predict(X))print("效果:{}".format(clf.score(X, y)))# 模型属性输出k = 1for item in clf.estimators_:print("第%d个模型:" % k, end="")print(item)k += 1print(clf.classes_)View Codeovr原理:在⼀对多模型训练中,不是两两类别的组合,⽽是将每⼀个类别作为正例,其它剩余的样例作为反例分别来训练K个模型;然后在预测的时候,如果在这K个模型中,只有⼀个模型输出为正例,那么最终的预测结果就是属于该分类器的这个类别;如果产⽣多个正例,那么则可以选择根据分类器的置信度作为指标,来选择置信度最⼤的分类器作为最终结果,常见置信度:精确度、召回率。

二进制分类c摘要:1.二进制分类简介2.二进制分类的原理与应用3.常见二进制分类算法4.二进制分类在实际场景中的应用5.总结与展望正文:一、二进制分类简介二进制分类(Binary Classification)是一种常见的机器学习任务,其主要目标是对输入数据进行两类别的划分。

在实际应用中,二进制分类问题广泛存在于各个领域,如金融、医疗、网络安全等。

例如,在信贷风险评估中,我们需要判断申请人是否违约;在疾病诊断中,我们需要判断患者是否患有某种疾病;在网络安全中,我们需要判断某封邮件是否为垃圾邮件等。

二、二进制分类的原理与应用二进制分类的原理是基于输入特征与类别标签之间的映射关系。

具体来说,我们通过训练数据集,学习到一个模型,该模型能够根据输入特征预测对应的类别标签。

在实际应用中,二进制分类问题可分为两类:一类是分类问题,即预测一个样本属于某一类别的概率;另一类是回归问题,即预测一个样本的类别标签。

三、常见二进制分类算法1.逻辑回归(Logistic Regression):逻辑回归是一种线性分类算法,通过sigmoid函数将线性函数的输出映射到[0,1]区间,表示样本属于某一类别的概率。

2.支持向量机(Support Vector Machine,SVM):支持向量机是一种基于最大间隔的分类算法,通过核函数将数据映射到高维空间,从而实现两类样本之间的最大间隔。

3.决策树(Decision Tree):决策树是一种基于特征分割的分类算法,通过递归地划分数据集,实现对类别标签的预测。

4.随机森林(Random Forest):随机森林是一种集成学习算法,通过构建多个决策树,结合投票策略实现分类。

5.深度学习(Deep Learning):深度学习是一种基于神经网络的分类算法,通过多层神经元对数据进行特征提取和融合,实现高维空间的分类。

四、二进制分类在实际场景中的应用1.金融领域:信贷风险评估、客户细分、营销策略等。

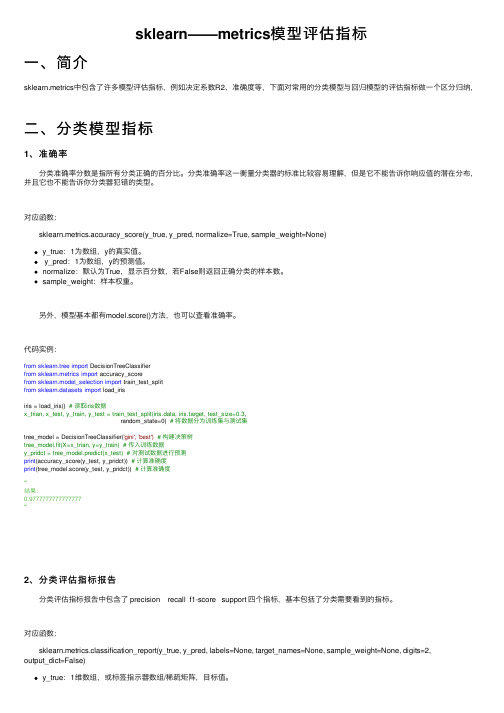

sklearn——metrics模型评估指标⼀、简介sklearn.metrics中包含了许多模型评估指标,例如决定系数R2、准确度等,下⾯对常⽤的分类模型与回归模型的评估指标做⼀个区分归纳,⼆、分类模型指标1、准确率 分类准确率分数是指所有分类正确的百分⽐。

分类准确率这⼀衡量分类器的标准⽐较容易理解,但是它不能告诉你响应值的潜在分布,并且它也不能告诉你分类器犯错的类型。

对应函数: sklearn.metrics.accuracy_score(y_true, y_pred, normalize=True, sample_weight=None)y_true:1为数组,y的真实值。

y_pred:1为数组,y的预测值。

normalize:默认为True,显⽰百分数,若False则返回正确分类的样本数。

sample_weight:样本权重。

另外,模型基本都有model.score()⽅法,也可以查看准确率。

代码实例:from sklearn.tree import DecisionTreeClassifierfrom sklearn.metrics import accuracy_scorefrom sklearn.model_selection import train_test_splitfrom sklearn.datasets import load_irisiris = load_iris() # 读取iris数据x_trian, x_test, y_train, y_test = train_test_split(iris.data, iris.target, test_size=0.3,random_state=0) # 将数据分为训练集与测试集tree_model = DecisionTreeClassifier('gini', 'best') # 构建决策树tree_model.fit(X=x_trian, y=y_train) # 传⼊训练数据y_pridct = tree_model.predict(x_test) # 对测试数据进⾏预测print(accuracy_score(y_test, y_pridct)) # 计算准确度print(tree_model.score(y_test, y_pridct)) # 计算准确度'''结果:0.9777777777777777'''2、分类评估指标报告 分类评估指标报告中包含了 precision recall f1-score support 四个指标,基本包括了分类需要看到的指标。

Project 2 Binary classification

Basic requirements (1)

a)Use linear regression with basis functions, you can choose any basis functions as you

like.

Script “linear_regression.m” uses linear regression with different degrees of polynomial functions as basis. Least square solution without ridge regularization is calculated. We can see from the Fig. 1 that the least square solution is the degrees of polynomial functions equal to 6.

Fig. 1Error rate of linear regression with different degrees of polynomial

Script “linear_regression.m” uses linear regression with 9-degree polynomial functions as basis. Least square solution with ridge regularization is calculated. We can see from the Fig. 2 that the least square solution is when the value of λsubjects to ln 2.5

λ=-.

Fig. 2Error rate linear regression with different value of λ

Script “linear_regression.m” invoking the function “cross_validation.m” uses classification

method on test data for different degrees of polynomial functions as basis. Error rate is plotted in Fig. 3. Test result shows that perform optimizes with a 9-order polynomial when regularization value equals 0.

Fig. 3 Error rate on test data

Basic requirements (2)

Function “logistic_regression.m ” realizes logistic regression with different orders of polynomials as basis.

Model evidence can be calculated as

{}{}

1

ln ()ln (|)ln 2

1

ln ln (,()|)2

1

ln ln (,()|)2ML ML x training set ML x training set p D p D w M N

M N p x c x w M N p x c x w ∈∈=-=-+∏=-+∑

Use different orders of polynomials as basis function. Maximum likelihood solution is

calculated using Newton-Raphson method. Fig. 3 shows the model evidence under Bayesian Information Criterion (BIC) for different orders of polynomials.

Fig. 4 model evidence under BIC

Fig. 3 shows that the model evidence reaches maximum value at order=7.

We should also notice that, hen polynomial order equals 9, 10 or 11, the model evidence

ln ()p D is infinite , thus these three point is missing in this figure.

Then test data is used to verify the model evidence under Bayesian Information Criterion. Error rate can be seen in Fig. 4. This figure shows that the classifier performs best at 7-order and 8-order. And when order equals 9, 10 or 11, error rate get rather high, which is consistent with the result of Fig. 3.

Fig. 5

verify BIC with test data

Plus

1、Implement gradient descent or Newton-Raphson method by yourself, and use it in your experiments.

From line 14 to line 18 in “logistic_regression.m”, Newton -Raphson method is implemented

05

1015

-160

-140-120-100

-80

model evidence under BIC

order

m o d e l e v i d e n c e

0.25

0.30.350.4

0.45verify BIC with test data

order

e r r o r r a t e

by myself to find the optimal w.

2、Use Fisher’s LDA.

This was done in “DLA.m”, error rate with this method is 0.2851.

3、Try to divide the training data into multiple classes (e.g. using k-means), and train a multi-class classifier accordingly, use it on the test data, and convert the multi-class results into binary classes; show the performance.

See “k -means.m”.

Plot the original training data in Fig. 5. Then using k-means method, we can divide the training data into 6 classes, as is shown in Fig. 6.

Comparing the two figures, in order to convert the 6-class classifier to a binary class classifier, we may classify class 1 to 3 in Fig. 6 as true (t=1) and class 4 to 6 as false (t=0).

Using test data to verify the validation, error rate is 0.2619.

Fig. 6

original training data

-2-1.5-1-0.500.511.522.53orignal training data

Fig. 7

k-means classification

-2-1.5-1-0.500.511.522.53k-means classification。