高效稀疏编码算法

1 Introduction

稀疏编码提供了发现对于外来刺激简明表示的一系列算法;给予未标记的输入数据,它学习可以抓住数据高水平特征的基函数。当一个稀疏编码算法英语到自然图像时,学习的基函数就类似于视觉皮层中的神经元感受野;此外,当应用到其他自然刺激例如语音和视频时,稀疏编码产生局部基函数。不同于其他无监督学习技术例如主成分分析,稀疏编码可以应用到学习超完备基函数,其中基函数的维度大于输入数据维度。稀疏编码同样可以通过稀疏化它们的刺激来生成基函数之间抑制模型。同样的性质可以在生物神经元中观察到,这样使得稀疏编码得到视觉皮层的合理模型。

尽管关于稀疏编码模型有良好的前景,我们认为它们的发展很大程度上被昂贵的计算代价所阻碍。特别是学习大维度,超完备代表时就会极度耗费计算资源。在这篇文章中,我们提出了一类基于变量两组子集的交替优化的高效稀疏编码。这类优化问题是凸问题;特别地,对于第一个子集的优化是一范数最小二乘问题;第二个子集则是二范数最小二乘问题。我们描述了每个算法并经验地分析了它们的表现。我们的方法允许我们高效地学习来及自然图像的高维度超完备基函数。我们证明了结果学习基展示了终止情况和对于传统感受野之外刺激的调整。此外,稀疏编码同样提供了对于V1区神经元这些现象的局部解释。在最近的工作中,我们展示了学习高水平特征的简明表示可以应用到监督分类任务。

2 Preliminaries

稀疏的目标就是将输入向量表示为少量的(未知的)“基函数”的加权线性组合。这些基函数可以抓住输入数据中的高水平特征。具体地说,每个输入的向量可以简单地由基函数和稀疏加权向量或系数使得来表示。这些基函数是超完备的(n>k),这样可以抓取输入数据的大量值。

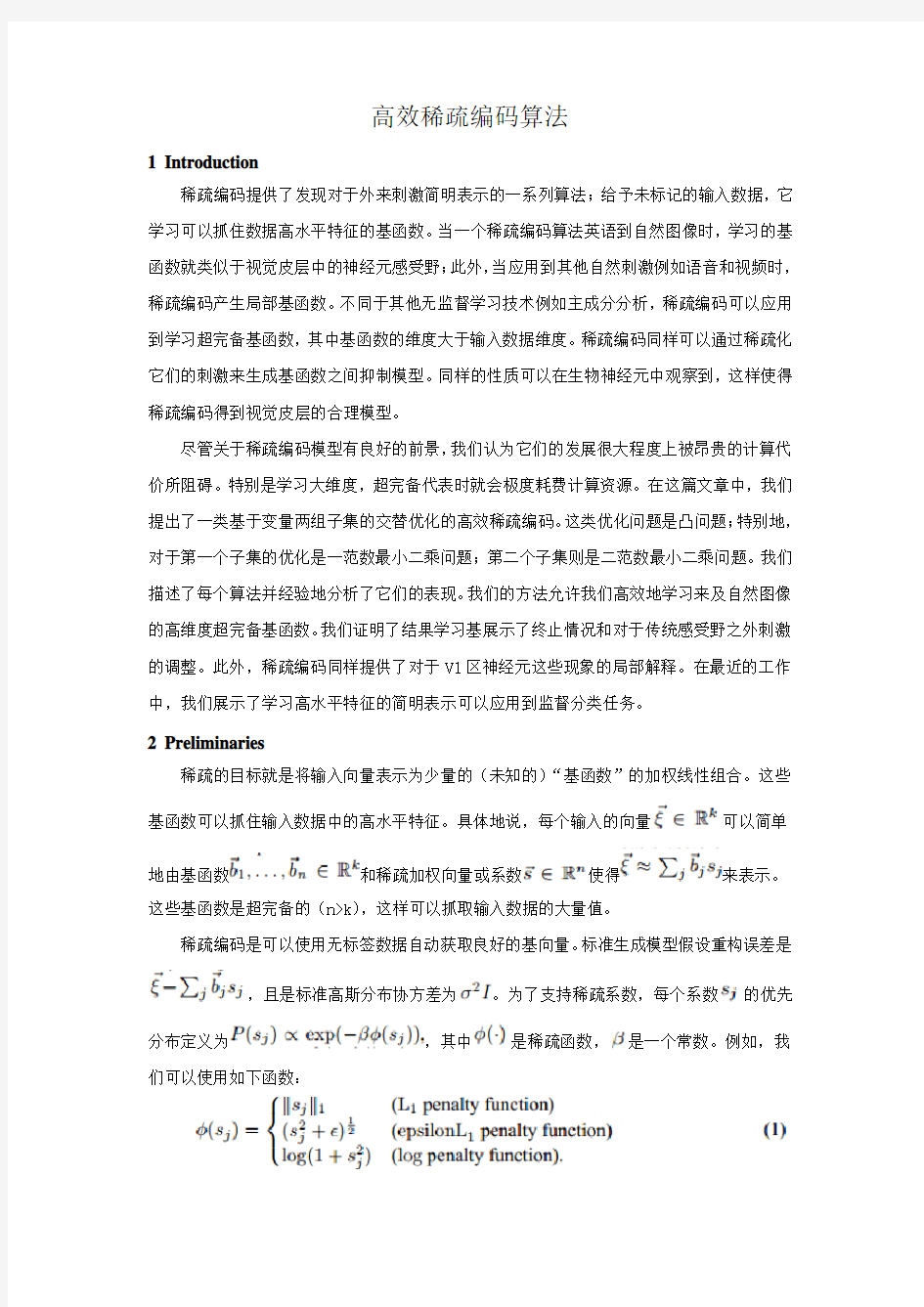

稀疏编码是可以使用无标签数据自动获取良好的基向量。标准生成模型假设重构误差是,且是标准高斯分布协方差为。为了支持稀疏系数,每个系数的优先分布定义为,其中是稀疏函数,是一个常数。例如,我们可以使用如下函数:

在这篇文章中,除非提及我们将会使用一范数罚项;一范数正则化是可以产生稀疏系数并且对于不相关特征是稳健的。

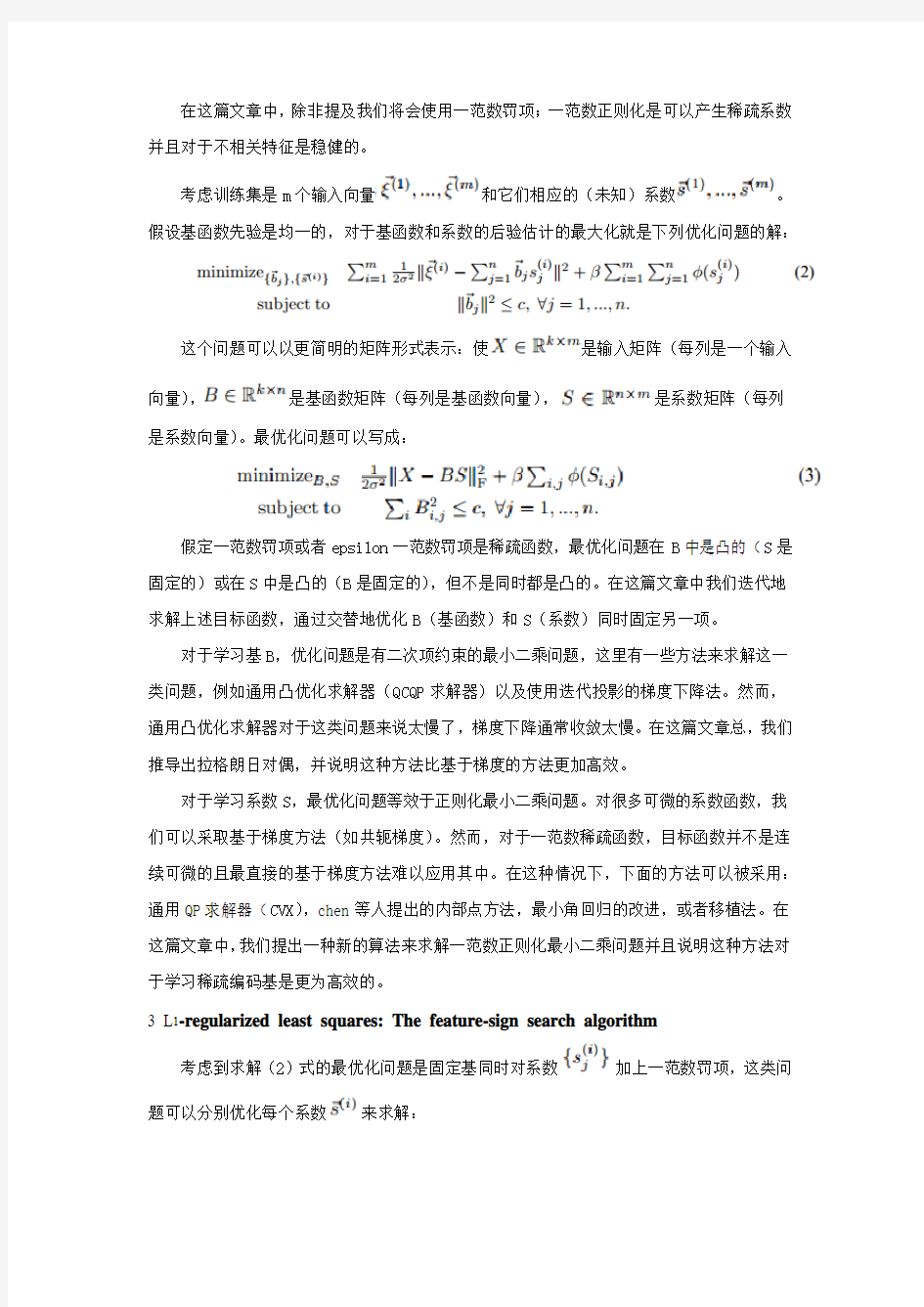

考虑训练集是m个输入向量和它们相应的(未知)系数。假设基函数先验是均一的,对于基函数和系数的后验估计的最大化就是下列优化问题的解:

这个问题可以以更简明的矩阵形式表示:使是输入矩阵(每列是一个输入向量),是基函数矩阵(每列是基函数向量),是系数矩阵(每列是系数向量)。最优化问题可以写成:

假定一范数罚项或者epsilon一范数罚项是稀疏函数,最优化问题在B中是凸的(S是固定的)或在S中是凸的(B是固定的),但不是同时都是凸的。在这篇文章中我们迭代地求解上述目标函数,通过交替地优化B(基函数)和S(系数)同时固定另一项。

对于学习基B,优化问题是有二次项约束的最小二乘问题,这里有一些方法来求解这一类问题,例如通用凸优化求解器(QCQP求解器)以及使用迭代投影的梯度下降法。然而,通用凸优化求解器对于这类问题来说太慢了,梯度下降通常收敛太慢。在这篇文章总,我们推导出拉格朗日对偶,并说明这种方法比基于梯度的方法更加高效。

对于学习系数S,最优化问题等效于正则化最小二乘问题。对很多可微的系数函数,我们可以采取基于梯度方法(如共轭梯度)。然而,对于一范数稀疏函数,目标函数并不是连续可微的且最直接的基于梯度方法难以应用其中。在这种情况下,下面的方法可以被采用:通用QP求解器(CVX),chen等人提出的内部点方法,最小角回归的改进,或者移植法。在这篇文章中,我们提出一种新的算法来求解一范数正则化最小二乘问题并且说明这种方法对于学习稀疏编码基是更为高效的。

3 L1-regularized least squares: The feature-sign search algorithm

考虑到求解(2)式的最优化问题是固定基同时对系数加上一范数罚项,这类问题可以分别优化每个系数来求解:

注意到如果我们知道在最优化值的标志(正,零或负),我们可以将项替换为(如果>0),(如果<0),或者0(如果=0)。仅仅考虑非零系数,式(4)简化为标准无约束的二次最优化问题(QP),这样就可以高效地解析求解。因此,我们的算法尝试去找到,或者说是“猜出”系数的特征;无论是怎么猜测我们都能够高效地求解出无约束QP问题。此外,如果初始值是错误的,算法会系统地改善搜索值。

为了简化符号表示,我们将算法表示为下面等效的最优化问题:

其中是一个常数,特征标志搜索算法仔算法1中所示。它保持了潜在非零系数的活跃子集和相应的标志——其他的系数必须是零值,并且系统地搜索最优的活跃子集和系数标志。算法通过一系列“特征标志步骤”来进行:在每一步,它对活跃子集和其标志进行猜测,并计算无约束QP问题的解析解;接着通过在当前解和之间的高效离散线性搜索,它会不断更新解,活跃子集和标志(详见算法1)。我们将会表现每一步会减小目标函数f(x),最终算法总会收敛到最优解。

算法1 特征标志搜索算法

1 初始化,活跃子集,其中代表标志

2 从零系数x中,选择,

激活x i(将i加入活跃子集)仅当它局部提高目标函数,即:

如果,那么令,活跃子集:=活跃子集。

如果,那么令,活跃子集:=活跃子集。

3 特征标志步骤:

令是A的子矩阵,其仅仅包含相应活跃子集的列。

令和分别是和相对于活跃子集的子向量。

计算无约束QP问题的解析解():

从到的闭合线性部分进行离散线性搜索:

检查目标函数在和其他所有系数标志变化点的值。

更新到有着最小目标函数值的点。

去掉在活跃子集中的零值,并更新

4 检查最优化条件:

(a)对于非零系数的最优化条件:

如果条件(a)不满足,转到步骤3(不做任何激活);否则检查条件(b) (b)对于零系数的最优化条件:

如果条件(b)不满足,转到步骤2;否则返回x为最终解。

为了证明收敛,令系数向量x和所给的活跃子集和标志向量一致如果对所有的i满足下面两个条件:(i)如果i在活跃子集中,那么,(ii)如果i不在活跃子集中,那么。

引理3.1考虑最优化问题(5)增加额外限制:x是同所给的活跃子集和标志向量相一致。那么,如果当前系数是同活跃子集和标志向量相一致,但是对于步骤3的增广问题并不是最优的,特征标志步骤是保证严格减小目标函数。

简略证明。令是相对于所给活跃子集中系数的子向量。仔步骤3中,考虑到平滑的二次项函数。因为不是的最优点,我们有。现在考虑两种可能的情况:(i)如果和所给的活跃子集和标志向量一致,更新会严格地减小目标函数;(ii)如果不是和所给的活跃子集和标志向量一致,令为在到线性部分的第一个零交叉点(其中任何系数改变其标志),那么很明显,而且由于的凸性质,因此我们可以得到

。因此,在步骤3中描述的离散线性搜索保证了目标函数值的减少。

引理3.2考虑最优化问题(5)增加额外限制:x是同所给的活跃子集和标志向量相一致。如果系数在步骤2的初始对于增广问题是最优的,但对问题(5)不是最优的,特征标志步骤保证严格减小目标函数。

简略证明。因为对于增广问题是最优的,它满足最优化条件(a),但是不满足条件(b);

因此,在步骤2中,存在一些i,使得;这些第i个系数被激活,i被加入活跃子集中。在步骤3中,考虑平滑二次函数。观察到:(i)因为在的泰勒展开仅在有一阶项(对其他系数使用条件4(a)),我

们得到任何局部减小的方向必须和活跃的标志相一致,(ii)因为并不是的最优点,必须在附近沿着到的方向减小。从(i)和(ii)得知,从到的线性搜索方向必须和活跃的标志相一致。最终,因为当和活跃子集相一致时,或者相一致的,或者从到的第一零交叉点有最小目标函数值(同引理3.1相似)。

定理 3.3特征标志搜索算法对于最优化问题(5)在有限的步数内收敛到全局最优点

简单证明。从上述的引理中,它遵循着特征标志步骤总是严格地减小目标函数f(x)。在步

骤2的开始,x要不满足最优化条件4(a),要不是零向量;在哪种条件下,x都是同当前

的活跃子集和标志向量相一致,并且对于上述引理描述的增广问题必须是最优的。因为所有可能的活跃子集和系数标志是有限的,而且没有重复的一对(因为目标函数值是严格减少的),步骤2-4(b)的外层循环是不能无期限地重复。这样是正确的是因为步骤3-4(a)总是导致要不退出到步骤4(b),要不减少活跃子集的大小。

注意到从任意起始点开始计算需要一点小的改进:在初始化和活跃子集,得到一个初始解,我们需要进行步骤3而不是步骤1。当初始解在最优解附近,特征标志搜索可以比初始值是更快地得到最优解。

4Learning bases using the Lagrange dual

在这一小节中,我们提出一种在固定系数S情况下求解基于基B的最优化问题(3)。该问题简化为下列问题:

这是有二次约束的最小二乘问题。通常来说,这类约束最小化问题可以通过迭代投影梯度下降方法。然而,使用拉格朗日对偶会更加高效。首先,考虑拉格朗日算符:

其中每个,是对偶变量。对B解析地最小化,我们得到朗格朗日对偶:

其中。的梯度和海塞矩阵分别有下式计算:

其中是第i个单位向量。我们可以通过使用牛顿法或者共轭梯度法来优化拉格朗日对偶(8)。在最大化后,我们得到最优基B如下所示:

求解对偶的优势是它相比较于原始的方法使用了更少的最优化变量。例如,最优化

仅需要100个对偶变量。注意到对偶变化是独立于稀疏函数(例如L1,epsilon L1,或者其他稀疏函数),而且可以延伸到其他相似的模型例如“拓扑”单元。

5Experimental results

5.1The feature-sign search algorithm

我们评估了我们的算法对于四种自然刺激数据集的表现:自然图像,语音,立体图像,和自然图像视频。所有的实验是在Linux机器,配置为AMD Opteron 2GHZ CPU和2GB RAM。

首先,我们评估了特征标志搜索算法对于学习L1稀疏函数系数的表现。我们比较了和之前最先进算法的运行时间和准确性:通用QP求解器,一种有着提前终止的LARS法的改进,移植法,和chen等人的内部点方法;所以的算法都是用MATLAB运行。对于每个数据集,我们使用100个输入向量测试,并测量运行时间和收敛时的目标函数。表1展现了不同系数学习算法的运行时间和准确性(计算最终目标函数的相对误差)。在所有数据集中,特征标志搜索有最好的目标函数值以及最短的运行时间。特征标志搜索和改进的LARS比其他算法的借要更准确。特征标志搜索比Chen等人算法和通用QP求解器用着更小量级的时间,而且比改进LARS和移植法更明显地快。此外,特征标志搜索有着重要的优势就是它可以以任意系数作为初始值(不同于LARS);我们甚至可以证明当应用到迭代系数学习时,特征标志搜索比LARS有着更高的加速。

表1运行时间秒为单位(相对误差在括号内)。对于每个数据集,输入维度k和基的数目n 表示为k×n。算法的相对误差定义为,其中是算法得到的最终目标函数值,是所有算法计算得到的最好的目标函数值。

5.2Total time for learning bases

对于基学习,拉格朗日对偶函数比有着迭代投影的梯度下降更快,由于空间约束,我们通常忽略这些结果。接下来,我们将直接展示来自自然刺激数据集,对于学习基的稀疏编码的总运行时间。

我们评估了系数学习和基学习算法的不同组合效果:来自我们实验的最快的系数学习方法(特征标志搜索,改进LARS和对于L1稀疏函数的移植法,以及对于epsilon L1稀疏函数的共轭梯度)和最先进的基学习方法(有着迭代投影的梯度下降和拉格朗日对偶变化)。我们四种自然刺激数据集的每种取1000个输入向量作为训练集。我们随机初始化基,并运行每个算法组合(通过交替地优化系数和基)直到收敛。

表2展示了不同算法组合的运行时间。首先,我们观察到拉格朗日对偶函数方法比有着迭代投影的梯度下降法对于L1和epsilon L1稀疏函数的表现有显著地提升;一种独特的收敛特征在图1(左)显示。第二,我们观察到,对于L1稀疏函数,特征标志搜索法比改进LARS和移植法表现更好。图1(右)展示了相比较特征标志搜索,改进LARS每次迭代的运行时间是移植法的数倍(对基学习使用同样的梯度下降算法),这证明了显著的效率提升是在迭代的后期;注意到特征标志搜索(和移植法)可以通过前一次迭代初始化系数,然而改进LARS不行。这样的结果证明了特征标志搜索法对于迭代最优化问题是非常有效的,例如学习稀疏编码基。

表2;使用不同稀疏函数的不同算法组合运行时间(以秒为单位)

图1:加速的证明。左:对比拉格朗日对偶函数和梯度下降对于学习基的收敛。右:改进LARS 和移植法相对于特征标志搜索法的每次迭代运行时间。

5.3Learning highly overcomplete natural image bases

使用我们的高效算法,我们能够学习如图2所示的自然图像的超完备基,例如,我们能够在2小时学习1024个基(每个14×14个像素)以及在10小时学习2000个基(每个20×20个像素)。相比较,对于基学习的梯度下降法在运行24小时后并没有产生任何合理的基。更进一步,由对每个基拟合Gabor函数参数得到的学习基的概括数据,定性地符合之前报道的数据。

图2:学习的超完备自然图像基。左:1024个基(每个14×14个像素)右:2000个基(每

个20×20个像素)

5.4 Replicating complex neuroscience phenomena

一些V1区神经反应的复杂现象不能够被简单的线性模型解释(其中响应是线性的输入函数)。例如,很多视觉神经元展示了“突然中止”,这其中神经元响应的最优方向和位置的条状图像是被压制成条状长度超过了最优长度。稀疏编码能够通过稀疏化它们的系数(激活)来模拟基(神经元)之间的交互(抑制),并且我们的算法能够使这些现象在超完备基上测试。

首先,我们评估突然中止行为是否能在稀疏编码框架中观察到。我们随机产生有着不同方向和长度为14×14的图像块的条带,并选取刺激条带能够最强地激活每个基,仅仅考虑那些能够被测试条带激活的基。对于每个活跃基,以及相应的最优条带位置和方向,我们变化条带大小从1像素到最大大小,并运行稀疏编码来测量选择基的系数,这是相对于它们最大的系数。如图3(左)所示,对于超完备基,我们观察到很多情况下系数随着条带超过最优点的增长而显著减少。这一结果和某些V1区神经元的突然中止行为相一致。

第二,通过使用学习超完备基,我们测试位于中心的非传统感受野效应(nCRF)。我们发现了对于50个随机基的最优条带几次,并检查出这些基是其中最活跃的。对于每一个基,我们测量对于最优条带刺激在周围区域有着和没有排列条带刺激的响应(图3(右))。我们接下来比较了两种情况下基响应来测量由于周围刺激带来的压制或者促进作用。周围排列的刺激会产生活跃基的压制;50个基中的42个展示了对周围输入图像的压制,并且13个基表现了超过10%的压制,这同观察到的nCRF周围压制效应定性上一致。

图3:左:对于14×14大小,1024个基的突然中止测试,图中的每条线表示了不同长度的条带的系数。右:对于nCRF效应的输入图像。

6 Application to self-taught learning

稀疏编码是一种无监督算法,它通过少量的基来简单地代表输入数据。例如,在图2使用“图像边缘”基,它代表了一种新的图像块作为少量基的线性组合。非正式来说,我们认为这是一种图像块在图像中以“边缘”形式的代表;这给了一种比像素强度值更高水

平或者更加抽象的图像表示,而且这对很多任务很有用。

在最近的工作中,我们把这些应用到了自主学习中,一种新的机器学习形式,其中我们被给于了监督学习问题,加上额外的无标签实例,这些可能没有像标签实例一样的传统标签。例如,某人可能希望通过给定的图像以及各种自然场景下的无标签图像,来学习区分汽车和摩托机车。(这相比较半监督学习问题更加严格,这些可能仅仅需要汽车和摩托机车的无标签实例)。我们运用我们的稀疏编码算法到无标签数据来学习基,着能够给我们关于图像的高水平表达,因此实现监督学习任务更加容易。在很多各种各样问题包括物体识别,声音分类和文本分类,这种方法能减少11-36%的测试误差。

7 Conclusion

在这篇文章中,我们将稀疏编码表示为两种凸优化问题的组合,并且对每种问题提出来高效算法:特征标志搜索法解决一范数最小二乘问题来学习系数,以及拉格朗日对偶函数方法解决二范数约束最小二乘问题来对于任何稀疏罚函数学习基。我们对于各种数据集来测试这些算法,并表示它们比之前的方法在效果上有了显著地提升。我们的算法可以用来学习超完备基,并展现稀疏编码能够部分地解释V1区神经元的突然中止行为和nCRF周围压制效应。

昆明理工大学信息工程与自动化学院学生实验报告 (201 —201 学年第一学期) 课程名称:算法设计与分析开课实验室:年月日 一、上机目的及内容 1.上机内容 设需要编码的字符集为{d1, d2, …, dn},它们出现的频率为{w1, w2, …, wn},应用哈夫曼树构造最短的不等长编码方案。 2.上机目的 (1)了解前缀编码的概念,理解数据压缩的基本方法; (2)掌握最优子结构性质的证明方法; (3)掌握贪心法的设计思想并能熟练运用。 二、实验原理及基本技术路线图(方框原理图或程序流程图) (1)证明哈夫曼树满足最优子结构性质; (2)设计贪心算法求解哈夫曼编码方案; (3)设计测试数据,写出程序文档。 数据结构与算法: typedef char *HuffmanCode; //动态分配数组,存储哈夫曼编码 typedef struct { unsigned int weight; //用来存放各个结点的权值 unsigned int parent,LChild,RChild; //指向双亲、孩子结点的指针 } HTNode, *HuffmanTree; //动态分配数组,存储哈夫曼树 程序流程图:

三、所用仪器、材料(设备名称、型号、规格等或使用软件) 1台PC及VISUAL C++6.0软件

四、实验方法、步骤(或:程序代码或操作过程) 程序代码: #include

班级 __ __ 学号__姓名 __ ___评分__________ 1.实验名称 LZW编码与解码算法 2.实验目的 2.1通过实验进一步掌握LZW编码的原理; 2.2 用C/C++等高级程序设计语言实现LZW编码。 3.实验内容步骤或记录(包括源程序或流程和说明等) 3.1 实验原理 (1)在压缩过程中动态形成一个字符列表(字典)。 (2)每当压缩扫描图像发现一个词典中没有的字符序列,就把该字符序列存到字典中,并用字典的地址(编码)作为这个字符序列的代码,替换原图像中的字符序列,下次再碰到相同的字符序列,就用字典的地址代替字符序列 3.2实验步骤 LZW编码算法的具体执行步骤如下: 步骤1:开始时的词典包含所有可能的根(Root),而当前前缀P是空的; 步骤2:当前字符(C) :=字符流中的下一个字符; 步骤3:判断缀-符串P+C是否在词典中 (1) 如果“是”:P := P+C // (用C扩展P) ; (2) 如果“否” ①把代表当前前缀P的码字输出到码字流;

②把缀-符串P+C添加到词典; ③令P := C //(现在的P仅包含一个字符C); 步骤4:判断码字流中是否还有码字要译 (1) 如果“是”,就返回到步骤2; (2) 如果“否” ①把代表当前前缀P的码字输出到码字流; ②结束。 3.3 源程序 #include

const int N=200; class LZW{ private: string Dic[200];//存放词典 int code[N];//存放编码过的码字 public: LZW(){//设置词典根 Dic[0]='a'; Dic[1]='b'; Dic[2]='c'; string *p=Dic;//定义指针指向词典中的字符} void Bianma(string cs[N]);//进行编码 int IsDic(string e);//判断是否在词典中 int codeDic(string f); void display(int g);//显示结果 }; void LZW::Bianma(string cs[N]){ string P,C,K; P=cs[0]; int l=0; for(int i=1;i 实验四 哈夫曼编码的贪心算法设计(4学时) [实验目的] 1. 根据算法设计需要,掌握哈夫曼编码的二叉树结构表示方法; 2. 编程实现哈夫曼编译码器; 3. 掌握贪心算法的一般设计方法。 实验目的和要求 (1)了解前缀编码的概念,理解数据压缩的基本方法; (2)掌握最优子结构性质的证明方法; (3)掌握贪心法的设计思想并能熟练运用 (4)证明哈夫曼树满足最优子结构性质; (5)设计贪心算法求解哈夫曼编码方案; (6)设计测试数据,写出程序文档。 实验内容 设需要编码的字符集为{d 1, d 2, …, dn },它们出现的频率为 {w 1, w 2, …, wn },应用哈夫曼树构造最短的不等长编码方案。 核心源代码 #include //选择两个parent为0,且weight最小的结点s1和s2 void Select(HuffmanTree *ht,int n,int *s1,int *s2) { int i,min; for(i=1; i<=n; i++) { if((*ht)[i].parent==0) { min=i; break; } } for(i=1; i<=n; i++) { if((*ht)[i].parent==0) { if((*ht)[i].weight<(*ht)[min].weight) min=i; } } *s1=min; for(i=1; i<=n; i++) LZW编码算法详解 LZW(Lempel-Ziv & Welch)编码又称字串表编码,是Welch将Lemple和Ziv所提出来的无损压缩技术改进后的压缩方法。GIF图像文件采用的是一种改良的LZW 压缩算法,通常称为GIF-LZW压缩算法。下面简要介绍GIF-LZW的编码与解码方程 解:例现有来源于二色系统的图像数据源(假设数据以字符串表示):aabbbaabb,试对其进行LZW编码及解码。 1)根据图像中使用的颜色数初始化一个字串表(如表1),字串表中的每个颜色对应一个索引。在初始字串表的LZW_CLEAR和LZW_EOI分别为字串表初始化标志和编码结束标志。设置字符串变量S1、S2并初始化为空。 2)输出LZW_CLEAR在字串表中的索引3H(见表2第一行)。 3)从图像数据流中第一个字符开始,读取一个字符a,将其赋给字符串变量S2。判断S1+S2=“a”在字符表中,则S1=S1+S2=“a”(见表2第二行)。 4)读取图像数据流中下一个字符a,将其赋给字符串变量S2。判断S1+S2=“aa”不在字符串表中,输出S1=“a”在字串表中的索引0H,并在字串表末尾为 S1+S2="aa"添加索引4H,且S1=S2=“a”(见表2第三行)。 5)读下一个字符b赋给S2。判断S1+S2=“ab”不在字符串表中,输出S1=“a”在字串表中的索引0H,并在字串表末尾为S1+S2=“ab”添加索引5H,且 S1=S2=“b”(见表2第四行)。 6)读下一个字符b赋给S2。S1+S2=“bb”不在字串表中,输出S1=“b”在字串表中的索引1H,并在字串表末尾为S1+S2=“bb”添加索引6H,且S1=S2=“b”(见表2第五行)。 7)读字符b赋给S2。S1+S2=“bb”在字串表中,则S1=S1+S2=“bb”(见表2第六行)。 8)读字符a赋给S2。S1+S2=“bba”不在字串表中,输出S1=“bb”在字串表中的索引6H,并在字串表末尾为S1+S2=“bba”添加索引7H,且S1=S2=“a”(见表2第七行)。 9)读字符a赋给S2。S1+S2=“aa”在字串表中,则S1=S1+S2=“aa”(见表2第八行)。 10)读字符b赋给S2。S1+S2=“aab”不在字串表中,输出S1=“aa”在字串表中的索引4H,并在字串表末尾为S1+S2=“aab”添加索引8H,且S1=S2=“b”(见表2第九行)。 11)读字符b赋给S2。S1+S2=“bb”,在字串表中,则S1=S1+S2=“b”(见表2第十行)。 12)输出S1中的字符串"b"在字串表中的索引1H(见表2第十一行)。 13)输出结束标志LZW_EOI的索引3H,编码完毕。 最后的编码结果为"30016463“。 数据结构课程设计哈夫曼编码-2 《数据结构与算法》课程设计 目录 一、前言 1.摘要 2.《数据结构与算法》课程设计任务书 二、实验目的 三、题目--赫夫曼编码/译码器 1.问题描述 2.基本要求 3.测试要求 4.实现提示 四、需求分析--具体要求 五、概要设计 六、程序说明 七、详细设计 八、实验心得与体会 前言 1.摘要 随着计算机的普遍应用与日益发展,其应用早已不局限于简单的数值运算,而涉及到问题的分析、数据结构框架的设计以及设计最短路线等复杂的非数值处理和操作。算法与数据结构的学习就是为以后利用计算机资源高效地开发非数值处理的计算机程序打下坚实的理论、方法和技术基础。 算法与数据结构旨在分析研究计算机加工的数据对象的特性,以便选择适当的数据结构和存储结构,从而使建立在其上的解决问题的算法达到最优。 数据结构是在整个计算机科学与技术领域上广泛被使用的术语。它用来反映一个数据的内部构成,即一个数据由那些成分数据构成,以什么方式构成,呈什么结构。数据结构有逻辑上的数据结构和物理上的数据结构之分。逻辑上的数据结构反映成分数据之间的逻辑关系,而物理上的数据结构反映成分数据在计算机内部的存储安排。数据结构是数据存在的形式。 《数据结构》主要介绍一些最常用的数据结构,阐明各种数据结构内在的逻辑关系,讨论其在计算机中的存储表示,以及在其上进行各种运算时的实现算法,并对算法的效率进行简单的分析和讨论。数据结构是介于数学、计算机软件和计算机硬件之间的一门计算机专业的核心课程,它是计算机程序设计、数据库、操作系统、编译原理及人工智能等的重要基础,广泛的应用于信息学、系统工程等各种领域。 学习数据结构是为了将实际问题中所涉及的对象在计算机中表示出来并对它们进行处理。通过课程设计可以提高学生的思维能力,促进学生的综合应用能力和专业素质的提高。 实验三树的应用 一.实验题目: 树的应用——哈夫曼编码 二.实验内容: 利用哈夫曼编码进行通信可以大大提高信道的利用率,缩短信息传输的时间,降低传输成本。根据哈夫曼编码的原理,编写一个程序,在用户输入结点权值的基础上求哈夫曼编码。 要求:从键盘输入若干字符及每个字符出现的频率,将字符出现的频率作为结点的权值,建立哈夫曼树,然后对各个字符进行哈夫曼编码,最后打印输出字符及对应的哈夫曼编码。 三、程序源代码: #include 哈夫曼编码步骤: 一、对给定的n个权值{W1,W2,W3,...,Wi,...,Wn}构成n棵二叉树的初始集合F= {T1,T2,T3,...,Ti,...,Tn},其中每棵二叉树Ti中只有一个权值为Wi的根结点,它的左右子树均为空。(为方便在计算机上实现算法,一般还要求以Ti的权值Wi的升序排列。) 二、在F中选取两棵根结点权值最小的树作为新构造的二叉树的左右子树,新二叉树的根结点的权值为其左右子树的根结点的权值之和。 三、从F中删除这两棵树,并把这棵新的二叉树同样以升序排列加入到集合F中。 四、重复二和三两步,直到集合F中只有一棵二叉树为止。 /*------------------------------------------------------------------------- * Name: 哈夫曼编码源代码。 * Date: 2011.04.16 * Author: Jeffrey Hill+Jezze(解码部分) * 在Win-TC 下测试通过 * 实现过程:着先通过HuffmanTree() 函数构造哈夫曼树,然后在主函数main()中 * 自底向上开始(也就是从数组序号为零的结点开始)向上层层判断,若在 * 父结点左侧,则置码为0,若在右侧,则置码为1。最后输出生成的编码。*------------------------------------------------------------------------*/ #include LZW编码算法,尝试使用matlab计算 %encoder LZW for matlab %yu 20170503 clc; clear; close all; %初始字典 dic = cell(512,1); for i = 1:256 dic{i} = {num2str(i)}; end %输入字符串a,按空格拆分成A,注意加1对应围1~256 a = input('input:','s'); a = deblank(a); A = regexp(a,'\s+','split'); L = length(A); for j=1:L A{j} = num2str(str2num(A{j})+1); end A_t = A{1};%可识别序列 B_t = 'test';%待验证词条 d = 256;%字典指针 b = 1;%输出指针 B = cell(L,1);%输出初始 output = ' ';%输出初始 j=1; for j = 2:L m=1; B_t =deblank([A_t,' ',A{j}]);%合成待验证词条 while(m <= d) if strcmp(dic{m},B_t) A_t = B_t; break else m=m+1; end end while(m == d+1) d = d+1; dic{d} = B_t; q=1; for q=1:d if strcmp(dic{q},A_t) B{b} = num2str(q); b = b+1; end end A_t = A{j}; end end for q=1:d%处理最后一个序列输出 if strcmp(dic{q},A_t) B{b} = num2str(q); b = b+1; end end for n = 1:(b-1) B{n} =num2str(str2num(B{n})-1); output=deblank([output,' ',B{n}]); end output 运算结果 计算结果为39 39 126 126 256 258 260 259 257 126 #include if((*ht)[i].weight < (*ht)[min].weight) min = i; } } *s2 = min; } void CrtHuffmanTree(HuffmanTree *ht , int *w, int n) { /* w存放已知的n个权值,构造哈夫曼树ht */ int m,i; int s1,s2; m=2*n-1; *ht=(HuffmanTree)malloc((m+1)*sizeof(HTNode)); /*0号单元未使用*/ for(i=1;i<=n;i++) {/*1-n号放叶子结点,初始化*/ (*ht)[i].weight = w[i]; (*ht)[i].LChild = 0; (*ht)[i].parent = 0; (*ht)[i].RChild = 0; } for(i=n+1;i<=m;i++) { (*ht)[i].weight = 0; (*ht)[i].LChild = 0; (*ht)[i].parent = 0; (*ht)[i].RChild = 0; } /*非叶子结点初始化*/ /* ------------初始化完毕!对应算法步骤1---------*/ for(i=n+1;i<=m;i++) /*创建非叶子结点,建哈夫曼树*/ { /*在(*ht)[1]~(*ht)[i-1]的范围内选择两个parent为0且weight最小的结点,其序号分别赋值给s1、s2返回*/ select(ht,i-1,&s1,&s2); (*ht)[s1].parent=i; (*ht)[s2].parent=i; (*ht)[i].LChild=s1; (*ht)[i].RChild=s2; (*ht)[i].weight=(*ht)[s1].weight+(*ht)[s2].weight; } }/*哈夫曼树建立完毕*/ void outputHuffman(HuffmanTree HT, int m) { if(m!=0) { LZW编码的编程和实现 一、实验目的 编写源程序,实现LZW的编码和解码 二、实验要求 1.编码输入若干字母(如abbababac),输出相应的编码 2.解码输入若干数字(如122473),输出相应的字母 三、编程思想 1.编码 根缀表已知 1 A 2 B 3 C 编码 分析字符串流,从词典中寻找最长匹配串,即字符串P在词典中,而字符串P+后一个字符C不在词典中 此时,输出P对应的码字,将P+C放入词典中。 如第一步: 输入A 此时,A在表中,而AB不在表中,则输出A对应的码字1,同时将AB写入表中,此时表为 1 A 2 B 3 C 4 AB 编码输出为1 (A已编码) 第二步,输入B,B在词典中,而BB不在词典中,则输出2,将BB写入表中,此时表为 1 A 2 B 3 C 4 AB 5 BB 编码输出为12 (AB已经编码) .... 2.解码 根缀表为 1 A 2 B 3 C 定义如下变量 StringP :前一步码字流 pW : StringP的第一个字符 StringC :当前的码字流 cW : StringC的第一个字符 第一步 输出StringC 并StringP = StringC 如: 1解码为A,则StringC = A 那么 输出A,并令St ringP = A --------------------------------------------------------------------------- 第二步 1.解码得到StringC,并输出StringC 2.将StringP + cW放入词典(如果当前码字不在词典中,则将StringP + cP放入词典中) 3.StringP = StringC 如: 第二步要解码为2,解码为B,则StringC=B,输出B (此时St ringP = A) 将StringP+cW放入表中,即将AB放入表中,此时表为 1 A 2 B 3 C 4 AB 四、实验情况及分析 编码解码 错误提示 附:源代码 #include 0023算法笔记——【贪心算法】哈夫曼编码问题 1、问题描述 哈夫曼编码是广泛地用于数据文件压缩的十分有效的编码方法。其压缩率通常在20%~90%之间。哈夫曼编码算法用字符在文件中出现的频率表来建立一个用0,1串表示各字符的最优表示方式。一个包含100,000个字符的文件,各字符出现频率不同,如下表所示。 有多种方式表示文件中的信息,若用0,1码表示字符的方法,即每个字符用唯一的一个0,1串表示。若采用定长编码表示,则需要3位表示一个字符,整个文件编码需要300,000位;若采用变长编码表示,给频率高的字符较短的编码;频率低的字符较长的编码,达到整体编码减少的目的,则整个文件编码需要(45×1+13×3+12×3+16×3+9×4+5×4)×1000=224,000位,由此可见,变长码比定长码方案好,总码长减小约25%。 前缀码:对每一个字符规定一个0,1串作为其代码,并要求任一字符的代码都不是其他字符代码的前缀。这种编码称为前缀码。编码的前缀性质可以使译码方法非常简单;例如001011101可以唯一的分解为0,0,101,1101,因而其译码为aabe。 译码过程需要方便的取出编码的前缀,因此需要表示前缀码的合适的数据结构。为此,可以用二叉树作为前缀码的数据结构:树叶表示给定字符;从树根到树叶的路径当作该字符的前缀码;代码中每一位的0或1分别作为指示某节点到左儿子或右儿子的“路标”。 从上图可以看出,表示最优前缀码的二叉树总是一棵完全二叉树,即树中任意节点都有2个儿子。图a表示定长编码方案不是最优的,其编码的二叉树不是一棵完全二叉树。在一般情况下,若C是编码字符集,表示其最优前缀码的二叉树中恰有|C|个叶子。每个叶子对应于字符集中的一个字符,该二叉树有|C|-1个内部节点。 给定编码字符集C及频率分布f,即C中任一字符c以频率f(c)在数据文件中出现。C的一个前缀码编码方案对应于一棵二叉树T。字符c在树T中的深度记为d T(c)。d T(c)也是字符c的前缀码长。则平均码长定义为: 淮海工学院计算机工程学院实验报告书 课程名:《算法分析与设计》 题目:实验3 贪心算法 哈夫曼编码 班级:软件102班 学号:11003215 姓名:鹿迅 实验3 贪心算法 实验目的和要求 (1)了解前缀编码的概念,理解数据压缩的基本方法; (2)掌握最优子结构性质的证明方法; (3)掌握贪心法的设计思想并能熟练运用 (4)证明哈夫曼树满足最优子结构性质; (5)设计贪心算法求解哈夫曼编码方案; (6)设计测试数据,写出程序文档。 实验内容 设需要编码的字符集为{d 1, d 2, …, dn },它们出现的频率为 {w 1, w 2, …, wn },应用哈夫曼树构造最短的不等长编码方案。 实验环境 Turbo C 或VC++ 实验学时 2学时,必做实验 数据结构与算法 struct huffman { double weight; //用来存放各个结点的权值 int lchild,rchild,parent; //指向双亲、孩子结点的指针 }; 核心源代码 #include int min=11000; int min1; for(int k=0;k 多媒体实验 LZW编码算法 1.实验目的 1)通过实验进一步掌握LZW编码的原理; 2)用C/C++等高级程序设计语言实现LZW编码。 2.实验设备 硬件:装有32M以上内存MPC; 软件:Windows 9X/NT/XP/2000操作系统、 TC 或C++等高级语言环境。3.实验设计原理 LZW编码思想: (1)在压缩过程中动态形成一个字符列表(字典)。 (2)每当压缩扫描图像发现一个词典中没有的字符序列,就把该字符序列存到字典中,并用字典的地址(编码)作为这个字符序列的代码,替换原图像中的字符序列,下次再碰到相同的字符序列,就用字典的地址代替字符序列。 LZW编码算法的具体执行步骤如下: 步骤1:开始时的词典包含所有可能的根(Root),而当前前缀P是空的; 步骤2:当前字符(C):=字符流中的下一个字符; 步骤3:判断缀-符串P+C是否在词典中 (1)如果“是”:P:=P+C//(用C扩展P); (2)如果“否” ①把代表当前前缀P的码字输出到码字流; ②把缀-符串P+C添加到词典; ③令P:=C//(现在的P仅包含一个字符C); 步骤4:判断码字流中是否还有码字要译 (1)如果“是”,就返回到步骤2; (2)如果“否” ①把代表当前前缀P的码字输出到码字流; ②结束。 4.程序框图 5.程序设计代码#include class LZW{ private: string Dic[200]; int code[N]; public: LZW(){ Dic[0]='a'; Dic[1]='b'; Dic[2]='c'; string *p=Dic; } void Bianma(string cs[N]); int IsDic(string e); int codeDic(string f); void display(int g); }; void LZW::Bianma(string cs[N]){ string P,C,K; P=cs[0]; int l=0; for(int i=1;i 哈夫曼编码的JAVA实现课程设计 目录 摘要 (2) 一、问题综述 (2) 二、求解方法介绍 (3) 三、实验步骤及结果分析 (4) 四、程序设计源代码 (5) 参考文献 (8) 摘要 利用哈夫曼编码进行通信可以大大提高信道利用率,缩短信息传输时间,降低传输成本,试用java语言设计一个哈夫曼编码系统。通过本课程设计,应使学生掌握哈夫曼编码的特点、储存方法和基本原理,培养学生利用java语言正确编写程序及调试程序的能力,运用数据结构知识解决实际问题的能力。 关键字:哈夫曼编码JA V A语言类方法 一、问题综述 1 哈夫曼编码的算法思想 哈夫曼编码也称前缀编码,它是根据每个字符出现的频率而进行编码的,要求任一字符的编码都不是其它任意字符编码的前缀且字符编码的总长度为最短。它主要应用于通信及数据的传送以及对信息的压缩处理等方面。哈夫曼编码的基础是依据字符出现的频率值而构造一棵哈夫曼树,从而实现最短的编码表示最常用的数据块或出现频率最高的数据,具体的方法是: 1.1 建立哈夫曼树 把N 个字符出现的频率值作为字符的权值,然后依据下列步骤建立哈夫曼树。 1.1.1 由N 个权值分别作N 棵树的根结点而形成一个森林。 1.1.2 从中选择两棵根值最小的树T1 和T2 组成一棵以结点T 为根结点的增长树,根结点T = T1 + T2 ,即新树的根值为原来两棵树的根值之和,而T1 和T2 分别为增长树的左右子树。 1.1.3 把这棵新树T 加入到森林中,把原来的两棵树T1 和T2 从森林中删除。 1.1.4 重复1.1.2~1.1.3 步,直到合并成一棵树为止。 1.2 生成各字符的哈夫曼编码 在上面形成的哈夫曼树中,各个字符的权值结点都是叶子结点,从叶子结点开始向根搜索,如果是双亲的左分支,则用“0”标记,右分支用“1”标记,从叶子结点到根结点所经过的分支编码“0”、“1”的组合序列就是各字符的哈夫曼编码。 2 构造哈夫曼树的算法 1)对给定的n个权值{W1,W2,W3,...,Wi,...,Wn}构成n棵二叉树的初始集合F={T1,T2,T3,...,Ti,..., Tn},其中每棵二叉树Ti中只有一个权值为Wi的根结点,它的左右子树均为空。 2)在F中选取两棵根结点权值最小的树作为新构造的二叉树的左右子树,新二叉树的根结点的权值为其左右子树的根结点的权值之和。 3)从F中删除这两棵树,并把这棵新的二叉树同样以升序排列加入到集合F 中。 实验八哈夫曼编码的方法和实现 一、实验目的 1.掌握哈夫曼编码的基本理论和算法流程; 2. 用VC++6.0编程实现图像的哈夫曼编码。 二、实验内容 1.画出哈夫曼编码的算法流程; 2.用VC++6.0编程实现哈夫曼编码。 三、实验步骤 (1)启动VC++6.0,打开Dip工程。 (2)在菜单栏→insert→resouce→dialog→new,在对话框模版的非控制区点击鼠标右键,在弹出的对话框中选properties,设置为ID:IDD_DLG_Huffman,C标题:哈夫曼编码表。 (3)在弹出的对话框中,添加如下的按钮等控件: (4)在ResourceView栏中→Menu→选IDR_DIPTYPE ,如图 在图像编码菜单栏下空的一栏中,右键鼠标, 在弹出的对话框中选属性properties,在弹出的对话框中,进行如下的设置 (5)右击哈夫曼编码表菜单栏,在建立的类向导中进行如下设置 (6)在DipDoc.cpp中找到void CDipDoc::OnCodeHuffman()添加如下代码void CDipDoc::OnCodeHuffman() { int imgSize; imgSize = m_pDibObject->GetWidth()*m_pDibObject->GetHeight(); //在点处理CPointPro类中创建用来绘制直方图的数据 CPointPro PointOperation(m_pDibObject ); int *pHistogram = PointOperation.GetHistogram(); //生成一个对话框CHistDlg类的实例 CDlgHuffman HuffmanDlg; 语音增强算法的研究与实现 目录 目 录 ..................................................................... ............................................................ I 河西学院本科生毕业论文(设计)诚信声 明 ................................... 错误~未定义书签。I 河西学院本科生毕业论文(设计)任务 书 ...................................... 错误~未定义书签。II 河西学院本科毕业论文(设计)开题报 告 ..................................... 错误~未定义书签。IV 摘 要 ..................................................................... .................................................................. I Abstract ........................................................... ....................................................................... I 1 引 言 ..................................................................... .. (1) 2 语音增强算法概 述 ..................................................................... (1) 1.哈夫曼编码的方法 编码过程如下: (1) 将信源符号按概率递减顺序排列; (2) 把两个最小的概率加起来, 作为新符号的概率; (3) 重复步骤(1) 、(2), 直到概率和达到1 为止; (4) 在每次合并消息时,将被合并的消息赋以1和0或0和1; (5) 寻找从每个信源符号到概率为1处的路径,记录下路径上的1和0; (6) 对每个符号写出"1"、"0"序列(从码数的根到终节点)。 2.哈夫曼编码的特点 ①哈夫曼方法构造出来的码不是唯一的。 原因 ·在给两个分支赋值时, 可以是左支( 或上支) 为0, 也可以是右支( 或下支) 为0, 造成编码的不唯一。 ·当两个消息的概率相等时, 谁前谁后也是随机的, 构造出来的码字就不是唯一的。 ②哈夫曼编码码字字长参差不齐, 因此硬件实现起来不大方便。 ③哈夫曼编码对不同的信源的编码效率是不同的。 ·当信源概率是2 的负幂时, 哈夫曼码的编码效率达到100%; ·当信源概率相等时, 其编码效率最低。 ·只有在概率分布很不均匀时, 哈夫曼编码才会收到显著的效果, 而在信源分布均匀的情况下, 一般不使用哈夫曼编码。 ④对信源进行哈夫曼编码后, 形成了一个哈夫曼编码表。解码时, 必须参照这一哈夫编码表才能正确译码。 ·在信源的存储与传输过程中必须首先存储或传输这一哈夫曼编码表在实际计算压缩效果时, 必须考虑哈夫曼编码表占有的比特数。在某些应用场合, 信源概率服从于某一分布或存在一定规律 使用缺省的哈夫曼编码表有 解:为了进行哈夫曼编码, 先把这组数据由大到小排列, 再按上方法处理 (1)将信源符号按概率递减顺序排列。 (2)首先将概率最小的两个符号的概率相加,合成一个新的数值。 (3)把合成的数值看成是一个新的组合符号概率,重复上述操作,直到剩下最后两个符号。 5.4.2 Shannon-Famo编码 Shannon-Famo(S-F) 编码方法与Huffman 的编码方法略有区别, 但有时也能编 出最佳码。 1.S-F码主要准则 符合即时码条件; 在码字中,1 和0 是独立的, 而且是( 或差不多是)等概率的。 这样的准则一方面能保证无需用间隔区分码字,同时又保证每一位码字几乎有 1位的信息量。 2.S-F码的编码过程 信源符号按概率递减顺序排列; 把符号集分成两个子集, 每个子集的概率和相等或近似相等; 186 2009年第10期,第42卷 通 信 技 术 Vol.42,No.10,2009 总第214期 Communications Technology No.214,Totally ·信源处理· Speex 语音编码算法实现与优化 穆 捷, 李 敬, 唐 昆 (清华大学 电子工程系,北京 100084) 【摘 要】介绍了Speex 编码原理,对其特有的编码方式进行了深入的分析,针对其编码特点提出了3种降低运算复杂度的优化方法,并在DSP 芯片上进行了实现。通过使用ITU P.862规范中的评分方法进行分析,所述方法能在保证语音质量基本不下降的前提下,显著的降低运算复杂度。 【关键词】Speex ;感觉加重;逆滤波;简单相关 【中图分类号】TN91 【文献标识码】A 【文章编号】1002-0802(2009)10-0186-03 Realization and Optimization of Speex MU Jie , LI Jing , TANG Kun (Department of Electronic Engineering, Tsinghua University, Beijing 10084, China ) 【Abstract 】This paper first tells of the principle of Speex. Then, based on the analysis, three ways for simplifying computation are described. Through analysis by using PESQ in ITU P.862, the three proposed ways could help reduce the complexity of computation while the speech quality is guaranteed. 【Key words 】Speex; perceptual weighting; reverse filter; simple correlation 0 引言 互联网的发展推动着VOIP(V oice Over IP)技术应用的不断扩大,而现有的语音编码算法如G .729,虽然在语音质量上已经取得了很好的效果,但是由于应用环境不同,这些算法并不能很好的适应因特网网络环境多变的特点。Speex 是在VOIP 的应用背景下提出的一种基于CELP(Code Excited Linear Prediction)算法的免费、开源的语音编码器,其编码方式非常灵活,可以依据不同的应用环境采用统一的码流格式和编码算法,实现多码率,多采样率的灵活的语音编码,以适应网络语音通信的需求。 然而,传统的CELP 算法虽然在低码率的条件下依然能够保证良好的语音效果,但是其较高的运算量使得一些基于该算法的编码器难以在一些低功耗的芯片上实现。本文首先简要介绍了Speex 编解码算法,然后针对CELP 算法运算量大的缺点提出了调整感觉加权滤波器、利用简单互相关简化自适应码本搜索和固定码本逆滤波3种降低运算复杂度的优化方法,最后给出了试验结果,经试验验证,本文提出的优 化方法在较好保证语音质量的同时能够有效地降低运算量。 1 Speex 语音编解码算法简介 Speex 基于CELP(Code Excited Linear Prediction)算法,可同时进行窄带和宽带编码,并且具有多种速率。 自适应码本搜索利用互相关算法进行三阶基因预测,得到相应子帧的残差信号。然后将经过自适应码本搜索后的子帧残差信号分为长度不等的从5到20个样点的子矢量,依速率的不同采用各自对应的独立码本进行固定码本搜索。解码就是编码的逆过程,由于解码过程中并没有涉及码本搜索,因此,整个编解码的运算量主要集中在编码上,其中自适应码本和固定码本搜索占据了绝大部分,而宽带模式由于编码方式基本与窄带相同,因此我们的优化测试都基于窄带模式。 2 算法优化 CELP 结构的编码器虽然可以在低码率下仍然保持较高的语音质量,但其主要缺点就是运算量较大。对于Speex 编解码算法,当其工作在高模式下时,由于码本的增加和搜索精度的提高,使得算法复杂度加大,同时也就造成了在一些低功耗的DSP 芯片上较难实现实时的语音通信。为了解决这一问题,我们在CELP 模型运算量集中的码本搜索和基音周 收稿日期:2008-10-23。 作者简介:穆 捷(1979-),男,硕士研究生,从事语音压缩编码方 向研究;李 敬,男,讲师,从事多媒体通信方向研究;唐 昆,男,教授,从事多媒体通信方向研究。 万方数据实验三.哈夫曼编码的贪心算法设计

LZW编码算法详解

数据结构课程设计哈夫曼编码-2

哈夫曼编码算法实现完整版

哈夫曼编码步骤

LZW编码算法matlab实现

哈夫曼树建立、哈夫曼编码算法的实现

LZW编码编程实现(C++版)

0023算法笔记——【贪心算法】哈夫曼编码问题

哈夫曼编码_贪心算法

lzw实验报告

哈夫曼编码的JAVA实现课程设计

数字图像实验 哈夫曼编码的方法和实现1234

语音增强算法的研究与实现

哈夫曼编码的方法

Speex语音编码算法实现与优化