外国人写的一篇关于F5 oneconnect的理解

- 格式:doc

- 大小:36.00 KB

- 文档页数:4

概述 挑战 解决方案概述 当今企业实现支持 Web 应用已取得巨大的成功,它提高了用户的效率、降低了成本、并实现了更大的效率提升。

但是,蜂拥而至的 web 应用已导致产生了许多新的性能问题。

首先,修复这些问题是一件相对简单的事务——对应用进行一下调整、增加硬件,或为企业的骨干网购买额外的带宽。

但是,当用户人数增加,尤其是当公司局域网之外的新的远程用户增加时,新的问题就出现了,这种问题不能用老的办法来解决。

本页将介绍一种全新的为企业内联网、互联网以及外部网络用户提升读取web 页面、应用以及门户最大性能的方法——它就是“F5 WebAccelerator”。

挑战 当越来越多的企业使其应用支持 web 时,服务器问题(通常的瓶颈)以及网络问题(交付瓶颈)开始出现。

最初,人们部署单项解决方案(如代理高速缓存、SSL 优化器、压缩器,以及其它方法)来解决这些问题,但是,这些方案仅仅是尝试保持运行正常的一种权宜之计。

应用的复杂性正在持续增加、部署的周期正在持续延长,而地理范围的广度正日益扩充。

修复某项问题仅会使另一个问题暴露出来。

例如,远程办公室的用户首先会受到可用网络带宽的限制。

然而,一旦带宽升级,网络延迟又成为影响 web 应用性能的主要问题。

影响 Web 应用性能的新瓶颈。

解决方案Web 应用性能问题将不复存在 F5 WebAccelerator 适用于多种专有技术,能够为企业内联网、互联网以及外部网络用户提供性能最优的网页、应用及门户。

单就每个用户来看,页面下载速率可获得极大的提升。

而就 WebAccelerator 而言,这些技术能够加速用户访问 Web 站点(或支持 web 的内部应用)的整体性能,从而购买以及部署各个单项产品将变得更加高效。

WebAccelerator 是一种经过高度优化、可扩展、基于服务器的解决方案,能够分析并智能处理浏览器请求以及服务器响应。

与其它解决方案不同,为了快速处理请求,它既能处理动态应用,也能处理静态内容。

F5 network 链路及服务器负载均衡解决方案2002.11.25链路负载平衡:多归属网络智能流量管理解决方案概览随着企业采用互联网传送关键任务内容和应用,只与公共网络保持一个链路就意味着单点故障和严重的网络隐患。

因此,提供多个网络连接已成为构建可靠和容错的数据中心的关键部分。

F5 的 BIG-IP®链路控制器 (BIG-IP LINK CONTROL 2000) 为希望增加其互联网连接可用性和性能的企业提供了一个解决方案。

BIG-IP 链路控制器提供了一个综合解决方案:-提供可靠的网络连接-管理多个链路上的入站 / 出站流量-通过最佳性能链路发送流量-增加链路可扩充性和吞吐量-实现最大的企业连接投资回报率-消除带有 BGP (边缘网关漫游)的多归属的部署障碍和成本多归属和 ISP 负载平衡的挑战显而易见,高可用性是部署多个互联网链路的主要推动因素之一。

一个平常的互联网中断即可使企业在冗余系统上的所有投资变得毫无用处。

同时,从物理网络组件到互联网服务提供商( ISP )本身,连接的任何地方都有可能发生故障,给企业和其客户带来重大停机事件和财务损失。

互联网连接的成本和可扩充性也是大多数企业的考虑重点。

如果仅有一个连接,企业必需确保他们在一条线路上购买了足够的带宽,以满足他们的吞吐量需求。

在许多情况下,这会导致站点的过度供应(尝试提供过多的保护和可扩充性)。

由于企业的业务依赖于单一 ISP ,企业还必须确信他们选择的服务提供商拥有良好的正常运行记录。

此外,一些企业也考虑采用多站点部署来解决可用性问题。

对于许多中小企业而言,开设第二个数据中心来增强可用性保护受到资金的限制。

许多企业还面临着在多个数据中心上提供 Web 应用和服务主机服务的复杂技术问题。

他们寻求一种更简单、成本更低的方法来提高其站点的可靠性。

多归属和流量管理“多归属”这个技术术语是指通过多个连接与互联网相连的网络。

多归属的重要意义不在于拥有多个链路,而是如何优化管理在这些连接上以及常常是在不同 ISP 之间传输的流量。

F5 LTM优化功能配置介绍F5 FSE 陈亮2007.10.19前言本文主要介绍的是F5 LTM上的基本优化功能,即HTTP压缩,Ramcache,及oneconnect连接优化功能的配置。

关于WA中涉及的高级优化功能,将另外进行介绍.一、HTTP压缩功能介绍HTTP压缩功能可以通过http内容的压缩,减少数据量的传送,并提高用户的访问速度。

当然,并非所有的文件需要压缩。

比如,已经压缩的文件诸如JPEG、GIF、PNG、电影和打包内容等不需要HTTP压缩过滤技术。

对它们再次压缩将无法得到显著减小文件体积的效果。

同时,网站还有大量的文本内容诸如HTML、XML、CSS和RSS等,他们都需要进行压缩。

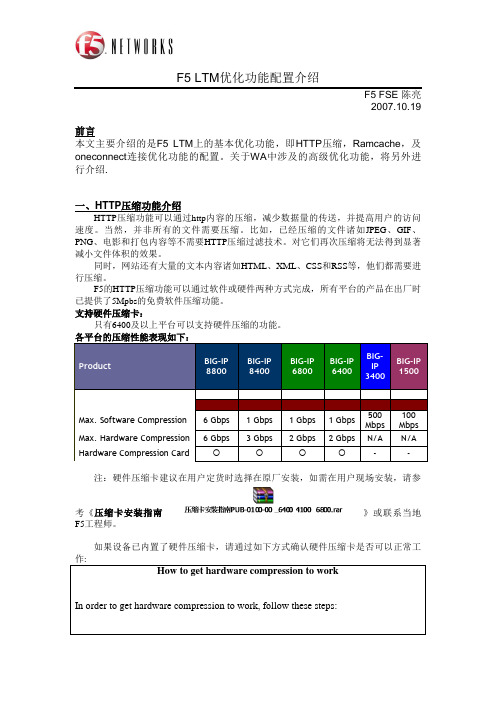

F5的HTTP压缩功能可以通过软件或硬件两种方式完成,所有平台的产品在出厂时已提供了5Mpbs的免费软件压缩功能。

支持硬件压缩卡:只有6400及以上平台可以支持硬件压缩的功能。

各平台的压缩性能表现如下:Product BIG-IP8800BIG-IP8400BIG-IP6800BIG-IP6400BIG-IP3400BIG-IP1500Max. Software Compression 6 Gbps 1 Gbps 1 Gbps 1 Gbps500Mbps100MbpsMax. Hardware Compression 6 Gbps 3 Gbps 2 Gbps 2 Gbps N/A N/A Hardware Compression Card - -注:硬件压缩卡建议在用户定货时选择在原厂安装,如需在用户现场安装,请参考《压缩卡安装指南》或联系当地F5工程师。

如果设备已内置了硬件压缩卡,请通过如下方式确认硬件压缩卡是否可以正常工How to get hardware compression to workIn order to get hardware compression to work, follow these steps:1)Verify that you have the hardware compression card installed and recognisedby the BIG-IP. This can be done in one of a few ways:a.Once the BIG-IP has booted check the “/var/log/ltm” file for an entrylike:aha0: AHA Compression device (rev 2.1) at 1.3b.From the console (not SSH) run the command:bigstart stop; /bin/tmm -a --speed-test=aha-fieldWhen completed look for the similar entry:aha0: AHA Compression device (rev 2.1) at 1.3Compression test: CRC matched ok.c.Run “cat /proc/pci” and look for the PCI device “193f:0001” – this isthe hardware compression card2)From a license point of view you need to make sure you have the licenseoption of “F5-ADD-BIG-HWCMP” (more specifically the flags “software-offload” and “perf_http_compression_hw”, see C206746). If you have these then you can check on the status of the hardware and software compressionsupport with the command “tmctl vcompress_stats”. You should see threecompression devices in a properly-licensed system: soft_sync, soft_offloadand aha_offload. None of the compression DB variables have any effect on a system without the hardware compression license.[root@guangzhoubigip:Active] config # tmctl vcompress_statsname queued_bytes precompress_bytes postcompress_bytes tot_streams------------ ------------ ----------------- ------------------ -----------_overflow 0 0 0 0soft_sync 0 15891910 8959907 1015soft_offload 0 968796177 952189037 1454aha_offload 0 94520923273 93309092599 846095cur_streams-----------203)Under the HTTP profile that is assigned to your VIPs you need to make surethat you select level 1 as the compression level and the GZIP Windows Size as “4k”.HTTP压缩功能配置介绍1. 配置http profile请参考如下配置界面:设置说明缺省值Compression 启用或禁用HTTP压缩特性。

F5基本原理介绍1. 负载均衡的基本单位目前负载均衡设备的基本处理单位是TCP连接,也就是说当一个TCP连接建立后,在该连接中的所有客户端请求和服务器响应信息都通过这一个TCP连接进行。

只有客户端发起新的连接的时候,才会根据负载均衡算法重新计算,才可能分发到其他服务器上。

2. 基本工作模式F5支持全代理模式,同时也可以工作在四层转发模式。

全代理模式就是VS配置成standard类型,此模式下客户端和F5建立一个连接,客户端将请求发送给F5,F5再和服务器建立连接,并将请求发送给服务器,服务器返回信息后,F5再将返的回信息送给客户端。

在此模式下F5可以查看请求和响应的所有信息,可以根据所有信息进行分发和处理。

四层转发模式就是VS配置成Performance L4类型,此模式下F5只做四层转发,也就是F5只处理四层以下的信息,即端口和IP信息,具体业务数据不做任何处理。

客户端发送给F5的数据包,F5只根据需要将IP和端口处理之后就直接发送给服务器,响应信息也类似处理。

在此模式下,F5只能查看四层一下信息,不处理业务信息,好处是处理过程简单、速度快。

缺点是无法对四层以上的协议数据进行精确处理。

3. 负载均衡算法F5支持的负载均衡算法分类两大类:静态算法和动态算法,总共将近20种,这里只分析常用的三种算法:轮询、比率、最小连接数。

3.1 轮询轮询算法就是按照后台服务器轮流分发,不考虑服务器承受能力和压力情况。

该算法简单、方便,主要适用于特别大量的访问,同时要求服务器的处理性能基本一致,每个请求产生的压力也相当。

实际中该算法使用不多。

3.2 比例比率算法是首先对每台服务器设定一定的比例,该算法根据该比例进行分发,该算法主要用于已经明确后台服务器的处理能力不同,并能够知道处理能力的大概比例关系的情况;还有一种情况下就是,当需要对后台服务器进行迁移的时候,可以使用该算法,通过调整每台服务器的比例关系,将流量逐渐迁移。

F5 采用 IXIA 测试解决方案验证应用交付控制器的性能IXIA IXLOAD 和 ACCELERON-NP 达到 F5 NETWORKS进行威普龙验证所需的第4 到第 7 层测试仿真的新水平美国加州卡拉巴萨斯,2009 年 11 月 17 日 - 全球领先的应用交付网络厂商F5 Networks, Inc. (NASDAQ:FFIV) 与全球领先的融合 IP 性能测试系统提供商Ixia(NASDAQ:XXIA)今日宣布了对 F5®最尖端的威普龙 (VIPRION)®应用交付控制器 (ADC) 进行性能验证的结果。

F5 对威普龙 ADC全配置下的四个插卡、业界领先的第7层和SSL的性能进行了测试。

测试过程中采用Ixia IxLoad、XM12 平台和 Acceleron-NP 负载模块对ADC进行了极限测试。

F5 Networks 位于华盛顿州西雅图市的F5 技术中心完全采用 Ixia 来测试其设备,F5为客户举办的的超大型演示和概念验证(POC)等通常都在此中心举行。

借助 Ixia Acceleron-NP 及其应用流模块 (ASM) 这两个负载模块,F5 可以快速验证其高端 ADC 的最高性能,包括吞吐量、第 4 层到第 7 层的每秒连接数、每秒交易数(TPS 和 CPS)以及最大并发连接数。

在最近的一次验证中,F5 对 Acceleron-NP 负载模块的性能印象深刻。

每个 Acceleron-NP 负载模块每秒可处理760,000个第 4 层连接和 38,700 个 SSL 交易。

这样,F5 只需两个 Acceleron-NP 负载模块就可以满足威普龙每秒 100 万个第 4 层连接的需求,而且使用 4 个负载模块便可以测试威普龙是否具有每秒处理 155,000 个 SSL 交易的性能。

F5 Networks 公司产品管理工程总监 Mike Lowell 表示:“Ixia 是唯一可以为高端 ADC 提供经济高效的解决方案的性能测试厂商,尤其是难度较大的 SSL TPS 和每秒第 4 层连接数等基准测试。

F5技术介绍范文F5是一家总部位于美国的公司,专注于提供应用交付控制(Application Delivery Controller,简称ADC)和应用安全解决方案。

F5技术是指该公司所开发和使用的一系列技术,以帮助企业提高应用性能和安全性。

下面将详细介绍F5技术的几个主要方面。

1.负载均衡负载均衡是F5技术的核心概念之一,它能够将流量均匀地分配给多个服务器,以提高应用的可用性和性能。

F5的负载均衡技术可以根据服务器的运行状态和负载情况来动态调度流量,并可以在服务器故障时自动切换流量至其他健康的服务器。

此外,F5的负载均衡还支持会话保持,即使用户的请求被分发到不同的服务器上,也能保持用户的会话状态。

2.SSL加速F5的SSL加速技术能够提升HTTPS协议的性能,减少服务器的负担。

通过使用硬件加速卡和专门的加密处理器,F5可以实时处理和解密SSL加密的流量,并将解密后的流量转发给后端服务器进行处理。

这种方式可以显著降低服务器的负载,并且提高用户的访问速度和性能。

3.网络防火墙F5的网络防火墙技术可以保护企业的网络免受恶意攻击和未授权访问。

F5的防火墙可以检测和阻止各种网络攻击,如DDoS攻击、SQL注入和应用层攻击等。

F5还提供了高级的流量分析和审计功能,以便管理员能够监视和分析网络流量,及时发现和响应潜在的安全威胁。

4.应用加速F5的应用加速技术可以通过多种方式提高应用的性能和可用性。

首先,F5可以将静态内容缓存至服务器的本地存储器中,以避免每次请求都需要从后端服务器获取,从而减少网络延迟并提高响应速度。

其次,F5还可以对应用层流量进行优化,通过压缩、缓存协议和数据流等技术来减少网络传输的数据量,进一步提高应用的响应速度。

5.DNS负载均衡F5的DNS负载均衡技术可以将用户的请求分发给最近和最可用的服务器,以提高应用的性能和可用性。

F5的DNS负载均衡可以根据用户的地理位置、网络延迟和服务器的健康状态来动态调度流量。

F5 Link Controller多链路负载均衡解决方案目录1. 问题的提出................................... 错误!未定义书签。

链路单点故障............................... 错误!未定义书签。

Internet用户访问快慢差异................... 错误!未定义书签。

关键应用的带宽保证......................... 错误!未定义书签。

2. F5提供的最佳解决方案......................... 错误!未定义书签。

设计结构图:............................... 错误!未定义书签。

实现原理................................... 错误!未定义书签。

出站访问............................. 错误!未定义书签。

入站访问............................. 错误!未定义书签。

系统切换时间............................ 错误!未定义书签。

DNS迁移................................. 错误!未定义书签。

3. 解决方案功能介绍............................. 错误!未定义书签。

高可用性................................... 错误!未定义书签。

全面的链路监控能力...................... 错误!未定义书签。

集合多个监视器.......................... 错误!未定义书签。

最大带宽和投资回报......................... 错误!未定义书签。

可节省 WAN 链路成本的压缩模块(需购买模块)错误!未定义书签。

带宽可扩展性............................ 错误!未定义书签。

多链路负载均衡标准结构及阐述F5 Networks Inc.目录一、F5多链路负载均衡标准结构 (3)1.1标准结构拓扑图 (3)1.2技术阐述 (3)二、域名解析方式 (12)2.1 Root DNS Server 直接与F5多链路负载均衡器配合•••122.1.1 CNAME 方式 (13)2.1.2 NS委派方式 (13)2.2 Root DNS Server通过第三方DNS Server与F5多链路负载均衡器配合 (14)2.2.1 CNAME 方式 (14)2.2.2 NS 方式 (15)三、F5多链路负载均衡其它结构及阐述 (16)3.1冗余结构 (16)3.2与防火墙配合的结构 (17)3.2.1后置防火墙 (17)3.2.2前置防火墙 (18)一、F5多链路负载均衡标准结构1.1标准结构拓扑图下图是F5多出口链路负载均衡解决方案的标准结构(单台设备)ISPthxil«T1.1.1)iiiterndl vlnni ntprn^ I nptutrnrkIhttl i. iO $<n*r.站Seivti. 30GW:192.168.1.21.2技术阐述网络环境描述上图中F5多链路负载均衡设备通过ISP1和ISP2接入In ternet。

每个ISP 都分配给该网络一个IP地址网段,假设ISP1分配的地址段为100.1.1.0/24 ,ISP2分配的地址段为200.1.1.0/24 (此处的200.1.1.0/24 表示网络IP地址段为:200.1.1.0,子网掩码为24 位,即255.255.255.0 )。

同样,In ternet 知道通过ISP1访问100.1.1.0/24 ,通过ISP2访问200.1.1.0/24。

网络中的主机和服务器都属于私有网段192.168.1.0/24。

F5多链路负载均衡设备解决方案就是在内部交换机和连接ISP的路由器之间,跨接一台多链路负载均衡设备应用交换机,所有的地址翻译和In ternet链路优化全部由多链路负载均衡设备来完成。

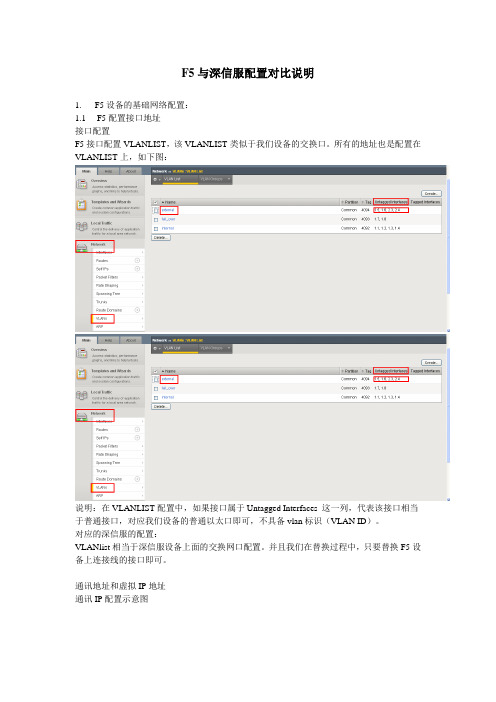

F5与深信服配置对比说明1. F5设备的基础网络配置:1.1 F5配置接口地址接口配置F5接口配置VLANLIST,该VLANLIST类似于我们设备的交换口。

所有的地址也是配置在VLANLIST上,如下图:说明:在VLANLIST配置中,如果接口属于Untagged Interfaces 这一列,代表该接口相当于普通接口,对应我们设备的普通以太口即可,不具备vlan标识(VLAN ID)。

对应的深信服的配置:VLANlist相当于深信服设备上面的交换网口配置。

并且我们在替换过程中,只要替换F5设备上连接线的接口即可。

通讯地址和虚拟IP地址通讯IP配置示意图F5在配置ip地址时候,与我们设备不同,分为通讯ip地址和对外发布的虚拟ip地址:A、通讯ip和虚拟ip地址,两种地址都不是配置在接口上。

B、通讯ip主要进行路由转发,虚拟ip地址是对外发布的虚拟ip地址(相当于我们设备的ip 组)。

C、F5在配置通讯ip地址的时候,首先配置VLANLIST。

VLANLIST作用是将F5设备的物理接口划分在不同的VLANLIST中,然后针对VLANLIST进行ip地址配置。

(该功能相当于3层交换机的vlan配置,设置vlan号,配置vlan地址,配置vlan承载的物理接口)。

D、虚拟ip地址不需要配置在接口上,只需要在配置VS(虚拟服务)的时候,直接配置要配置的ip地址即可。

对应的深信服设备配置:在深信服设备配置的时候,只需要配置F5设备的对外地址即可。

对应的wan口方向的网关需要到路由配置中添加。

如下图:F5双机配置F5双机配置跟我们设备不一样。

F5要使用双机配置,需要三个同一网段的地址,主备机各一个地址,另外一个虚拟ip(类似于vrrp)。

双机工作模式同时只有一台设备在进行服务负载,但是客户的F5的主备设备都是可以通过各自的ip地址登陆的。

F5的双机连接线同时可以使用多条,(一根串口线,一根网口线)或者多跟网口线。

F5方案F5方案1. 引言在当前互联网技术迅猛发展的背景下,企业对于网站和应用程序的性能和安全性要求越来越高。

F5方案是一种综合性的解决方案,通过使用F5系列产品,在大规模应用交付、网络安全和性能优化等方面提供全面的支持和解决方案。

本文将介绍F5方案的主要功能和应用场景,并详细解析其中的关键技术和优势。

2. F5方案的功能F5方案是基于F5公司的产品线开发的一种网络解决方案,主要包括以下功能:2.1 应用交付F5方案通过负载均衡、会话保持、内容缓存等技术,可以实现高可用、高性能的应用交付。

它能够将客户请求合理分配给后端服务器,提高系统的负载能力,确保网站和应用程序的可靠性和可用性。

2.2 网络安全F5方案提供了一系列的网络安全功能,包括应用层防火墙、DDoS防护、SSL加速等技术。

通过检测和阻止恶意流量,保护网络免受攻击。

同时,它还能够加密和解密网络流量,提高网站的安全性。

2.3 性能优化F5方案还提供了一系列的性能优化功能,包括数据压缩、TCP优化、HTTP优化等技术。

这些功能可以减少网络传输的数据量,提高网络的传输速度,加快网站和应用程序的访问速度。

3. F5方案的应用场景F5方案在各个行业和领域都有广泛的应用,主要包括以下几个方面:3.1 电子商务在电子商务领域,F5方案可以帮助企业实现高可用、高性能的网站和应用程序。

通过负载均衡和缓存技术,它可以提高用户访问的速度和体验,增强企业的竞争力。

3.2 金融领域在金融领域,F5方案可以保护企业的网络安全,防止恶意攻击和数据泄露。

同时,它还可以提供高性能的网络传输和应用交付,满足金融机构对于业务处理速度和可靠性的要求。

3.3 政府机构政府机构需要处理大量的网络流量和用户请求,同时还要保护网络的安全性。

F5方案可以帮助政府机构实现高性能的网络交付和安全防护,提高政府服务的效率和可靠性。

4. F5方案的关键技术和优势F5方案的核心技术包括:4.1 iRules技术iRules是F5方案的一项关键技术,它是一种基于事件驱动的脚本语言,可以用于实现高级的流量控制和应用逻辑。

1.什么是会话保持?在大多数电子商务的应用系统或者需要进行用户身份认证的在线系统中,一个客户与服务器经常经过好几次的交互过程才能完成一笔交易或者是一个请求的完成。

由于这几次交互过程是密切相关的,服务器在进行这些交互过程的某一个交互步骤时,往往需要了解上一次交互过程的处理结果,或者上几步的交互过程结果,服务器进行下一步操作时就要求所有这些相关的交互过程都由一台服务器完成,而不能被负载均衡器分散到不同的服务器上。

而这一系列的相关的交互过程可能是由客户到服务器的一个连接的多次会话完成,也可能是在客户与服务器之间的多个不同连接里的多次会话完成。

不同连接的多次会话,最典型的例子就是基于http 的访问,一个客户完成一笔交易可能需多次点击,而一个新的点击产生的请求,可能会重用上一次点击建立起来的连接,也可能是一个新建的连接。

会话保持就是指在负载均衡器上有这么一种机制,可以识别做客户与服务器之间交互过程的关连性,在作负载均衡的同时,还保证一系列相关连的访问请求会保持分配到一台服务器上。

2.F5支持什么样的会话保持方法?F5 Big-IP支持多种的会话保持方法,其中包括:简单会话保持(源地址会话保持)、HTTP Header的会话保持,基于SSL Session ID的会话保持,i-Rules会话保持以及基于HTTP Cookie的会话保持,此外还有基于SIP ID以及Cache设备的会话保持等,但常用的是简单会话保持,HTTP Header的会话保持以及HTTP Cookie会话保持以及基于i-Rules的会话保持。

2.1 简单会话保持简单会话保持也被称为基于源地址的会话保持,是指负载均衡器在作负载均衡时是根据访问请求的源地址作为判断关连会话的依据。

对来自同一IP地址的所有访问请求在作负载均时都会被保持到一台服务器上去。

在BIG-IP设备上可以为“同一IP地址”通过网络掩码进行区分,比如可以通过对IP地址 192.168.1.1进行255.255.255.0的网络掩码,这样只要是来自于192.168.1.0/24这个网段的流量BIGIP 都可以认为他们是来自于同一个用户,这样就将把来自于192.168.1.0/24网段的流量会话保持到特定的一台服务器上。

F5负载均衡简要原理解析以及命令⾏命令F5重点剖析原理配置维护⼀、F5是什么,它能解决什么问题?⼆、F5 BIG-IPLTM 硬件介绍三、F5的⼯作原理和相关名词术语四、门户⽹站负载均衡配置的分析1.⾸先我们应该了解⼀个名词:ADNADN(Application Delivery Networks )--应⽤交付⽹络:旨在把数据中⼼的应⽤和业务快速、安全、⾼可⽤地交付到客户端。

F5就是实现这种解决⽅案的⼀系列产品。

2.具体描述F5是⼀种⽹络性能优化设备,⼯作在⽹络的四层或七层。

它不同于交换机、路由器这些基础⽹络设备,⽽是建⽴在现有的⽹络结构上,⽤来扩展⽹络设备和服务器的带宽、增加吞吐量、加强⽹络处理数据能⼒的设备。

3.通俗地介绍⽐如⼀个门户⽹站共有10台服务器,⽤来提供相同的Web服务,在通信安全、处理请求、故障检测、性能优化⽅⾯,F5能做什么?在F5上配置⽹站对外的公⽹IP,接收来⾃Internet的请求,然后通过NAT转换把公⽹IP转换成后端Web服务器的私有地址,把请求转到各个服务器上,实现通信的安全。

F5在转发请求的时候,能通过⾃⾝的分发算法(如轮询),把请求均衡地分发到web服务器上。

通过Monitor机制,实时地检测后端服务器的状态,如果发现单点故障,便终⽌向此服务器发送请求。

当故障解决后,F5⼜会⾃动重新发送请求给它。

在性能优化⽅⾯,F5能够保持会话状态,能够压缩数据传输,从⽽减轻服务器的压⼒并减轻⽹络的吞吐压⼒。

2.LED指⽰灯的介绍1.⾯板介绍1.1最左端的红⾊⽹线所插的端⼝是F5的带外⽹络管理端⼝。

1.2左端两个较粗的线缆所插的端⼝:⿊⾊对应的是Console⼝,⽩⾊对应的是Failover端⼝。

( Failover端⼝是两台F5⼯作在HA主备模式下⽤到的)1.3中间的8个端⼝是以太⽹端⼝。

端⼝编号依次为1.1到1.8.1.4右⾯的两个挨着的端⼝是光纤端⼝。

编号分别为2.1和2.2.1.5最右⾯的为LED显⽰屏、指⽰灯、操作键。

F5白皮书灾难恢复:不仅是针对最坏情况做规划本白皮书介绍企业如何使用F5 Networks®的BIG-IP®广域流量管理器™在主用-主用配置下充分发挥二级站点的全部优势,全面地管理分布于多个站点间的应用。

本文还介绍了您如何利用BIG-IP®链路控制器™ 维护ISP链路的连接和WANJet™,从而加快WAN上的站点对站点数据复制。

作者:Paul StalvigF5 Networks目录保持数据中心的健康状态3最终解决方案4利用BIG-IP GTM进行灾难预防工作5全面的健康状态监控 6 服务管理和维护11结束语15由于自然灾害、攻击或应用基础设施故障而导致的站点瘫痪是收入损失、客户满意度降低以及用户工作效率下降的主要原因。

由于缺乏远见和预算,很少有公司能够在预测到灾难的情况下在另外一个地方的站点建立数据中心。

通常情况下,企业以主用-备用配置模式通过手工恢复流程设立备份站点,不但费用昂贵,容易出错,而且响应速度缓慢。

这些企业面临着交易中断、客户不满意以及停机成本等问题,严重影响业务的运行,并使获利能力降低。

本文介绍了企业如何利用F5 BIG-IP®广域流量管理器™在主用-主用配置下充分发挥备份站点的全部优势,全面地管理分布于多个站点间的应用,并且:•通过跟踪和管理组合应用中协同工作的多个数据中心、应用以及任何Web服务而实现应用的高可用性。

这涉及到通过跟踪依赖关系透明地将用户重定向到可用的站点,并消除因停机而造成的代价。

•通过应用状态和持续性跟踪而确保用户持续位于同一个站点中,以消除断续的会话和数据损坏。

•通过应用维护确保应用可以在多个站点间启动或停止,从而在不增加管理费用的情况下消除停机时间以及错误或者猜测。

本文还介绍了您如何利用BIG-IP®链路控制器™维护ISP链路的连接和WANJet™,从而加快WAN上的站点对站点数据复制。

保持数据中心的健康状态保持多个数据中心间应用的可用性提出了多方面的挑战:•缺乏对数据中心和应用健康状态的洞察力–如何衡量数据中心和应用的健康状态?•非最优的用户体验–当企业交付应用时,如何处理断续的会话、找回丢失的数据,并且保证个人信息的安全?•维护费用–通常情况下,企业除了关停整个数据中心进行升级之外别无选择,否则,需要花费多长时间在WAN上进行站点对站点数据复制?对于电子商务站点,您能否想像得到会损失多少收入?•DNS错误的影响–域名服务器(DNS) 管理一直是企业了解最少但应用最普遍的网络技术。

f5工作原理F5工作原理。

F5是一种网络流量管理设备,它可以帮助企业管理其网络流量,提高网络性能和安全性。

F5的工作原理涉及到负载均衡、应用交付控制和安全防护等方面,下面我们来详细了解一下F5的工作原理。

首先,F5的负载均衡功能是其最核心的工作原理之一。

负载均衡是指将网络流量均匀地分配到多台服务器上,以提高服务器的利用率、增加网站的访问速度和提高整个网络系统的可靠性。

F5通过监控服务器的负载情况,将流量智能地分发给空闲或负载较轻的服务器,从而实现了负载均衡的功能。

其次,F5还具有应用交付控制的功能。

应用交付控制是指通过F5设备对网络流量进行优化和加速,以提高用户体验和应用性能。

F5可以通过压缩、缓存和加速等技术,对网络流量进行优化,从而减少延迟,提高网站的响应速度,提升用户体验。

此外,F5还可以提供安全防护功能。

F5设备可以对网络流量进行深度检测和分析,识别恶意流量和攻击行为,并对其进行阻断和清洗,保护企业的网络安全。

F5可以通过应用防火墙、入侵检测系统等技术,对网络流量进行实时监控和防护,确保网络的安全性和稳定性。

除了以上几点,F5还具有很多其他的工作原理,比如内容路由、全局负载均衡、SSL加速等功能。

总的来说,F5通过负载均衡、应用交付控制和安全防护等多种技术手段,实现了对网络流量的智能管理和优化,为企业提供了高性能、高可靠性和高安全性的网络服务。

综上所述,F5的工作原理涉及到负载均衡、应用交付控制和安全防护等多个方面,通过这些技术手段,F5可以帮助企业提高网络性能和安全性,实现业务的高效运行。

希望本文对F5的工作原理有所帮助,谢谢阅读!。

F5利用全新IP智能服务目前,应用交付网络领域全球领导厂商F5 Networks, Inc. (NASDAQ:FFIV)推出基于云的服务,该服务支持企业通过检测阻止与恶意活动相关的IP地址访问,从而保护其基础设施。

通过识别相关IP地址和利用云环境安全解决方案中的智能性,F5的全新IP智能服务结合了最新威胁信息收集和BIG-IP 应用交付平台的统一策略执行功能。

BIG-IP系统将F5的订阅服务与外部服务无缝结合的功能可为客户提供增强其整体安全性的全新方式。

F5产品管理与安全部高级总监Mark Vondemkamp表示:“企业正在寻找可动态结合各种来源信息的解决方案,从而为基础设施提供最高程度的保护,避免复杂的网络攻击。

与此同时,由于网络和访问条件的不断变化,新威胁类型也将不断涌现,因此企业必须保证一定灵活性,从而定制其系统并增加防护。

F5的IP智能服务支持客户通过利用F5功能强大的BIG-IP Application Security Manager (应用安全管理器)和iRules 技术,汇聚不同的威胁检测功能,对恶意IP地址进行阻止,并为特定需求定制不同的安全及性能级别。

”增强安全级别的同时降低整体安全防护开销如今,提供丰富互联网内容的公司都面临大量攻击,而且这些攻击来自快速变换IP地址或其它变量。

此外,入站和出站僵尸网络流量和恶意活动可渗入安全层并消耗宝贵的资源。

通常情况下,企业会部署点解决方案,例如用于阻止恶意活动和站点的IP信誉服务,但是这些解决方案只有与应用交付控制器集成,才能够提供全方位、动态的保护。

另外,企业可通过利用BIG-IP解决方案在单一平台中提供统一服务的能力而减少整体安全开支。

利用频繁更新的威胁源和高风险IP地址列表,F5的全新IP智能服务可提供环境感知能力和IP请求分析功能,从而识别出互联网中多个来源中的威胁。

该服务可利用全球威胁传感器网络和IP地址数据库中的海量信息检测恶意活动,并可利用F5的统一BIG-IP架构提供覆盖整个应用交付基础设施的全面保护。

外国人写的一篇关于oneconnect的理解F5 OneConnectF5 has a trademark feature called OneConnect that leverages HTTP 1.1 Keepalive. In this article, I will try to explain the functionality of OneConnect, underlying technology and its usage requirements.There are 2 main reasons that I have utilized OneConnect profile:Efficient reuse of server side connections (F5-Servers)L7 Content Switching i.e., when the F5 is configured to make load balancing or persistence decision based on information available in L5 to L7.Efficient TCP Connection Reuse:Every time a new connection is set up on the server, the server has to allocate resources.What Resources:Resources like State/buffer memory at the Kernel level & memory per thread as each connection consumes web server threads. There is also an impact on the CPU of the server as the server needs to keep track of the web threads and connections.The consumption of resources outlined earlier won’t affect a small to medium scale load balanced web-server infrastructure. However, as the traffic flow increases, the servers can take quite a big hit. At this point, the option would be to add more servers which can increase your CapEx and of course, OpEx will rise for administrative reasons.OneConnect, if used properly will provide you with a method to efficiently utilize the existing infrastructure without the requirement for adding more physical servers. This is done by leveraging existing server side connections using HTTP 1.1 Keepalive.Lets say, client IP 1.1.1.1 is initiating a connection to the VIP 50.50.50.50 which then gets load balanced to the server 10.10.10.10. Within the TCP connection, the client will utilize multiple HTTP Requests to obtain the right content from the server (HTTP 1.1 Keepalive). After the transaction has been completed, the client closes theclient side connection (Client –F5). However, the F5 retains the server side connection (F5-Server). If a new client (1.1.1.2) initiates a connection within a certain timeout interval, the F5 will re-use the server side connection that was retained for the 1.1.1.1 connection. As you can see, the server side connection that was created when 1.1.1.1 made the initial request was used when the new client 1.1.1.2 made the request.In this particular simple example, 2 client side connections were served with only 1 server side connection. Assuming you can achieve the same scale ratio, 100K client side connections require only 50K server side connections. As the client side connection increases, the OneConnect profile delivers better results.One thing to note is that from the server’s perspective, HTTP Requests initiated by 1.1.1.2 is still assumed to be over the connection initiated by 1.1.1.1 i.e., the client IP at the server level no longer provides the right information about the true client IP. In order to overcome this, “X-Forwarded-For” header insertion would have t o be utilized to insert the right “True Client IP” at the server level. It is essential that the server logs and the application looks for the client IP in the “X-Forwarded-For” header and not the Client IP field.How does the F5 know which server-side connection to reuse:In order to understand the connection-reuse algorithm, it is essential to understand the OneConnect Profile Settings.OneConnect Profile Settings:Source Mask – Network mask that is applied to the incoming client IP in order to identify the server side connection that can be reused. The effect of Source Mask in OneConnect is well explained here.Maximum Size – Max number of server-side connections that is retained in the connection pool for reuseMaximum Age – Max age up to which a server side connection is retained in the connection pool for reuseMaximum Reuse – Max number of HTTP Requests that can be sent over a server side TCP connectionIdle Timeout Override – Max time up to which an idle server side connection is kept open for reuse.A server side connection is retained in the “connection pool” for reuse as long as it satisfies the Max Age, Reuse & Idle Timeout conditions. The size of this “connection pool” is defined within Max Size.Based on experience, I would recommend not altering any of the default settings of the OneConnect profile other than the Source Mask.L7 Content Switching:By default, F5 performs load balancing only once for each TCP connection. This is performed when the very first HTTP Request within a TCP Connection is received by the F5 LTM. Subsequent HTTP Requests in the same TCP connection will be sent to the same server that handled the 1st HTTP Request.Consider a scenario in which there are multiple clients originating connections from behind a proxy that multiplexes individual client TCP connection into a single TCP connection and sends requests to the F5’s VIP via this single TCP Connection. In this case, after the load balancing decision is made for the very first HTTP Request from the 1st client, subsequent HTTP requests from other clients will be sent to the same server, regardless of the L7 information. If you utilize the HTTP header information for load balancing or persistence, it will lead to undesirable behavior.An example:Lets say that there are 5 clients initiating 5 TCP connections and this gets multiplexed into 1 TCP connection between the Proxy and the F5.Lets say that the load balancing/persistence decision is made based on the cookie persistence (L7)When the 1st client sends its HTTP Request, it will be load balanced to a specific pool and cookie will be inserted in the HTTP Response.If there is a subsequent HTTP Request from any of the other 4 clients utilizing the same TCP connection between the proxy and the F5, they will be sent to the same server that handled the 1st HTTP Request, even if the cookie information provided by the subsequent HTTP Requests are different –lets say that the cookie was setmanually and it is pointing to a different server.This happens because the F5 will stop parsing the HTTP requests in the same TCP connection after the load balancing decision has been made for the very 1st HTTP request – default behavior. When we enable OneConnect, we are telling the F5 to continue checking the HTTP Requests and not to stop checking after the 1st HTTP Request.This article explains the default behavior of the F5 device and how it affects L7 persistence like Cookie & Universal (UIE).This article explains the reason for using OneConnect when load has to be balanced to multiple pools based on L7 information.In short, whenever you require load balancing or persistence based on L7 information, utilize OneConnect.A good understanding of OneConnect requires a good grasp of HTTP 1.1 Keepalive, Pipelining, OneConnect Profile Settings & the default F5 load balancing behavior.I will try to provide a graphical explanation to OneConnect in the coming days.More information about OneConnect is provided here.。