基于模糊匹配的Lucene检索应用

- 格式:pdf

- 大小:1.46 MB

- 文档页数:4

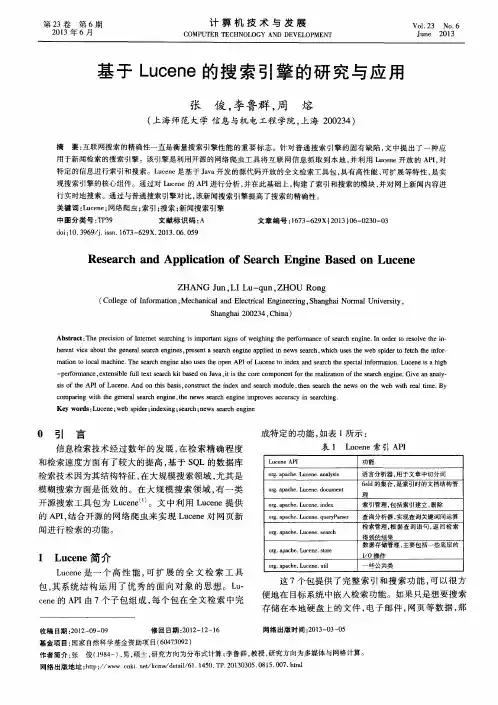

(责任编辑:陈和榜)浙江理工大学学报,第26卷,第1期,2009年1月Journal of Zhejiang Sci 2Tech U niversityVol.26,No.1,J an.2009文章编号:167323851(2009)0120109205收稿日期:2008-05-29作者简介:黄 珏(1982- ),女,浙江杭州人,助理研究员,主要从事搜索引擎,数字图书馆,软件工程方面的研究。

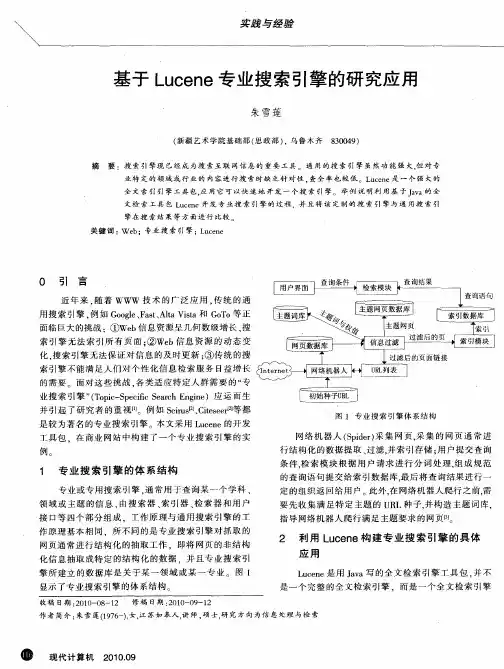

基于Lucene 的语段模糊匹配中文检索系统设计与实现黄 珏,黄志远(浙江理工大学科技与艺术学院,杭州311121) 摘 要:为提高图书馆中文信息检索的精确度和有效性,设计了基于L ucene 的语段模糊匹配中文检索系统。

其采用了自然语言处理中的词语切分技术,使输入条件可以直接通过自然语言的方式提交,同时针对语段匹配的实际问题情境,设计了一种新的结果有效性判别模型,提高了检索结果相似度的科学性和准确性。

经过多次实验结果的统计,搜索结果有效性可提高12%。

关键词:L ucene ;语段;中文检索;有效性判别中图分类号:TP393 文献标识码:A0 引 言信息检索技术在图书馆领域的应用是举足轻重的,然而,当前图书馆用户在检索资料的时候,常常会遇到这样的情况:记得一篇文章或一本书刊中的某段话,却记不清标题、作者、出版社之类的特征信息。

凭着对这个语段的记忆,选取某些关键字/词进行查询,又无法快速准确的找到目标答案。

个别数字资源自带的搜索引擎具有全文检索功能,允许用户输入一个语段来进行查询,但是查全率和查准率差强人意:要求输入条件与文档内容完全匹配,或者查询结果不能很好地对应用户感兴趣的内容。

首先,基于关键字/词和逻辑表达式的检索方式不能全面地反映用户的需求。

由于用户输入的关键字/词之间,往往不存在任何联系,因此检索条件本身无法清晰表达用户的真正含义[1]。

其次,简单的关键字/词匹配,往往输出大量的文档,而真正相关的文本却很少,使得用户耗费很多的时间和精力处理一些不相关的结果。

一、lucene模糊匹配原理概述lucene是一个开源的全文检索引擎工具,提供了强大的文本搜索和分析功能。

在实际应用中,经常需要进行模糊匹配,以处理用户输入的错别字、拼写错误或者同义词。

模糊匹配是lucene中非常重要的功能,它可以帮助用户找到相关的文档,提高搜索的准确性和全面性。

二、lucene模糊匹配的算法原理1. Levenshtein Distance算法Levenshtein Distance是衡量两个字符串相似程度的一种算法,也称为编辑距离。

在lucene中,模糊匹配主要使用Levenshtein Distance算法来实现。

该算法通过计算两个字符串之间的距离,从而确定它们的相似程度。

具体来说,它通过插入、删除和替换操作,将一个字符串转换成另一个字符串所需的最小步骤数来衡量相似度。

2. 模糊查询的实现方式在lucene中,模糊查询可以通过FuzzyQuery类来实现。

利用FuzzyQuery,可以指定一个最大编辑距离,从而允许匹配到具有一定相似度的文档。

FuzzyQuery会基于Levenshtein Distance算法来进行模糊匹配,找到编辑距离小于等于指定值的文档。

三、模糊匹配的应用场景1. 处理用户输入错误当用户在搜索框中输入错别字或者拼写错误时,模糊匹配可以帮助系统找到相关的文档,并提供纠正建议,提高搜索的准确性和用户体验。

2. 同义词匹配在自然语言处理中,同一个概念可能有多种不同的表达方式。

通过模糊匹配,可以将具有相似含义的词语进行匹配,从而提高搜索的全面性。

3. 解决词形变化问题词形变化是自然语言中常见的现象,同一个词可能有不同的变形形式。

通过模糊匹配,可以将不同词形的单词对应起来,使得搜索更加全面和准确。

四、模糊匹配的优化策略1. 设置合适的编辑距离阈值在使用模糊匹配时,需要根据具体的应用场景来设置合适的编辑距离阈值。

如果编辑距离过小,可能会产生大量的不必要匹配;如果编辑距离过大,可能会包含过多的无关文档。

javalucene用法JavaLucene是一个用于全文检索的开源库,它提供了一个高效且可扩展的搜索引擎。

它基于Apache Lucene项目,并提供了Java编程语言的接口和实现。

使用JavaLucene,我们可以创建索引并搜索包括文本、数字、日期等数据类型的文档。

下面是一些常见的JavaLucene用法:1.创建索引:首先,我们需要创建一个用于存储索引的目录。

然后,我们可以使用IndexWriter类将文档添加到索引中。

每个文档包含一个或多个字段,我们可以指定字段的类型和分析方式。

分析器负责将文本分成单词,并对它们进行规范化和标准化,以便更好地进行搜索。

2.搜索:我们使用IndexSearcher类来执行搜索操作。

可以使用QueryParser类解析查询字符串,并将其转换为查询对象。

查询可以是简单的词语匹配、范围查询、模糊查询等。

搜索结果以文档的形式返回,我们可以根据需要对其进行排序、过滤等操作。

3.更新索引:如果需要对索引进行更新,例如添加新的文档或删除现有的文档,我们可以使用IndexWriter类来执行这些操作。

之后,我们需要使用IndexReader类来重新打开索引以获取最新的结果。

拓展:除了基本的索引和搜索功能,JavaLucene还提供了其他一些强大的功能:1.高级搜索:JavaLucene支持布尔搜索、通配符搜索、模糊搜索、模糊匹配、短语搜索等。

这些功能可以帮助我们更准确地定位所需的结果。

2.高亮显示:JavaLucene可以通过标记匹配结果中的关键词并进行高亮显示来改善用户体验。

这对于搜索结果的展示非常有帮助。

3.分布式搜索:JavaLucene可以与其他工具配合使用,如Apache Solr和Elasticsearch,进行分布式搜索。

这允许我们搭建具有高可用性和可扩展性的搜索引擎。

4.自定义扩展:JavaLucene允许用户通过实现自定义的分析器、查询解析器、评分算法等来扩展其功能。

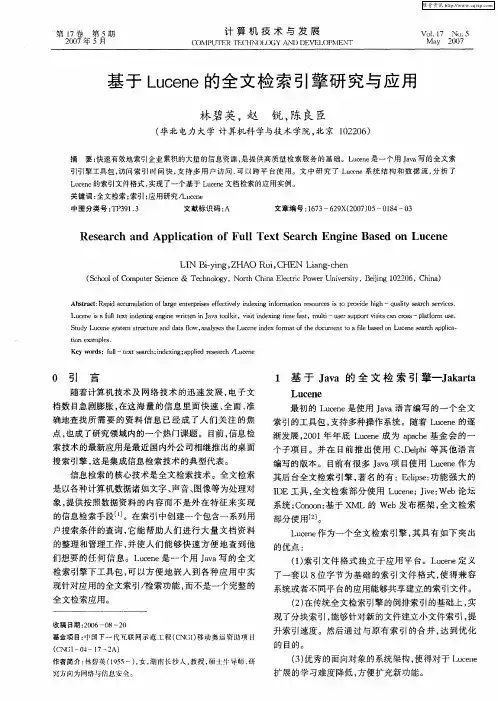

基于Lucene的搜索引擎的研究与应用的开题报告一、选题背景与意义随着大数据时代的到来,信息处理与搜索引擎的需求越来越旺盛。

搜索引擎已经成为了用户最主要的获取信息的方式之一,而其对于信息的快速准确检索,已经逐渐成为了搜索引擎最基本的核心要素。

在搜索引擎的实现中,建立搜索引擎的核心技术是信息检索技术。

Lucene是一种优秀的信息检索工具,它是一个开源的高性能全文检索引擎,是全球范围内最受欢迎和广泛使用的Java搜索引擎工具之一。

Lucene的出现,大大减轻了开发人员在搜索引擎上面的工作。

因此,本研究旨在结合Lucene技术,建立一个基于Lucene的高性能搜索引擎。

同时,本研究旨在建立一个高效可用的开源搜索引擎,提供了一种降低信息检索门槛的工具,可以帮助各行业快速掌握搜索引擎,实现业务数据的快速检索。

对于大数据时代进行数据分析、处理、挖掘和管理具有重要意义,提高企业的决策效率和准确性,并且降低成本和人力资源。

二、研究内容及方法2.1 研究内容:(1)了解信息检索和全文检索的概念和原理。

(2)分析Lucene架构和工作原理,掌握Lucene的基本概念和核心技术。

(3)按照Lucene的架构,设计并实现搜索引擎的各个模块。

(4)进行搜索引擎的基本测试和功能测试,检查搜索引擎的性能和可靠性。

2.2 研究方法:(1)文献综述法:阅读大量的文献和资料,理清搜索引擎的基本概念和原理。

(2)实验法:按照Lucene的架构,建立实验室,开发搜索引擎的各个模块,并进行测试和评估。

三、研究计划时间节点研究任务2021.1-2021.2 阅读文献,调研和理解搜索引擎的基本概念和原理。

2021.3-2021.4 学习Lucene技术,分析Lucene的架构和工作原理。

2021.5-2021.6 根据Lucene技术建立搜索引擎,在本地环境中逐步完善各个模块。

2021.7-2021.8 进行搜索引擎的基本测试和功能测试,并检查搜索引擎的性能和可靠性。

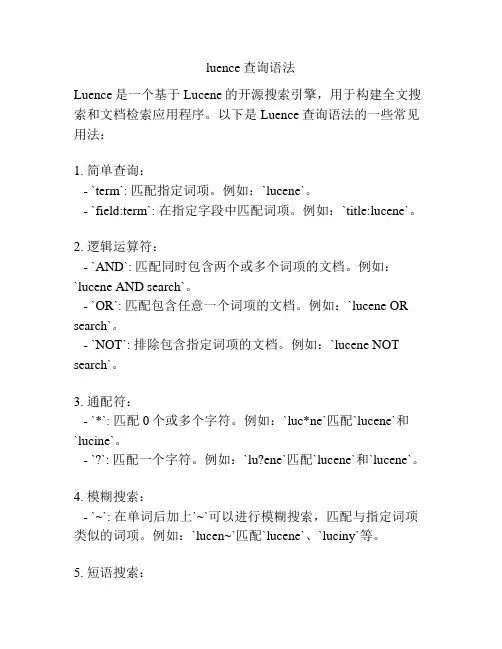

luence查询语法Luence是一个基于Lucene的开源搜索引擎,用于构建全文搜索和文档检索应用程序。

以下是Luence查询语法的一些常见用法:1. 简单查询:- `term`: 匹配指定词项。

例如:`lucene`。

- `field:term`: 在指定字段中匹配词项。

例如:`title:lucene`。

2. 逻辑运算符:- `AND`: 匹配同时包含两个或多个词项的文档。

例如:`lucene AND search`。

- `OR`: 匹配包含任意一个词项的文档。

例如:`lucene OR search`。

- `NOT`: 排除包含指定词项的文档。

例如:`lucene NOT search`。

3. 通配符:- `*`: 匹配0个或多个字符。

例如:`luc*ne`匹配`lucene`和`lucine`。

- `?`: 匹配一个字符。

例如:`lu?ene`匹配`lucene`和`lucene`。

4. 模糊搜索:- `~`: 在单词后加上`~`可以进行模糊搜索,匹配与指定词项类似的词项。

例如:`lucen~`匹配`lucene`、`luciny`等。

5. 短语搜索:- `"phrase search"`: 使用双引号来匹配包含完整短语的文档。

6. 范围搜索:- `field:[value1 TO value2]`: 匹配范围内的值。

例如:`price:[10 TO 100]`匹配价格在10到100之间的文档。

7. 分组查询:- `(query1) AND (query2)`: 使用括号来分组查询。

例如:`(lucene AND search) OR (java AND development)`。

以上是Luence查询语法的一些常见用法,可以根据具体需求进行组合和拓展。

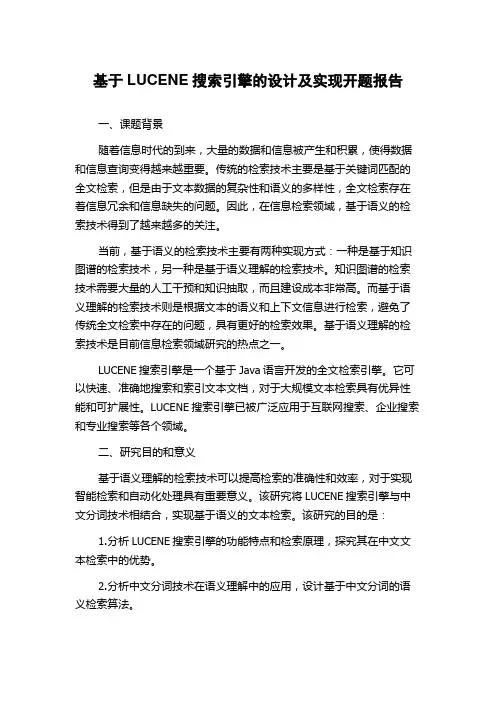

基于LUCENE搜索引擎的设计及实现开题报告一、课题背景随着信息时代的到来,大量的数据和信息被产生和积累,使得数据和信息查询变得越来越重要。

传统的检索技术主要是基于关键词匹配的全文检索,但是由于文本数据的复杂性和语义的多样性,全文检索存在着信息冗余和信息缺失的问题。

因此,在信息检索领域,基于语义的检索技术得到了越来越多的关注。

当前,基于语义的检索技术主要有两种实现方式:一种是基于知识图谱的检索技术,另一种是基于语义理解的检索技术。

知识图谱的检索技术需要大量的人工干预和知识抽取,而且建设成本非常高。

而基于语义理解的检索技术则是根据文本的语义和上下文信息进行检索,避免了传统全文检索中存在的问题,具有更好的检索效果。

基于语义理解的检索技术是目前信息检索领域研究的热点之一。

LUCENE搜索引擎是一个基于Java语言开发的全文检索引擎。

它可以快速、准确地搜索和索引文本文档,对于大规模文本检索具有优异性能和可扩展性。

LUCENE搜索引擎已被广泛应用于互联网搜索、企业搜索和专业搜索等各个领域。

二、研究目的和意义基于语义理解的检索技术可以提高检索的准确性和效率,对于实现智能检索和自动化处理具有重要意义。

该研究将LUCENE搜索引擎与中文分词技术相结合,实现基于语义的文本检索。

该研究的目的是:1.分析LUCENE搜索引擎的功能特点和检索原理,探究其在中文文本检索中的优势。

2.分析中文分词技术在语义理解中的应用,设计基于中文分词的语义检索算法。

3.实现基于LUCENE搜索引擎和中文分词技术的语义文本检索系统,并对系统性能进行测试和优化。

该研究将为语义文本检索领域的研究和应用提供新的思路和方法,促进智能检索技术的发展与应用。

三、研究内容和方法1.研究LUCENE搜索引擎的功能特点和检索原理,探究其在中文文本检索中的优势。

2.分析中文分词技术在语义理解中的应用,设计基于中文分词的语义检索算法。

3.实现基于LUCENE搜索引擎和中文分词技术的语义文本检索系统,并对系统性能进行测试和优化。

luncene检索语法Lucene是一个高性能、全功能的搜索引擎库,提供了强大的文本搜索和信息检索功能。

它是由Apache基金会开发和维护的一个开源项目,主要用于构建全文检索引擎。

Lucene的检索语法是用来构建查询表达式,从索引中检索相关文档的一种语法。

它支持多种查询操作,包括关键字查询、范围查询、通配符查询、模糊查询和布尔查询等。

下面将对Lucene的检索语法进行详细介绍。

1.关键字查询:关键字查询是最基本的查询操作,可以通过词项或短语来匹配文档中的内容。

例如,可以使用如下的查询语法进行关键字查询:-单个词项查询:term-多词项查询:term1 term2-短语查询:"term1 term2"2.范围查询:范围查询可以通过指定上下界来匹配落在指定范围内的文档。

范围查询语法如下:-数值范围查询:[low TO high]-日期范围查询:[date1 TO date2]-字符串范围查询:[term1 TO term2]3.通配符查询:通配符查询可以使用通配符字符来匹配文档中的内容。

通配符字符包括星号(*)和问号(?)。

例如,可以使用如下查询语法进行通配符查询:-单个通配符查询:term*-多个通配符查询:term1* term2?4.模糊查询:模糊查询可以通过指定编辑距离来匹配与查询词项相似的文档。

编辑距离是指将一个词项转化为另一个词项所需的最小编辑操作数,包括插入、删除和替换操作。

例如,可以使用如下查询语法进行模糊查询:-单个模糊查询:term~-多个模糊查询:term1~ term2~5.布尔查询:布尔查询可以通过逻辑运算符AND、OR和NOT来组合多个条件。

例如,可以使用如下查询语法进行布尔查询:- AND查询:term1 AND term2- OR查询:term1 OR term2- NOT查询:term1 NOT term2以上是Lucene检索语法的基本用法,可以通过组合和嵌套使用这些查询操作来构建更复杂和精确的检索语句。

luncene检索语法1. 简单查询:-单词匹配:查询包含指定单词的文档。

```text:Lucene```2. 逻辑运算符:- AND 操作符:查询同时包含两个条件的文档。

```text:Lucene AND text:search```- OR 操作符:查询包含任一条件的文档。

```text:Lucene OR text:search```- NOT 操作符:查询不包含指定条件的文档。

```text:Lucene NOT text:search```3. 通配符和模糊搜索:-通配符(Wildcard):使用通配符进行模糊搜索。

```te*t```-模糊搜索:允许在单词的末尾添加一个波浪线来执行模糊搜索。

```Lucene~```4. 范围搜索:-范围搜索:查询在指定范围内的文档。

```date:[20190101 TO 20191231]```5. 短语搜索:-短语搜索:查询包含特定短语的文档。

```"Lucene search"```6. 通用语法:-通用语法:使用通配符查询多个字段。

```(title:Lucene OR content:Lucene) AND text:search```7. 更复杂的查询:-布尔查询:使用BooleanQuery对象构建更复杂的查询。

```javaBooleanQuery.Builder builder = new BooleanQuery.Builder();builder.add(new TermQuery(new Term("text", "Lucene")), BooleanClause.Occur.MUST); builder.add(new TermQuery(new Term("text", "search")), BooleanClause.Occur.MUST_NOT); Query query = builder.build();```这只是一些基本的例子,Lucene支持更复杂的查询和过滤器。

栏目编辑:梁丽雯 E-mail:liven_01@2017年·第12期57浅析Lucene在站内文本检索中的应用*■ 中国人民银行怀化市中心支行 黄宇栋随着站内文本日益增多,传统SQL模糊搜索方式遇到了较大挑战:一是搜索效率较为低下,经常引发数据库的全表搜索,性能难以满足访问高峰期的要求;二是难以应对复杂的搜索条件:传统SQL搜索方式一般基于单域、单个条件的模糊检索方式,多个字段检索以及复杂分词检索操作均要提前设计。

为改善SQL检索困境,开发人员可在站内搜索模块中引入Lucene全文检索引擎,解决文本检索需求多样化问题。

一、Lucene特点Lucene是一款全文检索引擎,提供了一套强大的查询机制以实现模糊查询、分词查询等功能,广泛应用在文本检索、网站信息搜索以及数据库检索等方面,其基本检索过程包括:数据来源识别及读取、建立索引、进行检索,其主要特点如下。

摘要:传统数据库在文本搜索方面存在范围小、性能不理想、难以应对需求变化等问题。

通过Lucene引擎设计站内文本搜索模块是解决上述问题的较好办法。

本文拟通过介绍Lucene搜索引擎主要特点、使用方式,探索解决站内文本搜索问题,并简要讨论了Lucene引擎近实时搜索(near-real-time)的解决方法。

关键词:Lucene;文本检索;近实时搜索作者简介: 黄宇栋(1982-),男,湖南邵阳人,工程师。

收稿日期: 2017-09-21*本文仅代表作者个人观点,不代表作者所在单位意见。

一是分析器模块替换灵活。

分析器模块能够完成数据来源或者数据检索条件的分词操作。

Lucene引擎中,索引、检索模块均使用了分析器。

开发人员不仅可以使用Lucene自带的标准分析器实现文本内容的分词处理,也可以使用中文分析器如SmartChineseAnalyzer 替换标准分析器,实现文本有效、灵活分词。

二是实现多域索引存储功能。

在Lucene体系中,Document类的角色类似于传统数据库中“行”,它能够保存Filed多域集合并统一添加到IndexWriter中,实现单条信息的多域索引存储功能,提高了搜索灵活性。

es lucene 语法

Lucene是一个开源的搜索和分析引擎,它使用一种基于词素的索引和搜索方法。

Lucene的语法主要基于正则表达式,但也有一些特定的语法和功能。

以下是一些常见的Lucene语法:

1.词素匹配:Lucene使用词素作为索引和搜索的基本单位。

默认情况下,Lucene会将文本分解成一系列的词素,并使用这些词素来构建索引和进行搜索。

要匹配一个完整的词素,可以使用双引号将该词素括起来,例如:“apple”。

2.通配符匹配:Lucene支持使用通配符进行模糊匹配。

例如,要匹配以“app”开头的任何词素,可以使用“app*”作为查询表达式。

3.范围查询:要匹配一定范围内的数值或日期,可以使用“[]”将范围括起来。

例如,[10 TO 20]将匹配所有介于10和20之间的数字。

4.布尔操作符:Lucene支持使用布尔操作符进行复杂的查询组合。

例如,要同时匹配“apple”和“orange”,可以使用AND操作符“AND”;要排除匹配“banana”,可以使用NOT操作符“-”。

5.字段匹配:要指定在特定字段上进行匹配,可以在查询表达式后面添加字段名称。

例如,title:apple将在标题字段

上匹配词素“apple”。

除了以上常见的Lucene语法外,还有许多其他的语法和功能可以使用。

要了解更多关于Lucene语法的信息,建议查阅Lucene的官方文档或相关教程。

elasticsearch 模糊查询大小写区分案例在现代信息时代,数据的快速检索和查询是至关重要的。

Elasticsearch作为一种强大的分布式搜索和分析引擎,为我们提供了一种高效的解决方案。

在实际应用中,我们经常需要进行模糊查询,并且需要区分大小写。

本文将介绍一些elasticsearch模糊查询大小写区分的案例。

首先,让我们了解一下elasticsearch的基本概念。

Elasticsearch是一个基于Lucene的开源搜索引擎,它提供了一个分布式的、多租户的全文搜索引擎。

它具有高可用性、可伸缩性和强大的查询语言,能够处理大规模的数据集。

在elasticsearch中,我们可以使用模糊查询来匹配包含特定模式的文档。

模糊查询是一种基于编辑距离的查询,它可以找到与给定查询字符串相似的文档。

而大小写区分则是指查询时是否区分字母的大小写。

接下来,让我们看一些elasticsearch模糊查询大小写区分的实际案例。

案例一:基本模糊查询假设我们有一个包含用户信息的索引,其中包含了用户的姓名字段。

我们希望查询所有姓名中包含"Smith"的用户。

为了实现模糊查询并区分大小写,我们可以使用如下的查询语句:GET /users/_search"query": {"match": {"name": {"query": "Smith","fuzziness": "AUTO"}}}}在上述查询中,我们使用了`match`查询,并将`fuzziness`参数设置为`AUTO`。

这将允许elasticsearch在匹配查询字符串时进行一定程度的模糊匹配。

案例二:自定义模糊查询有时候,我们可能需要自定义模糊查询的参数,以便更好地满足具体的需求。

例如,我们可能希望只允许一个字符的编辑距离,或者只允许前缀匹配。

java elasticsearch 模糊查询实例-回复Java Elasticsearch 模糊查询实例Elasticsearch 是一个基于Lucene 的开源搜索引擎,它提供了一个分布式、高效和可扩展的全文搜索和分析引擎。

与传统的数据库相比,Elasticsearch 允许我们进行更复杂和强大的查询操作,其中之一就是模糊查询。

在本文中,我们将介绍如何在Java 中使用Elasticsearch 进行模糊查询,并提供一个实例来说明其用法。

首先,我们需要确保已经安装了Elasticsearch 并运行在本地或远程服务器上。

可以从Elasticsearch 官方网站(Elasticsearch。

接下来,我们需要使用Maven 或Gradle 将Elasticsearch Java 客户端添加到我们的项目中。

在pom.xml(或build.gradle)文件中,添加以下依赖项:Maven:xml<dependency><groupId>org.elasticsearch.client</groupId><artifactId>elasticsearch-rest-high-level-client</artifactId><version>7.15.1</version></dependency>Gradle:groovyimplementation'org.elasticsearch.client:elasticsearch-rest-high-level-client:7.15.1'接下来,我们将创建一个包含Elasticsearch 模糊查询的Java 类。

首先,我们需要导入相应的类和包:javaimport org.elasticsearch.action.search.SearchRequest;import org.elasticsearch.action.search.SearchResponse;import org.elasticsearch.client.RestHighLevelClient;import org.elasticsearchmon.unit.Fuzziness;import org.elasticsearch.index.query.QueryBuilders;import org.elasticsearch.index.query.QueryStringQueryBuilder; import org.elasticsearch.index.query.RangeQueryBuilder;import org.elasticsearch.search.SearchHits;import org.elasticsearch.search.builder.SearchSourceBuilder;接下来,我们需要创建一个方法来执行模糊查询:javapublic class FuzzySearchExample {private static final String INDEX_NAME = "your_index_name";private static final String FIELD_NAME = "your_field_name";public static void main(String[] args) {try (RestHighLevelClient client = new RestHighLevelClient(/* your Elasticsearch configuration */)) {SearchRequest searchRequest = new SearchRequest(INDEX_NAME);SearchSourceBuilder searchSourceBuilder = new SearchSourceBuilder();QueryStringQueryBuilder fuzzyQuery = QueryBuilders.queryStringQuery("your_search_query").fuzziness(Fuzziness.AUTO).field(FIELD_NAME);searchSourceBuilder.query(fuzzyQuery);searchRequest.source(searchSourceBuilder);SearchResponse searchResponse =client.search(searchRequest);SearchHits hits = searchResponse.getHits();处理模糊查询结果...} catch (Exception e) {e.printStackTrace();}}}在上面的示例代码中,我们首先创建了一个`RestHighLevelClient` 实例,用于与Elasticsearch 进行通信。

es lucene查询语法【引言】随着互联网技术的不断发展,搜索引擎在各个领域发挥着越来越重要的作用。

在众多搜索引擎技术中,Apache Lucene脱颖而出,成为许多开发者首选的全文检索解决方案。

本文将为您介绍Lucene的查询语法,帮助您更好地掌握这一强大而又实用的技术。

【Lucene查询语法简介】Apache Lucene是一个开源的全文检索框架,它提供了丰富的查询语言来满足各种搜索需求。

Lucene的查询语法基于布尔代数,同时引入了丰富的修饰词和操作符,使得查询表达式更加灵活和强大。

【Lucene查询语法的基本语法】Lucene查询语法主要包括以下几个部分:1.查询关键字:用于匹配文档中的文本。

例如:“java”、“搜索引擎”等。

2.布尔操作符:AND、OR、NOT。

这些操作符用于组合多个查询关键字,实现更复杂的查询需求。

3.短语查询:使用双引号将多个关键字括起来,可精确匹配文档中完整的短语。

如:“人工智能机器学习”。

4.字段限定:使用圆括号指定查询的字段,如:“title:java”。

5.排序和分页:使用字段排序,如:“sort by id desc”。

【高级查询语法】Lucene还提供了许多高级查询语法,如:1.模糊查询:使用“~”符号进行模糊匹配,如:“java~”。

2.拼写检查:使用“^”符号表示忽略大小写的查询,如:“Java^”。

3.通配符查询:使用“*”符号进行通配符匹配,如:“java*”。

4.范围查询:使用“[]”符号表示范围,如:“1990[0]2020”。

5.全文本相似度查询:使用“fuzziness”参数,如:“java~5”。

【实战案例与应用】在实际项目中,我们可以结合Lucene的查询语法实现如下场景:1.实现多条件组合查询。

2.对文档进行分类和标签标注。

3.针对特定字段进行排序和筛选。

4.自动完成拼写检查和模糊查询。

5.实现分页和排序功能。

【总结】掌握Lucene查询语法,对于开发者来说具有重要意义。

电子设计工程Electronic Design Engineering第26卷Vol.26第1期No.12018年1月Jan.2018收稿日期:2016-11-05稿件编号:201611033基金项目:江苏科技大学海洋装备研究院自培育项目(HZ2016004)作者简介:钱柯(1992—),男,江苏无锡人,硕士研究生。

研究方向:智能信息处理。

随着互联网的发展,数据量呈现爆发式的发展,在海量数据中如何快速及时的查找到所需的信息已经成为一个重要问题。

现在很多的站内搜索都是基于Lucene 搜索引擎包完成的,包括目前流行企业级站内搜索所用的solr 检索服务器,其底层也是基于Lucene 。

而在一些商用领域,Lucene 也是作为其内部全文检索子系统的核心[1]。

目前,普通的全文检索在检索过程中往往只是对用户输入的查询语句进行简单的分词操作,然后将分词结果在索引库中逐一进行匹配,根据匹配出来的结果寻找到对应的文档,这样做的优点就是简单易操作,容易实现。

缺点也很明显,对于用户输入的内容,没有进行有效的简单判断而直接进行分词然后去索引库中查找,这样做往往会降低检索的精度,本文提出了一种简单可行的基于模糊查询的Lucene 检索,在原有的Lucene 检索基础上,对用户的检索内容进行简单的错字纠错,增加了检索的精度。

国内出现的比较早的自动校对系统是啄木鸟系统,自动纠错的方式是通过对文本进行分词,由于文本中绝大多数的错误是出在单字词上,根据单字词的词频和其前后两个汉字的持续强度给单字词打分,然后将得分与一个预先设定好的阈值比较来判断该单字词是否为错字。

马金山等人构建了一种多方法融合的中文自动校对模型,该模型以三元模型为基础,利用依存方法等特点分析文本中句子的依基于模糊匹配的Lucene 检索应用钱柯(江苏科技大学计算机科学与工程学院,江苏镇江214400)摘要:随着大数据时代的到来,越来越多的站内搜索要求能够快速精准的查找到需要的内容。

目前很多的站内搜索引擎是基于Lucene 检索包来实现的,流行的solr 检索服务器其底层也是基于Lu⁃cene 检索包。

然而普通的Lucene 检索无法实现对用户输入的查询语句进行简单的纠错处理,这使得检索不够智能化。

本文提出一种基于模糊匹配的Lucene 检索,它能够对用户输入的查询语句进行简单的纠错处理,返回所有可能的检索结果,这使得Lucene 检索能够更加精确及人性化,提高了检索的准确率。

关键词:站内检索;Lucene ;模糊匹配;纠错中图分类号:TP391文献标识码:A文章编号:1674-6236(2018)01-0052-04Lucene retrieval application based on fuzzy matchingQIAN Ke(Jiangsu University of Science and Technology Computer Science and Engineering Department ,Zhenjiang 214400,China )Abstract:With the development of big data ,more and more site-search need to search content quickly and exactly.now ,many site searches are based on lucene package ,The popular solr search server is also based on its underlying Lucene retrieval mon lucene search cannot solve user ’s inputting query in error correction processing ,it makes search not intelligent enough.This paper presents a fuzzy matching based Lucene retrieval which can perform simple error correction on the user input query and return all possible search results ,which makes the Lucene retrieval more precise and humanistic ,and improves the retrieval accuracy.Key words:search within the station ;Lucene ;fuzzy matching ;error correction存,提供了一种新的思路和方法来处理全局错误。

张仰森等人提出了一种基于规则和统计相结合的方法,根据统计分析大量正确文本后单字词出现的规律,提出新规则用来发现错误,并且结合了以单字散串建立的字二元、三元统计模型以及词性二元、三元统计模型,提出了文本自动查错模型与实现算法。

1Lucene简介与搭建1.1Lucene简介Lucene是Apache下软件基金会jakarta项目组的一个子项目,它是一个开放源代码的全文检索引擎工具包[9],原作者是DungCutting,曾经是V-Tim搜索引擎的开发者之一。

由于商业引擎不开源,搜索结果不是单纯的根据网页本身的价值进行排序,比如最大的中文搜索引擎百度,其搜索出来的网页是通过竞价来排名的,因此,为了能够为各种中小型应用程序提供全文检索功能,DuungCutting在自己的主页上发布了Lucene,2001年年底Lucene成为了Apache的一个子项目,目前DungCutting从事INTERNET底层架构的研究。

Lucene提供了完整的查询和索引功能,还提供了部分文本分析引擎,目前有很多Java项目都使用了Lucene作为其后台的全文检索引擎,比较著名的有web论坛系统图Jive,邮件列表HTML归档/浏览/查询系统Eyebrows,Java开发工具Eclipse等。

1.2构建索引Lucene采用的是反向索引机制。

在反向索引中,文档中的每个词或者短语对应着一个文档列表[10]。

Lucene索引的构建就是通过不同的解析器,对不同类型的文档进行解析,利用分词器(Analyer)对从解析结果中提取索引相关信息,组成若干的项(term)。

项(term)是最小的单位,项(term)组成域(field),若干个域组成文档(document),若干个(document)组成段(segment),Lucene的索引index就是由若干个段组成。

1.3搜索索引Lucene的检索是通过IndexSearcher类来完成的,IndexSearcher类必须要Query对象作为其传入参数[3]。

lucene提供了好几种不同的检索方式,如布尔查询(BooleanQuery),区间范围查询(RangeQuery),通配符查询(WildCardQuery)等等,用户通过构建所需的query对象,调用QueryParse类来实现Lucene内部查询语句,在索引库中查找到匹配的索引,根据索引值的信息,返回查询内容对应的文档位置。

1.4分词器的选择Lucene自带的分词器是ChineseAnalyer,这个分词器使用的是单字切分,单词切分会提高系统的召回率,降低准确率,比如“参加过世界杯”,如果用单词切分的话,搜索“过世”也可以命中该文档,显然这样不符合用户的需求。

Lucene支持第三方分词器,通过对比,我们选择IKAnalyer,IKAnalyer是一个开源的,基于Java语言开发的轻量级中文分词工具包。

它有很好的词典存储,更小的内存占用,采用了特有的“正向迭代最细粒度切分算法”,能够很好的支持中文语句的切分,而且IK分词器支持词典的扩充,使用者可以手动添加专有名词和停用词,IK分词器可以对使用者添加的专有名词不进行切词操作,过滤掉使用者添加的停用词。

2Lucene检索系统的实现2.1精确匹配算法普通的Lucene检索是基于精确匹配算法来实现的。

精确匹配算法思想如下:1)调用分词器对查询语句进行分词处理。

2)将分词后结果加入到查询条件query中去。

3)调用Lucene的查询语句在索引库中对搜索索引。

4)根据索引到的结果查询数据库,返回结果。

普通精确算法的不足之处就在于将查询语句分词后没做任何处理就加入到查询条件query中去,这样搜索的坏处在于搜索结果完全取决于分词结果,对分词器的选择依赖过大,因此我们可以对分完词的结果进行处理来优化匹配算法。

IK分词器会将所有可能的分词结果返回,这样会导致有些在索引时候匹配到某些不需要的索引。

例如,对于语句“我去世界杯看球赛”可能会分成“我\去世\界\杯\看\球赛”和“我\去\世界杯\看\球赛”,如果不对分词结果进行处理而是全部加入到查询条件中去,则会将含有“去世”的结果返回。

对此可采取的策略有两种:第一种是通过在IK analyzer的ext.dic 文件中手动加入专有名词,分词器就会选择将“世界杯”做为一个整体来切分。

第二种则是修改IK analyzer的分词算法,正向最大匹配中文分词算法可以做到最大匹配而不是第一次匹配就进行切分。

正向最大匹配算法的核心思想通过扫描分词文本,同钱柯基于模糊匹配的Lucene检索应用《电子设计工程》2018年第1期时与词表中的词进行,当扫描到的分词文本既是词表中的词并且也不是其他词的前缀,则匹配出来的就是最大文本。

具体算法流程本文不做详细介绍。

以上两种方法优化了精确匹配算法,能够提高匹配的精确度。

然而,对于用户输入的查询语句,如果其中存在错字,可能就会影响到分词情况,进而影响到检索结果,因此为了进一步提高检索的正确率,我们引入模糊匹配算法。

2.2模糊匹配模糊匹配是为了解决用户输入的查询语句可能存在的错字现象而引入的匹配算法。

Lucene 检索中5个性能指标:查全率、查准率、响应时间、死链比率、索引库更新频率。

其中查准率定义为搜索引擎检索结果中相关信息与检索结果的比[10]。

为了提高查准率,首要的就是提高检索中相关信息量,而用户输入的内容是否有错字对检索的查准率有着重要影响。

设w i 和w j 是两个汉字,因为两个汉字之间可能存在音似和行似,因此本文定义两个汉字之间的相似度函数:sim (w i ,w j )=ìíîïï如果w i =ϕ或w j =ϕ1如果w i =w j αpsim (w i ,w j )+βssim (w i ,w j )其他其中,psim 和ssim 分别表示分别表示两个汉字的音相似度和形相似度,α和β分别是参数,α+β=1。