一种结构化道路环境中的视觉导航系统

- 格式:pdf

- 大小:290.78 KB

- 文档页数:4

第22卷第4期 吉林大学学报(信息科学版) V ol.22 No.4 2004年7月 Journal of JilinUniversity (Information Science Edition ) July 2004 文章编号:1671-5896(2004)04-0415-05基于道路结构特征的自主车视觉导航邓剑文,安向京,贺汉根(国防科技大学机电工程与自动化学院自动化研究所,湖南长沙410073)摘要:基于计算机视觉技术的道路检测,针对红旗轿车自主驾驶系统的视觉导航,提出并实现了一种基于道路结构特征的自主车视觉导航方法。

该方法根据高速公路上道路标志线平行、等宽等特征,将车载摄像机获取的道路图像投影到道路平面上,再运用这些特征来提取标志线像素。

在此基础上根据公路道路模型,建立参数空间搜索最优参数,得到道路标志线的参数表达,实现视觉导航,并给出了C 市环城高速上的实验结果。

关键词:自主车;视觉导航;道路检测;透视投影变换中图分类号:T P 242.6 文献标识码:AA LV vision navigation based on road structure characteristicDENG Jian-wen,AN Xiang -jing ,HE Han-gen(Institute of Automation,M ech atron i cs and Automation School,National U niversity of Defense Technology,C hangsha 410073,China)Abstract :T he lane detection based on the computer vision technique is one of key problems of ALV (Autonomous Land Vehicle ),a novel lane detection system for ALV based on the road structure was developed.First the vision navigation sy stem maps the orig inal imag e to road plane.T hen it abstracts lane marking pixels exploiting the highway road marking line feature such as parallel,equal-w idth.The optimal curv e to guide the vehicle is searched in parameters space according to the highw ay road model.The ex periment result on highw ay around city C w as illustrated .Key words :autonom ous land vehicle;v ision navigation;lane detection;inverse perspective mapping 引 言自主驾驶汽车技术一直是智能交通系统研究的重点,在公路管理、交通运输等方面也有着广阔的图1 红旗自主轿车Fig.1Hongqi antonomous car 应用前景。

无人驾驶汽车院别:**学院专业:自动化学号:******** 姓名:*********摘要:无人驾驶汽车通过传感器装置和计算机来实现无人驾驶,这一技术正渐渐地在生活中的到应用,并在生活中发挥着巨大的作用,有着广泛的发展前景.2009年11月,在国外某社交网站上的一段视频,引起广泛关注。

视频的上传者本·蔡特林在美国旧金山和帕洛阿尔托之间的280号高速公路行驶时,发现旁边有一辆“怪异"的丰田普锐斯轿车,在它的车顶,装着一个类似于扰流板的装置,蔡特林最初以为这是用来测试风速的,其实这就是谷歌所研发的无人驾驶汽车系统,在当时,这还是一个秘密进行中的项目。

关键字:无人驾驶汽车,智能,传感器,导航,安全一、无人驾驶汽车概念什么是无人驾驶汽车?清华大学汽车系副研究员王建强将无人驾驶汽车定义为“通过车载传感系统感知道路环境,自动规划行车路线并控制车辆到达预定目标的智能汽车”。

同时它也可以称之为轮式移动机器人,其核心在于位于其内的计算机系统。

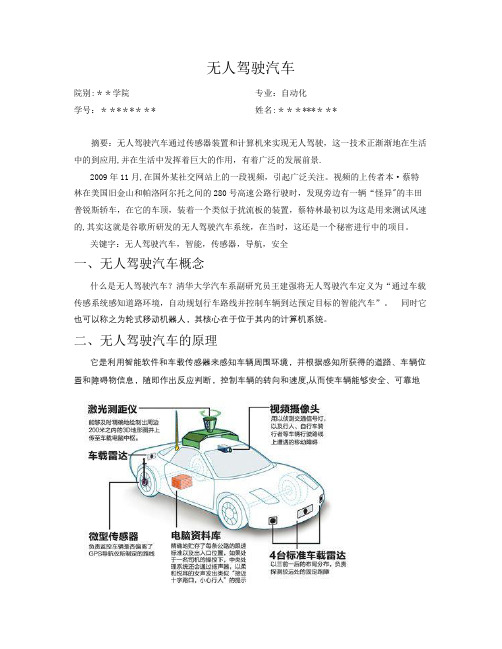

二、无人驾驶汽车的原理它是利用智能软件和车载传感器来感知车辆周围环境,并根据感知所获得的道路、车辆位置和障碍物信息,随即作出反应判断,控制车辆的转向和速度,从而使车辆能够安全、可靠地在道路上行驶。

比如,车体多个部位装有激光感应器,用于确定车身与障碍物的距离;有效地避开障碍物。

车载电脑可以经由后视镜附近的摄像头识别交通信号、交通标志并分析路况。

无人驾驶车的运动控制包括感知、动作、行为3个部分。

感知主要是通过车的“眼睛”认知周围环境,实现对环境的精确建模,如结构化环境中的车道线的检测、半结构环境中的边缘检测等;动作是指车的“大脑”在收到感知信息时作出的规划、控制与决策;而行为则是无人驾驶汽车在规划、控制与决策下产生的外在响应,体现了无人车的自主性能。

无人驾驶车是集视觉计算、模式识别和控制等众多技术于一体、具有人工智能功能的汽车。

它有车载麦克风、声波定位仪、红外线传感器、罗盘、激光扫描仪和微波雷达等多种传感器,这些装置相当于无人驾驶车辆的“眼耳”,用来感知车辆周围环境,并将感知所获得的道路、车辆位置、障碍物信息等,传输给无人驾驶车辆的“大脑”-—安装在车辆内部的高性能计算机进行分析和计算,以控制车辆的转向和速度,从而使车辆在遵守交通规则的前提下能够安全、可靠地在道路上自主行驶.当然,不同公司生产的无人驾驶汽车其原理都不太一样。

⼲货|⾃动驾驶14种功能解析⽬前有两个机构在对「⽆⼈驾驶技术」分级。

第⼀个是根据美国机动⼯程师协会(SAE)的定义,「⽆⼈驾驶技术」共分为 0-5 级。

下⾯的⼀张图,我们可以看出 SAE 对各个级别⾃动驾驶技术的定义。

SAE 的分类标准是按照司机从完全掌控驾驶到汽车完全⾃动驾驶,从⽆⾃动化到完全⾃动化展开的。

另⼀个是 NHTSa 的分级,「⽆⼈驾驶技术」共有 0-4 级。

借⽤上汽的⼀张图,我们可以使⽤两个维度来思考⽬前市场上所有的技术:⼀个是 TFC (见图左侧纵轴),即 Time For Collision,也就是汽车距离 (假设会) 发⽣碰撞需要的时间,和在发⽣碰撞前这⼀段时间的安全措施;另⼀个就是碰撞之后的安全措施,最简单的例⼦是安全带。

现在业界的研究⽅向是「主动安全」,也就是在 TFC 这个阶段。

根据 NHTSa 的定义,0-4 级分级是这样区别的:如果是驾驶员控制,那么为零级;如果⼀辆车在⾏驶中只有纵向或侧向某⼀⽅⾯控制,为⾃动⼀级。

如果同时具有纵向和侧向的⾃动控制,为⾃动⼆级。

在此基础上,如果汽车对所有环境的感知,是由汽车视觉来完成,则是三级。

在前三级的基础上,如果整个驾驶能够形成⼀个「闭环」,完全⾃动驾驶,则是四级。

⽆⼈驾驶技术的 14 个功能为了实现「⽆⼈驾驶」的理想,各⼤整车⼚和供应商⽬前正在开发「⾼级驾驶员辅助系统」(ADAS),随着 ADAS 慢慢被完善,车辆也在⼀步⼀步从 NHTSa 的 0 级过度到第 4 级,实现完全⾃动化。

.ADAS ⽬前已开发出 14 个功能:1、⾃适应巡航控制系统 Adaptive Cruise Control(ACC)⾃适应巡航控制系统是⼀种智能化的⾃动控制系统,它是在早已存在的巡航控制技术的基础上发展⽽来的。

在车辆⾏驶过程中,安装在车辆前部的车距传感器(雷达)持续扫描车辆前⽅道路,同时轮速传感器采集车速信号。

当与前车之间的距离过⼩时,ACC 控制单元可以通过与制动防抱死系统、发动机控制系统协调动作,使车轮适当制动,并使发动机的输出功率下降,以使车辆与前⽅车辆始终保持安全距离。

浅析道路工程与环境工程的协作关系摘要随着我国经济的快速发展,道路工程和环境工程都面临着巨大的压力,保持道路工程与环境工程的协作关系是首要条件。

通过分析我国目前的环境状况及存在的问题,进一步引出道路工程所面临的关键问题,提出了道路工程与环境工程可持续发展的有效结论,为我国工程的发展与生态的保护齐发展奠定基础。

关键词道路工程环境工程协作关系可持续发展道路工程是土木工程的一个分支,是从事道路规划、设计、勘测、施工和养护等的一门应用技术和科学。

道路工程包括道路网规划和路线勘测设计、路基工程、路面工程、道路给排水工程、桥涵工程、隧道工程、以及附属设施工程和养护工程,它涵盖的范围广,是一项综合性的建筑工程。

环境工程,是从事防治和研究环境污染,提高环境质量的技术,环境工程的核心就是环境污染的治理。

人类活动一开始就污染了环境,自然环境有一定的自净能力,只要污染没有超过环境的承载能力,环境仍可维持正常状态。

但是,随着科学技术和生产力的迅速发展,城市人口急剧增加,城市化的脚步加快,城市的基础设施工程例如建筑工程、道路工程等建设速度加快,城市的道路工程急剧增加,对环境的承载力产生一定的冲击,环境容量走在边缘地带,一旦城市建设继续突飞猛进的增长,极有可能突破环境容量的承载力,造成严重的环境污染进而引发一系列的次生灾害。

由此可见,保持道路工程与环境工程的协作关系,促使道路工程与环境工程协调增长,是当今城市建设亟待解决的问题和面临的挑战。

一、我国的环境问题环境是人类生存和发展的基础,它为人类提供了生存所必需的资源和条件。

随着经济社会的飞速发展,环境问题已作为一个迫在眉睫的重大问题提到了政府工作的日程上,保护环境,遏制生态恶化,阻止环境污染等成为政府管理工作的首要任务。

保护环境是我国的一项基本国策,解决环境问题,促进经济、社会与环境的可持续发展是我国政府的一项长期而又艰巨的任务。

国民经济的飞速发展引发了一系列的环境问题,目前我的大气污染、水环境污染、噪声污染严重,引起了土地荒漠化、水土流失、旱灾和水灾、生物多样性破坏、持久性有机污染以及气候变暖和极端天气的问题,经济的发展和资源的开发对环境造成了严重的破坏。

视觉导航及实验验证平台综述摘要:本文概述视觉导航技术。

视觉导航通过图像采集设备收集近距离的环境信息,并利用计算机视觉技术进行图像处理获得环境信息,实现导航。

首先比较了各种导航方式的优缺点,分析视觉导航的意义。

接着概述了视觉导航的应用领域和研究现状,然后分析比较了视觉导航中的一些关键技术,简单介绍了视觉导航领域的SLAM问题。

最后,综合国内外视觉导航技术研究存在问题,提出进一步研究方向和应用途径。

关键词:视觉导航;移动机器人;智能车辆;图像匹配;路径识别0 引言在当今世界的先进技术领域里,往往存在这样的问题:为了完成某种特殊的任务,需要在已知或者未知环境中,使特殊的能完成既定任务的实验设备或平台按照既定的且满足最优条件的路径运动或者到达既定目的地,这一类的问题便是导航。

对于一般的导航系统,在给定命令的前提下,结合环境中的各种探测信息,并根据自身位姿信息作出决策使运动体而到达目标,在运动过程中,还需要不断优化全局路径。

导航系统需要完成的任务包括以下三点:一,获取信息;二,处理信息;三,作出决策(即路径规划)。

目前广泛使用的导航方法有[1]:航标法,航位推算法,天文导航,惯性导航,无线电导航,卫星定位导航和组合导航等。

下文对各种导航方法对比说明。

航标法习惯称之为目视方法,它借助于信标和参照物对运动物体进行引导。

目前仍在应用,但是这种方法过于依赖经验,受天气、地理条件的影响。

航位推算法是通过一系列的速度增量来确定位置的,是一种自主导航方法,保密性强。

但是随着时间推移会产生误差积累。

天文导航是通过仪器设备对天体的位置精确测定,根据地理关系算出位置的相对导航方法,其缺点是误差积累受时间和气象条件限制,定位时间长,操作计算复杂[1]。

惯性导航通过加速度测量技术和积分技术的综合应用得到运动体的速度和位置信息。

这种导航技术完全依靠载体上的设备自主完成导航任务,因此隐蔽性好,不受外界条件限制。

但是加速度及精度和误差积累严重限制该方法的应用。

视觉导航技术综述唐超颖,杨忠,沈春林(南京航空航天大学自动化学院,江苏 南京 210016)摘要:概述了视觉导航技术。

视觉导航依据视觉图像,利用图像处理、计算机视觉、模型识别等相关技术获取运动体的运动信息和空间位置信息,实现导航。

首先,简单比较了各种常用的导航方式,分析了视觉导航的研究意义;其次,总结了目前视觉导航的应用领域及应用概况;接着,介绍了局部视觉和分布式组合视觉两种导航方式的含义及应用情况;然后,分析、比较了目前视觉导航研究中的一些关键技术;最后,综合国内外视觉导航技术研究的现状及存在的问题,提出了进一步研究的方向与途径。

关键词:视觉导航、移动机器人、智能车辆、三维重建、图像匹配、路径识别0 引 言导航是指运动体按照预先给定的任务命令,根据已知的地图信息做出全局路径规划,并在行进过程中,不断感知周围的局部环境信息,做出各种决策,随时调整自身的姿态与位置,引导自身安全行驶,直至目标位置。

导航系统要解决的问题包括:一、空间位置、方向、环境信息的检测;二、所获信息的分析、处理及综合;三、运动路径规划。

根据环境信息的完整程度、导航指示信号类型、导航地域等因素的不同,目前常见的导航方法有:惯性导航、电磁导航、卫星导航、激光导航、红外导航、无线电导航、视觉导航及各种方式的组合导航等。

惯性导航利用加速度计与陀螺仪计算航程,推知当前位置和下一步目的地,不易受外界环境的影响,是目前的主要导航方法,但随着航程的增长,定位误差将会不断累加,导致定位精度下降[1];电磁导航也称地下埋线导航,20世纪70年代迅速发展并广泛应用于柔性生产,其原理是在路径上连续埋设多条引导电缆,分别流过不同频率的电流,通过感应线圈对电流的检测来感知路径信息,该技术简单实用,但其成本高,改造和维护困难,且不适用于长距离导航[2];卫星导航利用卫星发射无线电波到地面接收器的时间来推算地面接收器所在的经纬度,其中GPS是目前真正实用的一种卫星导航和定位系统,但其技术为美国所垄断,我国也正在致力于这方面的研究;激光和红外线定位由于可以达到很高的精度,近年也被广泛应用于导航领域,但激光导航需要向外界发射能量,不易隐身,红外导航易受日光影响,一般用于夜间导航;无线电导航方式中,角度到达定位和信号强度定位的精度不高,只能提供粗略的位置信息,抵达时间定位可以达到很高的精度,但是电波以光速传播,要达到米级精度,时间粒度需要纳秒级以上,且易受空中各种无线电波的干扰[3]。

一种光电传感和路径记忆的智能车导航系统的实现一种光电传感和路径记忆的智能车导航系统的实现智能车的诞生为人类提供了一种全新的缓解城市交通拥堵、提高车辆安全性的交通工具。

在众多的智能车导航方案中,视觉导航由于与人类的驾驶方式最为接近,成为智能车研究热点之一。

目前,视觉导航方法在高速公路环境中已经获得了初步成功,这类环境结构化程度较高,道路曲率有限、路况相对简单。

然而,随着城市环境智能车研究的兴起,视觉导航面临了新的挑战。

城市环境中的道路不仅种类多,而且转弯半径大,常常会因视野有限而导致道路跟踪失败。

本文将从该智能车总体方案、路径识别方案选择、转向和驱动控制及路径记忆算法等方面进行介绍。

智能车总体方案智能车系统以飞思卡尔公司的MC68S912DP256为核心,由电源模块、传感器模块、直流电机驱动模块、转向电机控制模块、控制参数选择模块、单片机模块等组成,。

智能车系统工作电压由+1.6V、+5V、7.2V三个系统混合组成,其中7.2V用于给驱动电机和转向舵机供电,5V给车速传感器、MCU以及光电传感器接收管供电,1.6V给发光管供电。

为了在线控制参数的调整方便,还设置了一个控制参数选择模块,可以通过几个按键的设置,调用不同的程序或控制参数,以适应不同场地条件的要求。

图1智能车总体结构智能车的工作模式是:光电传感器探测赛道信息,转速传感器检测当前车速,电池电压监测电路检测电池电压,并将这些信息输入单片机进行处理。

通过控制算法对赛车发出控制命令,通过转向舵机和驱动电机对赛车的运动轨迹和速度进行实时控制。

路径识别方案选择与电路设计路径识别方案是首先需要确定的,主要有以下几个问题。

*光电识别还是摄像头识别;*传感器如何排列?间隔多大、形状如何、单排还是双排;*传感器可向前探测的远度;*传感器信号采用数字式还是模拟式;*电路上如何实现。

由于光电识别方案简单可靠,因此本文采用了光电识别方案。

数字式光电识别与模拟式光电识别光电式传感器是以光电器件作为转换元件的传感器。

![一种基于结构光的AGV视觉定位系统[发明专利]](https://img.taocdn.com/s1/m/5e5c4b040975f46526d3e1b7.png)

专利名称:一种基于结构光的AGV视觉定位系统专利类型:发明专利

发明人:胡晓兵,李航,向海,吴孟桦

申请号:CN201910785951.7

申请日:20190823

公开号:CN110398974A

公开日:

20191101

专利内容由知识产权出版社提供

摘要:本发明提供一种基于结构光的AGV视觉定位系统,包括AGV和轨迹,AGV上设置有图像采集模块、上位机和电机控制器,轨迹上设置有若干组结构光源;图像采集模块用于接收若干组结构光源的信号并传输至上位机;上位机用于与结构光源进行通信和分析采集的图像信息,从而确定当前AGV的位置和偏角信息;电机控制器用于接收上位机的指令并且控制AGV的运动方向和运动速度,结构光源发射相干光照射在AGV上,图像采集模块采集到照射的光斑图像并传输至上位机,上位机对采集的图像信息进行分析从而确定当前AGV的位置和偏角信息并传输至电机控制器,电机控制器根据接收的指令控制AGV的行驶,本系统精度高、成本低、路线设置灵活。

申请人:四川大学

地址:610000 四川省成都市一环路南一段24号

国籍:CN

代理机构:成都时誉知识产权代理事务所(普通合伙)

代理人:沈成金

更多信息请下载全文后查看。

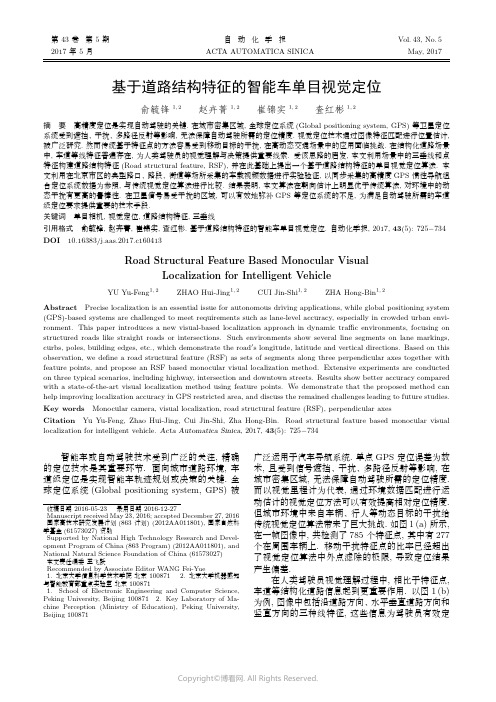

第43卷第5期自动化学报Vol.43,No.5 2017年5月ACTA AUTOMATICA SINICA May,2017基于道路结构特征的智能车单目视觉定位俞毓锋1,2赵卉菁1,2崔锦实1,2査红彬1,2摘要高精度定位是实现自动驾驶的关键.在城市密集区域,全球定位系统(Global positioning system,GPS)等卫星定位系统受到遮挡、干扰、多路径反射等影响,无法保障自动驾驶所需的定位精度.视觉定位技术通过图像特征匹配进行位置估计,被广泛研究.然而传统基于特征点的方法容易受到移动目标的干扰,在高动态交通场景中的应用面临挑战.在结构化道路场景中,车道等线特征普遍存在,为人类驾驶员的视觉理解与决策提供重要线索.受该思路的启发,本文利用场景中的三垂线和点特征构建道路结构特征(Road structural feature,RSF),并在此基础上提出一个基于道路结构特征的单目视觉定位算法.本文利用在北京市区的典型路口、路段、街道等场所采集的车载视频数据进行实验验证,以同步采集的高精度GPS惯性导航组合定位系统数据为参照,与传统视觉定位算法进行比较.结果表明,本文算法在朝向估计上明显优于传统算法,对环境中的动态干扰有更高的鲁棒性.在卫星信号易受干扰的区域,可以有效地弥补GPS等定位系统的不足,为满足自动驾驶所需的车道级定位要求提供重要的技术手段.关键词单目相机,视觉定位,道路结构特征,三垂线引用格式俞毓锋,赵卉菁,崔锦实,査红彬.基于道路结构特征的智能车单目视觉定位.自动化学报,2017,43(5):725−734 DOI10.16383/j.aas.2017.c160413Road Structural Feature Based Monocular VisualLocalization for Intelligent VehicleYU Yu-Feng1,2ZHAO Hui-Jing1,2CUI Jin-Shi1,2ZHA Hong-Bin1,2Abstract Precise localization is an essential issue for autonomous driving applications,while global positioning system (GPS)-based systems are challenged to meet requirements such as lane-level accuracy,especially in crowded urban envi-ronment.This paper introduces a new visual-based localization approach in dynamic traffic environments,focusing on structured roads like straight roads or intersections.Such environments show several line segments on lane markings, curbs,poles,building edges,etc.,which demonstrate the road s longitude,latitude and vertical directions.Based on this observation,we define a road structural feature(RSF)as sets of segments along three perpendicular axes together with feature points,and propose an RSF based monocular visual localization method.Extensive experiments are conducted on three typical scenarios,including highway,intersection and downtown streets.Results show better accuracy compared with a state-of-the-art visual localization method using feature points.We demonstrate that the proposed method can help improving localization accuracy in GPS restricted area,and discuss the remained challenges leading to future studies. Key words Monocular camera,visual localization,road structural feature(RSF),perpendicular axesCitation Yu Yu-Feng,Zhao Hui-Jing,Cui Jin-Shi,Zha Hong-Bin.Road structural feature based monocular visual localization for intelligent vehicle.Acta Automatica Sinica,2017,43(5):725−734智能车或自动驾驶技术受到广泛的关注,精确的定位技术是其重要环节.面向城市道路环境,车道级定位是实现智能车轨迹规划或决策的关键.全球定位系统(Global positioning system,GPS)被收稿日期2016-05-23录用日期2016-12-27Manuscript received May23,2016;accepted December27,2016国家高技术研究发展计划(863计划)(2012AA011801),国家自然科学基金(61573027)资助Supported by National High Technology Research and Devel-opment Program of China(863Program)(2012AA011801),and National Natural Science Foundation of China(61573027)本文责任编委王飞跃Recommended by Associate Editor WANG Fei-Yue1.北京大学信息科学技术学院北京1008712.北京大学机器感知与智能教育部重点实验室北京1008711.School of Electronic Engineering and Computer Science, Peking University,Beijing1008712.Key Laboratory of Ma-chine Perception(Ministry of Education),Peking University, Beijing100871广泛运用于汽车导航系统.单点GPS定位误差为数米,且受到信号遮挡、干扰、多路径反射等影响,在城市密集区域,无法保障自动驾驶所需的定位精度.而以视觉里程计为代表,通过环境数据匹配进行运动估计的视觉定位方法可以有效提高相对定位精度.但城市环境中来自车辆、行人等动态目标的干扰给传统视觉定位算法带来了巨大挑战.如图1(a)所示,在一帧图像中,共检测了785个特征点,其中有277个在周围车辆上.移动干扰特征点的比率已经超出了视觉定位算法中外点滤除的极限,导致定位结果产生偏差.在人类驾驶员视觉理解过程中,相比于特征点,车道等结构化道路信息起到更重要作用.以图1(b)为例,图像中包括沿道路方向、水平垂直道路方向和竖直方向的三种线特征,这些信息为驾驶员有效定726自动化学报43卷位自身车辆与道路的关系提供重要线索.受该思路启发,本文提出一个基于道路结构特征(Road struc-tural feature,RSF)的智能车单目视觉定位算法,用于解决高动态结构化道路环境下的定位问题.本文结合场景中的三垂线和点特征,定义道路结构特征,并在此基础上建立定位算法,包括道路结构预测、特征提取和车辆运动估计.本文利用安装在智能车平台上的摄像头在北京市区的路口、拥堵路段、密集街道等典型复杂场景进行数据采集,对本文提出的算法进行实验分析,以同步采集的高精度GPS惯性导航组合定位系统(GPS/惯导)数据为参照,与传统视觉定位算法进行比较,验证本文算法的有效性.图1单帧图像的点特征和线特征Fig.1Point feature and Line feature ofone on-road image本文结构如下:第1节围绕近年来国内外视觉定位的前沿研究,分析其在大范围高动态交通场景应用中所面临的关键难点;第2节给出道路结构特征的定义,并概述基于道路结构特征的定位算法;第3节详细描述定位算法中的细节;第4节给出实验结果,并与高精度GPS/惯导和传统视觉定位方法作比较;第5节总结本文算法并给出今后的研究展望.1相关研究基于视觉的定位算法被广泛用于智能车定位系统,视觉里程计(Visual odometry)[1]是其中最重要的领域之一.视觉里程计利用单个或者多个相机的输入信息,通过前后帧特征匹配,估计本体的运动.有关视觉里程计的研究最早可以追溯到1980年.当时,Moravec等[2]利用一个可滑动相机获取视觉信息,并以此作为输入,完成了机器人的室内导航. 1987年,Matthies等[3]提出了利用视觉做定位的概念,设计了包含特征提取、特征匹配与跟踪、运动估计的理论框架.2004年,Nist´e r等[4]首次明确了视觉里程计这一概念,并在2006年详细描述了视觉里程计系统[5].他们设计了一种实时的视觉里程计系统,真正意义上实现了机器人室外运动导航,同时提出了两类视觉里程计的实现途径和流程,即单目视觉和立体视觉的方法,之后的研究大多在此基础上进行改进.通用的视觉里程计以特征点匹配为基础,定位结果受到累计误差和移动物体干扰两方面因素的影响.针对累计误差,光束平差法(Bundle adjust-ment)[6]是一个常用的处理方法,通过最小化三维特征点在不同图像上的重投影误差,同时优化三维特征点和相机位置,提高了定位精度,但计算代价较高.为降低时间复杂度,Mouragnon等[7]使用局部光束平差法,在处理累计误差和计算代价上做了一个平衡.针对移动物体的干扰,传统的方法将移动物体上的特征点当作噪声,利用随机采样一致性方法(Random sample consensus,RANSAC)[8]来滤除噪声,但这只能处理少量干扰问题.Ozden 等[9]建立了一个多模型的定位与场景重建方法,将视频中的特征点进行聚类,提取移动物体,去除干扰.Kundu等[10]将光束平差法与多模型方法结合,有效提高了定位精度,但在移动物体较多的环境下,有效性受到制约.近几年的视觉里程计的研究将定位和建图结合起来,建立视觉SLAM方法,例如lsd-SLAM[11]、Orb-SLAM[12]等.此类方法有效减少了累计误差,但由于需要在定位的同时重建三维场景,导致高动态环境下移动物体的干扰增加.另一类视觉定位算法则采用与地图匹配的方式进行定位.Geiger等[13]利用视觉里程计生成的轨迹和二维地图上的道路进行形状比对,确定车辆实际位置.算法可定位到所处道路,但无法到达车道级精度.Ramalingam等[14−15]直接利用城市的三维模型,将图像中的特征点和线投影到三维模型中,直接获取对应的三维位置,避免了三维重建过程中的误差.算法提高了定位精度,但目前三维模型的可获取性不够广泛,算法的局限性高.另一些研究者则采用智能车预先建立地图进行定位.Achar等[16]利用词袋(Bag-of-words)的方法,在需要定位的街道上预先行驶若干圈采集数据,生成特征地图,在线定位时,将图像特征点和数据库中特征点进行匹配并定位.Ziegler等[17]同时建立了道路的几何地图与特征点云地图,提高了在线匹配的精度.该智能车完成了103千米的自动驾驶,但地图建立存在大量手工操作,人力和时间成本高.传统的视觉定位算法使用特征点进行定位,在高动态交通场景中,特征点易受移动车辆的干扰,导致定位结果出现偏差.Geiger等[18]将图像特征投影到路面上,利用标志线的角点对定位进行优化,适5期俞毓锋等:基于道路结构特征的智能车单目视觉定位727用于低动态场景,但无法处理拥堵环境.考虑到道路场景中线特征的朝向特殊性,Zhang 等[19]利用室外的垂直线特征进行定位,将原三维定位问题转换为二维定位问题,降低了复杂度,但垂直线特征不通用,局限性大.Barinova 等[20−21]则将线段进行聚类,并检测消失点,利用消失点之间的几何约束确定三垂线.该算法只在部分图片中进行测试,缺乏有效性验证,且计算代价高.本文对三垂线的检测进行优化,并将其用于结构化道路场景定位算法,极大地提高了定位估计的朝向稳定性.2系统概述本文提出的定位算法框架如图2所示.以下首先给出道路结构特征的定义,在此基础上简述算法的主要步骤,包含道路结构的预测、道路结构特征提取和基于道路结构特征的位置估计.图2算法框架Fig.2System outline2.1道路结构特征定义道路结构特征是一组带有语意信息,描述典型结构化道路场景特征的基本元素集合.在本研究中,道路结构特征由图像中对应于道路行进方向、水平垂直道路方向和竖直方向的三组线特征L 1,L 2,L 3,以及点特征P 构成,即Z RSF :{L 1,L 2,L 3,P }.其中线特征L 1,L 2,L 3在道路坐标系下相互垂直,在本文中简称三垂线.2.2道路结构预测随着定位服务(Location based services,LBS)技术的发展,地图作为数据基础被广泛建立,部分已开放使用(例如OpenStreetMap).这些地图中包含道路中心线、路口节点等信息,为预测局部道路结构提供依据.如图3所示,对于直道场景,根据智能车当前的定位信息和相机标定参数,可在地图中确定相机的可视区域,结合地图中道路中心线信息,建立局部道路坐标系.利用车辆位置以及相机参数等信息,将局部道路坐标系映射到图像中,预测对应于道路行进方向、水平垂直道路方向和竖直方向的三组线特征L 1,L 2,L 3的方向.对于路口场景,根据地图中道路中心线,将相机可视区域分割为一系列小区域,每个小区域都根据道路中心线定义自身的道路局部坐标系,再映射到图像中,将图像分为相应的区域,并在每个区域中预测对应的三组线特征方向.图3道路局部三垂线结构预测,包含直道和路口两种情况Fig.3Map-based RSF prediction,includingstraightway and intersection2.3道路结构特征提取道路结构特征的提取以线段检测算法和特征点检测算法为基础,实时检测图像中的线段和特征点,构建道路结构特征.对于线特征,定义线和道路坐标系三方向的距离函数,以此将图像中的线段进行分类.通常情况下,路面上的车道线、道路边界、车辆侧面的线段等会被分成第一类L 1;路面上的停止线、车辆后侧的横向线段、路牌上的横向线段会被分成第二类L 2;路灯、路边建筑物、大型车辆等的竖直方向线段会被分为第三类L 3.对于点特征,直接根据通用特征点检测结果,生成特征点集合P .2.4基于道路结构特征的位置估计车辆的位置估计采用随机采样一致性方法(RANSAC).在检测到所有道路结构特征Z RSF 后,基于随机采样构建样本集合{C iRSF }.一个有效的采样C RSF 包含三条线段和两个点.其中三条线段中728自动化学报43卷两条相互平行,并且垂直于第三条.C RSF ={l 1,l 2∈L u ,l 3∈L v ,u =v,p 1,p 2∈P }(1)图4所示为当u =1,v =3的一个样例.l 1和l 2为沿道路方向上的线段,l 3为竖直方向上的线段,p 1和p 2为图像中任意两个特征点.在利用采样C RSF 进行位置姿态x 求解的过程中,使用其中的线特征求解旋转,再使用点特征估计平移,平移尺度的估计则使用车速信息累计求解.位置姿态求解结果使用后验概率p (Z RSF |x i k )p (x ik |x k −1)进行评价.其中p (Z RSF |x i k )为观测模型,p (x ik |x k −1)为车辆运动模型.通过一定次数的随机采样C RSF (本文实验中采样次数为200),最优位置估计结果ˆx k 通过最大化后验概率求得.ˆx k =arg max x i k ∼C iRSF{p (Z RSF |x i k )p (x ik |x k −1)}(2)图4道路结构特征采样样例,包含三条线段和两个特征点Fig.4Sample of RSF candidate,including three linesegments and two points3算法细节3.1坐标系定义车体与相机的坐标系定义如图5所示.定义x v={R v ,s v }为车体在世界坐标系下的位置姿态.其中,R v 为旋转矩阵,s v 为平移向量.车体坐标系定义为右手系准则,其中原点位于车辆后轴中心,x ,y ,z 的方向分别为车辆右侧,前方和上方.相机固定在车顶前侧上方,定义x c ={R c ,s c }为相机的在世界坐标系下的位置姿态.相机坐标系定义为右手系准侧,其中原点为相机中心,x ,y ,z 的方向分别为相机右侧、下方和前方.相机和车体的刚性固定,车体坐标系到图像映射P vc =K [R vc |s vc ]可通过标定得到.其中K 为相机内参数,R vc 和s vc 分别为外参数中的旋转矩阵和平移向量,即车体在相机坐标系下的旋转矩阵和平移向量.图5车体与相机的坐标系定义Fig.5Coordinate frames of the vehicle and the camera3.2道路结构预测定义e 1=(1,0,0)T ,e 2=(0,1,0)T ,e 3=(0,0,1)T 为x ,y ,z 方向的单位向量,车体在世界坐标系下的三个方向可表示为d x d y d z =R ve 1e 2e 3(3)其中,d y =R v e 2为车体朝向.定义{R v,k ,s v,k }为车体在k 时刻的位置姿态,{ˆR v,k ,ˆs v,k }为对应时刻的预测结果.假设车体的运动在朝向上变化均匀,则车辆在k 时刻的旋转矩阵可以通过前一帧的旋转矩阵和前两帧之间的相对旋转求解ˆR v,k =R rel R v,k −1= R v,k −1R T v,k −2 R v,k −1(4)平移的预测则将车辆在两帧间的位移进行求和.在较短的时间内,位移方向近似为前后帧车辆朝向的角平分线的方向,即ˆs v,k ≈s v,k −1+d y,k −1+ˆdy,k 2 t kt k −1v t d t (5)其中,d y,k −1为车体k −1时刻的朝向,ˆdy,k 为车体k 时刻朝向预测结果,v 为车速.相机在k 时刻的位置姿态{R c ,s c }通过车体的位置姿态预测结果和标定参数进行求解.ˆRc,k =ˆR v,k R cv (6)ˆs c,k =ˆs v,k +ˆRv,k s cv (7)世界坐标系下到相机的投影矩阵的预测为ˆP c =K [ˆR T c,k |−ˆR T c,k ˆs c,k ](8)车体和相机的位置预测完成后,道路结构通过相机的投影矩阵变换到图像坐标系下,如图3所示.对于直道环境,只有一条道路线被投影到图像中,生成一个局部道路坐标系;对于路口环境,多条道路线被投影到图像中,将图像分割成不同区域,每个区域包含一个局部道路坐标系;对于弯道环境,用多段线段拟合弯道,再将其投影到图像中,与路口环境类似.对于每一个区域,道路坐标系对应三个朝5期俞毓锋等:基于道路结构特征的智能车单目视觉定位729向d j(j=1,2,3),分别为道路行进方向、水平垂直道路方向和竖直方向.虽然对于二维地图,道路朝向只有一个自由度,但为了系统的统一,以及今后有三维道路地图后算法的可扩展性,使用旋转矩阵R r=[d1d2d3]来描述道路朝向.3.3道路结构特征提取道路结构特征RSF定义为{L1,L2,L3,P},即三垂线和特征点的集合.道路结构特征的提取中最重要的部分为从图像基础特征(线段和点)中建立道路结构特征.对于特征点,直接使用通用特征点检测跟踪结果;对于三垂线特征,利用预测的道路结构,将通用线段特征依照朝向进行分类,关键点在于定义图像线段和道路坐标系三方向的距离函数.图像上的任意线段l i转换到相机坐标系下,构成一个过相机中心的平面πl i=[l T i K0]T,其法线方向为n i=K T l iK T l i(9)定义线段l i到道路方向R r e j的距离函数为线段对应平面法线n i和道路方向R r e j夹角余弦值的平方,即d2(l i,R r e j)=n TiR TcR r e j2=l TiKR TcR r e jK T l i2(10)对于任意线段l i,计算它和局部坐标系下三方向的距离,将其归类为距离最近的方向,并将其朝向记录为d i.当最小距离大于给定阈值 时,该线段则被当作噪声滤除.3.4车体位置姿态估计给定一个道路结构特征的采样C RSF,如式(1)所示.其中l1,l2∈L u为图像上的两条线段,对应两条在道路坐标系下的平行线;l3∈L v为第三条线段,在道路坐标系下垂直于前两条线段.p1,p2∈P 为两个特征点.令ˆd1,ˆd2,ˆd3为三垂线特征l1,l2,l3的朝向估计结果,p1和p2为当前帧检测到的特征点,p 1和p 2为前一帧的跟踪结果.3.4.1旋转矩阵求解根据线特征和对应朝向的距离定义,有l T1KRˆd1=0(11)l T2KRˆd2=0(12)l T3KRˆd3=0(13)从特征采样C RSF中已知l1和l2在道路坐标系下的朝向一致,即ˆd1=ˆd2,则l1和l2在图像上的交点对应于该朝向的消失点,即v1=l1×l2=λKRˆd1(14)根据罗德里格斯矩阵,旋转矩阵可改写为R=(I−S)−1(I+S)(15)S=0−c−bc0−ab a0(16)将式(15)代入式(14)中,可得(I−S)K−1(l1×l2)=λ(I+S)ˆd1(17)结合式(16)和式(17),共有4个参数a,b,c,λ需要求解.式(17)和式(13)共给出4个约束方程,通过联立方程组可求解这4个参数.在求解过程中,最多产生两组可行解,这两组可行解对应l3的方向相反.通过和预测的旋转矩阵ˆR c做比较,可滤除错误解,留下唯一可行解.3.4.2平移向量求解在世界坐标系下,令当前帧相机的投影矩阵为P=K[R|t],前一帧相机的投影矩阵为P = K[R |t ],则相机的相对旋转和平移为R rel=RR T(18)t rel=t−R Trelt (19)根据对极几何约束可得p T F p =0(20)其中,F=K−T[t rel]×R rel K−1(21)由于旋转矩阵已知,式(20)中待求解的只有平移向量t rel,共三个自由度.使用两个特征点,即可通过式(20)求解出归一化的平移向量,尺度因子 t rel 则需要通过其他方式求解.在本文实验中,尺度因子通过车轮编码器所获取的车速信息求解.相对位移求解完成后,通过式(19)求解当前相机的绝对位置,再利用标定参数,得到车体的绝对位置. 3.4.3后验概率估计每一个采样C RSF都可求解出相应的旋转矩阵和平移向量.由于采样的随机性,需要多次采样来得到最优解.而最优解的估计可以通过最大化后验概率p(Z RSF|x i k)p(x i k|x k−1)得到.其中,p(x i k|x k−1)为运动模型,通过车辆的基础运动模型加上高斯噪声求解;p(Z RSF|x i k)为观测模型,需要定义观测值与真值的误差函数来求解.本文误差函数定义为线特征与点特征的误差加权和,即E=E l+λE p(22)730自动化学报43卷对于三垂线特征,误差定义为线段长度的平方乘以它到对应道路朝向的距离,即E l=ilen2(l i)×d2(l i,ˆd i)(23)其中,len(l i)是线段l i的长度,d2(l i,ˆd i)是线段和对应道路朝向的距离,即d2(l i,ˆd i)=l TiKR TcˆdiK T l i2(24)对于点特征,误差定义为点到对应对极线距离的平方,即E p=id2(p,F p )+d2(p ,F T p)(25)其中,距离d(p,F p )是点p到对极线F p 的距离.3.5鲁棒性优化道路结构特征的采样C RSF需要包含三条线段和两个特征点,其中三条线段l1,l2,l3需要满足d1 =d2,d1×d3=0.因此,算法需要检测至少两个主方向上的线段.对于空旷环境,即移动车辆、路灯、建筑物较少的情况,水平垂直道路方向和竖直方向上的线特征均较少,只有道路行进方向的线特征可被稳定检测.在这种情况下,假设路面平整,车辆颠簸不明显,车辆运动只包含三个自由度(x,y, yaw),对应旋转矩阵R退化为一个自由度.利用公式l T1KRd1=0,通过一条线段求解旋转矩阵.同理,当仅能检测到其他两个主方向上的线段时,也将车辆运动退化为二维运动求解.此外,当无法检测到有效数目的主方向线段时,则根据通用的特征点定位算法求解.算法根据当前帧图像所能检测到的三垂线数目动态切换.4实验与分析4.1概述本文利用如图5所示的智能车平台,在北京市区的路口、拥堵路段、密集街道等典型复杂场景进行数据采集和算法验证1.实验中利用PointGray公司的Flea2相机采集图像序列,图像分辨率为640像素×480像素,关键帧采样帧率为3Hz;利用车轮编码器采集车速信息,用于平移尺度的求解.为了对算法的精度进行比较验证,实验中使用一台拥有光纤陀螺的GPS惯性导航组合定位系统对车辆位置方向进行高精度测量.实验中使用线段检测工具包(Line segment de-tector,LSD)[22]进行图像线段检测,参考文献[23]中的算法进行图像特征点检测跟踪.本文算法的实验结果与目前被广泛使用的单目视觉里程计算法libviso2[13]、最新发表的Orb-SLAM算法[12]以及高精度GPS/惯导进行比较.以下分别对路口、拥堵路段和密集街道等三种典型场景的实验结果进行展示,最后给出分析讨论.在路口和拥堵路段场景, Orb-SLAM在初始化时特征点集中于前方移动车辆上,导致定位失败.在密集街道场景中,移动车辆少, Orb-SLAM结果较为稳定.因此本文仅在密集街道场景中加入与Orb-SLAM定位结果的比较.4.2案例分析4.2.1路口实验路口实验场景起始点坐标为(39.9754760, 116.3911050),行驶距离约为600米,时间约为2分钟,采集了共350帧关键帧,车辆行驶过程中包括两次右换道、一次右转和一次靠右并入辅路等驾驶行为,如图6所示.图6路口实验场景与定位结果Fig.6The scenario and localization results ofintersection environment图6中点虚线、虚线和实线分别为本文算法、libviso2和GPS/IMU的定位结果.如图6中B区域所示,在本次实验终点处,虽然实验车沿直线行驶进入辅路,然而由于周边树木建筑物密集,卫星信号受到干扰,GPS定位结果有明显偏移.在B区域以外的其他区域中,卫星信号条件良好,GPS定位有较高的精度,因此本文利用B区域以外的GPS数据作为参照,定量化验证本算法的定位精度,并与libviso2的结果进行比较.实验中,libviso2的结果在车辆右转过程中产生明显偏差,如图6中A区域所示,而本文算法表现良好,轨迹和GPS接近.图7展示了算法对车辆朝向的估计结果.本文算法与GPS/IMU的结果非常接近,而libviso2的结果却存在明显偏差.虽然偏差只有5度,但由此引起的位置偏差非常大,在进入B区域前与GPS相比有1实验相关视频已上传至优酷:/v show/id XMTU4MDIzOTM5Mg==.html?from=y1.7-1.25期俞毓锋等:基于道路结构特征的智能车单目视觉定位731约15米的误差.说明在定位中,朝向的估计精度有着重要的影响,而实验结果表明本文算法在朝向估计上精度明显高于libviso2.需要说明的是,本文算法在朝向结算上只使用了当前帧的信息,导致结果存在局部噪声,呈现轻微锯齿状.这个现象可以通过今后引入前后帧跟踪予以缓解.图7路口场景朝向计算结果Fig.7Yaw results in intersection environment为了使结果更加直观,将图像中的沿道路线方向的线段结合定位结果投影到地平面上,得到如图8所示结果.通过投影结果,可以较清晰地看到斑马线、道路标线、道路边界等信息.结合车体运动轨迹,可以检测出一些高层的运动信息,例如车辆换道等.图8线特征鸟瞰投影结果Fig.8Projected line segments on bird eye view4.2.2拥堵路段拥堵路段实验场景在四环主路,车流量大,行驶速度缓慢,道路笔直,多处有过街天桥.车辆由北向南行驶,起始点坐标为(39.9544800,116.3031370),行驶时间约为2分30秒,全长约1800米,共采集450帧关键帧,期间做了若干次换道.实验中未使用地图信息,而利用前一帧的处理结果,推测当前帧道路结构.实验结果如图9所示,其中点虚线、虚线和实线轨迹分别表示本文算法、libviso2和GPS/IMU 的结果.libviso2的结果在第22帧和第229帧附近有两处较大偏差(如图9中A 区域和B 区域所示),原因是一辆环境车占据了图像中很大区域,且进行换道,即包含相对于车道的横向运动.图像中该车上的特征点为实验车的运动估计带来干扰,特别是在朝向求解上(如图10所示).另外,实验路线中多处经过过街天桥.这些天桥对卫星信号造成遮挡或干扰,使得经过天桥时,GPS 定位结果出现很大偏差.如图9中C 区域所示,GPS 轨迹呈现约10米的偏差.相比之下,本文算法的结果在朝向及位置估计上均稳定可靠,结果优于GPS 和libviso2.图9拥堵路段中的定位结果Fig.9Localization results in high trafficenvironment图10拥堵路段中的朝向计算结果Fig.10Yaw results in high traffic environment4.2.3密集街道密集街道场景在北京上地信息路附近区域.车辆行驶了约6分30秒,全长约2000米,采集了3800帧视频数据,期间做了若干次换道和左右转弯.定位结果如图11所示,其中点虚线、点线和虚线,实线轨迹分别表示本文算法、Orb-SLAM 、libviso2和GPS/IMU 的结果.由于Orb-SLAM 算法存在平移尺度漂移,为了更好地比较结果,利用车速信息将平移尺度修正.图11所示结果中,libviso2的结果在几次转弯后出现明显偏差,而本文算法和Orb-SLAM 误差相对较小.以GPS 值作为参考值计算误差,本文算法精度高于Orb-SLAM (数值对比结果见表1).在本场景中,部分区域没有车道线信息,且由于路边停放的车辆,道路边沿被遮挡,道路结。

基于无人车自动构图导航系统的设计与实现

无人车自动构图导航系统是一种通过激光雷达和视觉传感器等设备,实时获取环境信息并对其进行处理和分析的系统,以实现无人车在未知环境中的构图和导航。

该系统主要包括环境感知模块、构图模块和导航模块三个部分。

环境感知模块是整个系统的核心部分,其主要功能是实时获取车辆周围的环境信息。

激光雷达是其中最关键的传感器,通过扫描周围环境,获取地面、墙壁、障碍物等物体的位置和形状信息。

视觉传感器则可以用于检测交通信号灯、行人等动态物体。

通过这些传感器获取的信息,可以进行环境地图的构建和实时更新。

构图模块是根据环境感知模块获取的信息,对周围环境进行构图的模块。

在构图模块中,可以利用激光雷达获取的地图数据进行点云处理,提取关键特征点,并根据这些特征点生成地图。

还可以将获得的地图信息与先验地图进行融合,实现地图的增量更新。

导航模块是根据构建好的地图,实现无人车的自主导航的模块。

在导航模块中,可以利用地图和传感器信息,进行路径规划和路径跟踪。

路径规划是根据起点和终点,通过搜索算法确定最优路径的过程。

路径跟踪是根据当前车辆的位置和姿态信息,实时调整车辆的运动控制,使其按照规划的路径进行行驶。

在系统的实现中,还需要考虑到系统的稳定性和可靠性。

为了保证系统的稳定性,可以采用冗余设计和容错机制,使得系统在部分传感器失效或环境发生变化时,仍能正常运行。

还可以通过实时监测系统的状态和性能,对系统进行自适应调整和优化,保证系统的可靠性。

基于踢脚线的结构化环境单目视觉导航

刘菁;王忠民;曾彦淞;王晨

【期刊名称】《西安邮电学院学报》

【年(卷),期】2012(017)001

【摘要】针对室内结构化环境下的导航任务,提出一种以踢脚线为参考直线的基于单目视觉的导航算法。

利用单目摄像头提取图像,运用Canny边缘检测方法和霍夫变换相结合的边缘检测算法提取结构化环境中的踢脚线,根据平行直线在图像平面的成像原理,提取出参考直线和偏航角作为导航信息,实时控制小车的运动。

试验结果显示,基于该方法设计的小车可以实现安全行驶,该方法获取的导航参数受光照的影响不大,稳定可靠,能满足安全性和实时性的要求。

【总页数】4页(P75-78)

【作者】刘菁;王忠民;曾彦淞;王晨

【作者单位】西安邮电学院计算机学院,陕西西安710121;西安邮电学院计算机学院,陕西西安710121;西安邮电学院计算机学院,陕西西安710121;西安邮电学院计算机学院,陕西西安710121

【正文语种】中文

【中图分类】TP242.6

【相关文献】

1.基于单目视觉的非结构化道路检测与跟踪 [J], 王燕清;陈德运;石朝侠

2.未知环境下移动机器人单目视觉导航算法 [J], 战强;吴佳

3.基于低分辨率单目视觉的非结构化道路检测算法 [J], 卢瑜

4.基于单目视觉的结构化道路检测算法研究 [J], 焦欣欣;王民慧;李晓鹏

5.基于单目视觉的农业机器人导航系统研究 [J], 赵荣阳;吴桂云;梁家海;王青青;姜重然;王斌

因版权原因,仅展示原文概要,查看原文内容请购买。

基于FSMC的结构化道路视觉导引系统曲仕茹;张明;李超然【期刊名称】《计算机测量与控制》【年(卷),期】2014(22)1【摘要】针对结构化道路特征提出一种道路边沿检测和模糊推理相结合的视觉引导算法,结合外部设备和基于 ARMCortex-M4核心的 MK60芯片,实现了一套简单的视觉导航移动平台;在该设备上进行实验表明,本系统能够实时获取道路边界及相应的虚拟导引线,模糊推理机判断路况的准确率为93%以上,行驶过程中的归一化偏差在0.2m 以内,根据模糊推理结合模糊滑模控制能够使该移动平台在合理路径上稳定行驶。

%Combining the algorithm for the road edge detection and fuzzy reasoning,with external devices and system based on MK60 chip ARM Cortex-M4core,achieve a simple visual navigation of mobile platform.Experimental results on the device told that the system can obtain real-time road boundary and the corresponding virtual guide wire,and according to fuzzy inference control of the mobile platform in the reasonable path stability.【总页数】4页(P184-187)【作者】曲仕茹;张明;李超然【作者单位】西北工业大学自动化学院,西安710072;西北工业大学自动化学院,西安 710072;西北工业大学自动化学院,西安 710072【正文语种】中文【中图分类】TP242.6【相关文献】1.一种结构化道路环境中的视觉导航系统 [J], 李欣;李宏东;顾伟康;李庆中2.基于单目视觉的非结构化道路检测与跟踪 [J], 王燕清;陈德运;石朝侠3.基于交叉视觉皮质模型的非结构化道路检测算法 [J], 高庆吉;张磊4.关于视觉的AGV道路识别和导引系统设计研究 [J], 张宏玉;张桥5.基于单目视觉的结构化道路检测算法研究 [J], 焦欣欣;王民慧;李晓鹏因版权原因,仅展示原文概要,查看原文内容请购买。

第36卷第6期2002年11月浙 江 大 学 学 报(工学版)Journal of Zhejiang U niversity (Engineering Science )V o l .36N o .6N ov .2002收稿日期:2002203215.作者简介:李欣(1977-),男,江西宁都人,硕士生,从事自主机器人视觉导航算法研究.E 2m ail :ndlixin @21cn .com一种结构化道路环境中的视觉导航系统李 欣,李宏东,顾伟康,李庆中(浙江大学信息与电子工程系,浙江杭州310027)摘 要:根据结构化道路环境的特点提出了一种将边沿检测和道路环境知识相结合的机器视觉算法,并结合基于行为响应的路径规划方法和智能预瞄控制方法,实现了一套基本的机器人视觉导航系统.在自主机器人实验平台A TRV 22上的实验结果表明,该视觉导航系统能够实时理解结构化道路环境,并且能够控制机器人沿着合理路径行驶.关键词:结构化道路;视觉导航;机器视觉;路径规划;预瞄控制中图分类号:T P 242.6 文献标识码:A 文章编号:10082973X (2002)0620630204A v ision -based nav igation system i nstructural road env ironm en tL I X in ,L I Hong 2dong ,GU W ei 2kang ,L I Q ing 2zhong(D ep art m ent of Inf or m ation and E lectronics E ng ineering ,Z hej iang U niversity ,H ang z hou 310027,Ch ina )Abstract :Com b in ing the know ledge of structu ral road and edge detecting m ethod ,a m ach ine visi on algo 2rithm w as p ropo sed to understand the su rrounding environm en t .W ith the behavi o r 2based path p lann ing and in telligen t p review con tro lling ,a basic visi on based navigati on system w as created and i m p lem en ted on ou r au tonom ou s robo t test bed A TRV 22.Experi m en tal resu lts show ed that the p ropo sed visi on based sys 2tem can recogn ize drivab le area in real 2ti m e and drive the A TRV 22along a reasonab le p ath .Key words :structu ral road ;visi on 2based navigati on ;m ach ine visi on ;path p lann ing ;p review con tro l 结构化道路是指地面平坦,无障碍,有良好视觉效果的白线导航的道路环境.结构化道路可以用一条白线也可用两条白线来表示可通行区域,更复杂的是高速公路网上的白线.结构化道路环境下视觉导航系统能够实现自主移动平台道路实时理解和自主行驶.一个基于视觉的导航系统从功能结构来看应包括道路检测、路径规划、运动控制等各种性质各异的功能模块.在这个系统中关键技术是机器视觉、路径规划和运动控制,在这几个方面已有大量的研究[1,2],问题主要集中于机器视觉对路面环境的快速识别和理解能力差,大部分的算法受到光照和路面环境影响,鲁棒性能较差,而且算法无法实时实现.在路径规划和运动控制方面缺乏智能性.本文提出一种基于知识的视觉导航算法,充分利用结构化道路环境知识和道路理解的历史记录进行道路环境理解,并且采用智能预瞄控制方法.该视觉导航算法在机器人实验平台A TRV 22上实现,并且进行大量实验.结果表明该自主机器人能快速准确地理解结构化道路环境,自主行驶的轨迹平滑,并且自主行驶路径是该结构化道路环境下的合理路径.1 实验平台和视觉导航系统在研究中所用的实验机器人平台是美国I ROBO T 公司的A TRV 22产品.机器人的运动由底层运动控制模块控制,该模块直接控制车轮电机.I ROBO T 公司提供底层运动控制模块软件接口,高层控制只需给接口给定线速度和角速度就可以实现机器人的运动控制.本文介绍的视觉导航系统在实验平台上实现,在文章中将实验平台和视觉导航系统合称为基于视觉导航的地面自主机器人.图1 系统结构F ig .1 System arch itecture图1给出了本文要介绍的结构化道路环境下视觉导航系统和机器人实验平台的系统结构框图.在机器人的自动行驶过程中机器视觉模块的功能是对结构化道路路面信息进行实时采集、预处理、特征提取和道路环境理解;然后将结果传给路径规划模块,该模块道路环境理解结果,规划出一条安全的、平滑的参考路径.预瞄控制模块根据路径规划模块的规划路径采用智能预瞄控制方法得到控制参数,主要是线速度参数和角速度参数;最后是底层车体运动控制模块根据预瞄控制模块给出的控制参数来控制移动机器人平台的电机参数,从而精确控制机器人运动,完成机器人在给定的道路环境自主行驶.2 机器视觉和路径规划在基于视觉导航的地面自主机器人中,机器视觉与路径规划是核心模块.目前国内外许多学者在这方面作了大量的研究工作,到目前为止还没有找到一套适用于各种道路环境的算法,解决的方法大都是针对某些比较具体的道路环境.本文研究的是针对结构化道路环境下的机器视觉与路径规划算法.在这种环境下机器视觉的任务就是白线的检测与组织,并根据白线来理解道路.而路径规划则根据白线的位置来规划出合理、平滑的路径.2.1 白线检测和组织有的白线检测算法主要是基于边缘的,也有的研究是基于区域灰度在直方图上作分割的.直方图的分割在路面环境不是很理想的情况下效果不是很好,首先由于阴影、水迹以及路面的反光造成路面灰度的不均匀,白线的灰度也不是固定的,比如阴影下的白线有时灰度和阳光下的路面是非常接近的;其次,路面上有时会有一些沙石、泥土等使得路面的灰度和白线的灰度比较接近,这时分割效果也不好.基于边缘的方法利用的是局部信息,而白线在局部仍然比旁边路面要亮,因此上面两个问题的影响不是很大,但在大部分图像中有一些很强的边缘不是白线,而白线的边缘却并不强,所以得到的边缘图往往有很大的噪声,而且可能会丢失白线.为了克服这些缺点,算法应该尽量利用白线的各种知识,在这里利用了下面两条知识来检测出白线:(1)形状知识:白线的宽度基本保持不变,方向逐渐变化.(2)灰度知识:白线的灰度高于它两边邻域的灰度.算法的流程如下:(1)边缘检测,对边缘进行分类.如果边缘两侧从左到右灰度值是从小到大变化,则定义该边缘为正边缘,反之则定义该边缘为负边缘.显然白线的左边界是正边缘,而右边界是负边缘,而且它们之间的距离和估计的白线宽度接近,记录每对满足要求的正负边缘点对.(2)根据边缘点对,利用白线灰度值比其邻域内路面的灰度值要大的知识,记录满足条件的点对.利用数学形态学方法平滑点对所描述的区域,对连通区域进行标记,每个连通区域对应一条白线段,用直线段表示每个连通区域.(3)组织直线段,寻找满足下面两个条件的直线段序列.这些白线段序列对应道路上的白线.①相邻两个直线段之间的距离比较接近;②相邻两个直线段之间的方向变化不大.(4)根据路面白线分布的知识,利用检测出来的白线段表达路面状态.例如在路面由两条白线表示的时候,检测出的白线结果要区分是在左路边还是右路边.由于是通过检测道路图像边沿和充分利用结构化道路环境的知识来识别白线,算法具有良好的鲁棒性,即使是在不同的光照条件下也能准确识别出道路白线.为了使算法达到实时性的要求,利用In 2tel 的MM X 指令对算法进行了优化.2.2 路径规划自主机器人的路径规划一般可以按照所规划的路径距离长短把路径规划分为两类:全局路径规划和局部路径规划.一般而言,全局路径规划解决的是机器人从A 点到B 点应该经过哪些路径的问题;而局部路径规划解决的是机器人在当前时刻根据前方道路情况如何保持行驶在道路上并避开障碍物的问题.因此全局路径规划一般是依赖事先建立的全局地图,而局部路径规划一般是依赖当前时刻通过传136 第6期李欣,等:一种结构化道路环境中的视觉导航系统感器检测到的机器人附近一个小范围内的局部地图.本文中要介绍的是局部路径规划.图2 白线检测与路径规划处理过程F ig .2 W h ite line detecting and path p lanning局部路径规划常用的方法有:人工势场法、模糊逻辑算法和基于传感器信息融合及行为响应方法.本视觉导航系统采用信息融合及行为响应方法,使用的信息包括视觉传感器信息和机器人运动参数.在高速公路环境下,当司机驾驶汽车行驶时,在无外在因素影响的时候,通常是以路两侧的白线获得路边中部作为行驶路径.因而在路面状态由白线段表达出来后,根据路面的宽度和路边建立道路结构模型,根据这个模型生成期望路径.然后利用机器人运动参数反馈动态调整期望路径最终规划出一条平滑、合理的自主机器人行驶路径.下面介绍路径规划的具体过程.(1)得到期望路径.以路面有两条白线的情况为例,视野范围有两条白线时,期望路径在两条白线的中间;视野范围只有一条白线时,根据白线是左路边还是右路边向路中央延伸半个路宽得到期望路径;视野范围出现白线消失时,例如急转弯的情况,期望路径将根据前一控制周期的规划路径和运动控制参数得到本次期望路径.(2)动态调整期望路径.利用传感器实时信息反馈确定机器人姿态与道路之间的交角,来调整期望路径得到最终的规划路径.例如根据机器人姿态和道路模型方向(该方向定义为平行路边方向),利用多段折线逼近方法调整期望路径.图2展示了机器视觉和路径规划的处理过程.3 预瞄控制机器人平台的运动控制分为两层:处于高层的智能控制和处于底层的电机运动控制.要让机器人按规划路径行驶,必须由高层智能控制模块得到机器人下一时刻行驶的角速度和线速度.通过研究汽车驾驶员的驾驶行为,发现它是一个典型的预瞄控制行为.驾驶员找到当前道路环境下的预瞄点,根据预瞄点控制机器人行驶.地面自主机器人的控制和驾驶员对机器人控制相类似,因而采用预瞄控制算法,算法采用专家驾驶经验规则确定线速度和参数动态调整的P I D 控制确定角速度.下面分别介绍线速度控制算法和角速度控制算法.3.1 线速度控制算法实验中控制周期为80m s ,虽然在每个控制周期内线速度为常量,但是在不同的控制周期由于道路环境的变化,线速度也有所变化,因此总体来看机器人是在变速行驶.实验表明机器人前进的线速度主要取决于两个因素:道路的弯曲程度和机器人相对预瞄点的方向偏差.在经过机器视觉和路径规划后,自主机器人已经获得理想路径.理想路径通过一系列的点连接起来的折线段表示,路径的弯曲程度可以用这些折线段之间的夹角总和来表示.预瞄点的选取由以下几个方面来确定:(1)道路的弯曲程度,若道路弯曲程度大,则预瞄点的距离应该选得小,反之越大.(2)根据摄像机的视野范围,预瞄点应该在视野范围之内.(3)预瞄点的位置应该在规划路径的曲线上.在确定了预瞄点后,根据预瞄点与机器人相对坐标系的夹角Η和规划路径中起点到预瞄点之间的弯曲度W 的值确定该控制周期的线速度v .在实验中发现,速度分为三个档次比较合理,下面给出实验中得到的经验规则:(1)当Η、W 均小于10°,规划路径是直道,对应预瞄点的位置在机器人正前方位置时,v 取高速,在实验中取2.0m s .236浙 江 大 学 学 报(工学版) 第36卷 (2)当Η大于40°或W大于90°,规划路径弯曲,预瞄点严重偏离机器人正前方向时,机器人需要低速拐弯,v取低速,在实验中取0.5m s.(3)其他情况.规划路径稍有弯曲,预瞄点和机器人正前方位置有偏差,但是不大,机器人可以保持中速,并配合角速度调整机器人行驶方向,这时v取中速,在实验中取1.0m s.3.2 角速度P I D控制算法P I D控制简单、稳定、可靠性高,因而采用它来实现角速度的控制.算法的关键在于P I D参数的选取,要求参数在不同的控制周期能动态调整.当前k时刻角速度Ξ的P I D控制算式为Ξc(k)=k1x p+k2бp+k3Ξc(k-1)+k4Ξc(k-2).(1)式中:x p、бp分别为当前时刻机器人相对于参考路径上预瞄点的位置偏差和方向偏差;Ξc(k-1)、Ξc(k-2)分别为k-1、k-2时刻的角速度控制量;k1、k2、k3、k4分别为P I D控制器的参数.各参数的确定方法如下:k3、k4是过去两个时刻的角速度控制量的权系数,可设定为0.33,即当前时刻和前两个时刻的权重一致.最后只剩下k1、k2由仿真试验整定,但角速度P I D控制器参数的整定与移动机器人的线速度大小有关.k1、k2的整定方法为:根据前进速度的控制规则,分别通过仿真试验在计算机上设定高、中、低速对应的三种不同弯曲程度的路径,然后由仿真控制试验确定最佳预瞄距离d p和相应的k1、k2值,整定的结果是三组值(d p i,k1i,k2i),i=1,2,3.这三组值分别对应于三个前进速度下的角速度P I D控制参数.即机器人通过视觉获取预瞄参考路径的弯曲度,然后根据弯曲度大小确定线速度的控制档位,再根据确定的线速度档位,在线调整角速度控制的P I D参数,由此实现移动机器人路径跟踪的智能预瞄控制.为验证本文提出的控制方法的有效性,编写了一套仿真程序,仿真程序内建有移动机器人平台运动模型.只需设定各种形式的路径,即可进行仿真控制试验,以整定角速度P I D控制器的参数和观察控制效果,图3是部分路径跟踪的仿真试验结果.由图3可知,机器人在偏离设定路径的初始点(横向位置偏差为0.35m),经过约1.35m的行程后,就能逼近设定路径,整条路径上,最大位置偏差小于0.14 m,可见路径跟踪效果良好.所以通过仿真试验进行P I D控制器的参数整定是方便的.4 试验结果在A TRV22移动机器人平台上试验了视觉导图3 P I D控制仿真试验结果F ig.3 R esult of P I D contro ller si m ulati on航系统,机器视觉的图像采集采用单目彩色CCD摄像机和hauppauge公司采集卡,采用双P II CPU, L inux操作系统.图像处理算法经过MM X指令优化,控制周期在80m s.实验场道路环境为八字形环状跑道,中间为绿化区,水泥路面由左右两条白线标记,弯道角度大于100°.实际机器人自主行驶迹线的确定是采用在机器人底部中心处固定洒水装置,然后以地面上的水迹线来测量机器人自主行驶的实际迹线.通过这种方法在试验场地进行大量自主机器人行驶轨迹跟踪的重复实验.机器人的三档速度分别为0.5、1.0、2.0m s.试验表明在行驶过程中机器人90%以上时间行驶在道路中间,行驶过程平稳,路径平滑.经过长时间的试验发现机器人每圈的轨迹重叠程度达到80%Λ5 结 语试验结果表明,本文所介绍的基于视觉导航的地面自主机器人的实时性和鲁棒性都满足结构化道路环境的要求.但是由于试验环境中路况简单,它和真正的结构化道路环境还有很大的差别,比如道路白线标记可能不连续,宽度并非严格恒定不变,道路中还会有其他车辆的行驶以及天气变化等因素需要考虑Λ这些都有待作进一步研究.参考文献(References):[1]BER TO ZZ IM,BRO GG I A.Go ld:a parallel real2ti m estereo visi on system fo r generic obstacle and lane detec2 ti on[J].I EEE Tran s on I mage Processi ng,1998,7(1):62-81.[2]CH EN M,JOCH E M T,POM ERL EAU D.AU RORA:A visi on2based roadw ay departure system[A].I n Proceedi ngs of the I EEE Conference on I n telligen t Robots and Syste m s(vol.1)[C].P ittsburgh,PA,U SA: IEEE Computer Society,1995.243-248.[3]SH ER I DAN T B,T h ree models of p review contro l[J].I EEE Tran s on Hu man Factors i n Electron ics,1966,H FE27(6):91-102.336 第6期李欣,等:一种结构化道路环境中的视觉导航系统。