Nginx反向代理服务器的工作原理

- 格式:docx

- 大小:103.75 KB

- 文档页数:3

nginx工作原理

Nginx(发音同engine x)是一款高性能的HTTP和反向代理服务器,

也是一个IMAP/POP3/SMTP服务器。

Nginx是由俄罗斯的程序设计师

Igor Sysoev所开发,他最初是为俄国大型的入口网站Rambler(俄文:Рамблер)所设计的,现在已经成为一个被广泛使用的Web服

务器软件。

Nginx的工作原理是,它将HTTP请求转发到后端的Web服务器,然后

将Web服务器的响应返回给客户端。

Nginx可以作为一个反向代理服务器,将客户端的请求转发到后端的Web服务器,并将Web服务器的响

应返回给客户端。

Nginx还可以作为一个负载均衡器,将客户端的请求分发到多台后端服务器上,以提高系统的吞吐量。

Nginx的工作流程是:首先,客户端发出HTTP请求,Nginx接收到请

求后,会根据配置文件中的规则,将请求转发到后端的Web服务器上;然后,Web服务器处理请求,并将响应返回给Nginx;最后,Nginx将

响应返回给客户端。

Nginx的优势在于,它可以处理大量的并发请求,而且支持虚拟主机,可以同时处理多个域名的请求,这样可以节省服务器的资源,提高系

统的性能。

此外,Nginx还支持SSL加密,可以保证数据传输的安全性。

总之,Nginx是一款高性能的HTTP和反向代理服务器,它可以处理大

量的并发请求,支持虚拟主机,支持SSL加密,可以保证数据传输的

安全性,是一款非常实用的Web服务器软件。

ingress-nginx工作原理Ingress-Nginx是Kubernetes集群中用于管理流量和进行负载均衡的一个常用工具。

它是基于Nginx的反向代理服务器,通过将外部流量路由到集群内部的服务,实现了高性能的负载均衡和流量控制。

Ingress-Nginx的工作原理如下:1. 定义Ingress规则:管理员通过Ingress资源定义了一组规则,指定了外部请求如何访问集群中的服务。

每个Ingress规则包含了一个或多个路径和相应的服务。

2. 部署Ingress-Nginx控制器:在集群中部署Ingress-Nginx控制器,它会监听Kubernetes API Server上的Ingress资源的变化。

3. Nginx配置生成:Ingress-Nginx控制器会根据Ingress资源的定义,生成相应的Nginx配置文件。

4. 负载均衡和流量路由:Nginx根据生成的配置文件进行负载均衡和流量路由。

当外部请求到达Ingress-Nginx的Load Balancer时,它会根据配置将请求路由到对应的后端服务上进行处理。

5. SSL/TLS支持:Ingress-Nginx支持通过自签名或使用公共证书来提供加密通信,可以在Ingress规则中配置相应的TLS相关信息。

6. 日志和监控:Ingress-Nginx控制器会记录请求和回复的详细日志,可以通过这些日志来进行监控和排查问题。

7. 动态配置:管理员可以通过更新对应的Ingress资源来进行动态配置,例如更改路径、添加新的服务等,这些更改会被Ingress-Nginx控制器自动更新并应用到Nginx配置中。

总结起来,Ingress-Nginx的工作流程是定义Ingress规则 -> 部署Ingress-Nginx控制器 -> Nginx配置生成 -> 负载均衡和流量路由。

它通过控制器和Nginx的配合,使得流量可以根据规则进行分发和路由,从而实现了高效的负载均衡和流量控制。

nginx 代理ws 原理-回复Nginx代理ws原理WebSocket(缩写为ws)是一种在Web应用程序和服务器之间进行全双工通信的协议。

Nginx是一种高性能的反向代理服务器,支持多种协议和服务。

本文将详细介绍Nginx如何代理WebSocket并解释其工作原理。

一、WebSocket简介在WebSocket出现之前,实现实时双向通信的常用方法是使用长轮询(Long Polling)或服务器发送事件(Server-Sent Events,SSE)等技术。

这些方法的问题在于它们在客户端和服务器之间维护了持久的连接,这会导致额外的资源开销和网络延迟。

WebSocket协议通过在客户端和服务器之间建立一个持久的双向通信通道,解决了这个问题。

它是建立在HTTP协议之上的,而且与HTTP协议兼容,可以使用默认的TCP端口80和443。

二、Nginx代理WebSocket的配置要使用Nginx代理WebSocket,需要进行一些配置和调整。

下面是一些配置指南:1. 安装Nginx首先,需要在服务器上安装Nginx。

可以使用包管理器(如apt或yum)来安装。

2. 配置Nginx在Nginx的配置文件(通常是/etc/nginx/nginx.conf)中,需要添加以下配置代码:http {...map http_upgrade connection_upgrade {default upgrade;'' close;}server {...location / {proxy_passproxy_http_version 1.1;proxy_set_header Upgrade http_upgrade;proxy_set_header Connection connection_upgrade;}}...}上述配置中,`http_upgrade`变量会根据请求头中的`Upgrade`字段的值判断是否进行升级。

nginx反向代理解决跨域问题的方法【实用版3篇】目录(篇1)I.nginx反向代理介绍II.跨域问题介绍III.nginx反向代理解决跨域问题的原理IV.nginx反向代理解决跨域问题的具体方法V.总结正文(篇1)I.nginx反向代理介绍ginx是一款常用的反向代理服务器,它可以代理客户端的请求,将请求转发到后端服务器,并能够处理静态文件和异常情况。

反向代理服务器能够减轻原始服务器的工作负担,提高服务器的可伸缩性和可用性。

II.跨域问题介绍跨域问题是指浏览器由于同源策略无法访问不同源的资源。

这导致了一些问题,例如无法读取Cookie、无法发送AJAX请求等。

在Web开发中,跨域问题是一个常见的问题,需要解决。

III.nginx反向代理解决跨域问题的原理ginx反向代理可以解决跨域问题,其原理是代理客户端的请求时,将请求头中的“Access-Control-Allow-Origin”设置为代理服务器的地址,从而允许后端服务器响应来自该地址的请求。

这样,客户端就可以访问后端服务器的资源,而无需考虑跨域问题。

IV.nginx反向代理解决跨域问题的具体方法要使用Nginx反向代理解决跨域问题,需要在Nginx配置文件中添加以下指令:```bashproxy_set_header Access-Control-Allow-Origin $http_origin;```其中,$http_origin是客户端发送的请求头中的“Access-Control-Allow-Origin”的值。

V.总结ginx反向代理可以解决跨域问题,其原理是代理客户端的请求时,将请求头中的“Access-Control-Allow-Origin”设置为代理服务器的地址。

目录(篇2)I.nginx反向代理的基本概念II.跨域问题的产生及影响III.nginx反向代理解决跨域问题的几种方法IV.总结正文(篇2)I.nginx反向代理的基本概念ginx反向代理是一种将请求转发到后端服务器,并将响应返回给客户端的代理服务器。

nginx代理转发原理nginx代理转发原理详解【引言】随着互联网的快速发展,现代应用程序通常需要通过代理服务器来实现负载均衡、反向代理和高可用性等需求。

而nginx代理服务器凭借其高性能、稳定性和资源占用率低的特点成为当前最流行的选择之一。

本文将深入探讨nginx代理转发原理,从基本概念到具体实现一步步进行解析,以帮助读者全面了解并掌握nginx代理转发的工作原理。

【一、什么是nginx代理转发】nginx代理转发是指将客户端的请求经过nginx代理服务器进行处理和转发,以达到负载均衡、反向代理和高可用性等需求。

负载均衡:nginx代理服务器收到客户端请求后,会选择一个合适的目标服务器来处理请求,分配负载,以提高系统性能和可扩展性。

反向代理:nginx代理服务器作为客户端和目标服务器之间的中间层,客户端访问的是代理服务器,代理服务器负责将请求转发给目标服务器,并将目标服务器的响应返回给客户端,隐藏了目标服务器的真实IP和端口信息,提高了系统的安全性和可控性。

高可用性:通过使用nginx代理服务器,可以将请求分发给多个目标服务器,当其中一个服务器故障时,代理服务器会自动将请求转发给其他正常工作的服务器,以提高系统的可用性。

【二、nginx代理转发的基本原理】为了更好地理解nginx代理转发的工作原理,我们需要先了解以下几个重要的概念:1. 正向代理和反向代理正向代理是指代理服务器位于客户端和目标服务器之间,代理服务器代表客户端向目标服务器发送请求,接收响应后再返回给客户端。

而反向代理则是指代理服务器作为目标服务器的一部分,客户端直接访问代理服务器,代理服务器负责将请求转发给真实的目标服务器,并将处理结果返回给客户端。

2. 负载均衡算法负载均衡是实现nginx代理转发的核心功能之一,涉及到如何选择合适的目标服务器来处理客户端请求。

常见的负载均衡算法有:轮询(Round Robin)、加权轮询(Weighted Round Robin)、最少连接(Least Connections)等。

Nginx 反向代理返参解析在 Nginx 反向代理中,返回的 HTTP 响应报文中包含了客户端发送的请求参数。

通过对这些参数进行解析,可以获取客户端的请求信息,从而进行后续的处理。

本文介绍了 Nginx 反向代理返参解析的基本原理和使用方法。

下面是本店铺为大家精心编写的4篇《Nginx 反向代理返参解析》,供大家借鉴与参考,希望对大家有所帮助。

《Nginx 反向代理返参解析》篇1一、基本原理Nginx 反向代理返参解析是指在 Nginx 作为反向代理服务器时,解析 HTTP 响应报文中的客户端请求参数。

这些参数在客户端发送请求时被附加在请求报文中,由 Nginx 接收后转发给后端服务器。

后端服务器在处理请求时,将响应参数添加到 HTTP 响应报文中,然后返回给客户端。

Nginx 反向代理返参解析的基本原理是通过 Nginx 的配置文件,指定需要解析的请求参数,并在 Nginx 内部使用相应的变量进行处理。

这些变量可以在 Nginx 的日志中查看,也可以在后端服务器的处理过程中使用。

二、使用方法1. 配置 Nginx在 Nginx 的配置文件中,可以使用`proxy_pass`指令指定反向代理的后端服务器,并使用`proxy_set_header`指令设置需要返回的请求参数。

例如:```proxy_pass http://backend;proxy_set_header Host $host;proxy_set_header X-Real-IP $remote_addr;proxy_set_header X-Forwarded-For$proxy_add_x_forwarded_for;```上述配置中,`proxy_pass`指令指定后端服务器为`backend`,并使用`proxy_set_header`指令设置了三个请求参数:`Host`、`X-Real-IP`和`X-Forwarded-For`。

nginx反向代理工作原理Nginx是一款高性能、高并发的Web服务器和反向代理服务器。

反向代理是一种计算机网络技术,它可以代理客户端向服务器发送请求,并将服务器的响应返回给客户端。

在这个过程中,反向代理服务器隐藏了真实的服务器,并根据一定的规则将客户端的请求转发给不同的服务器进行处理。

下面是Nginx反向代理的工作原理的详细解释。

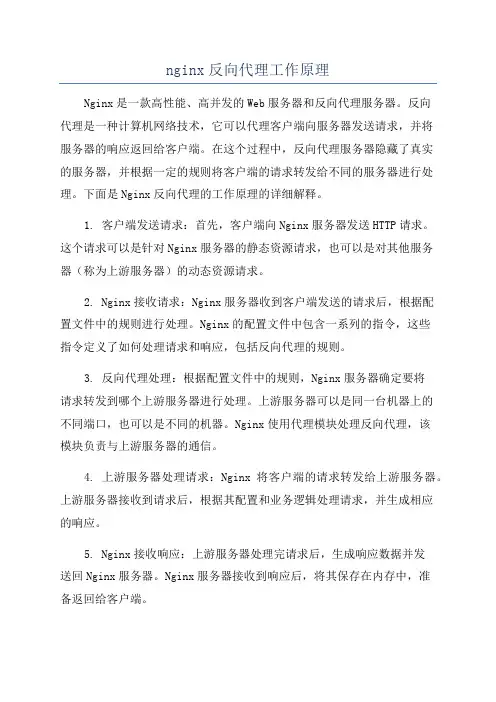

1. 客户端发送请求:首先,客户端向Nginx服务器发送HTTP请求。

这个请求可以是针对Nginx服务器的静态资源请求,也可以是对其他服务器(称为上游服务器)的动态资源请求。

2. Nginx接收请求:Nginx服务器收到客户端发送的请求后,根据配置文件中的规则进行处理。

Nginx的配置文件中包含一系列的指令,这些指令定义了如何处理请求和响应,包括反向代理的规则。

3. 反向代理处理:根据配置文件中的规则,Nginx服务器确定要将请求转发到哪个上游服务器进行处理。

上游服务器可以是同一台机器上的不同端口,也可以是不同的机器。

Nginx使用代理模块处理反向代理,该模块负责与上游服务器的通信。

4. 上游服务器处理请求:Nginx将客户端的请求转发给上游服务器。

上游服务器接收到请求后,根据其配置和业务逻辑处理请求,并生成相应的响应。

5. Nginx接收响应:上游服务器处理完请求后,生成响应数据并发送回Nginx服务器。

Nginx服务器接收到响应后,将其保存在内存中,准备返回给客户端。

6. 客户端接收响应:最后,Nginx服务器将上游服务器返回的响应发送给客户端。

客户端收到响应数据后,根据其内容进行相应的处理。

在这个过程中,Nginx做了很多工作来保证高性能和高并发。

首先,Nginx使用事件驱动的异步模型,采用了多进程或多线程的工作方式,可以处理大量的并发请求。

其次,Nginx的代理模块使用连接池和缓冲区来管理与上游服务器的连接,减少了连接的建立和关闭的开销,提高了代理的性能。

另外,Nginx还提供了HTTP缓存功能,可以缓存上游服务器返回的响应,在一定的时间内直接返回缓存的响应,减少对上游服务器的访问。

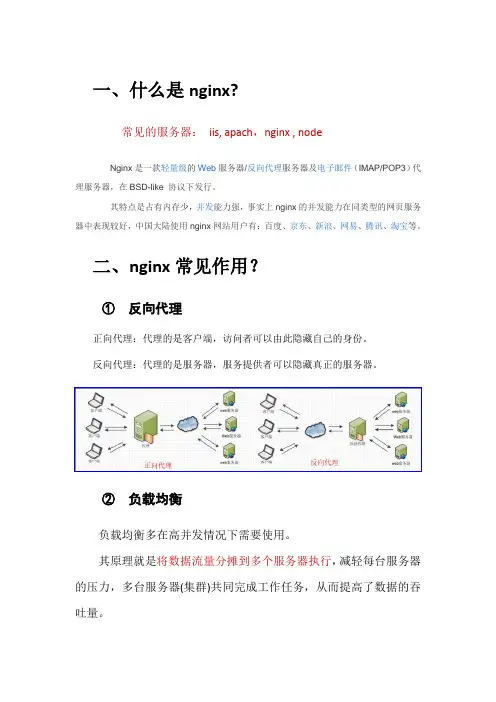

一、什么是nginx?常见的服务器:iis, apach,nginx , nodeNginx是一款轻量级的Web服务器/反向代理服务器及电子邮件(IMAP/POP3)代理服务器,在BSD-like 协议下发行。

其特点是占有内存少,并发能力强,事实上nginx的并发能力在同类型的网页服务器中表现较好,中国大陆使用nginx网站用户有:百度、京东、新浪、网易、腾讯、淘宝等。

二、nginx常见作用?①反向代理正向代理:代理的是客户端,访问者可以由此隐藏自己的身份。

反向代理:代理的是服务器,服务提供者可以隐藏真正的服务器。

②负载均衡负载均衡多在高并发情况下需要使用。

其原理就是将数据流量分摊到多个服务器执行,减轻每台服务器的压力,多台服务器(集群)共同完成工作任务,从而提高了数据的吞吐量。

③动静分离Nginx提供的动静分离是指把动态请求和静态请求分离开,合适的服务器处理相应的请求,使整个服务器系统的性能、效率更高。

Nginx可以根据配置对不同的请求做不同转发,这是动态分离的基础。

静态请求对应的静态资源可以直接放在Nginx上做缓冲,更好的做法是放在相应的缓冲服务器上。

动态请求由相应的后端服务器处理。

三、nginx的安装下载下载稳定版:/en/download.html解压下载进行解压,将解压后的文件放到自己心仪的目录下,我的解压文件放在了d盘根目录下,如下图所示:启动直接双击上图中的蓝色图标【nginx.exe】文件即可,双击后,cmd 窗口会闪一下就消失,这时你可以查看下任务管理器里面是否有相关进程,如果有,那就说明启动成功了启动失败如果你双击后在任务管理器没有发现这两个进程,那么就说明启动失败,这时估计很有可能是端口被占用了(因为nginx的默认端口是80,然后iis等服务器的默认端口也是80),这时,修改端口即可,打开nginx的配置文件:D:\nginx-1.16.1\conf\nginx.conf将端口80修改下,比如改成82访问这时你直接访问:127.0.0.1 即可(默认端口80,如果修改了就加上修改后的端口)四、一些在nginx命令nginx.exe -s stop //停止nginxnginx.exe -s reload //重新加载nginxnginx.exe -s quit //退出nginx注意:如果想要这些命令生效,需要在nginx.exe所在目录下打开cmd进行执行,或者把此路径配置进入环境变量。

Nginx反向代理解决跨域问题的原理可以概括为以下几点:

1. Nginx作为反向代理服务器,接收来自客户端的HTTP请求,并将其转发到另一个或多个服务器上处理。

2. 当请求涉及到跨域资源共享(CORS)时,Nginx可以作为代理服务器,在请求和响应之间扮演桥梁角色。

3. Nginx通过配置相应的代理规则,将本地一个URL前缀映射到要跨域访问的Web服务器上。

这样,对于浏览器来说,访问的就是同源服务器上的一个URL,从而实现了跨域访问。

4. 在Nginx的配置文件中,可以设置特定的指令来控制代理的行为,如使用`add_header`指令添加相应的CORS头部信息。

5. 通过Nginx的反向代理功能,可以实现不同域名之间的跨域访问,同时隐藏了实际的物理服务器地址,保护了后端服务的安全性。

综上所述,Nginx反向代理解决跨域问题的原理是通过将本地URL前缀映射到要跨域访问的Web服务器上,并在代理过程中添加相应的CORS头部信息,从而实现跨域访问。

nginx负载均衡和反向代理原理

Nginx是一个高性能的Web服务器和反向代理服务器,它可以用于负载均衡和反向代理。

1. 负载均衡:当有多个服务器时,Nginx可以通过配置,将请求分发到不同的服务器上。

这可以提高服务器的性能,并提高系统的稳定性。

Nginx使用一种名为“轮询”的负载均衡算法,即每个请求依次分配给不同的服务器。

2. 反向代理:Nginx可以作为一个反向代理服务器,代替用户请求的真实服务器进行HTTP通信。

Nginx可以缓存服务器的响应,因此可以提高服务器的性能。

此外,Nginx还可以对请求进行缓存、压缩、加密等操作,以提高服务的响应速度和安全性。

Nginx的工作原理是基于事件驱动和多路复用的。

这意味着Nginx可以在等待下一个请求时处理其他事情,从而提高其性能。

总的来说,Nginx通过负载均衡和反向代理,可以有效地提高服务器的性能和稳定性。

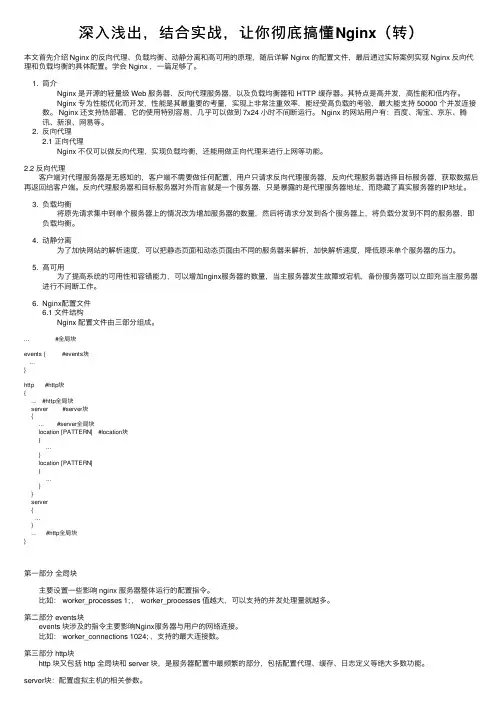

深⼊浅出,结合实战,让你彻底搞懂Nginx(转)本⽂⾸先介绍 Nginx 的反向代理、负载均衡、动静分离和⾼可⽤的原理,随后详解 Nginx 的配置⽂件,最后通过实际案例实现 Nginx 反向代理和负载均衡的具体配置。

学会 Nginx ,⼀篇⾜够了。

1. 简介 Nginx 是开源的轻量级 Web 服务器、反向代理服务器,以及负载均衡器和 HTTP 缓存器。

其特点是⾼并发,⾼性能和低内存。

Nginx 专为性能优化⽽开发,性能是其最重要的考量,实现上⾮常注重效率,能经受⾼负载的考验,最⼤能⽀持 50000 个并发连接数。

Nginx 还⽀持热部署,它的使⽤特别容易,⼏乎可以做到 7x24 ⼩时不间断运⾏。

Nginx 的⽹站⽤户有:百度、淘宝、京东、腾讯、新浪、⽹易等。

2. 反向代理2.1 正向代理 Nginx 不仅可以做反向代理,实现负载均衡,还能⽤做正向代理来进⾏上⽹等功能。

2.2 反向代理 客户端对代理服务器是⽆感知的,客户端不需要做任何配置,⽤户只请求反向代理服务器,反向代理服务器选择⽬标服务器,获取数据后再返回给客户端。

反向代理服务器和⽬标服务器对外⽽⾔就是⼀个服务器,只是暴露的是代理服务器地址,⽽隐藏了真实服务器的IP地址。

3. 负载均衡 将原先请求集中到单个服务器上的情况改为增加服务器的数量,然后将请求分发到各个服务器上,将负载分发到不同的服务器,即负载均衡。

4. 动静分离 为了加快⽹站的解析速度,可以把静态页⾯和动态页⾯由不同的服务器来解析,加快解析速度,降低原来单个服务器的压⼒。

5. ⾼可⽤ 为了提⾼系统的可⽤性和容错能⼒,可以增加nginx服务器的数量,当主服务器发⽣故障或宕机,备份服务器可以⽴即充当主服务器进⾏不间断⼯作。

6. Nginx配置⽂件6.1 ⽂件结构 Nginx 配置⽂件由三部分组成。

... #全局块events { #events块...}http #http块{... #http全局块server #server块{... #server全局块location [PATTERN] #location块{...}location [PATTERN]{...}}server{...}... #http全局块}第⼀部分全局块 主要设置⼀些影响 nginx 服务器整体运⾏的配置指令。

Nginx反向代理多个服务器的实现⽅法Nginx反向代理多个服务器,意思是说,当我们发起了不同的请求到nginx,nginx会根据请求的不同,转发到不同的服务器,如下图,当我们通过8000端⼝访问资源a时,nginx会将请求转发到8080服务器,当访问资源b时,会转发到8081服务器我们先做下准备⼯作,⾸先准备两个tomcat服务器,分别是8080端⼝和8081端⼝,8080端⼝是默认的,这⾥进⾏修改8081的端⼝,⾸先我们进⼊tomcat下的conf⽬录下,进⼊server.xml⽂件进⾏如下两个地⽅的修改⼀、修改shutdown端⼝号为8015⼆、修改start端⼝号为8081这样我们就有了两个tomcat了,接下来我们启动⼀下这两个tomcat,看是否都能访问,如果不能访问,可能就是你防⽕墙的问题, systemctl stop firewalld ,这个命令可以关闭防⽕墙,如果还不能访问,可能是阿⾥云未打开端⼝的webapps⽬录下分别创建a⽬录和b⽬录,并创建index.html,⾥⾯分别写8080,8081,⽅便⼀会测试,这⾥给出资源a好了,接下来就是配置nginx了,进⼊到nginx的conf⽬录下打开nginx.conf⽂件,⼿动配置⼀个server块该server的意思是:listen 8000:监听8000端⼝,也就是我们直接访问的nginx端⼝server_name localhost:是域名location ~ /a/:是所有访问a资源的请求,会通过下⾯的代理转发http://39.106.231.3:8080;意思是代理转发到ip为39.106.231.3主机下的8080服务器配置好之后,在sbin⽬录下执⾏./nginx -s reload,重新加载配置⽂件访问:39.106.231.3:8000/a访问:39.106.231.3:8000/b到此这篇关于Nginx反向代理多个服务器的实现⽅法的⽂章就介绍到这了,更多相关Nginx反向代理服务器内容请搜索以前的⽂章或继续浏览下⾯的相关⽂章希望⼤家以后多多⽀持!。

nginx前后端调用原理标题,深入理解Nginx前后端调用原理。

Nginx是一个高性能的开源Web服务器,同时也可以作为反向代理服务器、负载均衡器和HTTP缓存服务器。

它的灵活性和高性能使得它成为许多网站和应用程序的首选。

在实际应用中,Nginx经常被用于与后端应用程序进行交互,以提供更好的性能和可靠性。

在Nginx中,前后端调用是通过一系列的请求和响应过程来实现的。

下面我们将深入探讨Nginx前后端调用的原理。

1. 反向代理。

Nginx可以作为反向代理服务器,将客户端的请求转发给后端的应用服务器。

当客户端发送请求时,请求首先到达Nginx服务器,然后Nginx会根据配置的规则将请求转发给后端的应用服务器。

这种方式可以隐藏后端服务器的真实IP地址,提高安全性,并且可以实现负载均衡和高可用性。

2. 负载均衡。

Nginx可以通过负载均衡模块来分发请求到多个后端服务器上,以实现更好的性能和可靠性。

负载均衡可以根据不同的算法(如轮询、IP哈希、最少连接等)来分配请求,从而避免单个服务器的过载,提高系统的整体性能。

3. 缓存。

Nginx还可以作为HTTP缓存服务器,缓存静态资源或动态页面,以减轻后端服务器的压力,加快页面加载速度。

当客户端请求静态资源时,Nginx可以直接返回缓存的内容,而不需要向后端服务器发起请求,从而提高了整体的响应速度。

总结。

通过以上的介绍,我们可以看到Nginx在前后端调用中发挥着重要的作用。

它不仅可以实现反向代理、负载均衡和缓存,还可以提高系统的性能和可靠性。

因此,深入理解Nginx前后端调用的原理对于构建高性能、高可用的Web应用是非常重要的。

希望本文能帮助读者更好地理解Nginx的工作原理,从而更好地应用它来构建稳定高效的Web应用。

Udp的反向代理:nginx在实时性要求较⾼的特殊场景下,简单的UDP协议仍然是我们的主要⼿段。

UDP协议没有重传机制,还适⽤于同时向多台主机⼴播,因此在诸如多⼈会议、实时竞技游戏、DNS查询等场景⾥很适⽤,视频、⾳频每⼀帧可以允许丢失但绝对不能重传,⽹络不好时⽤户可以容忍⿊⼀下或者声⾳嘟⼀下,如果突然把⼏秒前的视频帧或者声⾳重播⼀次就乱套了。

使⽤UDP协议作为信息承载的传输层协议时,就要⾯临反向代理如何选择的挑战。

通常我们有数台企业内⽹的服务器向客户端提供服务,此时需要在下游⽤户前有⼀台反向代理服务器做UDP包的转发、依据各服务器的实时状态做负载均衡,⽽关于UDP反向代理服务器的使⽤介绍⽹上并不多见。

本⽂将讲述udp协议的会话机制原理,以及基于nginx如何配置udp协议的反向代理,包括如何维持住session、透传客户端ip到上游应⽤服务的3种⽅案等。

许多⼈眼中的udp协议是没有反向代理、负载均衡这个概念的。

毕竟,udp只是在IP包上加了个仅仅8个字节的包头,这区区8个字节⼜如何能把session会话这个特性描述出来呢?图1 UDP报⽂的协议分层在TCP/IP或者?OSI⽹络七层模型中,每层的任务都是如此明确:物理层专注于提供物理的、机械的、电⼦的数据传输,但这是有可能出现差错的;数据链路层在物理层的基础上通过差错的检测、控制来提升传输质量,并可在局域⽹内使数据报⽂跨主机可达。

这些功能是通过在报⽂的前后添加Frame头尾部实现的,如上图所⽰。

每个局域⽹由于技术特性,都会设置报⽂的最⼤长度MTU(Maximum Transmission Unit),⽤netstat -i(linux)命令可以查看MTU的⼤⼩:⽽IP⽹络层的⽬标是确保报⽂可以跨⼴域⽹到达⽬的主机。

由于⼴域⽹由许多不同的局域⽹,⽽每个局域⽹的MTU不同,当⽹络设备的IP层发现待发送的数据字节数超过MTU时,将会把数据拆成多个⼩于MTU的数据块各⾃组成新的IP报⽂发送出去,⽽接收主机则根据IP报头中的Flags和Fragment Offset这两个字段将接收到的⽆序的多个IP报⽂,组合成⼀段有序的初始发送数据。

nginx的工作原理Nginx是一个高性能的HTTP和反向代理服务器。

它使用事件驱动的架构,采用异步的I/O模型,因此能够处理高并发的请求。

Nginx的工作原理可以简单描述为以下几个步骤:1.启动和初始化:Nginx的启动程序会读取配置文件,并根据配置文件中的指令进行初始化。

配置文件指定了Nginx的全局参数、服务器块(server block)和位置(location)块。

服务器块定义了虚拟服务器的配置,而位置块用于匹配客户端请求的URL路径。

2.处理客户端请求:Nginx维护一个主事件循环,用于监听客户端的连接和请求。

当有新的客户端连接到Nginx服务器时,它会创建一个新的连接句柄,并将其加入到事件循环中。

当客户端发送请求时,Nginx会从连接句柄中读取请求数据,并将其解析成HTTP请求。

3.配置解析:Nginx根据配置文件中的服务器块和位置块来确定如何处理请求。

首先,它会根据请求的主机名(Host字段)找到对应的虚拟主机配置。

然后,根据请求的URL路径匹配到对应的位置块。

4.处理静态文件:如果请求的URL路径对应着一个静态文件,Nginx会尝试直接返回该文件。

它会首先检查磁盘上是否存在该文件,如果存在则通过sendfile系统调用将文件内容发送到客户端。

这个过程是高效的,因为文件内容无需经过用户空间和内核空间的拷贝。

5.代理请求:如果请求的URL路径不是静态文件,Nginx会将其转发给对应的后端服务器。

Nginx作为反向代理服务器,能够将请求转发给多个后端服务器,并根据一定的负载均衡算法选择合适的服务器。

Nginx使用代理模块来实现请求的转发和负载均衡。

6.日志记录:Nginx能够记录客户端请求和服务器响应的日志。

管理员可以通过配置文件来指定日志格式和存储位置。

Nginx的日志模块可以记录请求的方法、URL、状态码、响应时间等信息,这对于监控和故障排查非常有用。

7.处理并发连接:Nginx使用多进程或多线程来处理并发的连接。

nginx前端反向代理的原理Nginx是一个高性能、高并发的Web服务器和反向代理服务器,其前端反向代理的原理是通过接收客户端的请求,并将这些请求转发给后端的服务器,然后将结果返回给客户端。

在这篇文章中,我们将一步一步回答关于Nginx前端反向代理的原理,并深入探讨其工作原理和应用场景。

第一步:客户端发送请求当客户端(如浏览器)发送一个HTTP请求时,它会首先将请求发送给Nginx服务器的IP地址和端口。

第二步:Nginx接收请求Nginx监听指定的端口,接收到客户端的请求后,会对请求进行解析,提取出请求的详细信息,比如请求的URL、请求的方式(GET、POST等)以及头部信息等。

第三步:配置反向代理在Nginx的配置文件中,可以通过配置反向代理的方式来指定要将请求转发到的后端服务器的地址和端口。

这个配置可以根据需求进行灵活的调整,可以将请求转发给多个后端服务器,也可以设置负载均衡等策略。

第四步:向后端服务器转发请求Nginx会将客户端的请求按照配置文件中的指定转发给后端服务器。

它会重新组装请求,将原始请求的URL、请求的方式等信息添加到转发给后端服务器的请求头中,并将请求的内容通过TCP/IP协议发送给后端服务器。

第五步:后端服务器处理请求后端服务器接收到Nginx转发的请求后,会根据请求的内容做出相应的处理。

处理的过程和方式根据具体的后端服务器和业务逻辑而定。

后端服务器可以是Web服务器、应用服务器、数据库服务器或其他类型的服务器。

第六步:后端服务器返回结果后端服务器处理完请求后,会生成响应数据,然后将响应数据返回给Nginx。

响应数据包括HTTP响应状态码、响应头和响应体等信息。

第七步:Nginx返回响应给客户端Nginx接收到后端服务器返回的响应数据后,会重新组装响应,并将响应发送回客户端。

Nginx将响应数据通过TCP/IP协议发送给客户端。

整个过程中,Nginx起到了一个中间层的作用。

Nginx服务器的基本原理和配置指南(英文介绍):Basic Principles of Nginx ServerNginx is a high-performance web server and reverse proxy that is renowned for its efficiency, stability, and low resource consumption. It utilizes an event-driven, asynchronous, non-blocking architecture, which allows it to handle a large number of concurrent connections efficiently.The core components of Nginx include a master process and multiple worker processes. The master process manages the worker processes, while the worker processes handle incoming requests. This architecture enables Nginx to make use of multi-core processors effectively and provides better performance and reliability.When a request comes in, Nginx routes it to the appropriate worker process based on a scheduling algorithm. The worker process then processes the request, which may involve retrieving static files, proxying the request to another server, or performing other tasks depending on the server's configuration.One of the key features of Nginx is its support for reverse proxying with load balancing. This allows Nginx to distribute incoming requests across multiple backend servers, improving performance and reliability. Additionally, Nginx provides a range of modules that can be used to enhance its functionality, such as SSL/TLS support for secure connections and gzip compression to reduce the size of transmitted data.Configuration Guidelines for Nginx ServerConfiguring Nginx involves editing its configuration file, typically locatedat /etc/nginx/nginx.conf or a similar path depending on the installation. The configuration file consists of various directives that define how Nginx should handle incoming requests.Some key directives include:•server: Defines a virtual server, specifying the domain name, port, and other related settings.•location: Specifies how to respond to different request URIs within a server block.•proxy_pass: Directs requests to a specified proxy server or upstream group.•listen: Specifies the IP address and port on which Nginx should listen for incoming connections.Additionally, Nginx supports a wide range of other directives for fine-tuning its behavior, such as setting up SSL/TLS, enabling gzip compression, and configuring access logs.To apply changes to the configuration, Nginx needs to be reloaded or restarted. This can be done using commands like sudo service nginx reload or sudo systemctl reload nginx.It's important to note that improper configuration can lead to issues such as security vulnerabilities or performance degradation. Therefore, it's crucial to carefully review and test any changes made to the Nginx configuration before deploying them to a production environment.Nginx服务器的基本原理和配置指南(中文介绍):Nginx服务器的基本原理Nginx是一款高性能的Web服务器和反向代理服务器,以其高效、稳定和低资源消耗而闻名。

最近有打算研读nginx源代码,看到网上介绍nginx可以作为一个反向代理服务器完成负载均衡。

所以搜罗了一些关于反向代理服务器的内容,整理综合。

一概述

反向代理(Reverse Proxy)方式是指以代理服务器来接受Internet上的连接请求,然后将请求转发给内部网络上的服务器;并将从服务器上得到的结果返回给Internet上请求连接的客户端,此时代理服务器对外就表现为一个服务器。

通常的代理服务器,只用于代理内部网络对Internet的连接请求,客户机必须指定代理服务器,并将本来要直接发送到Web服务器上的http请求发送到代理服务器中。

当一个代理服务器能够代理外部网络上的主机,访问内部网络时,这种代理服务的方式称为反向代理服务。

图1 反向代理服务器的基本原理

二反向代理服务器的工作原理

反向代理服务器通常有两种模型,它可以作为内容服务器的替身,也可以作为内容服务器集群的负载均衡器。

1,作内容服务器的替身

如果您的内容服务器具有必须保持安全的敏感信息,如信用卡号数据库,可在防火墙外部设置一个代理服务器作为内容服务器的替身。

当外部客户机尝试访问内容服务器时,会将其送到代理服务器。

实际内容位于内容服务器上,在防火

墙内部受到安全保护。

代理服务器位于防火墙外部,在客户机看来就像是内容服务器。

当客户机向提出请求时,请求将转到代理服务器。

然后,代理服务器通过防火墙中的特定通路,将客户机的请求发送到内容服务器。

内容服务器再通过该通道将结果回传给代理服务器。

代理服务器将检索到的信息发送给客户机,好像代理服务器就是实际的内容服务器(参见图 2)。

如果内容服务器返回错误消息,代理服务器会先行截取该消息并更改标头中列出的任何 URL,然后再将消息发送给客户机。

如此可防止外部客户机获取内部内容服务器的重定向 URL。

这样,代理服务器就在安全数据库和可能的恶意攻击之间提供了又一道屏障。

与有权访问整个数据库的情况相对比,就算是侥幸攻击成功,作恶者充其量也仅限于访问单个事务中所涉及的信息。

未经授权的用户无法访问到真正的内容服务器,因为防火墙通路只允许代理服务器有权进行访问。

图2 反向代理服务器作为内容服务器的替身

可以配置防火墙路由器,使其只允许特定端口上的特定服务器(在本例中为其所分配端口上的代理服务器)有权通过防火墙进行访问,而不允许其他任何机器进出。

2,作为内容服务器的负载均衡器

可以在一个组织内使用多个代理服务器来平衡各 Web 服务器间的网络负载。

在此模型中,可以利用代理服务器的高速缓存特性,创建一个用于负载平衡的服务器池。

此时,代理服务器可以位于防火墙的任意一侧。

如果 Web 服务器每天都会接收大量的请求,则可以使用代理服务器分担 Web 服务器的负载并提高网络访问效率。

对于客户机发往真正服务器的请求,代理服务器起着中间调停者的作用。

代理服务器会将所请求的文档存入高速缓存。

如果有不止一个代理服务器,DNS 可

以采用“循环复用法”选择其 IP 地址,随机地为请求选择路由。

客户机每次都使用同一个 URL,但请求所采取的路由每次都可能经过不同的代理服务器。

可以使用多个代理服务器来处理对一个高用量内容服务器的请求,这样做的好处是内容服务器可以处理更高的负载,并且比其独自工作时更有效率。

在初始启动期间,代理服务器首次从内容服务器检索文档,此后,对内容服务器的请求数会大大下降。

图3 反向代理服务器作为负载均衡器。