人工智能实践:Tensorflow笔记 北京大学 7 第七讲卷积网络基础 (7.3.1) 助教的Tenso

- 格式:pdf

- 大小:2.19 MB

- 文档页数:31

实习报告:人工智能实践实习经历一、实习背景随着科技的飞速发展,人工智能(AI)已经成为当今社会的一大热点。

作为计算机科学专业的学生,我一直对人工智能领域充满好奇,并希望通过实践锻炼自己的能力。

在这个暑假,我幸运地获得了一次在一家知名人工智能公司实习的机会。

在这份实习报告中,我将分享我在实习期间的学习和工作经验,以及人工智能领域的实践应用。

二、实习内容实习期间,我参与了公司的一个项目,旨在开发一款基于人工智能的音乐推荐系统。

该系统利用深度学习技术对用户听歌行为进行分析,从而为用户提供个性化的音乐推荐。

在项目过程中,我主要负责以下工作:1. 数据处理:在项目开始阶段,我们需要对大量音乐数据进行预处理,包括数据清洗、特征提取等。

我学习了如何使用Python的Pandas库进行数据处理,并掌握了相关数据处理技巧。

2. 模型训练:接下来,我参与了基于TensorFlow的深度学习模型的开发。

我学习了卷积神经网络(CNN)和循环神经网络(RNN)的基本原理,并掌握了模型训练、评估和优化方法。

3. 模型部署:为了将模型应用于实际场景,我们需要将其部署到服务器上。

我学习了使用Flask框架搭建Web应用,并将模型集成到应用中。

通过这一过程,我了解了服务器配置、模型部署等实际操作。

4. 系统测试与优化:在系统开发完成后,我们需要对系统进行测试,以保证其稳定性和可靠性。

我参与了系统测试工作,并针对发现的问题进行了一系列优化。

三、实习收获通过这次实习,我不仅在理论上加深了对人工智能领域的理解,还提高了自己的实际操作能力。

以下是我在实习过程中的一些收获:1. 掌握了Python编程和相关库的使用,如Pandas、TensorFlow、Flask等。

2. 学会了深度学习的基本原理和模型训练方法,如CNN、RNN等。

3. 了解了服务器配置、模型部署等实际操作,提高了自己的实际动手能力。

4. 学会了与他人协作,提高了团队协作能力。

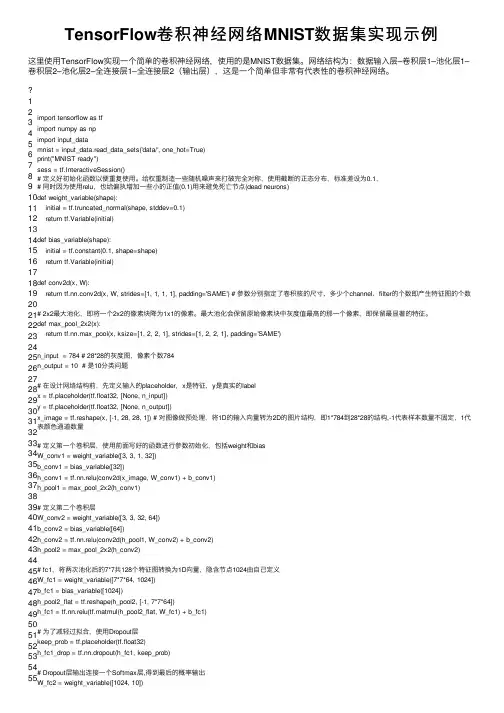

TensorFlow卷积神经⽹络MNIST数据集实现⽰例这⾥使⽤TensorFlow实现⼀个简单的卷积神经⽹络,使⽤的是MNIST数据集。

⽹络结构为:数据输⼊层–卷积层1–池化层1–卷积层2–池化层2–全连接层1–全连接层2(输出层),这是⼀个简单但⾮常有代表性的卷积神经⽹络。

12 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55import tensorflow as tfimport numpy as npimport input_datamnist =input_data.read_data_sets('data/', one_hot=True)print("MNIST ready")sess =tf.InteractiveSession()# 定义好初始化函数以便重复使⽤。

给权重制造⼀些随机噪声来打破完全对称,使⽤截断的正态分布,标准差设为0.1,# 同时因为使⽤relu,也给偏执增加⼀些⼩的正值(0.1)⽤来避免死亡节点(dead neurons)def weight_variable(shape):initial =tf.truncated_normal(shape, stddev=0.1)return tf.Variable(initial)def bias_variable(shape):initial =tf.constant(0.1, shape=shape)return tf.Variable(initial)def conv2d(x, W):return tf.nn.conv2d(x, W, strides=[1, 1, 1, 1], padding='SAME') # 参数分别指定了卷积核的尺⼨、多少个channel、filter的个数即产⽣特征图的个数# 2x2最⼤池化,即将⼀个2x2的像素块降为1x1的像素。

《人工智能概论》课程笔记第一章人工智能概述1.1 人工智能的概念人工智能(Artificial Intelligence,简称AI)是指使计算机具有智能行为的技术。

智能行为包括视觉、听觉、语言、学习、推理等多种能力。

人工智能的研究目标是让计算机能够模拟人类智能的某些方面,从而实现自主感知、自主决策和自主行动。

人工智能的研究领域非常广泛,包括机器学习、计算机视觉、自然语言处理、知识表示与推理等。

1.2 人工智能的产生与发展人工智能的概念最早可以追溯到上世纪50 年代。

1950 年,Alan Turing 发表了著名的论文《计算机器与智能》,提出了“图灵测试”来衡量计算机是否具有智能。

1956 年,在达特茅斯会议上,John McCarthy 等人首次提出了“人工智能”这个术语,并确立了人工智能作为一个独立的研究领域。

人工智能的发展可以分为几个阶段:(1)推理期(1956-1969):主要研究基于逻辑的符号操作和自动推理。

代表性成果包括逻辑推理、专家系统等。

(2)知识期(1970-1980):研究重点转向知识表示和知识工程,出现了专家系统。

代表性成果包括产生式系统、框架等。

(3)机器学习期(1980-1990):机器学习成为人工智能的重要分支,研究如何让计算机从数据中学习。

代表性成果包括决策树、神经网络等。

(4)深度学习期(2006-至今):深度学习技术的出现,推动了计算机视觉、自然语言处理等领域的发展。

代表性成果包括卷积神经网络、循环神经网络等。

1.3 人工智能的三大学派人工智能的研究可以分为三大学派:(1)符号主义学派:认为智能行为的基础是符号操作和逻辑推理。

符号主义学派的研究方法包括逻辑推理、知识表示、专家系统等。

(2)连接主义学派:认为智能行为的基础是神经网络和机器学习。

连接主义学派的研究方法包括人工神经网络、深度学习、强化学习等。

(3)行为主义学派:认为智能行为的基础是感知和行动。

行为主义学派的研究方法包括遗传算法、蚁群算法、粒子群算法等。

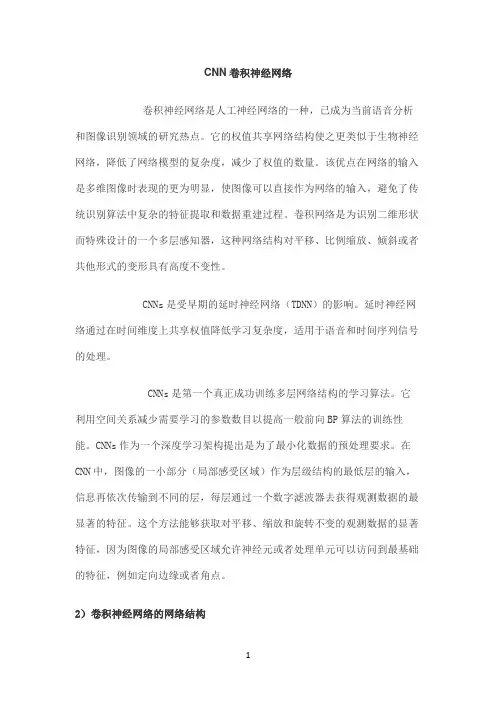

CNN卷积神经网络卷积神经网络是人工神经网络的一种,已成为当前语音分析和图像识别领域的研究热点。

它的权值共享网络结构使之更类似于生物神经网络,降低了网络模型的复杂度,减少了权值的数量。

该优点在网络的输入是多维图像时表现的更为明显,使图像可以直接作为网络的输入,避免了传统识别算法中复杂的特征提取和数据重建过程。

卷积网络是为识别二维形状而特殊设计的一个多层感知器,这种网络结构对平移、比例缩放、倾斜或者共他形式的变形具有高度不变性。

CNNs是受早期的延时神经网络(TDNN)的影响。

延时神经网络通过在时间维度上共享权值降低学习复杂度,适用于语音和时间序列信号的处理。

CNNs是第一个真正成功训练多层网络结构的学习算法。

它利用空间关系减少需要学习的参数数目以提高一般前向BP算法的训练性能。

CNNs作为一个深度学习架构提出是为了最小化数据的预处理要求。

在CNN中,图像的一小部分(局部感受区域)作为层级结构的最低层的输入,信息再依次传输到不同的层,每层通过一个数字滤波器去获得观测数据的最显著的特征。

这个方法能够获取对平移、缩放和旋转不变的观测数据的显著特征,因为图像的局部感受区域允许神经元或者处理单元可以访问到最基础的特征,例如定向边缘或者角点。

2)卷积神经网络的网络结构图:卷积神经网络的概念示范:输入图像通过和三个可训练的滤波器和可加偏置进行卷积,滤波过程如图一,卷积后在C1层产生三个特征映射图,然后特征映射图中每组的四个像素再进行求和,加权值,加偏置,通过一个Sigmoid函数得到三个S2层的特征映射图。

这些映射图再进过滤波得到C3层。

这个层级结构再和S2一样产生S4。

最终,这些像素值被光栅化,并连接成一个向量输入到传统的神经网络,得到输出。

一般地,C层为特征提取层,每个神经元的输入与前一层的局部感受野相连,并提取该局部的特征,一旦该局部特征被提取后,它与其他特征间的位置关系也随之确定下来;S层是特征映射层,网络的每个计算层由多个特征映射组成,每个特征映射为一个平面,平面上所有神经元的权值相等。

TensorFlow机器学习基础教程TensorFlow是一种开源的机器学习框架,它广泛应用于各种领域,如计算机视觉、自然语言处理和深度学习等。

本文将对TensorFlow的基础知识进行介绍,并按类划分为以下几个章节。

第一章:TensorFlow简介TensorFlow是由Google开发的一个用于机器学习和深度学习的库。

它提供了一个灵活而高效的工具,可以用于构建、训练和部署各种机器学习模型。

TensorFlow的核心是张量(Tensor)和计算图(Graph),通过构建计算图来定义模型的计算过程,并通过张量来传递数据。

第二章:张量和计算图张量是TensorFlow中的核心概念之一。

它类似于多维数组,用于存储和传递数据。

TensorFlow中的计算过程是基于计算图的,计算图是一种数据流图,图中的节点表示计算操作,边表示数据流动的方向。

通过构建计算图,TensorFlow可以有效地执行各种计算操作,并自动进行梯度计算和优化。

第三章:TensorFlow的基本操作TensorFlow提供了一系列的操作和函数,用于构建和执行机器学习模型。

常见的操作包括张量的创建、变形、切片和合并等。

此外,TensorFlow还提供了各种计算函数,如矩阵乘法、激活函数、损失函数和优化器等。

通过这些操作和函数,可以方便地进行各种机器学习任务。

第四章:TensorFlow的模型构建TensorFlow通过组合各种操作和函数,可以构建各种机器学习模型。

常见的模型包括线性回归、逻辑回归、多层感知机和卷积神经网络等。

对于每个模型,可以定义模型的结构和参数,并通过计算图来实现模型的前向传播和反向传播。

通过反向传播,可以自动计算模型的梯度,并使用优化器来更新模型的参数。

第五章:TensorFlow的模型训练在构建好模型后,可以使用TensorFlow进行模型训练。

模型训练是通过迭代的方式来优化模型的参数,使模型的预测结果接近于真实标签。

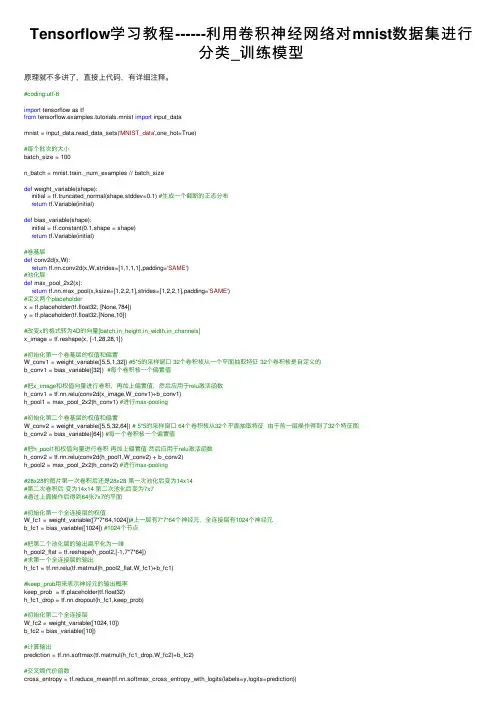

Tensorflow学习教程------利⽤卷积神经⽹络对mnist数据集进⾏分类_训练模型原理就不多讲了,直接上代码,有详细注释。

#coding:utf-8import tensorflow as tffrom tensorflow.examples.tutorials.mnist import input_datamnist = input_data.read_data_sets('MNIST_data',one_hot=True)#每个批次的⼤⼩batch_size = 100n_batch = mnist.train._num_examples // batch_sizedef weight_variable(shape):initial = tf.truncated_normal(shape,stddev=0.1) #⽣成⼀个截断的正态分布return tf.Variable(initial)def bias_variable(shape):initial = tf.constant(0.1,shape = shape)return tf.Variable(initial)#卷基层def conv2d(x,W):return tf.nn.conv2d(x,W,strides=[1,1,1,1],padding='SAME')#池化层def max_pool_2x2(x):return tf.nn.max_pool(x,ksize=[1,2,2,1],strides=[1,2,2,1],padding='SAME')#定义两个placeholderx = tf.placeholder(tf.float32, [None,784])y = tf.placeholder(tf.float32,[None,10])#改变x的格式转为4D的向量[batch,in_height,in_width,in_channels]x_image = tf.reshape(x, [-1,28,28,1])#初始化第⼀个卷基层的权值和偏置W_conv1 = weight_variable([5,5,1,32]) #5*5的采样窗⼝ 32个卷积核从⼀个平⾯抽取特征 32个卷积核是⾃定义的b_conv1 = bias_variable([32]) #每个卷积核⼀个偏置值#把x_image和权值向量进⾏卷积,再加上偏置值,然后应⽤于relu激活函数h_conv1 = tf.nn.relu(conv2d(x_image,W_conv1)+b_conv1)h_pool1 = max_pool_2x2(h_conv1) #进⾏max-pooling#初始化第⼆个卷基层的权值和偏置W_conv2 = weight_variable([5,5,32,64]) # 5*5的采样窗⼝ 64个卷积核从32个平⾯抽取特征由于前⼀层操作得到了32个特征图b_conv2 = bias_variable([64]) #每⼀个卷积核⼀个偏置值#把h_pool1和权值向量进⾏卷积再加上偏置值然后应⽤于relu激活函数h_conv2 = tf.nn.relu(conv2d(h_pool1,W_conv2) + b_conv2)h_pool2 = max_pool_2x2(h_conv2) #进⾏max-pooling#28x28的图⽚第⼀次卷积后还是28x28 第⼀次池化后变为14x14#第⼆次卷积后变为14x14 第⼆次池化后变为7x7#通过上⾯操作后得到64张7x7的平⾯#初始化第⼀个全连接层的权值W_fc1 = weight_variable([7*7*64,1024])#上⼀层有7*7*64个神经元,全连接层有1024个神经元b_fc1 = bias_variable([1024]) #1024个节点#把第⼆个池化层的输出扁平化为⼀维h_pool2_flat = tf.reshape(h_pool2,[-1,7*7*64])#求第⼀个全连接层的输出h_fc1 = tf.nn.relu(tf.matmul(h_pool2_flat,W_fc1)+b_fc1)#keep_prob⽤来表⽰神经元的输出概率keep_prob = tf.placeholder(tf.float32)h_fc1_drop = tf.nn.dropout(h_fc1,keep_prob)#初始化第⼆个全连接层W_fc2 = weight_variable([1024,10])b_fc2 = bias_variable([10])#计算输出prediction = tf.nn.softmax(tf.matmul(h_fc1_drop,W_fc2)+b_fc2)#交叉熵代价函数cross_entropy = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits(labels=y,logits=prediction))#使⽤AdamOptimizer进⾏优化train_step = tf.train.AdamOptimizer(1e-4).minimize(cross_entropy)#结果存放在⼀个布尔列表中correct_prediction = tf.equal(tf.argmax(prediction,1),tf.argmax(y,1)) #argmax返回⼀维张量中最⼤的值所在的位置#求准确率accuracy = tf.reduce_mean(tf.cast(correct_prediction,tf.float32))saver = tf.train.Saver()with tf.Session() as sess:sess.run(tf.global_variables_initializer())for epoch in range(50):for batch in range(n_batch):batch_xs,batch_ys = mnist.train.next_batch(batch_size)sess.run(train_step,feed_dict={x:batch_xs,y:batch_ys,keep_prob:0.7})acc = sess.run(accuracy,feed_dict={x:mnist.test.images,y:bels,keep_prob:1.0}) print ("Iter "+ str(epoch) + ", Testing Accuracy= " + str(acc)) saver.save(sess,save_path='/home/xxx/logs/mnistmodel',global_step=1)#将训练出来的权重参数保存结果Iter 0, Testing Accuracy= 0.8517Iter 1, Testing Accuracy= 0.9612Iter 2, Testing Accuracy= 0.9769Iter 3, Testing Accuracy= 0.9804Iter 4, Testing Accuracy= 0.9832Iter 5, Testing Accuracy= 0.9844Iter 6, Testing Accuracy= 0.988Iter 7, Testing Accuracy= 0.9882Iter 8, Testing Accuracy= 0.9875Iter 9, Testing Accuracy= 0.9889Iter 10, Testing Accuracy= 0.9891Iter 11, Testing Accuracy= 0.9897Iter 12, Testing Accuracy= 0.9891Iter 13, Testing Accuracy= 0.9897Iter 14, Testing Accuracy= 0.9905Iter 15, Testing Accuracy= 0.9913Iter 16, Testing Accuracy= 0.9908Iter 17, Testing Accuracy= 0.9909Iter 18, Testing Accuracy= 0.9913Iter 19, Testing Accuracy= 0.9915Iter 20, Testing Accuracy= 0.9902Iter 21, Testing Accuracy= 0.9899Iter 22, Testing Accuracy= 0.9912Iter 23, Testing Accuracy= 0.9911Iter 24, Testing Accuracy= 0.9907Iter 25, Testing Accuracy= 0.9918Iter 26, Testing Accuracy= 0.9919Iter 27, Testing Accuracy= 0.9916Iter 28, Testing Accuracy= 0.9899Iter 29, Testing Accuracy= 0.9924Iter 30, Testing Accuracy= 0.9913Iter 31, Testing Accuracy= 0.992Iter 32, Testing Accuracy= 0.9927Iter 33, Testing Accuracy= 0.9919Iter 34, Testing Accuracy= 0.9922Iter 35, Testing Accuracy= 0.9918Iter 36, Testing Accuracy= 0.9932Iter 37, Testing Accuracy= 0.9924Iter 38, Testing Accuracy= 0.9917Iter 39, Testing Accuracy= 0.9919Iter 40, Testing Accuracy= 0.9933Iter 41, Testing Accuracy= 0.9924Iter 42, Testing Accuracy= 0.9926Iter 43, Testing Accuracy= 0.9932Iter 44, Testing Accuracy= 0.9922Iter 45, Testing Accuracy= 0.9925Iter 46, Testing Accuracy= 0.9928Iter 47, Testing Accuracy= 0.9935Iter 48, Testing Accuracy= 0.9922Iter 49, Testing Accuracy= 0.9926。

【机器学习基础】卷积神经⽹络(CNN)基础最近⼏天陆续补充了⼀些“线性回归”部分内容,这节继续机器学习基础部分,这节主要对CNN的基础进⾏整理,仅限于基础原理的了解,更复杂的内容和实践放在以后再进⾏总结。

卷积神经⽹络的基本原理 前⾯对全连接神经⽹络和深度学习进⾏了简要的介绍,这⼀节主要对卷积神经⽹络的基本原理进⾏学习和总结。

所谓卷积,就是通过⼀种数学变换的⽅式来对特征进⾏提取,通常⽤于图⽚识别中。

既然全连接的神经⽹络可以⽤于图⽚识别,那么为什么还要⽤卷积神经⽹络呢?(1)⾸先来看下⾯⼀张图⽚: 在这个图⽚当中,鸟嘴是⼀个很明显的特征,当我们做图像识别时,当识别到有“鸟嘴”这样的特征时,可以具有很⾼的确定性认为图⽚是⼀个鸟类。

那么,在提取特征的过程中,有时就没有必要去看完整张图⽚,只需要⼀⼩部分就能识别出⼀定具有代表的特征。

因此,使⽤卷积就可以使某⼀个特定的神经元(在这⾥,这个神经元可能就是⽤来识别“鸟嘴”的)仅仅处理带有该特征的部分图⽚就可以了,⽽不必去看整张图⽚。

那么这样就会使得这个神经元具有更少的参数(因为不⽤再跟图⽚的每⼀维输⼊都连接起来)。

(2)再来看下⾯⼀组图⽚:上⾯两张图⽚都是鸟类,⽽不同的是,两只鸟的“鸟嘴”的位置不同,但在普通的神经⽹络中,需要有两个神经元,⼀个去识别左上⾓的“鸟嘴”,另⼀个去识别中间的“鸟嘴”: 但其实这两个“鸟嘴”的形状是⼀样的,这样相当于上⾯两个神经元是在做同⼀件事情。

⽽在卷积神经⽹络中,这两个神经元可以共⽤⼀套参数,⽤来做同⼀件事情。

(3)对样本进⾏⼦采样,往往不会影响图⽚的识别。

如下⾯⼀张图: 假设把⼀张图⽚当做⼀个矩阵的话,取矩阵的奇数⾏和奇数列,可看做是对图⽚的⼀种缩放,⽽这种缩放往往不会影响识别效果。

卷积神经⽹络中就可以对图⽚进⾏缩放,是图⽚变⼩,从⽽减少模型的参数。

卷积神经⽹络的基本结构如图所⽰: 从右到左,输⼊⼀张图⽚→卷积层→max pooling(池化层)→卷积层→max pooling(池化层)→......→展开→全连接神经⽹络→输出。

卷积神经网络入门教程随着人工智能的快速发展,卷积神经网络(Convolutional Neural Network,简称CNN)已经成为图像识别、语音识别等领域中最常用的深度学习模型之一。

本文将为大家介绍卷积神经网络的基本原理、结构和训练方法。

一、卷积神经网络的基本原理卷积神经网络是一种受到生物视觉系统启发的深度学习模型,其核心思想是通过卷积操作和池化操作来提取图像的特征。

在卷积层中,网络通过滑动一个卷积核在输入图像上进行卷积操作,提取图像的局部特征。

卷积操作可以有效地减少参数数量,提高计算效率,并且具有平移不变性的特点。

在池化层中,网络通过降采样操作来减小特征图的尺寸,同时保留主要特征。

通过多次堆叠卷积层和池化层,网络可以逐渐提取出图像的高级特征。

二、卷积神经网络的结构卷积神经网络通常由卷积层、池化层、全连接层和输出层组成。

卷积层和池化层用于提取图像的特征,全连接层用于将提取到的特征映射到具体的类别上,输出层用于输出分类结果。

网络的结构可以根据任务的复杂程度进行设计,常见的结构有LeNet-5、AlexNet、VGG、GoogLeNet和ResNet等。

这些结构在深度和参数数量上有所不同,但都遵循了卷积神经网络的基本原理。

三、卷积神经网络的训练方法卷积神经网络的训练通常使用反向传播算法和梯度下降法。

首先,网络通过前向传播计算出预测结果,并计算出预测结果与真实标签之间的误差。

然后,通过反向传播算法计算出每个参数对误差的贡献,并使用梯度下降法来更新参数。

这个过程不断迭代,直到网络的预测结果与真实标签的误差达到一个接受的范围。

在训练过程中,还可以采用一些技巧来提高网络的性能。

例如,可以使用批量归一化(Batch Normalization)来加速网络的收敛速度,减少梯度消失的问题。

还可以使用dropout来防止过拟合,提高网络的泛化能力。

此外,还可以使用数据增强(Data Augmentation)来增加训练集的多样性,提高网络的鲁棒性。

人工智能实训课程学习总结使用Python实现卷积神经网络的学习心得在人工智能领域,深度学习算法占据了重要的地位,而卷积神经网络(Convolutional Neural Network,简称CNN)被广泛应用于图像处理、语音识别等各个领域。

本文将总结我在人工智能实训课程中使用Python实现卷积神经网络的学习心得。

首先,学习Python编程语言是使用卷积神经网络的必备基础。

Python作为一种简洁、灵活的编程语言,具有丰富的第三方库和工具,适用于各种机器学习任务。

在学习过程中,我通过阅读Python的相关文档和教程,提高了自己的Python编程能力,掌握了基本的语法和常用的编程技巧。

其次,在实现卷积神经网络之前,我了解了卷积神经网络的原理和基本结构。

卷积神经网络由输入层、卷积层、池化层、全连接层和输出层等组成。

其中,卷积层和池化层的作用是通过对输入数据的卷积和下采样操作提取图像的特征信息,全连接层则用于将提取到的特征映射到输出。

了解卷积神经网络的结构和原理对于实现过程起到了指导作用。

然后,我利用Python的深度学习库Keras进行卷积神经网络的实现。

Keras是一个高级的神经网络API,提供了一种快速实现深度学习模型的方法。

在使用Keras之前,我安装了TensorFlow作为其后台引擎,这样可以更高效地运行深度学习模型。

Keras提供了丰富的API和函数,使得卷积神经网络的实现过程更加简洁和易于理解。

接着,在实现卷积神经网络时,我首先准备了合适的训练数据集。

对于图像分类任务,通常需要一个包含训练图像和对应标签的数据集。

通过准备好的数据集,我可以将其加载到模型中进行训练和测试。

在加载数据集时,我使用了Python的NumPy库进行矩阵运算和数据预处理,以保证数据的准确性和可用性。

然后,我根据卷积神经网络的结构,在Keras中实现了相应的模型。

通过定义模型的层次结构和参数设置,我可以构建一个完整的卷积神经网络模型。

在深度学习领域中,卷积神经网络(CNN)是一种被广泛应用的神经网络模型,而 TensorFlow 作为一个流行的深度学习框架,有着丰富的卷积种类。

本文将针对 TensorFlow 中的卷积种类进行全面评估,并根据深度和广度的要求撰写一篇有价值的文章。

让我们从简单的卷积层开始讨论。

在 TensorFlow 中,最基本的卷积层是二维卷积层,它通常用于处理图像数据。

二维卷积层可以通过指定卷积核的大小、步长和填充方式来实现不同的卷积效果。

这种类型的卷积层是深度学习中最常见的一种,其简单直观的运算方式使其易于理解和应用。

接下来,我们可以深入探讨 TensorFlow 中的其他卷积种类。

除了二维卷积层外,TensorFlow 还支持许多其他类型的卷积层,如一维卷积层、三维卷积层等。

这些不同种类的卷积层可以用于处理不同维度的数据,例如文本数据、时间序列数据等。

通过灵活地使用不同种类的卷积层,我们可以更好地适应不同类型的数据,从而提高模型的性能和泛化能力。

TensorFlow 还提供了丰富的卷积变种,如深度可分离卷积、转置卷积等。

这些卷积变种可以在特定的场景下发挥重要作用,例如在移动端模型部署中的轻量化设计、图像分割中的语义信息提取等。

熟练掌握这些卷积变种的特点和应用方法,对于深度学习工程师而言至关重要。

在文章的总结部分,我们可以回顾所涉及的卷积种类,并总结它们的特点和适用场景。

通过对 TensorFlow 中的卷积种类进行全面评估,我们不仅可以更深入地理解卷积神经网络的原理和应用,还可以掌握灵活运用不同卷积种类解决实际问题的能力。

就我个人对 TensorFlow 中的卷积种类的理解和观点而言,我认为熟练掌握不同种类的卷积层和卷积变种,是成为一名优秀的深度学习工程师必不可少的技能。

只有在深入理解和灵活运用不同卷积种类的基础上,我们才能更好地应对复杂多变的实际问题,创造出更加优秀的深度学习模型。

通过对 TensorFlow 中的卷积种类进行全面评估,并据此撰写有价值的文章,我们不仅可以加深对卷积神经网络原理和应用的理解,还可以提升我们在深度学习领域的实战能力。

卷积神经网络,还是这样理解更简单!PyTorch深度学习入门互联网发展至今,已经存储了海量的网络图片,但是这些图片被形象地称为互联网的“暗物质”,因为现在的计算机还难以分类或识别这些非结构性的图片数据。

在早期的图像识别研究中,使用人工提取的特征造成识别效果不佳。

卷积神经网络(Convolutional Neural Network, CNN)的出现给图像识别领域带来了崭新的风气,如今,CNN图像识别技术的正确率已经可以达到人类水平。

卷积神经网络的兴起大大促进了深度学习研究的发展。

下面我们来研究下卷积神经网络的基本原理,为接下来的实战打好基础。

仿生模型20 世纪60 年代,神经科学家们研究了猫的脑皮层中用于局部敏感和方向选择的神经元,在这个过程中,他们发现猫的脑皮层所具有的独特网络结构可以有效地降低反馈神经网络的复杂性,研究结果显示:视觉系统的信息处理是分级的。

大脑分层处理的视觉原理如图1所示:首先,光信号进入瞳孔(视网膜),接着大脑皮层的初级视觉细胞(即V1 区)对信号进行初步处理,发现图像的边缘和方向;然后进入下一层视觉细胞(即V2 区)进行抽象,发现物体的形状;最后在V4 区进一步抽象出物体的概念。

图1 人脑视觉处理机制卷积神经网络模型的物体识别模仿了人脑的视觉处理机制,采用分级提取特征的原理,每一级的特征均由网络学习提取,识别效果优于人工选取特征的算法。

例如在人脸识别过程中,最底层特征基本上是各方向上的边缘,越往上的神经层越能提取出人脸的局部特征(比如眼睛、嘴巴、鼻子等),最上层由不同的高级特征组合成人脸的图像。

该模型最早在1998 年由Yann LeCun 提出并应用在手写字体识别上(MINST),LeCun 提出的网络称为LeNet,其网络结构如图2所示,输入的手写字体图片经过两次卷积和池化,进入全连接层后分类输出10 种结果。

图2 LeNet 结构示意图LeNet 结构简单却完美地诠释了卷积神经网络的结构和其惊人的识别成效,被称为深度神经网络的“果蝇”。

实习报告:人工智能实习体验一、实习背景及目的随着科技的飞速发展,人工智能(Artificial Intelligence,AI)逐渐成为热点领域,吸引了众多企业和科研机构投身于相关技术的研究与开发。

在我国,政府高度重视人工智能产业的发展,提出了一系列政策措施,为人工智能的发展创造了良好的环境。

在此背景下,我选择了人工智能作为实习方向,以期提高自己的专业技能,为未来的职业发展打下坚实基础。

本次实习的主要目的是:1. 了解人工智能的基本概念、技术体系和应用领域;2. 学习并掌握一些常用的人工智能算法和工具;3. 结合实际项目,锻炼自己的动手能力和团队协作能力;4. 紧跟行业动态,了解人工智能领域的前沿技术和发展趋势。

二、实习内容及过程实习期间,我参与了以下几个方面的工作:1. 学习人工智能基础知识:通过阅读相关书籍、论文和在线教程,掌握了人工智能的基本概念、技术体系和应用领域。

了解了机器学习、深度学习、自然语言处理等关键技术,学习了监督学习、无监督学习、强化学习等学习方法。

2. 学习并实践常用人工智能算法:学习了线性回归、逻辑回归、支持向量机、决策树、随机森林等经典算法,并使用Python等编程语言实现了这些算法。

同时,学习了TensorFlow、Keras等深度学习框架,并利用它们实现了卷积神经网络(CNN)、循环神经网络(RNN)等深度学习模型。

3. 参与实际项目:在导师的指导下,参与了公司的一个实际项目,负责数据预处理、模型训练和效果评估等工作。

在项目过程中,学会了如何处理数据不平衡、过拟合等问题,提高了自己的解决问题的能力。

4. 跟进行业动态:通过阅读相关新闻、论文和参加线上讲座,了解了人工智能领域的前沿技术和应用动态,为自己的研究方向提供了指导。

三、实习收获及反思通过本次实习,我收获颇丰,具体表现在以下几个方面:1. 知识层面:学习了人工智能的基本概念、技术体系和应用领域,掌握了常用的人工智能算法和工具,提高了自己的专业素养。

Tensorflow笔记:第七讲卷积神经网络本节目标:学会使用CNN实现对手写数字的识别。

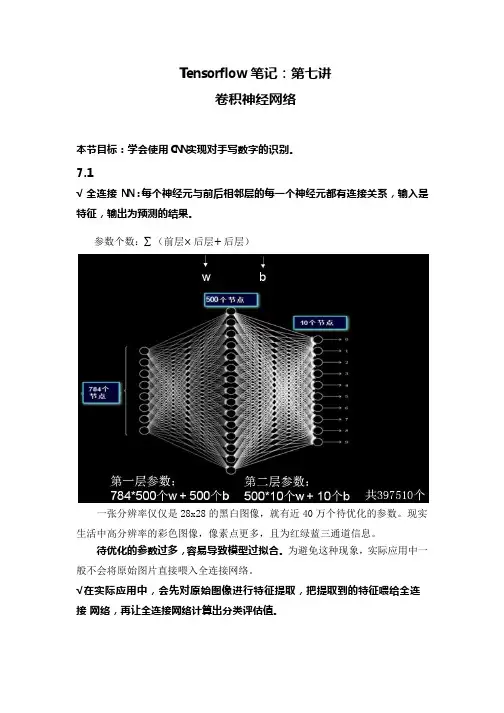

7.1√全连接NN:每个神经元与前后相邻层的每一个神经元都有连接关系,输入是特征,输出为预测的结果。

参数个数:∑(前层×后层+后层)一张分辨率仅仅是28x28的黑白图像,就有近40万个待优化的参数。

现实生活中高分辨率的彩色图像,像素点更多,且为红绿蓝三通道信息。

待优化的参数过多,容易导致模型过拟合。

为避免这种现象,实际应用中一般不会将原始图片直接喂入全连接网络。

√在实际应用中,会先对原始图像进行特征提取,把提取到的特征喂给全连接网络,再让全连接网络计算出分类评估值。

例:先将此图进行多次特征提取,再把提取后的计算机可读特征喂给全连接网络。

√卷积Convolutional卷积是一种有效提取图片特征的方法。

一般用一个正方形卷积核,遍历图片上的每一个像素点。

图片与卷积核重合区域内相对应的每一个像素值乘卷积核内相对应点的权重,然后求和,再加上偏置后,最后得到输出图片中的一个像素值。

例:上面是5x5x1的灰度图片,1表示单通道,5x5表示分辨率,共有5行5列个灰度值。

若用一个3x3x1的卷积核对此5x5x1的灰度图片进行卷积,偏置项b=1,则求卷积的计算是:(-1)x1+0x0+1x2+(-1)x5+0x4+1x2+(-1)x3+0x4+1x5+1=1(注意不要忘记加偏置1)。

输出图片边长=(输入图片边长–卷积核长+1)/步长,此图为:(5 – 3 + 1)/ 1 = 3,输出图片是3x3的分辨率,用了1个卷积核,输出深度是1,最后输出的是3x3x1的图片。

√全零填充Padding有时会在输入图片周围进行全零填充,这样可以保证输出图片的尺寸和输入图片一致。

例:在前面5x5x1的图片周围进行全零填充,可使输出图片仍保持5x5x1的维度。

这个全零填充的过程叫做padding。

输出数据体的尺寸=(W−F+2P)/S+1W:输入数据体尺寸,F:卷积层中神经元感知域,S:步长,P:零填充的数量。

例:输入是7×7,滤波器是3×3,步长为1,填充为0,那么就能得到一个5×5的输出。

如果步长为2,输出就是3×3。

如果输入量是32x32x3,核是5x5x3,不用全零填充,输出是(32-5+1)/1=28,如果要让输出量保持在32x32x3,可以对该层加一个大小为2的零填充。

可以根据需求计算出需要填充几层零。

32=(32-5+2P)/1 +1,计算出P=2,即需填充2层零。

√使用padding和不使用padding的输出维度上一行公式是使用padding的输出图片边长,下一行公式是不使用padding 的输出图片边长。

公式如果不能整除,需要向上取整数。

如果用全零填充,也就是padding=SAME。

如果不用全零填充,也就是padding=VALID。

√Tensorflow给出的计算卷积的函数函数中要给出四个信息:对输入图片的描述、对卷积核的描述、对卷积核滑动步长的描述以及是否使用padding。

1)对输入图片的描述:用batch给出一次喂入多少张图片,每张图片的分辨率大小,比如5行5列,以及这些图片包含几个通道的信息,如果是灰度图则为单通道,参数写1,如果是彩色图则为红绿蓝三通道,参数写3。

2)对卷积核的描述:要给出卷积核的行分辨率和列分辨率、通道数以及用了几个卷积核。

比如上图描述,表示卷积核行列分辨率分别为3行和3列,且是1通道的,一共有16个这样的卷积核,卷积核的通道数是由输入图片的通道数决定的,卷积核的通道数等于输入图片的通道数,所以卷积核的通道数也是1。

一共有16个这样的卷积核,说明卷积操作后输出图片的深度是16,也就是输出为16通道。

3)对卷积核滑动步长的描述:上图第二个参数表示横向滑动步长,第三个参数表示纵向滑动步长。

第一个1和最后一个1这里固定的。

这句表示横向纵向都以1为步长。

4)是否使用padding:用的是VALID。

注意这里是以字符串的形式给出VALID。

√对多通道的图片求卷积多数情况下,输入的图片是RGB三个颜色组成的彩色图,输入的图片包含了红、绿、蓝三层数据,卷积核的深度应该等于输入图片的通道数,所以使用3x3x3的卷积核,最后一个3表示匹配输入图像的3个通道,这样这个卷积核有三层,每层会随机生成9个待优化的参数,一共有27个待优化参数w和一个偏置b。

对于彩色图,按层分解开,可以直观表示为上面这张图,三个颜色分量:红色分量、绿色分量和蓝色分量。

卷积计算方法和单层卷积核相似,卷积核为了匹配红绿蓝三个颜色,把三层的卷积核套在三层的彩色图片上,重合的27个像素进行对应点的乘加运算,最后的结果再加上偏置项b,求得输出图片中的一个值。

这个5x5x3的输入图片加了全零填充,使用3x3x3的卷积核,所有27个点与对应的待优化参数相乘,乘积求和再加上偏置b得到输出图片中的一个值6。

针对上面这幅彩色图片,用conv2d函数实现可以表示为:一次输入batch张图片,输入图片的分辨率是5x5,是3通道的,卷积核是3x3x3,一共有16个卷积核,这样输出的深度就是16,核滑动横向步长是1,纵向步长也是1,padding选择same,保证输出是5x5分辨率。

由于一共用了16个卷积核,所以输出图片是5x5x16。

√池化PoolingTensorflow给出了计算池化的函数。

最大池化用tf.nn.max_pool函数,平均池化用tf.nn.avg_pool函数。

函数中要给出四个信息,对输入的描述、对池化核的描述、对池化核滑动步长的描述和是否使用padding。

1)对输入的描述:给出一次输入batch张图片、行列分辨率、输入通道的个数。

2)对池化核的描述:只描述行分辨率和列分辨率,第一个和最后一个参数固定是1。

3)对池化核滑动步长的描述:只描述横向滑动步长和纵向滑动步长,第一个和最后一个参数固定是1。

4)是否使用padding:padding可以是使用零填充SAME或者不使用零填充VALID。

√舍弃Dropout在神经网络训练过程中,为了减少过多参数常使用dropout的方法,将一部分神经元按照一定概率从神经网络中舍弃。

这种舍弃是临时性的,仅在训练时舍弃一些神经元;在使用神经网络时,会把所有的神经元恢复到神经网络中。

比如上面这张图,在训练时一些神经元不参加神经网络计算了。

Dropout可以有效减少过拟合。

Tensorflow提供的dropout的函数:用tf.nn.dropout函数。

第一个参数链接上一层的输出,第二个参数给出神经元舍弃的概率。

在实际应用中,常常在前向传播构建神经网络时使用dropout来减小过拟合加快模型的训练速度。

dropout一般会放到全连接网络中。

如果在训练参数的过程中,输出=tf.nn.dropout(上层输出,暂时舍弃神经元的概率),这样就有指定概率的神经元被随机置零,置零的神经元不参加当前轮的参数优化。

√卷积NN:借助卷积核(kernel)提取特征后,送入全连接网络。

卷积神经网络可以认为由两部分组成,一部分是对输入图片进行特征提取,另一部分就是全连接网络,只不过喂入全连接网络的不再是原始图片,而是经过若干次卷积、激活和池化后的特征信息。

卷积神经网络从诞生到现在,已经出现了许多经典网络结构,比如Lenet-5、Alenet、VGGNet、GoogleNet和ResNet等。

每一种网络结构都是以卷积、激活、池化、全连接这四种操作为基础进行扩展。

Lenet-5是最早出现的卷积神经网络,由Lecun团队首先提出,Lenet-5有效解决了手写数字的识别问题。

7.2Lenet神经网络是Yann LeCun等人在1998年提出的,该神经网络充分考虑图像的相关性。

√Lenet神经网络结构为:①输入为32*32*1的图片大小,为单通道的输入;②进行卷积,卷积核大小为5*5*1,个数为6,步长为1,非全零填充模式;③将卷积结果通过非线性激活函数;④进行池化,池化大小为2*2,步长为1,全零填充模式;⑤进行卷积,卷积核大小为5*5*6,个数为16,步长为1,非全零填充模式;⑥将卷积结果通过非线性激活函数;⑦进行池化,池化大小为2*2,步长为1,全零填充模式;⑧全连接层进行10分类。

Lenet神经网络的结构图及特征提取过程如下所示:Lenet神经网络结构图Lenet神经网络的输入是32*32*1,经过5*5*1的卷积核,卷积核个数为6个,采用非全零填充方式,步长为1,根据非全零填充计算公式:输出尺寸=(输入尺寸-卷积核尺寸+1)/步长=(32-5+1)/1=28.故经过卷积后输出为28*28*6。

经过第一层池化层,池化大小为2*2,全零填充,步长为2,由全零填充计算公式:输出尺寸=输入尺寸/步长=28/2=14,池化层不改变深度,深度仍为6。

用同样计算方法,得到第二层池化后的输出为5*5*16。

将第二池化层后的输出拉直送入全连接层。

√根据Lenet神经网络的结构可得,Lenet神经网络具有如下特点:①卷积(Conv)、池化(ave-pooling)、非线性激活函数(sigmoid)相互交替;②层与层之间稀疏连接,减少计算复杂度。

√对Lenet神经网络进行微调,使其适应Mnist数据集:由于Mnist数据集中图片大小为28*28*1的灰度图片,而Lenet神经网络的输入为32*32*1,故需要对Lenet神经网络进行微调。

①输入为28*28*1的图片大小,为单通道的输入;②进行卷积,卷积核大小为5*5*1,个数为32,步长为1,全零填充模式;③将卷积结果通过非线性激活函数;④进行池化,池化大小为2*2,步长为2,全零填充模式;⑤进行卷积,卷积核大小为5*5*32,个数为64,步长为1,全零填充模式;⑥将卷积结果通过非线性激活函数;⑦进行池化,池化大小为2*2,步长为2,全零填充模式;⑧全连接层,进行10分类。

Lenet进行微调后的结构如下所示:√Lenet神经网络在Mnist数据集上的实现,主要分为三个部分:前向传播过程(mnist_lenet5_forward.py)、反向传播过程(mnist_lenet5_backword.py)、测试过程(mnist_lenet5_test.py)。

第一,前向传播过程(mnist_lenet5_forward.py)实现对网络中参数和偏置的初始化、定义卷积结构和池化结构、定义前向传播过程。

具体代码如下所示:注释:1)定义前向传播过程中常用到的参数。

图片大小即每张图片分辨率为28*28,故IMAGE_SIZE取值为28;Mnist数据集为灰度图,故输入图片通道数NUM_CHANNELS取值为1;第一层卷积核大小为5,卷积核个数为32,故CONV1_SIZE取值为5,CONV1_KERNEL_NUM取值为32;第二层卷积核大小为5,卷积核个数为64,故CONV2_SIZE取值为5,CONV2_KERNEL_NUM为64;全连接层第一层为512个神经元,全连接层第二层为10个神经元,故FC_SIZE取值为512,OUTPUT_NODE取值为10,实现10分类输出。