神经网络分类器_(2)

- 格式:ppt

- 大小:1.49 MB

- 文档页数:56

49开发应用1 引言用第一次计算的雅可比矩阵的结果,从而在多次迭代中只身份识别鉴定是各行各业保证系统安全的必要措施。

需要求一次雅可比矩阵就可以达到适应迭代的数据变化的在国家安全、司法、金融、电子商务、电子政务等应用领目的,从而可以大大提高迭代的收敛速度,由于多次迭代域迫切需要。

与传统的身份识别系统相比,人脸具有不易过程结合在一起,可以增加每次迭代的修正量,减少收敛伪造、不易窃取、不会遗忘的显著特点;而与指纹、虹膜时需要的迭代次数,避免迭代振荡的情况,使算法获得更等其他生物特征识别相比,人脸识别则具有更自然、友好的收敛性能。

M-FastICA算法继承了FastICA算法不需要好、无侵犯性的明显优势。

选择步长参数,收敛较有保证和所提取的人脸特征有效的2 特征提取优点,而且能进一步减少算法收敛的迭代次数和时间。

人脸特征提取是人脸识别的第一步。

其目标是用最少 3 QGA-BP神经网络分类器设计的特征量来表征人脸,同时要求特征量最大程度地保持不(1)量子遗传算法。

量子遗传算法(Quantum Genetic 同人脸的可区分能力。

研究表明不同的人脸特征提取方法Algorithm QGA)是一种高效的并行算法,建立在量子的态对人脸识别的性能影响很大。

本文采用的特征提取方法是矢量表达基础上。

它改变了传统GA的结构,其染色体不用基于整体的代数特征提取方法。

二进制数、十进制数或符号等来表示,而将量子比特的概(1)ICA算法的原理。

独立分量分析方法是由法国学率幅表示应用于染色体的编码,染色体的状态是一种叠加者Herault和Jutten于1985年提出的,它是一种非常有效的态或纠缠态,并利用量子旋转门实现染色体的更新操作,盲源分离技术 (Blind Sources Separation,BSS)。

它的基引入量子交叉克服了早熟收敛现象。

QGA的遗传操作不是采本思想是用一组独立的基函数来表示一系列随机变量。

用传统GA的选择、交叉和变异等,而是代之以简单的量子独立分量分析在处理高维数据时存在计算量大的缺门运算。

神经网络简介神经网络简介:人工神经网络是以工程技术手段来模拟人脑神经元网络的结构和特征的系统。

利用人工神经网络可以构成各种不同拓扑结构的神经网络,他是生物神经网络的一种模拟和近似。

神经网络的主要连接形式主要有前馈型和反馈型神经网络。

常用的前馈型有感知器神经网络、BP 神经网络,常用的反馈型有Hopfield 网络。

这里介绍BP (Back Propagation )神经网络,即误差反向传播算法。

原理:BP (Back Propagation )网络是一种按误差逆传播算法训练的多层前馈网络,是目前应用最广泛的神经网络模型之一。

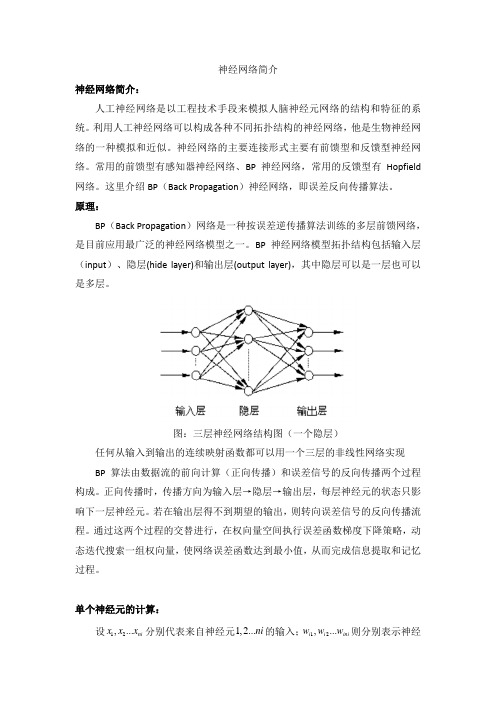

BP 神经网络模型拓扑结构包括输入层(input )、隐层(hide layer)和输出层(output layer),其中隐层可以是一层也可以是多层。

图:三层神经网络结构图(一个隐层)任何从输入到输出的连续映射函数都可以用一个三层的非线性网络实现 BP 算法由数据流的前向计算(正向传播)和误差信号的反向传播两个过程构成。

正向传播时,传播方向为输入层→隐层→输出层,每层神经元的状态只影响下一层神经元。

若在输出层得不到期望的输出,则转向误差信号的反向传播流程。

通过这两个过程的交替进行,在权向量空间执行误差函数梯度下降策略,动态迭代搜索一组权向量,使网络误差函数达到最小值,从而完成信息提取和记忆过程。

单个神经元的计算:设12,...ni x x x 分别代表来自神经元1,2...ni 的输入;12,...i i ini w w w 则分别表示神经元1,2...ni 与下一层第j 个神经元的连接强度,即权值;j b 为阈值;()f ∙为传递函数;j y 为第j 个神经元的输出。

若记001,j j x w b ==,于是节点j 的净输入j S 可表示为:0*nij ij i i S w x ==∑;净输入j S 通过激活函数()f ∙后,便得到第j 个神经元的输出:0()(*),nij j ij i i y f S f w x ===∑激活函数:激活函数()f ∙是单调上升可微函数,除输出层激活函数外,其他层激活函数必须是有界函数,必有一最大值。

习题2.1什么是感知机?感知机的基本结构是什么样的?解答:感知机是Frank Rosenblatt在1957年就职于Cornell航空实验室时发明的一种人工神经网络。

它可以被视为一种最简单形式的前馈人工神经网络,是一种二元线性分类器。

感知机结构:2.2单层感知机与多层感知机之间的差异是什么?请举例说明。

解答:单层感知机与多层感知机的区别:1. 单层感知机只有输入层和输出层,多层感知机在输入与输出层之间还有若干隐藏层;2. 单层感知机只能解决线性可分问题,多层感知机还可以解决非线性可分问题。

2.3证明定理:样本集线性可分的充分必要条件是正实例点集所构成的凸壳与负实例点集构成的凸壳互不相交.解答:首先给出凸壳与线性可分的定义凸壳定义1:设集合S⊂R n,是由R n中的k个点所组成的集合,即S={x1,x2,⋯,x k}。

定义S的凸壳为conv(S)为:conv(S)={x=∑λi x iki=1|∑λi=1,λi≥0,i=1,2,⋯,k ki=1}线性可分定义2:给定一个数据集T={(x1,y1),(x2,y2),⋯,(x n,y n)}其中x i∈X=R n , y i∈Y={+1,−1} , i=1,2,⋯,n ,如果存在在某个超平面S:w∙x+b=0能够将数据集的正实例点和负实例点完全正确地划分到超平面的两侧,即对所有的正例点即y i=+1的实例i,有w∙x+b>0,对所有负实例点即y i=−1的实例i,有w∙x+b<0,则称数据集T为线性可分数据集;否则,称数据集T线性不可分。

必要性:线性可分→凸壳不相交设数据集T中的正例点集为S+,S+的凸壳为conv(S+),负实例点集为S−,S−的凸壳为conv(S−),若T是线性可分的,则存在一个超平面:w ∙x +b =0能够将S +和S −完全分离。

假设对于所有的正例点x i ,有:w ∙x i +b =εi易知εi >0,i =1,2,⋯,|S +|。

常用的分类模型一、引言分类模型是机器学习中常用的一种模型,它用于将数据集中的样本分成不同的类别。

分类模型在各个领域有着广泛的应用,如垃圾邮件过滤、情感分析、疾病诊断等。

在本文中,我们将介绍一些常用的分类模型,包括朴素贝叶斯分类器、决策树、支持向量机和神经网络。

二、朴素贝叶斯分类器朴素贝叶斯分类器是一种基于贝叶斯定理的分类模型。

它假设所有的特征都是相互独立的,这在实际应用中并不一定成立,但朴素贝叶斯分类器仍然是一种简单而有效的分类算法。

2.1 贝叶斯定理贝叶斯定理是概率论中的一条基本公式,它描述了在已知一些先验概率的情况下,如何根据新的证据来更新概率的计算方法。

贝叶斯定理的公式如下:P(A|B) = P(B|A) * P(A) / P(B)其中,P(A|B)表示在事件B已经发生的条件下事件A发生的概率,P(B|A)表示在事件A已经发生的条件下事件B发生的概率,P(A)和P(B)分别表示事件A和事件B独立发生的概率。

2.2 朴素贝叶斯分类器的工作原理朴素贝叶斯分类器假设所有特征之间相互独立,基于贝叶斯定理计算出后验概率最大的类别作为预测结果。

具体地,朴素贝叶斯分类器的工作原理如下:1.计算每个类别的先验概率,即在样本集中每个类别的概率。

2.对于给定的输入样本,计算每个类别的后验概率,即在样本集中每个类别下该样本出现的概率。

3.选择后验概率最大的类别作为预测结果。

2.3 朴素贝叶斯分类器的优缺点朴素贝叶斯分类器有以下优点:•算法简单,易于实现。

•在处理大规模数据集时速度较快。

•对缺失数据不敏感。

但朴素贝叶斯分类器也有一些缺点:•假设特征之间相互独立,这在实际应用中并不一定成立。

•对输入数据的分布假设较强。

三、决策树决策树是一种基于树结构的分类模型,它根据特征的取值以及样本的类别信息构建一个树状模型,并利用该模型进行分类预测。

3.1 决策树的构建决策树的构建过程可以分为三个步骤:1.特征选择:选择一个最佳的特征作为当前节点的划分特征。

绗竴绔?1銆?011骞撮害鑲敗鐮旂┒闄㈡彁鍑虹殑澶ф暟鎹畾涔夋槸锛氬ぇ鏁版嵁鏄寚鍏跺ぇ灏忚秴鍑轰簡甯歌鏁版嵁搴撳伐鍏疯幏鍙栥€佸偍瀛樸€佺鐞嗗拰锛? 锛夎兘鍔涚殑鏁版嵁闆嗐€?A:璁$畻B:璁块棶C:搴旂敤D:鍒嗘瀽绛旀: 鍒嗘瀽2銆佺敤4V鏉ユ鎷ぇ鏁版嵁鐨勭壒鐐圭殑璇濓紝涓€鑸槸鎸囷細Value銆乂elocity 銆乂olume鍜岋紙锛夈€?A:VarietyB:VainlyC:VagaryD:Valley绛旀: Variety3銆佸ぇ鏁版嵁鍒嗘瀽鍥涗釜鏂归潰鐨勫伐浣滀富瑕佹槸锛氭暟鎹垎绫汇€侊紙锛夈€佸叧鑱旇鍒欐寲鎺樺拰鏃堕棿搴忓垪棰勬祴銆?A:鏁版嵁缁熻B:鏁版嵁璁$畻C:鏁版嵁鑱氱被D:鏁版嵁娓呮礂绛旀: 鏁版嵁鑱氱被4銆佹柊娴拰浜笢鑱斿悎鎺ㄥ嚭鐨勫ぇ鏁版嵁鍟嗗搧鎺ㄨ崘锛屾槸鐢变含涓滅洸鐩帹閫佸埌褰撳墠娴忚鏂版氮缃戠珯鐨勭敤鎴风殑椤甸潰涓婄殑銆?A:瀵?B:閿?绛旀: 閿?5銆佺洰鍓嶇殑澶ф暟鎹鐞嗘妧鏈彧鑳藉鐞嗙粨鏋勫寲鏁版嵁銆?A:瀵?B:閿?绛旀: 閿?绗簩绔?1銆佹垜浠父鐢ㄧ殑寰蒋Office濂椾欢涓殑Access鏁版嵁搴撹蒋浠剁殑鏁版嵁搴撴枃浠舵牸寮忓悗缂€鍚嶆槸锛? 锛夈€?A:mdfB:mdbC:dbfD:xls绛旀: mdb2銆佸ぇ澶氭暟鏃ュ織鏂囦欢鐨勫悗缂€鍚嶆槸锛? 锛夈€?A:txtB:csvC:xmlD:log绛旀: log3銆佹湰璇剧▼閲嶇偣浠嬬粛鐨剋eka杞欢鐨勪笓鏈夋枃浠舵牸寮忔槸锛? 锛夈€?A:MongoDBB:ARFFC:valueD:key map绛旀: ARFF4銆佹暟鎹竻娲楀伐浣滅殑鐩殑涓昏鏄瑙e喅鏁版嵁鐨勫畬鏁存€с€佸敮涓€鎬с€佸悎娉曟€у拰锛? 锛夈€?A:涓撲笟鎬?B:鎺掍粬鎬?C:涓€鑷存€?D:鍏变韩鎬?绛旀: 涓€鑷存€?5銆佸叓鐖奔杞欢鐨勨€滆嚜瀹氫箟閲囬泦鈥濆伐浣滄柟寮忎笅锛岄渶瑕佸湪杞欢閲岃緭鍏ヤ竴涓紙锛夋潵浣滀负閲囬泦鐨勭洰鏍囥€?A:鐢佃瘽鍙风爜B:鍏抽敭璇?C:缃戦〉鍦板潃D:鐢ㄦ埛鍚?绛旀: 缃戦〉鍦板潃6銆佸叓鐖奔杞欢鐨勯噰闆嗚鍒欏彲浠ラ€氳繃鏂囦欢鐨勫舰寮忔潵瀵煎叆鎴栬€呭鍑猴紝杩欑鏂囦欢鐨勫悗缂€鍚嶆槸锛? 锛夈€?A:otdB:jpgC:pngD:gif绛旀: otd7銆丒xcel鍙互閫氳繃鈥滄暟鎹湁鏁堟€р€濇寜閽搷浣滄潵瑙勮寖鏁版嵁杈撳叆鐨勮寖鍥淬€?A:瀵?B:閿?绛旀: 瀵?8銆丒xcel涓嶈兘瀵煎叆txt鎴朿sv鏍煎紡鐨勬枃浠躲€?A:瀵?B:閿?绛旀: 閿?9銆佸叓鐖奔杞欢鍙兘瀵硅蒋浠跺唴寤轰簡鈥滅畝鏄撻噰闆嗏€濊鍒欑殑缃戠珯閲囬泦鏁版嵁銆?A:瀵?B:閿?绛旀: 閿?10銆佸叓鐖奔杞欢杩涜鑷畾涔夐噰闆嗘椂锛岄渶瑕佷簡瑙e缃戦〉鐨勯〉闈㈢粨鏋勩€?A:瀵?B:閿?绛旀: 瀵?绗笁绔?1銆佷娇鐢―BSCAN绠楁硶瀵归涪灏捐姳鏁版嵁闆嗭紙Iris.arff锛夎繘琛岃仛绫伙紝灏唀psilon鍙傛暟璁剧疆涓?.2锛? minPoints鍙傛暟璁剧疆涓?锛屽拷鐣lass灞炴€э紝閭d箞灏嗗舰鎴愶紙锛変釜绨囥€?A: 1B: 2C: 3D: 4绛旀: 32銆佷娇鐢‥M绠楁硶瀵瑰ぉ姘旀暟鎹泦锛坵eather.numeric.arff锛夎繘琛岃仛绫伙紝灏唍umClusters璁剧疆涓?锛屽嵆绨囨暟涓?锛屽叾浠栧弬鏁颁繚鎸侀粯璁ゅ€硷紝蹇界暐class灞炴€э紝浠庣粨鏋滀腑鍙煡锛屼笅鍒楅€夐」涓紝锛? 锛夋槸閿欒鐨勩€?A: 妯″瀷鐨勬渶澶т技鐒朵及璁″€兼槸-7.18B: 杩欑粍鏁版嵁鐢ㄧ畻娉曡凯浠?5娆?C: 绗洓涓皣鐨勫厛楠屾鐜囨槸0.14D: 绗洓涓皣鐨勫疄渚嬫暟涓?绛旀: 绗洓涓皣鐨勫疄渚嬫暟涓?3銆佷娇鐢⊿impleKMeans绠楁硶瀵瑰ぉ姘旀暟鎹泦锛坵eather.numeric.arff锛夎繘琛岃仛绫伙紝淇濇寔榛樿鍙傛暟锛屽嵆3涓皣浠ュ強娆ф皬璺濈銆傞€夋嫨play灞炴€т负蹇界暐灞炴€э紝浠庣粨鏋滀腑鍙煡锛屼笅鍒楅€夐」涓紝锛? 锛夋槸閿欒銆?A: 杩欑粍鏁版嵁鐢ㄧ畻娉曡凯浠e洓娆?B: 浜х敓浜嗕笁涓腑蹇冪偣C: 鑱氬悎涓?涓皣锛屽垎鍒湁7锛?锛?涓疄渚?D: 骞虫柟鍜岃宸负8.928绛旀: 杩欑粍鏁版嵁鐢ㄧ畻娉曡凯浠e洓娆?4銆佷娇鐢ㄧ嚎鎬у洖褰掞紙LinearRegression锛夊垎绫诲櫒鍜岀敤M5P鍒嗙被鍣ㄥcpu.arff鍒嗗埆杩涜鍒嗙被锛岀敱鍏惰緭鍑虹殑璇樊鎸囨爣鍙煡锛? 锛夈€?A: LinearRegression鐨勬爣鍑嗚宸瘮M5P鐨勬爣鍑嗚宸皬B: LinearRegression鐨勫钩鍧囩粷瀵硅宸瘮M5P鐨勫钩鍧囩粷瀵硅宸皬C: LinearRegression鐨勭浉瀵硅宸瘮M5P鐨勭浉瀵硅宸皬D: LinearRegression鐨勫钩鍧囨柟鏍硅宸瘮M5P鐨勫钩鍧囨柟鏍硅宸ぇ绛旀: LinearRegression鐨勫钩鍧囨柟鏍硅宸瘮M5P鐨勫钩鍧囨柟鏍硅宸ぇ5銆佸垹鍘籧pu.arff鏁版嵁鏂囦欢涓殑CACH灞炴€у悗锛屼娇鐢∕5P鍒嗙被鍣ㄦ瀯寤烘柟妗堬紝鍦ㄧ粨鏋滀腑锛屽埌杈綥M2鐨勫疄渚嬫暟鏈夛紙锛変釜銆?A: 165B: 21C: 23D: 30绛旀: 216銆佹牴鎹甁48鍒嗙被鍣ㄨ缁僿eather.nominal.arff鎵€鐢熶骇鐨勫喅绛栨爲锛屽綋outlook=sunny锛泃emperature=cool锛沨umidity =high锛泈indy=TRUE鏃讹紝鍒嗙被鐨勭粨鏋滄槸锛?锛夈€?A: YesB: NoC: 娌℃湁缁撴灉D: 鏃犳硶鍒嗙被绛旀: No7銆佹牴鎹甁48鍒嗙被鍣ㄨ缁僫ris.arff鎵€鐢熶骇鐨勫喅绛栨爲锛屽綋sepallength=4.4锛泂epalwidth=3.0锛沺etallength=1.3锛沺etalwidth=0.2鏃讹紝鍒嗙被鐨勭粨鏋滄槸锛? 锛夈€?A: Iris-setosaB: Iris-versicolorC: Iris-virginicaD: 鏃犳硶鍒嗙被绛旀: Iris-setosa8銆佸叧浜嶹eka绂绘暎鍖栬鏄庢纭殑鏄紙锛夈€?A: 绂绘暎鍖栨槸灏嗘暟鍊煎睘鎬ц浆鎹负瀛楃涓插瀷灞炴€?B: 鏈夌洃鐫g鏁e寲鏈変袱绉嶇瓑瀹藉拰绛夐鏂规硶C: 绛夊绂绘暎鍖栨槸浣垮疄渚嬪垎甯冨潎鍖€鐨?D: 绂绘暎鍖栧寘鎷棤鐩戠潱绂绘暎鍖栧拰鏈夌洃鐫g鏁e寲绛旀: 绂绘暎鍖栧寘鎷棤鐩戠潱绂绘暎鍖栧拰鏈夌洃鐫g鏁e寲9銆佷互涓嬶紙锛変笉鏄疻eka鐨勬暟鎹被鍨嬨€?A: numericB: nominalC: stringD: decimal绛旀: decimal10銆佸叧浜嶹eka鐨勬枃浠剁被鍨嬫弿杩伴敊璇殑鏄紙锛夈€?A: Weka鍙互鎵撳紑鏂囦欢鏍煎紡鏈?arff銆?csv銆?xlsxB: Weka澶勭悊鐨勬暟鎹泦绫讳技浜庡叧绯绘暟鎹簱妯瀹炰緥锛岀珫琛屽睘鎬?C: arff鏄疉SCII鏂囦欢锛屽彲浠ョ敤Word绛夋枃鏈紪杈戝櫒鎵撳紑鏌ョ湅D: @relation 瀹氫箟鏁版嵁闆嗗悕绉帮紝@data涔嬪悗鍛堢幇瀹炰緥锛屾瘡涓€琛屽氨鏄竴涓疄渚?绛旀: Weka鍙互鎵撳紑鏂囦欢鏍煎紡鏈?arff銆?csv銆?xlsx11銆佷互涓嬪睘浜庡叧鑱斿垎鏋愮殑鏄紙锛夈€?A: CPU鎬ц兘棰勬祴B: 璐墿绡垎鏋?C: 鑷姩鍒ゆ柇楦㈠熬鑺辩被鍒?D: 鑲$エ瓒嬪娍寤烘ā绛旀: 璐墿绡垎鏋?12銆佸ぇ鏁版嵁鏃朵唬鐨勫埌鏉ワ紝浣挎垜浠棤娉曚汉涓哄湴鍘诲彂鐜版暟鎹腑鐨勫ゥ濡欙紝涓庢鍚屾椂锛屾垜浠洿搴旇娉ㄩ噸鏁版嵁涓殑鐩稿叧鍏崇郴锛岃€屼笉鏄洜鏋滃叧绯汇€傚叾涓紝鏁版嵁涔嬮棿鐨勭浉鍏冲叧绯诲彲浠ラ€氳繃浠ヤ笅锛? 锛夌畻娉曠洿鎺ユ寲鎺樸€?A: K-meansB: Bayes NetworkC: C4.5D: Apriori绛旀: Apriori13銆佹煇瓒呭競鐮旂┒閿€鍞邯褰曟暟鎹悗鍙戠幇锛屼拱鍟ら厭鐨勪汉寰堝ぇ姒傜巼涔熶細璐拱灏垮竷锛岃繖绉嶅睘浜庢暟鎹寲鎺樼殑锛? 锛夐棶棰樸€?A: 鍏宠仈瑙勫垯鍙戠幇B: 鑱氱被C: 鍒嗙被D: 鑷劧璇█澶勭悊绛旀: 鍏宠仈瑙勫垯鍙戠幇14銆佸湪杩涜鑷姩閫夋嫨灞炴€ф椂锛屽繀椤昏绔嬩袱涓璞★紝鍏朵腑纭畾浣跨敤浠€涔堟柟娉曚负姣忎釜灞炴€у瓙闆嗗垎閰嶄竴涓瘎浼板€肩殑瀵硅薄鏄笅闈㈢殑锛? 锛夈€?A: 鎼滅储鏂规硶B: 灞炴€ц瘎浼板櫒C: 鍏冨垎绫诲櫒D: 瑙勫垯鎸栨帢绛旀: 灞炴€ц瘎浼板櫒15銆佷互涓嬪睘浜庡睘鎬х┖闂寸殑鎼滅储鏂规硶鐨勬槸锛?锛夈€?A: GainRatioAttributeEvalB: BestFirstC: PrincipalComponentsD: SymmetricalUncertAttributeEval绛旀: BestFirst16銆佸湪weka杞欢鎺㈢储鑰呯晫闈腑锛屽埄鐢╒isualize鏍囩椤甸€氳繃鏇存敼鍚勪釜鍙傛暟鏉ヨ繘琛屾暟鎹泦鐨勫彲瑙嗗寲灞炴€ц缃悗锛岄渶瑕佸崟鍑讳互涓嬶紙锛夋寜閽紝鎵€鏈夋洿鏀规墠浼氱敓鏁堛€?A: Select AttributeB: SubSampleC: UpdateD: Fast scrolling绛旀: Update17銆佺粰瀹氬叧鑱旇鍒橝B锛屾剰鍛崇潃锛氳嫢A鍙戠敓锛孊涔熶細鍙戠敓銆?A:瀵?B:閿?绛旀: 閿?18銆佹敮鎸佸害鏄閲忓叧鑱旇鍒欓噸瑕佹€х殑涓€涓寚鏍囥€?A:瀵?B:閿?绛旀: 瀵?19銆丷anker鏂规硶鏃㈠彲浠ョ敤浜庡崟涓睘鎬ц瘎浼板櫒锛屽張鍙互鐢ㄤ簬灞炴€у瓙闆嗚瘎浼板櫒銆?A:瀵?B:閿?绛旀: 閿?20銆佸埄鐢╳eka杞欢杩涜鏁版嵁鍙鍖栨椂锛岀敤鎴峰彲浠ラ€夋嫨绫诲埆灞炴€у鏁版嵁鐐圭潃鑹诧紝濡傛灉绫诲埆灞炴€ф槸鏍囩О鍨嬶紝鍒欐樉绀轰负褰╄壊鏉°€?A:瀵?B:閿?绛旀: 閿?绗洓绔?1銆佽礉鍙舵柉缃戠粶涓殑鑺傜偣浠h〃锛? 锛夈€?A:鍙橀噺B:闅忔満杩囩▼C:闅忔満鍙橀噺D:闅忔満鍑芥暟绛旀: 闅忔満鍙橀噺2銆佽礉鍙舵柉缃戠粶涓紝鑺傜偣闇€缁欏嚭姒傜巼鍒嗗竷鎻忚堪锛屽浜庣鏁e瀷闅忔満鍙橀噺鑰岃█锛屽彲浠ョ敤锛? 锛夌殑褰㈠紡琛ㄧず銆?A:鏉′欢姒傜巼瀵嗗害鍑芥暟B:姝f€佸垎甯?C:鏉′欢姒傜巼琛?D: 鍧囧寑鍒嗗竷绛旀: 鏉′欢姒傜巼琛?3銆佽礉鍙舵柉缃戠粶涓妭鐐逛箣闂寸殑杈逛唬琛紙锛夈€? A:闅忔満鍏崇郴B:姒傜巼鍥犳灉C:缁勫悎鍏崇郴D:闅忔満缁撴灉绛旀: 闅忔満鍏崇郴4銆佽礉鍙舵柉缃戠粶淇濆瓨鐨勬枃浠舵牸寮忔槸( )銆?A:XML BIFB:DOCXC: TXTD:XLS绛旀: XML BIF5銆佷笅闈紙锛変笉鏄弽鍚戜紶鎾缁忕綉缁滅殑缁撴瀯銆? A:杈撳叆灞?B:闅愬惈灞?C:璁$畻灞?D:杈撳嚭灞?绛旀: 璁$畻灞?6銆佺缁忕綉缁滀腑鐨勮妭鐐逛唬琛紙锛夈€?A:婵€鍔卞彉閲?B:婵€鍔卞嚱鏁?C:闅忔満鍙橀噺D:闅忔満鍑芥暟绛旀: 婵€鍔卞嚱鏁?7銆佷笅鍒楋紙锛変笉鏄父瑙佺殑婵€鍔卞嚱鏁般€?A:绾挎€у嚱鏁?B:Sigmoid鍑芥暟C:闃堝€煎嚱鏁?D:姝e鸡鍑芥暟绛旀: 姝e鸡鍑芥暟8銆佸湪璐濆彾鏂綉缁滅紪杈戠晫闈㈡椂锛屽鏋滆妭鐐圭殑鍚嶇О娌℃硶瀹屽叏鏄剧ず锛岄渶瑕佷粠锛? 锛夎彍鍗曢」杩涜璋冩暣銆?A:Tools|SetDataB:View|Zoom OutC:View|Zoom InD:Tools|Layout绛旀: Tools|Layout9銆乄EKA涓€夋嫨绁炵粡缃戠粶鍒嗙被鍣ㄦ搷浣滄椂锛屽簲璇ラ€夋嫨锛? 锛夈€?A:rules鏉$洰涓嬬殑PARTB:functions鏉$洰涓嬬殑SGD鍒嗙被鍣?C:functions鏉$洰涓嬬殑MultilayerPerceptron鍒嗙被鍣?D:榛樿鐨勫垎绫诲櫒绛旀: functions鏉$洰涓嬬殑MultilayerPerceptron鍒嗙被鍣?10銆佷笅闈㈠叧浜嶱ackage Manager瀹夎鍚庣殑鐩綍璇存槑涓嶆纭殑鏄紙锛夈€?A:doc瀛愮洰褰曞瓨鏀続PI鏂囨。

Softmax原理及Sigmoid和Softmax⽤于分类的区别1、什么是 softmax机器学习总归是要接触到 softmax 的,那么这个东东倒底是怎么来的呢?实际上 softmax 可能指两种相似但不相同的东东。

1.1. softmax function这函数定义⽐较符合 softmax 这个名字:可见 softmax function 是从⼀个输⼊序列⾥算出⼀个值。

可见 softmax 确实会返回输⼊序列中最⼤的那个值的近似值。

softmax 是对真 max 函数的近似,softmax 的函数曲线是光滑的(处处可微分),⽽ max(0,x) 之类的函数则会有折点。

在机器学习领域,多分类算法需要从⼀组可能的结果中找出概率最⾼的那个,正需要使⽤ max 函数。

⽽为了能进⾏优化,⽤于描述问题的函数必须是可微分的,这样 softmax 就是⼀个⾮常合适的选择了。

1.2. softmax activation function这是机器学习领域⼴为使⽤的⼀个函数,也叫归⼀化指数数函,它的定义是:可见 softmax activation function 返回的是⼀个序列,这个函数的分母部分跟 softmax function 有⼀部分是相同的,并且在效果上也有⼀点⼉相似:通过运算会扩⼤最⼤项的优势并抑制序列中其余的项。

1.3.历史能在互联⽹上查到的记录显⽰,1989 年 John S. Bridle 在论⽂“Probabilistic Interpretation of Feedforward Classification Network Outputs, with relationships to statistical pattern recognition” 中⾸次引⼊了 softmax activation function 。

这位 2013 年加⼊苹果⾄今,在搞 Siri 。

1.4.softmax activation function 的特性和应⽤这个函数能够将输⼊序列的每⼀个值挤压到[0,1]范围内,并且所有项的和为1。

人工智能导论第四章课后答案1. 什么是先验概率?举例说明。

先验概率是指在考虑新的证据之前,先已知一些先前的概率,然后根据这些先前的概率来计算得到新的概率。

例如,在掷硬币的情况下,如果每个面出现的概率都是50%,那么在扔出正面之前,出现正面的先验概率为0.5。

2. 什么是后验概率?举例说明。

后验概率是指在获得新的证据后,重新计算概率。

例如,在掷硬币的情况下,如果前10次硬币都是正面朝上,那么出现正面的后验概率已经不再是0.5,而是根据已有的数据计算得出的新概率。

3. 什么是朴素贝叶斯分类器?其基本假设是什么?朴素贝叶斯分类器是一种基于贝叶斯定理的分类器。

它假设特征之间相互独立,即给定类别C,所有特征之间都是条件独立的。

这个假设使得朴素贝叶斯分类器能够通过简单的计算得出后验概率,从而进行分类。

4. 什么是决策树分类器?请描述它的工作过程。

决策树分类器是一种基于树形结构的分类器。

它通过不断地对特征进行分类来最终确定样本所属的类别,其工作过程如下:1.在样本集中找到一个关于分类问题的最好特征进行划分。

2.根据该特征将样本集分成若干个子集,每个子集对应该特征的一个取值。

3.对每个子集重复第1步和第2步操作,直到子集内所有样本的类别均相同,或者子集样本过小无法继续划分。

4.构建出一棵树模型,将每个子集对应于树上的一个节点。

5.对于新的样本,从根节点开始沿着树的路径不断前进,直到达到一个叶子节点,该叶子节点的类别即为样本的预测类别。

5. 什么是神经网络分类器?请描述其基本结构和工作原理。

神经网络分类器是一种基于人工神经网络的分类器。

它基于反向传播算法学习样本,通过不断调整网络权重使得输出结果接近真实标签。

神经网络分类器的基本结构由多个神经元组成,其在输入和输出层之间包括若干个隐藏层。

神经元通过输入层接受输入信号,该信号被赋予权值,然后被传递到下一层。

每个神经元接受到多个输入信号,经加权处理后只输出一个值,该值将作为输入传递到下一层。

《模式识别》课程标准一、课程概述1.课程性质《模式识别》是人工智能技术服务专业针对人工智能产业及其应用相关的企事业单位的人工智能技术应用开发、系统运维、产品营销、技术支持等岗位,经过对企业岗位典型工作任务的调研和分析后,归纳总结出来的为适应人工智能产品开发与测试、数据处理、系统运维等能力要求而设置的一门专业核心课程。

2.课程任务《模式识别》课程通过与各类特征识别应用案例开发相关的实际项目学习,增强学生对本专业智能感知与识别算法知识的认识,训练他们养成良好的解析思维习惯,在理解理论知识的基础之上,根据实现情况分析与设计出最优解决方案,再用编程方式实现特征提取和识别算法并加以应用的能力,从而满足企业对相应岗位的职业能力需求。

3.课程要求通过课程的学习培养学生智能感知与识别算法应用方面的岗位职业能力,分析问题、解决问题的能力,养成良好的职业道德,为后续课程的学习打下坚实的基础。

二、教学目标(一)知识目标(1)了解模式识别的概念,掌握通过编程实现模板匹配算法来解决简单的模式识别问题的能力;(2)了解常用模式识别算法的原理,能初步利用该类算法解决具体模式识别问题的一般方法;(3)理解特征提取与降维的概念及主要方法,并能够在解决模式识别问题的过程中加以应用;(4)详细了解BP神经网络的原理,熟练掌握利用该算法解决手写体识别问题的方法;(5)详细了解朴素贝叶斯分类器算法的原理,熟练掌握利用该算法解决打印体文字识别问题的方法;(6)详细了解基于隐马尔可夫模型的语音识别原理,熟练掌握利用该模型解决语音识别问题的方法;(7)详细了解基于PCA和SVM模型的人脸识别原理,熟练掌握利用该模型解决人脸识别问题的方法。

(二)能力目标(1)会识读程序流程图,能看懂案例程序代码;(2)会使用Python语言实现“模式识别”常规算法;(3)能按照任务要求,设计程序流程图,编写程序代码;(4)能够根据系统功能要求对程序进行调试;(5)能够对所编写的程序故障进行分析,提出解决方案并进行故障排除:(6)能根据系统工作情况,提出合理的改造方案,组织技术改造工作、绘制程序流程图、提出工艺要求、编制技术文件。

分类问题的求解过程如下图:2.⽤pytorch的逻辑回归实现图像分类#导⼊包#损失函数和优化器import torch.nn.functional as Fimport torch.optim as optimlearning_rate=0.001loss = nn.CrossEntropyLoss()#定义交叉熵损失函数, 这个⽅法集成了softmax计算optimizer = torch.optim.SGD(linearnet.parameters(),lr=learning_rate)#SGD优化器#测试集数据评估def evaluate_accuracy(data_iter, net):acc_sum, n =0.0, 0for data in data_iter:X, y=dataX, y=X.to(device),y.to(device)acc_sum +=(net(X).argmax(dim=1)== y).float().sum().item()n += y.shape[0]return acc_sum / n#定义训练过程epochs =200def train_model(optimizer):for epoch in range(epochs):train_loss_sum, train_acc_sum, n =0.0, 0.0, 0for data in trainloader:inputs, y=datainputs, y=inputs.to(device),y.to(device)#print(inputs)y_hat = linearnet(inputs)cost = loss(y_hat, y).sum()optimizer.zero_grad()cost.backward()optimizer.step()train_loss_sum += cost.item()train_acc_sum +=(torch.argmax(y_hat, dim=1)== y).float().sum().item()n += y.shape[0]test_acc = evaluate_accuracy(testloader, linearnet)print('epoch %d, loss %.4f, train acc %.4f, test acc %.4f' % (epoch + 1, train_loss_sum / n, train_acc_sum / n, test_acc)) #调⽤函数训练数据train_model(optimizer)#结果可视化#准确度绘制import matplotlib.pyplot as plt# 绘制训练%验证的精度Trainacc=[]#请输⼊上述训练过程中保存的数据Testacc=[]##请输⼊上述训练过程中保存的数据plt.plot(Trainacc)plt.plot(Testacc)plt.title('qijiajing-Residual Block Model accuracy')plt.xlabel('Epoch')plt.ylabel('Accuracy')plt.legend(['Train acc', 'Test acc'], loc='upper left')plt.show()#loss绘制import matplotlib.pyplot as pltloss=[]plt.plot(loss)plt.xlabel('Epoch')plt.ylabel('Loss')plt.title('qijiajing-Model accuracy')我们进⾏了250次迭代,最终训练集精度稳定在43.5%左右,测试集精度稳定在41%左右,是随机猜测10%的四倍。

如何通过神经网络实现图像分类随着信息时代的到来,图像数据越来越丰富、庞大,图像分类的需求也越来越强烈。

传统的图像分类方法主要来自于特征提取和机器学习算法的组合,但是这种方法难以胜任海量图像数据的分类,且存在过拟合等缺陷。

而新兴的深度学习方法则通过神经网络自动从原始数据中提取更高级别的表征,以此取得了很大的成功。

在本文中,我们将探讨如何通过神经网络实现图像分类。

一、什么是神经网络?神经网络是一种类似于生物神经系统的计算机算法,它通过学习样本数据中固有的规律,自动获得数据的表征。

它由一系列简单的神经元组成,每个神经元接收多个输入,并根据参数调整计算结果,输出给下一层的神经元。

神经网络是一种十分强大的工具,可以用于图像分类、自然语言处理、语音识别等诸多领域。

在图像分类领域中,通过神经网络提取的特征更加丰富,可以比传统的图像分类方法更精确、更有效地对图像进行分类。

二、神经网络的图像分类基本流程图像分类的基本流程就是将原始图像经过一系列的图像预处理操作,然后用神经网络进行特征提取和分类,最后通过目标检测和识别反馈结果。

1. 图像预处理图像预处理是神经网络图像分类的第一步,包括以下几个步骤:(1)图像去噪在进行图像分类之前,需要先将图像去噪。

通常使用滤波器,比如高斯滤波器和中值滤波器,对图像进行平滑处理,去除图像上的噪声。

(2)图像归一化图像归一化是为了将输入的图像转化为可处理的数值型矩阵。

可以将图像的尺寸统一化,进行灰度化处理等。

(3)特征提取特征提取是将图像中某些特定的特征提取出来,以辅助对图像的分类。

例如,可以提取图像的边缘、角点、颜色等。

2. 特征提取与分类特征提取是神经网络图像分类的核心,通过对图像特征的提取,可以建立一个较好的特征空间来区分不同类别的图像。

有两种常用的神经网络分类方法:卷积神经网络和循环神经网络。

(1)卷积神经网络(CNN)卷积神经网络是一种专门用于图像分类的神经网络,主要包含卷积层、池化层、全连接层等几个部分。

人工智能基础(习题卷53)第1部分:单项选择题,共50题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]RPA执行器主要的用途是()。

A)编写和发布RPA流程B)运行RPA流程C)管控RPA流程答案:B解析:2.[单选题]从全称判断推导出特称判断或单称判断的过程,即由一般性知识推出适合于某一具体情况的结论的推理是()A)归结推理B)演绎推理C)默认推理D)单调推理答案:B解析:3.[单选题]从给定的特征集合中选择出相关特征子集的过程,称为(___)A)特征抽取B)特征选择C)特征降维D)特征简化答案:B解析:4.[单选题]在训练神经网络过程中我们目的是让损失函数不断减小,我们常用以下哪种方法最小化损失函数A)梯度下降B)DropoutC)交叉验证D)正则化答案:A解析:5.[单选题]在线性回归问题中,我们用R方来衡量拟合的好坏。

在线性回归模型中增加特征值并再训练同一模型。

下列说法正确的是()。

A)如果R方上升,则该变量是显著的B)如果R方下降,则该变量不显著C)单单R方不能反映变量重要性,不能就此得出正确结论D)以上答案都不正确答案:C解析:单单R方不能表示变量显著性,因为每次加入一个特征值,R方都会上升或维持 不变。

但在调整R方的情况下这也有误(如果特征值显著的话,调整R方会上升)。

6.[单选题]()中各神经元接受前一层的输入,并输出给下一层,没有反馈。

A)反馈型神经网络B)前馈型神经网络C)Hopfield神经网络D)全互联神经网络答案:B解析:7.[单选题]邻域通信网用于( )之间的通信。

A)边设备与边设备B)边设备与端设备C)端设备与云主站D)边设备与云主站答案:B解析:8.[单选题]以下哪个不是语音识别技术的应用场景()A)入侵检测B)语音合成C)语音翻译D)智能客服答案:A解析:9.[单选题]数据价值挖掘常用的模型有()、描述型模型等。

A)聚类模型B)预测型模型C)分类模型D)时间模型答案:B解析:10.[单选题]根据图中所示的minimax算法决策树,根结点的估值是( )。

第46卷第1期2024年1月沈 阳 工 业 大 学 学 报JournalofShenyangUniversityofTechnologyVol 46No 1Jan 2024收稿日期:2020-11-19基金项目:国家自然科学基金青年科学基金项目(61163113)。

作者简介:王 昊(1986—),女,吉林松原人,高级工程师,硕士,主要从事智能电网建设、输电线路无人机自动驾驶巡检与设备图像识别等方面的研究。

檪檪檪檪檪檪檪檪檪檪殏殏殏殏电气工程 DOI:10.7688/j.issn.1000-1646.2024.01.09基于无人机机载AI模块的电力巡检技术王 昊1,丁国斌2,杨家慧1(1 南方电网数字电网研究院有限公司,广东广州510700;2 广州致讯信息科技有限责任公司研发部,广东广州510700)摘 要:针对输电线路无人机巡检实时性和准确性的要求,深入研究了YOLOv3目标检测算法在无人机巡检机载AI模块中的应用。

利用将目标检测候选区选取和对象识别合二为一的YOLOv3算法,结合多尺度特征融合方式实现了目标检测的高准确性和实时优化,并采用残差块解决了模型退化问题。

输电线路绝缘子检测结果表明:YOLOv3算法平均精度可达90%,相同条件下YOLOv3算法平均处理速度约为FasterRCNN算法的3 2倍,约为SSD算法的1 6倍。

关 键 词:无人机巡检;目标检测;图像识别;多尺度特征融合;残差块;输电线路;实时性中图分类号:TM744 文献标志码:A 文章编号:1000-1646(2024)01-0049-05PowerinspectiontechnologybasedonUAVairborneAImoduleWANGHao1,DINGGuobin2,YANGJiahui1(1.DigitalGridResearchInstituteCo.,Ltd.ofChinaSouthernPowerGrid,Guangzhou510700,Guangdong,China;2.R&DDepartment,GuangzhouZhixunInformationTechnologyCo.,Ltd.,Guangzhou510700,Guangdong,China)Abstract:AccordingtotherequirementsforinstantaneityandaccuracybyUAVinspectionoftransmissionline,theapplicationofYOLOv3targetdetectionalgorithminUAVinspectionairborneAImodulewasdeeplystudied.ThroughtheYOLOv3algorithmforbothobjectdetectioncandidateregionselectionandobjectrecognition,incombinationwiththemulti scalefeaturefusionmethod,thehighaccuracyandinstantaneityoptimizationoftargetdetectionwererealized,andtheresidualblockwasusedtosolvetheproblemofmodeldegradation.TheresultsoftransmissionlineinsulatordetectionshowthattheaverageaccuracyofYOLOv3algorithmcanreach90%.Underthesameconditions,theaverageprocessingspeedofYOLOv3algorithmis3 2timesthatofFasterRCNNalgorithmand1 6timesthatofSSDalgorithm.Keywords:UAVinspection;targetdetection;imagerecognition;multi scalefeaturefusion;residualblock;transmissionline;instantaneity 随着计算机技术的发展,利用无人机巡航结合图像识别算法的目标检测技术在城市规划、应急抢险、工程建设、森林防火、电力巡检等领域获得了广泛应用[1-2]。

基于Stacking堆叠模型的构建算法摘要:肝癌是全球范围内最常见的恶性肿瘤之一。

肝细胞性肝癌(hepatocellular carcinoma,HCC)是一种患病率和死亡率较高的肿瘤,是肝癌的主要组织学亚型,且临床上以组织病理学诊断作为肝癌诊断的金标准。

人体影像学诊断技术敏感性高,但检测费用昂贵、技术操作复杂,对患者具有潜在伤害,无法应用于大规模人群筛查。

因此,本文基于堆叠网络的肝癌复发预测模型设计了一种结合甘愈肝癌早筛的辅助诊疗系统。

关键词:网络堆叠模型机器学习辅助诊疗系统1.引言在机器学习中,集成方法通常指的是使用多种学习算法进行组合来取得比单一学习算法更好效果的方法。

机器学习的最终任务是在模型的假设空间中寻找到一个合适的假设,从而对所需解决的问题进行建模和预测。

但是有可能即便假设空间中存在许多很好的假设,也没法被发现。

这时使用集成方法便可以将多个弱一点的假设组合在一起,形成一个更好的假设。

从经验上讲,当同一个假设空间中的模型之间存在显著差异时,它们的集成模型总体趋向于产生更好的结果。

因此,许多集成方法的目的都在于促进同一个假设在机器学习中,集成方法通常指的是使用多种学习算法进行组合来取得比单一学习算法更好效果的方法。

机器学习的最终任务是在模型的假设空间中寻找到一个合适的假设,从而对所需解决的问题进行建模和预测。

但是有可能即便假设空间中存在许多很好的假设,也没法被发现。

这时使用集成方法便可以将多个弱一点的假设组合在一起,形成一个更好的假设。

2.堆叠网络模型从实际经验上讲,当同一个假设空间中的模型之间存在显著差异时,它们的集成模型总体趋向于产生更好的结果。

因此,许多集成方法的目的都在促进同一个假设空间中的模型结合以产生多样性的假设。

例如,模型个数更多的随机算法(比如随机森林)可以比非常单一的算法(比如决策树)产生更好的效果。

假设已经训练了一些分类器,比如有一个支持向量机分类器、一个梯度提升树分类器、一个随机森林分类器、一个神经网络分类器,如图2-1所示。

模式识别教案一、课题模式识别二、教学目标1. 知识与技能目标- 学生能够理解模式识别的基本概念,包括模式、模式类等。

- 了解模式识别的主要方法,如统计模式识别和结构模式识别的基本原理。

- 能够区分不同模式识别方法的适用场景。

2. 过程与方法目标- 通过案例分析,培养学生观察、分析和归纳总结的能力。

- 以小组合作探究的方式,让学生体验模式识别在实际生活中的应用开发过程,提高学生的团队协作能力和解决问题的能力。

3. 情感态度与价值观目标- 激发学生对模式识别这一人工智能领域的兴趣,培养学生对新兴技术的探索精神。

- 让学生意识到模式识别在现代科技发展和社会生活中的重要性,增强学生的科技意识。

三、教学重点&难点1. 教学重点- 模式识别的基本概念,如模式、模式类、特征提取等。

- 统计模式识别和结构模式识别的原理及主要算法。

- 模式识别在实际生活中的典型应用,如人脸识别、指纹识别等。

2. 教学难点- 理解统计模式识别中概率密度函数的估计方法,如最大似然估计等。

- 掌握结构模式识别中模式的描述和匹配方法,如句法分析等。

四、教学方法小组合作探究法、案例分析法、问题驱动法五、教学过程1. 导入(10分钟)- 教师展示一些图片,包括不同人的脸、不同的指纹、各种手写数字等。

然后提问学生:“你们是如何区分这些图片中的不同对象的呢?”引导学生思考人类识别物体的方式。

- 教师话术:“同学们,今天我们来看这些有趣的图片。

你们看,这里有很多不同的人脸,还有不同的指纹,以及手写的数字。

大家想一想,当你们看到这些的时候,你们是怎么知道哪张脸是不同的人,哪个指纹属于不同的手指,这些数字又分别是什么呢?其实,这就是一种识别的能力,而今天我们要学习的模式识别,就是让计算机也具备这样的能力。

”- 接着,教师再展示一些利用模式识别技术实现的成果,如门禁系统中的人脸识别、手机上的指纹解锁等视频,进一步激发学生的兴趣。

2. 概念讲解(15分钟)- 教师给出模式识别的定义:模式识别是指对表征事物或现象的各种形式的(数值的、文字的和逻辑关系的)信息进行处理和分析,以对事物或现象进行描述、辨认、分类和解释的过程。

neuroph例子Neuroph是在Java语言中开发的一个神经网络框架,允许开发者创建、训练和部署人工神经网络。

本文将介绍一些使用Neuroph的实例,并解释其核心思想和使用方式。

一、基础概念在使用Neuroph之前,您需要熟悉一些基本的神经网络概念。

以下是一些重要的概念:1. 神经元(Neuron):神经网络中的基本单元,用于接收输入并进行加权计算。

每个神经元都有一个激活函数,用于将输入转换为输出。

2. 层(Layer):神经元可以组成层,这些层可以是输入层、隐藏层或输出层。

每个神经元都会将其输出传递给下一层单元进行处理。

3. 权重(Weights):权重是神经元之间的附加值,用于调整网络的输出。

权重的初始值通常是随机的,并且在训练过程中发生变化。

4. 学习率(Learning Rate):学习率是调整权重的速率。

它决定了在每个训练迭代中应该调整多少权重。

高学习率意味着更快的训练,但可能会导致过拟合。

二、实例接下来我们将介绍一些使用Neuroph的实例,帮助您了解神经网络的训练和使用。

1. 神经网络分类器神经网络可以用于分类器问题,例如对图像或文档进行分类。

以下是一个基本的图像分类器示例:```java// 创建输入层InputLayer inputLayer = new InputLayer(10);// 将层分别添加到网络中NeuralNetwork neuralNetwork = new NeuralNetwork();neuralNetwork.addLayer(inputLayer);neuralNetwork.addLayer(hiddenLayer);neuralNetwork.addLayer(outputLayer);// 创建训练数据和标签DataSet dataSet = new DataSet(10, 3);dataSet.addRow(new double[]{0, 0, 0, 0, 0, 0, 0, 0, 0, 0}, new double[]{1, 0, 0});dataSet.addRow(new double[]{1, 1, 1, 1, 1, 1, 1, 1, 1, 1}, new double[]{0, 1, 0});dataSet.addRow(new double[]{1, 0, 1, 0, 1, 0, 1, 0, 1, 0}, new double[]{0, 0, 1});// 训练神经网络backPropagation.learn(dataSet);// 使用训练数据进行预测neuralNetwork.setInput(new double[]{0, 0, 0, 0, 0, 0, 0, 0, 0, 0});neuralNetwork.calculate();double[] output = neuralNetwork.getOutput();// 打印输出System.out.println(Arrays.toString(output));```以上示例构建了一个包含10个输入、5个隐藏和3个输出神经元的分类器。