人工神经网络_matlab工具箱

- 格式:ppt

- 大小:790.00 KB

- 文档页数:39

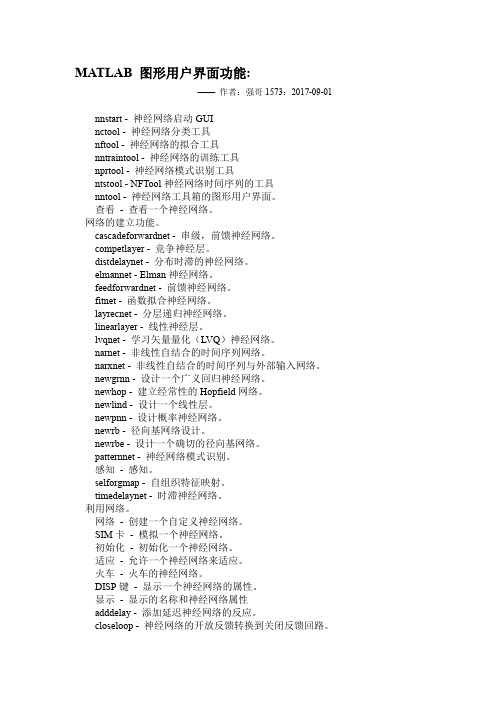

MATLAB 图形用户界面功能:——作者:强哥1573:2017-09-01 nnstart - 神经网络启动GUInctool - 神经网络分类工具nftool - 神经网络的拟合工具nntraintool - 神经网络的训练工具nprtool - 神经网络模式识别工具ntstool - NFTool神经网络时间序列的工具nntool - 神经网络工具箱的图形用户界面。

查看- 查看一个神经网络。

网络的建立功能。

cascadeforwardnet - 串级,前馈神经网络。

competlayer - 竞争神经层。

distdelaynet - 分布时滞的神经网络。

elmannet - Elman神经网络。

feedforwardnet - 前馈神经网络。

fitnet - 函数拟合神经网络。

layrecnet - 分层递归神经网络。

linearlayer - 线性神经层。

lvqnet - 学习矢量量化(LVQ)神经网络。

narnet - 非线性自结合的时间序列网络。

narxnet - 非线性自结合的时间序列与外部输入网络。

newgrnn - 设计一个广义回归神经网络。

newhop - 建立经常性的Hopfield网络。

newlind - 设计一个线性层。

newpnn - 设计概率神经网络。

newrb - 径向基网络设计。

newrbe - 设计一个确切的径向基网络。

patternnet - 神经网络模式识别。

感知- 感知。

selforgmap - 自组织特征映射。

timedelaynet - 时滞神经网络。

利用网络。

网络- 创建一个自定义神经网络。

SIM卡- 模拟一个神经网络。

初始化- 初始化一个神经网络。

适应- 允许一个神经网络来适应。

火车- 火车的神经网络。

DISP键- 显示一个神经网络的属性。

显示- 显示的名称和神经网络属性adddelay - 添加延迟神经网络的反应。

closeloop - 神经网络的开放反馈转换到关闭反馈回路。

Matlab中的神经网络实现方法近年来,神经网络技术在各个领域中得到了广泛的应用。

通过对大量的数据进行学习和训练,神经网络可以用于解决诸如图像识别、语音识别、自然语言处理等复杂的问题。

而Matlab作为一种强大的科学计算工具,提供了丰富的神经网络实现方法,帮助研究人员和工程师更好地应用神经网络技术。

在Matlab中,实现神经网络有多种方法,包括使用神经网络工具箱、编写自定义的函数和使用深度学习工具箱等。

下面将分别介绍这些方法的特点和应用。

一、神经网络工具箱Matlab的神经网络工具箱是一个功能强大的工具,可以帮助用户在短时间内搭建和训练神经网络模型。

通过在Matlab中调用神经网络工具箱中的函数,用户可以实现包括前馈神经网络、递归神经网络、自动编码器等各种类型的神经网络模型。

使用神经网络工具箱,用户只需要简单地定义网络的拓扑结构、选择合适的激活函数和学习算法,然后通过输入训练数据进行网络的训练。

训练完成后,用户可以使用训练好的神经网络模型对新的数据进行预测和分类。

神经网络工具箱提供了丰富的函数和工具,帮助用户实现各种复杂的操作,例如特征选择、模型评估和可视化等。

此外,神经网络工具箱还支持并行计算和分布式计算,提高了神经网络模型的训练效率。

二、自定义函数除了使用神经网络工具箱,用户还可以编写自定义的函数来实现神经网络。

这种方式可以更加灵活地控制网络的结构和参数。

在Matlab中,用户可以通过编写自定义的函数来定义网络的拓扑结构、激活函数、学习算法等。

同时,用户还可以使用Matlab提供的矩阵运算和优化工具,对神经网络的参数进行更新和优化。

使用自定义函数实现神经网络需要较高的编程能力和数学知识,但是可以满足对网络结构和参数精细控制的需求。

此外,用户还可以在自定义函数中加入其他自己的算法和操作,提升神经网络的性能和应用效果。

三、深度学习工具箱随着深度学习技术的兴起,Matlab还引入了深度学习工具箱,帮助用户实现包括卷积神经网络、循环神经网络等深度学习模型。

Matlab中的人工智能算法介绍人工智能(Artificial Intelligence,AI)作为一门学科,旨在研究和开发能够模拟人类智能行为的技术和系统。

近年来,人工智能在各个领域迅猛发展,为解决现实生活中的复杂问题提供了全新的思路和方法。

而在实现人工智能技术的过程中,算法的选择和应用显得尤为重要。

Matlab作为一款强大的科学计算工具,提供了丰富的人工智能算法库,方便研究人员和工程师在开发人工智能系统时使用。

本文将介绍几种在Matlab中常用的人工智能算法。

一、机器学习算法1. 支持向量机(Support Vector Machine,SVM)支持向量机是一种监督学习算法,主要用于分类和回归问题。

它通过找到一个最优超平面来使不同类型的数据点具有最大的间隔,从而实现分类。

在Matlab中,通过SVM工具箱可以轻松应用支持向量机算法,进行分类和回归分析。

2. 人工神经网络(Artificial Neural Network,ANN)人工神经网络是模拟人脑神经网络的计算模型,可以进行模式识别、分类、优化等任务。

在Matlab中,通过神经网络工具箱可以构建和训练不同类型的人工神经网络,如前馈神经网络、循环神经网络等。

3. 随机森林(Random Forest)随机森林是一种集成学习算法,通过随机抽样和特征选择的方式构建多个决策树,并通过投票或平均等方式进行预测。

在Matlab中,通过随机森林工具箱可以构建和训练随机森林模型,用于分类和回归问题。

二、进化算法1. 遗传算法(Genetic Algorithm,GA)遗传算法是一种模拟自然界生物进化过程的优化算法,通过模拟选择、交叉和变异等操作,逐步优化问题的解。

在Matlab中,通过遗传算法工具箱可以方便地进行遗传算法的设计和实现。

2. 粒子群优化算法(Particle Swarm Optimization,PSO)粒子群优化算法是一种模拟鸟群觅食行为的智能优化算法,通过粒子的位置和速度信息进行搜索和优化。

Matlab中的神经网络算法实现指南1. 引言神经网络是一种基于生物神经系统的模型,旨在模拟人脑的学习和决策过程。

在现代机器学习领域,神经网络被广泛应用于图像识别、语言处理、预测分析等各种任务中。

而Matlab作为一种功能强大的数值计算和可视化软件,提供了丰富的神经网络工具箱,可以帮助开发人员快速实现和调试各种神经网络算法。

本文将介绍Matlab中的神经网络工具箱,并提供一些实现神经网络算法的指南。

2. Matlab中的神经网络工具箱Matlab提供了一个名为"Neural Network Toolbox"的工具箱,包含了大量的函数和工具,用于构建、训练和评估神经网络模型。

该工具箱支持多种类型的神经网络结构,包括前馈神经网络、递归神经网络、卷积神经网络等。

此外,Matlab还提供了各种用于优化神经网络的算法,如反向传播算法、遗传算法等。

3. 构建神经网络模型在Matlab中,我们可以使用"feedforwardnet"函数来构建一个前馈神经网络模型。

该函数接受一个包含神经网络层结构的向量作为输入参数,并返回一个神经网络对象。

我们可以通过修改这个向量的元素来调整神经网络的结构和参数。

例如,下面的代码展示了如何构建一个包含两个隐藏层的前馈神经网络模型:```matlabnet = feedforwardnet([10, 5]);```4. 导入和预处理数据导入和预处理数据对于构建和训练神经网络模型至关重要。

Matlab提供了各种用于数据导入和预处理的函数和工具。

例如,可以使用"csvread"函数来导入CSV 格式的数据文件;可以使用"mapminmax"函数来对数据进行归一化处理;可以使用"splittingData"函数将数据划分为训练集、验证集和测试集等。

5. 为神经网络模型训练数据在Matlab中,我们可以通过调用"train"函数来训练神经网络模型。

MATLAB神经网络工具箱的使用指南引言:在当今信息时代的浪潮中,神经网络作为一种模仿人类神经系统运行方式的数学计算模型,被广泛应用于各个领域。

而MATLAB神经网络工具箱作为一款功能强大、易于使用的软件工具,成为许多科学家和工程师进行神经网络研究和应用实践的首选。

本文旨在为读者提供MATLAB神经网络工具箱的全面介绍,并指导读者如何利用其进行神经网络的搭建、训练和应用。

一、神经网络基础知识在正式介绍MATLAB神经网络工具箱之前,我们先来了解一些神经网络的基础知识。

神经网络由输入层、隐藏层和输出层组成,其中输入层接收外部输入,隐藏层进行数据转换和处理,输出层输出最终结果。

神经网络模拟人类大脑的工作原理,通过调整神经元之间的连接权重来实现对输入数据的学习和对未知数据的预测。

二、MATLAB神经网络工具箱的使用1. 环境准备在使用MATLAB神经网络工具箱之前,我们需要先安装MATLAB软件,并确保已经安装了神经网络工具箱。

安装完成后,可以通过在命令窗口输入“nntool”命令来打开神经网络工具箱界面。

2. 神经网络搭建在神经网络工具箱中,可以通过图形用户界面进行神经网络的搭建。

点击界面左上角的“New”按钮,选择“Feedforwardnet”或“Patternnet”等网络类型,并设置输入层、隐藏层和输出层的节点数。

接下来,可以通过拖拽节点和连接来构建网络。

此外,还可以使用“Layer”和“Connection”选项卡来对网络的结构和参数进行进一步设置。

3. 数据准备成功搭建神经网络后,我们需要准备用于训练和测试的数据。

MATLAB提供了丰富的数据处理函数,可以将数据从不同格式的文件中导入,或者通过代码生成。

导入数据后,可以使用数据处理工具对数据进行清洗、归一化等预处理操作,以提高神经网络的训练效果。

4. 神经网络训练数据准备完毕后,可以通过神经网络工具箱提供的训练函数对神经网络进行训练。

常用的训练函数包括“trainlm”、“traingd”、“trainrp”等,它们采用不同的优化算法来调整网络中的连接权重。

MATLAB中的神经网络工具箱详解神经网络是一种模拟人脑神经系统工作方式的计算模型,广泛应用于科学、工程和金融等领域。

而在MATLAB软件中,也有专门的神经网络工具箱,提供了丰富的功能和算法,用于实现神经网络的建模、训练和应用。

本文将对MATLAB中的神经网络工具箱进行详细的解析和介绍。

一、神经网络基础知识在深入了解MATLAB神经网络工具箱之前,我们首先来了解一些神经网络的基础知识。

1. 神经元和激活函数神经元是神经网络的基本单位,它接收来自其他神经元的输入,并通过激活函数将输入转化为输出。

在MATLAB中,可以使用`newff`函数创建一个前馈神经网络,可以通过`sim`函数进行网络的模拟和计算。

2. 训练算法神经网络的训练是指通过一系列的输入和输出样本来调整网络的参数,使得网络能够正确地学习和推断。

常用的训练算法包括误差逆传播算法(Backpropagation)、Levenberg-Marquardt算法等。

在MATLAB中,可以使用`train`函数进行网络的训练,可以选择不同的训练算法和参数。

二、MATLAB神经网络工具箱的使用1. 创建神经网络对象在MATLAB中,可以使用`newff`函数创建一个前馈神经网络对象,该函数的参数包括网络的结构、激活函数等。

例如,`net = newff(input, target, hiddenSize)`可以创建一个具有输入层、隐藏层和输出层的神经网络对象。

2. 设置神经网络参数创建神经网络对象后,可以使用`setwb`函数设置网络的权重和偏置值,使用`train`函数设置网络的训练算法和参数。

例如,`setwb(net, weights, biases)`可以设置网络的权重和偏置值。

3. 神经网络的训练神经网络的训练是通过提供一系列的输入和输出样本,调整网络的参数使得网络能够正确地学习和推断。

在MATLAB中,可以使用`train`函数进行网络的训练,该函数的参数包括训练集、目标值、训练算法和其他参数。

12.Matlab神经⽹络⼯具箱概述:1 ⼈⼯神经⽹络介绍2 ⼈⼯神经元3 MATLAB神经⽹络⼯具箱4 感知器神经⽹络5 感知器神经⽹络5.1 设计实例分析1 clear all;2 close all;3 P=[0011;0101];4 T=[0111];5 %建⽴神经⽹络6 net=newp(minmax(P),1,'hardlim','learnp');7 %对神经⽹络进⾏训练,net是建⽴⽹络,P是输⼊向量,T是⽬标向量8 net=train(net,P,T);9 %对⽹络进⾏仿真10 Y=sim(net,P);11 %绘制建模点12 plotpv(P,T);13 %绘制分界线14 plotpc(net.iw{1,1},net.b{1});1 clear all;2 close all;3 P=[-0.5 -0.50.4 -0.1 -0.8;-0.50.5 -0.30.20.9];4 T=[11001];5 plotpv(P,T);6 %建⽴感知器⽹络7 net=newp(minmax(P),1,'hardlim','learnpn');8 hold on;9 linehandle=plot(net.IW{1},net.b{1});10 E=1;11 net.adaptParam.passes=10;12 %误差没有达到要求会持续不断的训练13while mae(E)14 %进⾏感知器⽹络的训练15 [net,Y,E]=adapt(net,P,T);16 linehandle=plotpc(net.IW{1},net.b{1},linehandle);17 drawnow;18 end19 %对训练好的⽹络进⾏保存,保存成net120 save net1 net;21set(gcf,'position',[50,50,400,400]);1 clear all;2 close all;3 %加载⽹络4 load net1.mat;5 X=[-0.40.20.8;-0.70.30.9];6 %对⽹络进⾏仿真,输⼊向量为X7 Y=sim(net,X);8 figure;9 %绘制样本点和分界线10 plotpv(X,Y);11 plotpc(net.IW{1},net.b{1});12set(gcf,'position',[50,50,400,400]);5.2 线性神经⽹络1 clear all;2 close all;3 P=[1.02.134];4 T=[2.04.015.98.0];5 %获取最⼤的学习速率6 lr=maxlinlr(P);7 net=newlin(minmax(P),1,0,lr);8 %最⼤学习次数是3009 net.trainParam.epochs=300;10 %训练的⽬标误差为0.0511 net.trainParam.goal=0.05;12 net=train(net,P,T);13 Y=sim(net,P)6 设计实例分析1 clear all;2 close all;3 t=0:pi/10:4*pi;4 X=t.*sin(t);5 T=2*X+3;6 figure;7 plot(t,X,'+-',t,T,'+--');8 legend('系统输⼊','系统输出');9set(gca,'xlim',[04*pi]);10set(gcf,'position',[50,50,400,400]);11 net=newlind(X,T);12 %对⽹络进⾏仿真13 y=sim(net,X);14 figure;15 plot(t,y,'+:',t,y-T,'r:');16 legend('⽹络预测输出','误差');17set(gca,'xlim',[04*pi]);18set(gcf,'position',[50,50,400,400]); 7 BP⽹络7.1 BP⽹络的创建7.2 BP⽹络实例分析1 clear all;2 clear all;3 P=[012345678910];4 T=[01234321234];5 %隐含层为10个神经元6 net=newff(P,T,10);7 net.trainParam.epochs=100;8 %进⾏训练9 net=train(net,P,T);10 %对⽹络进⾏仿真11 Y=sim(net,P);12 figure;13 plot(P,T,P,Y,'o');BP神经⽹络进⾏曲线拟合1 clear all;2 clear all;3 P=-1:0.05:1;4 T=sin(2*pi*P)+0.1*randn(size(P));5 net=newff(P,T,20,{},'trainbr');6 net.trainParam.show=10;7 net.trainParam.epochs=50;8 net=train(net,P,T);9 Y=sim(net,P);10 figure;11 plot(P,T,'-',P,Y,'+');12 legend('原始信号','⽹络输出信号'); 13set(gcf,'position',[50,50,600,300]); 8 径向基审计⽹络1 clear all;2 close all;3 P=[12345];4 T=[2.13.45.46.95.6];5 net=newrb(P,T);6 x=2:0.5:57 y=sim(net,x)9 ⼴义回归神经⽹络1 clear all;2 close all;3 %输⼊向量4 P=1:20;5 %输出向量6 T=3*sin(P);7 net=newgrnn(P,T,0.2);8 y=sim(net,P);9 figure;10 plot(P,T,':+',P,T-y,'-o'); 10 概率神经⽹络1 clear all;2 close all;3 P=[1:8];4 Tc=[23123211];5 T=ind2vec(Tc)6 net=newpnn(P,T);7 Y=sim(net,P);8 Yc=vec2ind(Y)。

用Deep Network Designer工具箱建立网络Deep Network Designer 工具箱可实现以下功能:导入、编辑网络从头建立新的网络通过拖拽方式增加网络层和连接(类似Simulink)查看、编辑网络层属性生成matlab代码1.打开App,导入网络在App标题栏中,点击Deep Network Designer 按钮即可打开工具箱,也可在命令窗中输入以下命令打开在开始界面,有一些预训练网络可供下载安装。

一般通过新建或从工作区导入的方式创建网络2.增加/编辑网络层App提供了常用的网络层模块,可通过拖拽的方式添加,软件自带的层模块有:输入层(图片/序列输入)、卷积和全连接层(二维/三维卷积)、池化层、序列层(lstm、gru、NLP处理)、激活函数(relu、elu、tanh等)、归一化等工具(BN、dropout)、目标检测、输出层。

另外,可以通过命令行自己建立新的层,并添加到网络中。

在工作区中点击每个层,可以查看修改层属性参数,也可选中各层进行复制、剪切、删除等操作。

3.分析网络点击Analyze按钮可以检查分析网络,检查网络结构是否有问题,分析各层的可学习参数数量,errors为0时,网络可用于训练。

4.使用Deep Network Designer进行训练首先在Data 栏中,点击Import Data 按钮导入训练集,然后在Training栏中,进行网络训练。

App中可对训练集进行数据增强,可设置训练参数。

5.网络导出也可将建好的网络导出到matlab工作区,通过 trainNetwork 命令进行训练。

也可先在App中训练完毕,将训练好的网络导出到工作区,这样导出的网络包含已学习的权重参数。

Matlab神经网络工具简介MATLAB软件中包含MATLAB神经网络工具箱,工具箱以人工神经网络为基础,只要根据自己需要调用相关函数,就可以完成网络设计、权值初始化、网络训练等,MATLAB神经网络工具箱包括的网络有感知器、线性网络、BP神经网络、径向基网络、自组织网络和回归网络,BP神经网络工具箱主要包括newff,sim 和train三个神经网络函数各函数的解释如下:1 newff::::BP神经网络参数设置函数神经网络参数设置函数神经网络参数设置函数神经网络参数设置函数函数功能:构建一个BP神经网络。

函数形式:net = newff(P,T,S,TF,BTF,BLF,PF,IPF,OPF,DDF)P:输入数据矩阵T:输出数据矩阵S:隐含层节点数TF:节点传递函数,包括硬限幅传递函数hardlim,对称硬限幅传递函数hardlims,线性传递函数purelin,正切S型传递函数tansig,对数S型传递函数logsig BTF:训练函数,包括梯度下降BP算法训练函数traingd,动量反传的梯度下降BP算法训练函数traingdm,动态自适应学习率的梯度下降BP算法训练函数traingda,动量反传和动态自适应学习率的梯度下降BP算法训练函数traingdx,Levenberg_Marquardt的BP算法训练函数trainlmBLF:网络学习函数,包括BP学习规则learngd,带动量项的BP学习规则learngdmPF:性能分析函数,包括均值绝对误差性能分析函数mae,均方差性能分析函数mse IPF:输入处理函数OPF:输出处理函数DDF:验证数据划分函数一般在使用过程中设置前六个参数,后四个参数采用系统默认参数。

2 train::::BP神经网络训练函数神经网络训练函数神经网络训练函数神经网络训练函数函数功能:用训练数据训练BP神经网络。

函数形式:[net,tr] = train(NET,X,T,Pi,Ai)NET:待训练网络X:输入数据矩阵T:输出数据矩阵Pi:初始化输入层条件Ai:初始化输出层条件net:训练好的网络tr:训练过程记录一般在使用过程中设置前三个参数,后两个参数采用系统默认参数。

MATLAB神经网络工具箱与液位控制BP 模型的设计与仿真随着科学技术的发展,在控制领域中被控对象变得越来越复杂,控制系统呈现出复杂的非线性、时变及不确定性的特点,难于精确建模,有的虽然可以建立粗略的模型,但求解困难。

人工神经网络具有一定的自学习、自适应和非线性映射能力及容错性等优点,为解决复杂的非线性、不确定、不确知系统的控制问题开辟了一条新的途径。

其中,BP 网络,即基于误差反向传播算法的多层前馈神经网络,由于它可以以任意精度逼近任意的连续函数,因此被广泛应用于非线性建模、函数逼近、模式分类、智能控制及预测等领域。

MATLAB神经网络工具箱是以神经网络理论作为背景的专业工具箱,本文针对某发电厂液位控制建立BP 预测模型,利用目前工程领域流行的MATLAB 6.1中提供的神经网络工具箱,对网络模型进行训练和仿真,给出优化的BP 模型实现步骤。

MATLAB及其神经网络工具箱MATLAB是由MATHWORKS公司开发的一个高性能的技术计算语言。

它在一个简单易用的交互式环境中集成了计算、可视化和程序设计等强大的功能。

神经网络工具箱是MATLAB中集成的一个重要工具箱,工具箱中提供了面向不同神经网络模型特别是BP网络模型的丰富多彩的网络学习和训练函数,其中包括了BP算法和各种改进BP算法,为神经网络的仿真分析提供了极大的方便,从而使MATLAB成为目前世界上最为流行的神经仿真平台。

用户只要调用工具箱中相关函数并输入参数,就可以完成相应的训练仿真。

在本文液位控制BP模型的设计与仿真研究中,主要用到以下几个函数及其主要参数:1)Newff格式: net = newff(PR,[S1 S2… S nl],{TF1 TF2… TF nl},BTF,BLF,PF)其中net是神经网络名;S i是第i层神经网络的神经元个数,网络共有nl层;TFi 是第i层网络神经元的转移函数,缺省为tansig; BTF是BP训练函数,缺省为trainlm;BLF 是学习函数,缺省为learngdm;PF是性能函数,缺省为mse。

![[matlab工具箱]神经网络NeuralNet](https://img.taocdn.com/s1/m/1defa8ed710abb68a98271fe910ef12d2af9a9ae.png)

[matlab⼯具箱]神经⽹络NeuralNet//⽬的是学习在BP神经⽹络的基础上添加遗传算法,蚁群算法等优化算法来优化⽹络,这是后话。

先简单了解了MATLAB中的神经⽹络⼯具箱,⼯具箱功能还是⾮常强⼤的,已经可以拟合出⾮常多的曲线来分析了。

神经⽹络⼯具箱选择(4种)今天下载了⾃带的example跑了⼀次试⼀下选择隐藏神经元个数训练结束后可以在plot查看各种图表,这⾥只对⼯具箱操作做简单介绍最近⼀段时间在研究如何利⽤预测其销量个数,在⽹上搜索了⼀下,发现了很多模型来预测,⽐如利⽤回归模型、时间序列模型,GM(1,1)模型,可是⾃⼰在结合实际的⼯作内容,发现这⼏种模型预测的精度不是很⾼,于是再在⽹上进⾏搜索,发现神经⽹络模型可以来预测,并且有很多是结合时间序列或者SVM(⽀持向量机)等组合模型来进⾏预测,本⽂结合实际数据,选取了常⽤的BP神经⽹络算法,其算法原理,因⽹上⼀⼤堆,所以在此不必⼀⼀展⽰,并参考了这篇博⽂,运⽤matlab 2016a,给出了下⾯的代码,并最终进⾏了预测clcclear allclose all%bp 神经⽹络的预测代码%载⼊输出和输⼊数据load C:\Users\amzon\Desktop\p.txt;load C:\Users\amzon\Desktop\t.txt;%保存数据到matlab的⼯作路径⾥⾯save p.mat;save t.mat;%注意t必须为⾏向量%赋值给输出p和输⼊tp=p;t=t;%数据的归⼀化处理,利⽤mapminmax函数,使数值归⼀化到[-1.1]之间%该函数使⽤⽅法如下:[y,ps] =mapminmax(x,ymin,ymax),x需归化的数据输⼊,%ymin,ymax为需归化到的范围,不填默认为归化到[-1,1]%返回归化后的值y,以及参数ps,ps在结果反归⼀化中,需要调⽤[p1,ps]=mapminmax(p);[t1,ts]=mapminmax(t);%确定训练数据,测试数据,⼀般是随机的从样本中选取70%的数据作为训练数据%15%的数据作为测试数据,⼀般是使⽤函数dividerand,其⼀般的使⽤⽅法如下:%[trainInd,valInd,testInd] = dividerand(Q,trainRatio,valRatio,testRatio)[trainsample.p,valsample.p,testsample.p] =dividerand(p,0.7,0.15,0.15);[trainsample.t,valsample.t,testsample.t] =dividerand(t,0.7,0.15,0.15);%建⽴反向传播算法的BP神经⽹络,使⽤newff函数,其⼀般的使⽤⽅法如下%net = newff(minmax(p),[隐层的神经元的个数,输出层的神经元的个数],{隐层神经元的传输函数,输出层的传输函数},'反向传播的训练函数'),其中p为输⼊数据,t为输%tf为神经⽹络的传输函数,默认为'tansig'函数为隐层的传输函数,%purelin函数为输出层的传输函数%⼀般在这⾥还有其他的传输的函数⼀般的如下,如果预测出来的效果不是很好,可以调节%TF1 = 'tansig';TF2 = 'logsig';%TF1 = 'logsig';TF2 = 'purelin';%TF1 = 'logsig';TF2 = 'logsig';%TF1 = 'purelin';TF2 = 'purelin';TF1='tansig';TF2='purelin';net=newff(minmax(p),[10,1],{TF1 TF2},'traingdm');%⽹络创建%⽹络参数的设置net.trainParam.epochs=10000;%训练次数设置net.trainParam.goal=1e-7;%训练⽬标设置net.trainParam.lr=0.01;%学习率设置,应设置为较少值,太⼤虽然会在开始加快收敛速度,但临近最佳点时,会产⽣动荡,⽽致使⽆法收敛net.trainParam.mc=0.9;%动量因⼦的设置,默认为0.9net.trainParam.show=25;%显⽰的间隔次数%指定训练参数% net.trainFcn = 'traingd'; %梯度下降算法% net.trainFcn = 'traingdm'; %动量梯度下降算法% net.trainFcn = 'traingda'; %变学习率梯度下降算法% net.trainFcn = 'traingdx'; %变学习率动量梯度下降算法% (⼤型⽹络的⾸选算法)% net.trainFcn = 'trainrp'; % RPROP(弹性BP)算法,内存需求最⼩%共轭梯度算法% net.trainFcn = 'traincgf'; %Fletcher-Reeves修正算法% net.trainFcn = 'traincgp'; %Polak-Ribiere修正算法,内存需求⽐Fletcher-Reeves修正算法略⼤% net.trainFcn = 'traincgb'; % Powell-Beal复位算法,内存需求⽐Polak-Ribiere修正算法略⼤% (⼤型⽹络的⾸选算法)%net.trainFcn = 'trainscg'; % ScaledConjugate Gradient算法,内存需求与Fletcher-Reeves修正算法相同,计算量⽐上⾯三种算法都⼩很多% net.trainFcn = 'trainbfg'; %Quasi-Newton Algorithms - BFGS Algorithm,计算量和内存需求均⽐共轭梯度算法⼤,但收敛⽐较快% net.trainFcn = 'trainoss'; % OneStep Secant Algorithm,计算量和内存需求均⽐BFGS算法⼩,⽐共轭梯度算法略⼤% (中型⽹络的⾸选算法)%net.trainFcn = 'trainlm'; %Levenberg-Marquardt算法,内存需求最⼤,收敛速度最快% net.trainFcn = 'trainbr'; %贝叶斯正则化算法% 有代表性的五种算法为:'traingdx','trainrp','trainscg','trainoss', 'trainlm'%在这⾥⼀般是选取'trainlm'函数来训练,其算对对应的是Levenberg-Marquardt算法net.trainFcn='trainlm';[net,tr]=train(net,trainsample.p,trainsample.t);%计算仿真,其⼀般⽤sim函数[normtrainoutput,trainPerf]=sim(net,trainsample.p,[],[],trainsample.t);%训练的数据,根据BP得到的结果[normvalidateoutput,validatePerf]=sim(net,valsample.p,[],[],valsample.t);%验证的数据,经BP得到的结果[normtestoutput,testPerf]=sim(net,testsample.p,[],[],testsample.t);%测试数据,经BP得到的结果%将所得的结果进⾏反归⼀化,得到其拟合的数据trainoutput=mapminmax('reverse',normtrainoutput,ts);validateoutput=mapminmax('reverse',normvalidateoutput,ts);testoutput=mapminmax('reverse',normtestoutput,ts);%正常输⼊的数据的反归⼀化的处理,得到其正式值trainvalue=mapminmax('reverse',trainsample.t,ts);%正常的验证数据validatevalue=mapminmax('reverse',valsample.t,ts);%正常的验证的数据testvalue=mapminmax('reverse',testsample.t,ts);%正常的测试数据%做预测,输⼊要预测的数据pnewpnew=[313,256,239]';pnewn=mapminmax(pnew);anewn=sim(net,pnewn);anew=mapminmax('reverse',anewn,ts);%绝对误差的计算errors=trainvalue-trainoutput;%plotregression拟合图figure,plotregression(trainvalue,trainoutput)%误差图figure,plot(1:length(errors),errors,'-b')title('误差变化图')%误差值的正态性的检验figure,hist(errors);%频数直⽅图figure,normplot(errors);%Q-Q图[muhat,sigmahat,muci,sigmaci]=normfit(errors);%参数估计均值,⽅差,均值的0.95置信区间,⽅差的0.95置信区间[h1,sig,ci]= ttest(errors,muhat);%假设检验figure, ploterrcorr(errors);%绘制误差的⾃相关图figure, parcorr(errors);%绘制偏相关图运⾏之后的,结果如下:BP神经⽹络的结果分析图训练数据的梯度和均⽅误差之间的关系图验证数据的梯度与学习次数残差的正态的检验图(Q-Q图)在⽹上,发现可以通过神经⽹络⼯具箱这个GUI界⾯来创建神经⽹络,其⼀般的操作步骤如下:1:在输⼊命令⾥⾯输⼊nntool命令,或者在应⽤程序这个选项下找到Netrual Net Fitting 这个应⽤程序,点击打开,就能看见如下界⾯2:输⼊数据和输出数据的导⼊(在本⽂中选取了matlab⾃带的案例数据)3:随机选择三种类型的数据所占的样本量的⽐例,⼀般选取默认即可4:隐层神经元的确定5:训练算法的选取,⼀般是选择默认即可,选择完成后点击<train>按钮即可运⾏程序6:根据得到的结果,⼀般是MSE的值越⼩,R值越接近1,其训练的效果⽐较,并第⼆张图给出了神经⽹络的各参数的设置以及其最终的结果,其拟合图R越接近1,模型拟合的更好最终的结果图7:如果所得到的模型不能满⾜你的需求,则需重复上述的步骤直⾄能够得到你想要的精确度8:将最终的得到的各种数据以及其拟合值进⾏保存,然后查看,就可以得到所要的拟合值最后参考了⽹上和MATLAB的帮助,给出了⼀些与神经⽹络相关的函数,希望能够帮助⼤家。